A revelação recente do MLPerf Inference v3.1 trouxe novos benchmarks para grandes Modelos de linguagem (LLMs) e recomendações, significando um avanço significativo nos testes de IA. Os benchmarks MLPerf-desenvolvidos pela MLCommons, um consórcio de líderes acadêmicos de IA, laboratórios de pesquisa e em toda a indústria-são projetados para fornecer avaliações imparciais de treinamento e desempenho de inferência para hardware, software e serviços.

A nova versão testemunhou um nível de participação sem precedentes, com mais de 13.500 resultados de desempenho, marcando uma melhoria de até 40% no desempenho. A diversidade na participação é evidente com 26 participantes distintos, incluindo grandes empresas de tecnologia como Google, Intel e NVIDIA, bem como participantes iniciantes, como Connect Tech, Nutanix, Oracle e TTA.

David Kanter, Diretor Executivo da MLCommons, enfatizou a importância desta contribuição, afirmando: “Submeter-se ao MLPerf não é trivial… Requer um verdadeiro trabalho de engenharia e é uma prova ao compromisso de nossos remetentes com a IA, com seus clientes e com o ML.”

@MLCommons, acabamos de lançar! Novo @MLPerf Resultados de inferência e armazenamento. A participação recorde no MLPerf Inference v3.1 e os primeiros resultados do MLPerf Storage v0.5 destacam a crescente importância do GenAI e armazenamento. Veja todos os resultados e saiba mais https://t.co/7eycrrmOdw

— MLCommons (@ MLCommons) 11 de setembro de 2023

Resultados de benchmarks

O objetivo principal da inferência MLPerf é avaliar a velocidade com que os sistemas de IA podem executar modelos em diferentes cenários de implantação. Eles variam de chatbots avançados de IA generativos a recursos de segurança de veículos, como manutenção automática de faixa e interfaces de fala para texto. O destaque nesta versão está na introdução de dois benchmarks:

Um LLM usando o modelo de referência GPT-J para resumir artigos de notícias da CNN, refletindo a rápida adoção de IA generativa com 15 participantes. Um benchmark de recomendação atualizado, mais alinhado aos padrões do setor, utilizando o modelo de referência DLRM-DCNv2 e conjuntos de dados maiores, recebendo nove envios.

Os resultados para MLPerf Inference v3.1 e MLPerf Storage v0.5 são interessantes, abrangendo:

Armazenamento: quão rápido o armazenamento pode fornecer dados ao treinar um modelo de IA. Resultados: a rapidez com que um sistema pode produzir entradas de um modelo treinado.

O domínio da NVIDIA e a perseguição da Intel

Os chips avançados da NVIDIA emergiram como os principais concorrentes em testes em um modelo de linguagem grande, com o hardware da Intel seguindo de perto. A MLCommons, conhecida por seu benchmarking neutro de desempenho de chipsets de IA, anunciou os resultados de seus novos benchmarks MLPerf Inference 3.1.

A NVIDIA apresentou seu GH200 Grace Hopper Superchip, que combina uma unidade de processamento gráfico Hopper com uma unidade de processamento central Grace, oferecendo memória aprimorada, largura de banda e recursos de mudança de tarefas entre o GPU e uma CPU baseada em Arm. Este chipset superou o sistema HGX 100 da NVIDIA em aproximadamente 17%. No entanto, os aceleradores Habana Gaudi2 da Intel não ficaram muito atrás, mostrando um atraso de desempenho de apenas 10% em comparação com os sistemas da NVIDIA.

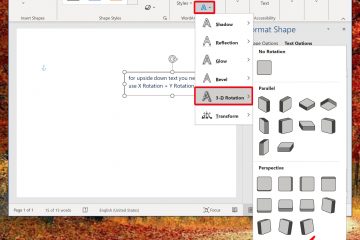

Esta semana, a Nvidia anunciou uma nova atualização de software que efetivamente dobra o desempenho de sua GPU H100 AI. O novo software TensorRT-LLM de código aberto da empresa, com lançamento previsto para as próximas semanas, demonstrou um aumento significativo de desempenho.

Em testes usando o modelo GPT-J 6B, o sistema atualizado apresentou uma melhoria de desempenho oito vezes maior em relação ao A100, um salto significativo em relação à vantagem anterior de quatro vezes. Além disso, quando avaliados no Llama2 LLM da Meta, os H100s aprimorados pelo TensorRT-LLM ultrapassaram os A100s por um fator de 4,6, uma melhoria acentuada em relação aos 2,6 vezes anteriores à atualização.