El nuevo software de código abierto TensorRT-LLM de NVIDIA, cuyo lanzamiento está previsto para las próximas semanas, ha demostrado un aumento significativo en el rendimiento. En las pruebas realizadas con el modelo GPT-J 6B, el sistema actualizado mostró una mejora de rendimiento ocho veces mayor que el A100, un salto significativo con respecto a la ventaja anterior de cuatro veces. Además, cuando se evaluó en Llama2 LLM de Meta, los H100 mejorados con TensorRT-LLM superaron a los A100 por un factor de 4,6, una marcada mejora con respecto a las 2,6 veces anteriores a la actualización.

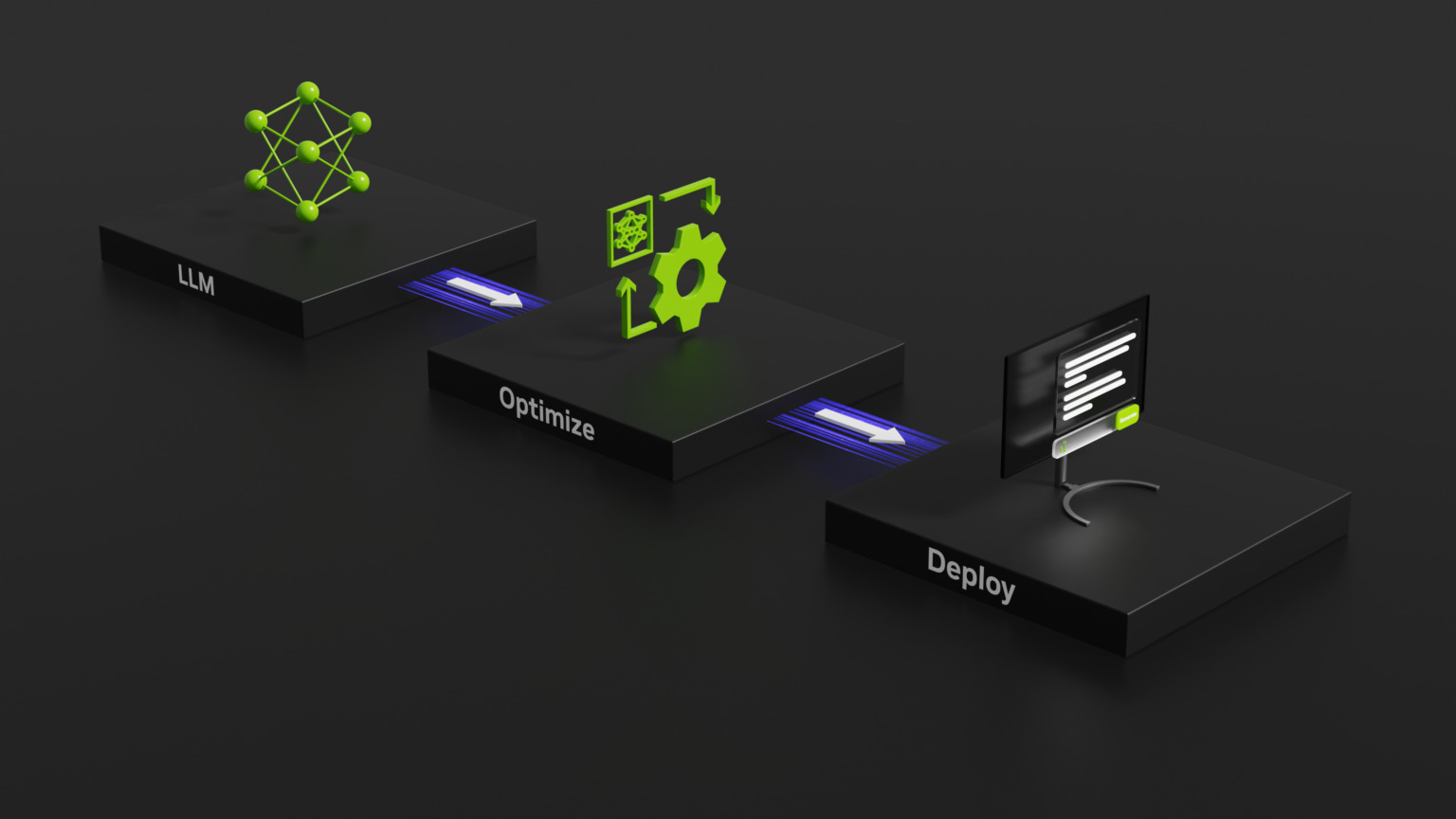

En un intento por mejorar el rendimiento de Large Language Models (LLM), NVIDIA ha presentado recientemente TensorRT-LLM, una biblioteca de código abierto diseñada para mejorar el rendimiento de los modelos de lenguaje grande (LLM) en el hardware de NVIDIA.

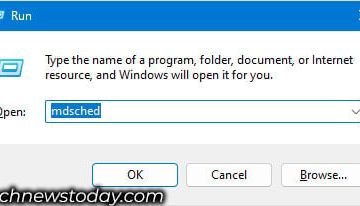

TensorRT-LLM es una biblioteca de código abierto que opera en las GPU NVIDIA Tensor Core. Su función principal es ofrecer a los desarrolladores un entorno para experimentar y construir nuevos modelos de lenguaje grandes, que forman la base de plataformas de inteligencia artificial generativa como ChatGPT. El software se centra en la inferencia, lo que refina el proceso de entrenamiento de una IA y ayuda al sistema a comprender cómo vincular conceptos y hacer predicciones.

Recién anunciado: NVIDIA TensorRT-LLM potencia el modelo de lenguaje grande #inference en las GPU NVIDIA H100 Tensor Core. #LLM https://t.co/jMX0EDxkXJ

— Desarrollador de IA de NVIDIA (@NVIDIAAIDev) 8 de septiembre de 2023

Técnicas innovadoras detrás del impulso

El desafío con los modelos de lenguaje grandes (LLM) radica en su versatilidad, lo que dificulta el procesamiento por lotes de solicitudes y su ejecución simultánea. NVIDIA y sus socios abordaron este desafío integrando TensorRT-LLM con un método de programación avanzado denominado”procesamiento por lotes en vuelo”. Este enfoque innovador permite segmentar la generación de texto en múltiples subtareas.

Esencialmente, el sistema puede procesa nuevos lotes de diferentes solicitudes simultáneamente, en lugar de esperar a que se complete un solo lote. TensorRT-LLM incluye un compilador de aprendizaje profundo de TensorRT, núcleos optimizados, pasos previos y posteriores al procesamiento, y facilita la comunicación entre múltiples GPU y nodos. en un rendimiento incomparable en las GPU de NVIDIA, lo que permite la experimentación novedosa con modelos de lenguaje grande, una rápida personalización y un rendimiento máximo.

Evaluación comparativa de excelencia y perspectivas futuras

GH200 Grace de NVIDIA Hopper Superchip, que combina una GPU Hopper con una CPU Grace, ha mostrado resultados impresionantes en los últimos benchmarks de la industria MLPerf. El superchip, junto con las GPU H100, lideró todas las pruebas del centro de datos de MLPerf, incluyendo visión por computadora, reconocimiento de voz, pruebas médicas. imágenes y las tareas más exigentes de los sistemas de inferencia y recomendación de LLM. Además, NVIDIA ha anunciado una próxima actualización de software que mejorará aún más las capacidades de inferencia de IA de su superchip GH200 Grace Hopper.

La IA es un área importante de crecimiento para Nvidia y la compañía ya está viendo los beneficios de adoptarla. un papel de liderazgo en el mercado. Análisis recientes han revelado que Nvidia está obteniendo casi un beneficio del 1000% con cada GPU H100 Tensor Core que vende. Información financiera de Raymond James, una prestigiosa empresa de servicios financieros, compartida en Barron’s, han estimado que el coste de producción de una de estas GPU ronda los 3.320 dólares. En marcado contraste, el precio de venta de Nvidia para estas GPU fluctúa entre $25 000 y $30 000, dependiendo del volumen del pedido.