Enfrentando um dilúvio de conteúdo de baixa qualidade gerado por IA, o servidor acadêmico de pré-impressão arXiv está reforçando suas regras de envio de artigos de ciência da computação.

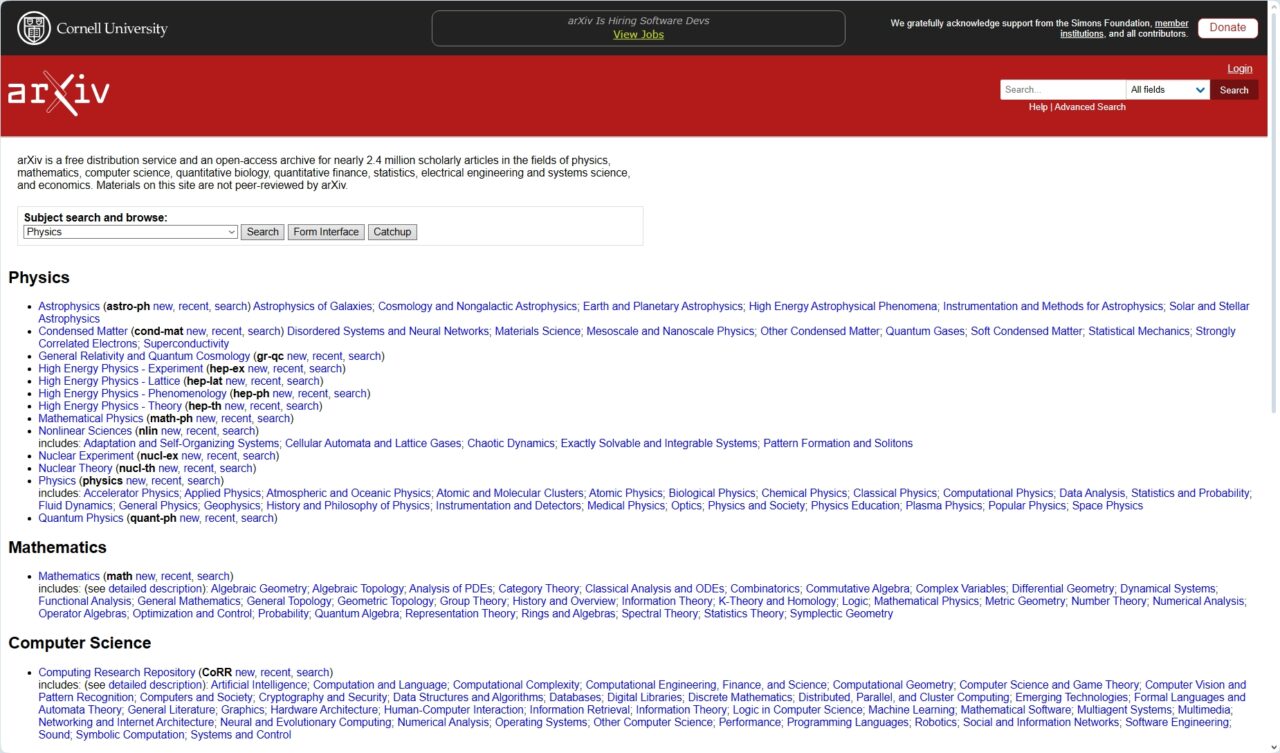

Em um anúncio em 31 de outubro, a influente plataforma afirmou que sua categoria Ciência da Computação (CS) não aceitará mais artigos de revisão ou documentos de posição, a menos que já tenham sido aprovados na revisão por pares em um periódico ou conferência reconhecida.

A mudança foi projetada para reduzir a carga sobre moderadores voluntários e confronta diretamente uma enxurrada de submissões que o arXiv diz serem “rápidas e fáceis de escrever” com IA generativa, mas muitas vezes carecem de substância.

Uma inundação de’resíduos’gerados por IA

Em um esforço para salvaguardar a qualidade da pesquisa, o arXiv está enfrentando diretamente o impacto de grandes modelos de linguagem na publicação acadêmica. A plataforma foi inundada com submissões, especialmente em sua seção de ciência da computação, que evolui rapidamente.

De acordo com seu comunicado oficial, o site agora recebe “centenas de artigos de revisão todos os meses”. Seu grande volume tornou-se incontrolável para o sistema de verificação da plataforma.

Muitas dessas submissões não atendem aos padrões acadêmicos básicos. Os moderadores do arXiv descobriram que “a maioria dos artigos de revisão que recebemos são pouco mais do que bibliografias comentadas, sem nenhuma discussão substancial de questões de pesquisa abertas”.

Esses artigos contribuem para o ruído acadêmico, desperdiçando o tempo dos pesquisadores em busca de novos insights. Essa facilidade de produção levou a uma pressão significativa sobre os especialistas voluntários que examinam os artigos.

Como explicou o arXiv, “IA generativa/modelos de linguagem grande contribuíram para essa inundação, tornando os artigos-especialmente artigos que não introduzem novos resultados de pesquisa-rápidos e fáceis de escrever.”Artigos recentes, como um que descreve um assistente de pesquisa de IA multiagente, demonstram tecnologia capaz de automatizar todo o processo de redação acadêmica, desde a concepção até a redação.

Essa tecnologia torna trivial a geração de revisões de literatura que parecem plausíveis, mas, em última análise, vazias, exacerbando o problema que o arXiv está tentando resolver agora. A exigência de revisão prévia por pares funciona como um filtro crucial, terceirizando o controle de qualidade inicial para periódicos e conferências estabelecidas.

Um sistema sob pressão

Embora a mudança política seja nova, o problema subjacente não o é. O processo acadêmico de revisão por pares tem lutado há anos sob uma cultura de “publicar ou perecer” que incentiva a quantidade em vez da qualidade.

Especialistas como Satoshi Tanaka, da Universidade Farmacêutica de Kyoto, argumentaram que o processo de revisão por pares na academia “está em crise”.

Agravando a situação A crise é o número limitado de revisores voluntários, que ficam sobrecarregados com o número de submissões. Esta fadiga cria uma vulnerabilidade que as ferramentas de IA, tanto para o bem como para o mal, estão começando a explorar.

arXiv já esteve no centro de debates sobre IA e integridade acadêmica antes. No ano passado, pesquisadores foram encontrados incorporando comandos ocultos em seus artigos para manipular sistemas de revisão baseados em IA, uma prática conhecida como injeção imediata.

Ao ocultar instruções em texto branco ou fontes microscópicas, os autores tentaram enganar os sistemas automatizados para que fornecessem feedback positivo. Esse incidente destacou a facilidade com que os sistemas automatizados poderiam ser manipulados, prejudicando todo o processo de revisão.

As nuances na mudança recente do arXiv foram até mesmo uma fonte de confusão, com alguns meios de comunicação inicialmente relatando incorretamente o escopo da nova regra.

Não é uma nova política, mas uma aplicação necessária

Citando um fluxo incontrolável de submissões, os funcionários do arXiv esclareceram que a mudança é mais uma ação de fiscalização do que uma nova política.

Artigos de revisão e documentos de posição nunca foram tipos de conteúdo oficialmente aceitos, mas eram historicamente permitidos a critério do moderador quando eram de alta qualidade e interesse acadêmico.

Uma recente explosão no volume, impulsionada pela IA, simplesmente tornou essa abordagem discricionária insustentável. Proteger o tempo desses moderadores voluntários – a base do sistema de pré-impressão – é essencial.

As diretrizes da plataforma arXiv afirmam que os autores humanos são totalmente responsáveis por qualquer conteúdo produzido por ferramentas de IA e proíbem explicitamente listar uma IA como coautor.

A adoção desta nova prática de moderação para a categoria CS é uma extensão lógica deste princípio, reforçando que a validação liderada por humanos continua fundamental. Editores de todo o setor estão lutando contra isso, criando políticas fragmentadas.

Embora alguns permitam o uso limitado de IA, outros, como a Elsevier, o baniram totalmente, citando o “risco de que a tecnologia gere informações incorretas, incompletas ou tendenciosas”. conclusões.”

Olhando para o futuro, a plataforma indicou que outras disciplinas poderão sofrer mudanças semelhantes. Em seu anúncio, o arXiv observou: “Se outras categorias observarem um aumento semelhante em artigos de revisão e documentos de posição escritos por LLM, elas poderão optar por mudar suas práticas de moderação de maneira semelhante…”

Tal movimento sugere uma possível mudança em toda a plataforma se a onda de conteúdo gerado por IA continuar a se espalhar. Ele posiciona a mudança do arXiv não como uma solução isolada, mas como um indicador potencial de como toda a comunidade científica será forçada a se adaptar aos desafios e tentações da IA generativa.