Trong khi cảnh báo công khai về”sự bất hợp lý”trong thị trường AI, ban lãnh đạo Google đã ra lệnh riêng tư mở rộng cơ sở hạ tầng tích cực để tăng gấp đôi công suất phục vụ AI cứ sau sáu tháng.

Theo một bài thuyết trình được CNBC xem trong tuần này, Chỉ thị này đặt mục tiêu tăng quy mô gấp 1.000 lần trong vòng 5 năm để hỗ trợ”thời đại suy luận”thiên về tính toán.

Được cung cấp bởi VP cơ sở hạ tầng Amin Vahdat, mệnh lệnh nội bộ này hoàn toàn trái ngược với nhận xét gần đây của CEO Sundar Pichai về một cuộc phỏng vấn với BBC về một tiềm năng bong bóng.

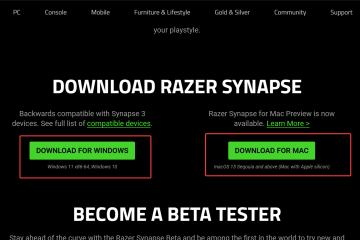

Do nỗi lo sợ hiện hữu về việc đầu tư dưới mức, chiến lược này dựa vào silicon tùy chỉnh như Chip TPU Ironwood của Google để ngăn chi phí tăng vọt cùng với sự tăng trưởng công suất.

Nhiệm vụ 1.000x: Bên trong Phòng chiến tranh của Google

Các chi tiết nổi lên từ cuộc họp toàn thể ngày 6 tháng 11 đã vẽ nên bức tranh về một công ty hoạt động trên nền tảng thời chiến.

Phó chủ tịch cơ sở hạ tầng Amin Vahdat đã trình bày một lộ trình có tiêu đề”Cơ sở hạ tầng AI”đặt ra các yêu cầu tăng trưởng theo cấp số nhân cần thiết để theo kịp nhu cầu. Rõ ràng, chỉ thị này yêu cầu Google tăng gấp đôi công suất phân phát AI sáu tháng một lần để duy trì vị thế cạnh tranh của mình.

Các dự báo dài hạn nhắm đến mức tăng công suất đáng kinh ngạc gấp 1.000 lần chỉ trong vòng 4 đến 5 năm. Thúc đẩy sự tăng tốc này không phải là đào tạo mô hình, vốn đã tiêu tốn phần lớn tài nguyên điện toán trong lịch sử, mà là sự chuyển đổi cơ bản sang”thời đại suy luận”.

Các mô hình như Gemini 3 Pro mới ra mắt gần đây yêu cầu sức mạnh tính toán khổng lồ, liên tục để thực hiện các tác vụ suy luận và thực thi mã.

Vahdat cảnh báo rằng”sự cạnh tranh trong cơ sở hạ tầng AI là phần quan trọng nhất và cũng là phần đắt nhất của cuộc đua AI”.

Ý kiến này được củng cố bởi CEO Sundar Pichai, người đã trích dẫn những cơ hội bị bỏ lỡ với công cụ tạo video của công ty, Veo, do hạn chế về phần cứng. Pichai thừa nhận rằng bất chấp sự phát triển mạnh mẽ của đám mây,”những con số đó sẽ tốt hơn nhiều nếu chúng tôi có nhiều tính toán hơn”.

Không hề chùn bước trước sự hoài nghi của thị trường, giai điệu nội bộ coi năm 2026 là một năm”dữ dội”với nhiều”thăng trầm”. Thông điệp của lãnh đạo rất rõ ràng: hạn chế chính đối với sự tăng trưởng không còn là năng lực phần mềm mà là sự sẵn có về mặt vật lý của máy tính.

Lá chắn Silicon: Ironwood, Axion và Bẫy hiệu quả

Việc mở rộng quy mô lên 1.000 lần bằng cách sử dụng phần cứng sẵn có sẽ gây tổn hại về mặt tài chính. Chiến lược của Google xoay quanh việc tách rời lợi ích hiệu suất khỏi việc tăng chi phí tuyến tính. Vahdat đã nêu ra yêu cầu về mặt kỹ thuật:

“Google cần ‘có khả năng cung cấp khả năng, tính toán, kết nối mạng lưu trữ gấp 1.000 lần với cùng một mức chi phí và ngày càng có cùng công suất, cùng mức năng lượng’, Vahdat nói.”

Nền tảng cho việc mở rộng quy mô lớn này là một thực tế kinh tế đơn giản nhưng tàn khốc: hiệu quả là con đường duy nhất dẫn đến sự bền vững. Sự phụ thuộc vào Ironwood TPU, vừa được đưa vào sử dụng rộng rãi, là trọng tâm của chiến lược này.

Với mức cải thiện hiệu suất cao nhất gấp 10 lần so với v5p, con chip thế hệ thứ bảy này cung cấp hiệu suất trên mỗi watt gấp 2 lần so với thế hệ Trillium trước đó.

Các khối lượng công việc đa năng đang được chuyển sang CPU Axion dựa trên Arm mới để giải phóng năng lượng và khoảng trống nhiệt cho các tác vụ AI. Bằng cách chuyển các tác vụ điện toán tiêu chuẩn sang bộ xử lý hiệu quả hơn, Google đặt mục tiêu tối đa hóa năng lượng sẵn có cho các TPU tiêu tốn nhiều điện năng của mình.

Áp dụng triết lý “đồng thiết kế”, các kỹ sư tích hợp phần mềm trực tiếp với kiến trúc phần cứng. Nghiên cứu từ Google DeepMind cung cấp thông tin về thiết kế chip, cho phép công ty tận dụng tối đa lợi ích mà phần cứng tiêu chuẩn không thể làm được. Vahdat lưu ý rằng “điều này sẽ không dễ dàng nhưng thông qua cộng tác và đồng thiết kế, chúng tôi sẽ đạt được điều đó”.

Tuy nhiên, hiện ra lờ mờ chính là “cái bẫy hiệu quả”. Nghịch lý Jevons cho thấy rằng khi máy tính trở nên hiệu quả hơn, nhu cầu sẽ tăng lên để tiêu thụ phần thặng dư, phủ nhận việc tiết kiệm chi phí. Nếu chi phí suy luận giảm, khối lượng truy vấn – được thúc đẩy bởi quy trình làm việc tác nhân và lý luận “Suy nghĩ sâu” – dự kiến sẽ bùng nổ, khiến tổng mức tiêu thụ năng lượng ở mức cao.

Nghịch lý bong bóng: Đặt cược chống lại’sự phi lý’

Trong bối cảnh chủ nghĩa hoài nghi bên ngoài ngày càng tăng về lợi tức đầu tư (ROI) cho AI sáng tạo, quá trình mở rộng nội bộ tích cực này vẫn tiếp tục.

Trong một cuộc phỏng vấn với BBC, Pichai thừa nhận có “các yếu tố phi lý” trong định giá thị trường hiện tại của AI. Bất chấp sự thận trọng này của công chúng, Alphabet đã nâng dự báo chi tiêu vốn năm 2025 lên 93 tỷ USD, với kế hoạch”tăng đáng kể”cho năm 2026.

Các nhân viên đã trực tiếp thách thức lãnh đạo về vấn đề ngắt kết nối này trong phiên hỏi đáp. Một câu hỏi đặc biệt đề cập đến sự căng thẳng giữa chi tiêu tăng vọt và nỗi lo thị trường điều chỉnh:

“Trong bối cảnh các khoản đầu tư Al đáng kể và cuộc thảo luận trên thị trường về khả năng bong bóng Al vỡ, chúng ta nghĩ thế nào về việc đảm bảo tính bền vững lâu dài và khả năng sinh lời nếu thị trường Al không trưởng thành như mong đợi?”

Lời biện hộ của Pichai dựa trên bảng cân đối kế toán của công ty. Ông lập luận: “Bạn biết đấy, chúng tôi có khả năng chống chọi tốt hơn các công ty khác”.

Về mặt phòng thủ, logic thừa nhận rằng nguy cơ đầu tư dưới mức – và có khả năng trở nên không liên quan – là tồn tại, trong khi đầu tư quá mức chỉ đơn thuần là tốn kém.

Lý do như vậy hiện đang thúc đẩy sự bùng nổ AI Capex đang diễn ra, trong đó việc xây dựng cơ sở hạ tầng tách rời khỏi thực tế doanh thu trước mắt. Google đang đặt cược một cách hiệu quả rằng họ có thể tồn tại lâu hơn các đối thủ cạnh tranh trong một cuộc chiến tiêu hao nhiều vốn.

Thực tế thị trường: Thế tiến thoái lưỡng nan của tù nhân về AI

Nói chung, “Tứ đại gia” – Google, Microsoft, Amazon và Meta – dự kiến sẽ chi hơn 380 tỷ USD vào cơ sở hạ tầng trong năm nay, theo số liệu do CNBC trích dẫn. Giám đốc điều hành Nvidia Jensen Huang đã bác bỏ rõ ràng câu chuyện về”bong bóng”trong tuần này, với lý do nhu cầu hữu hình, một quan điểm mà Google phải chống lại.

Đối thủ cạnh tranh OpenAI đang phải đối mặt với những khó khăn của chính mình. Một bản ghi nhớ nội bộ của Sam Altman xuất hiện trong tuần này cho thấy rằng công ty dẫn đầu ngành đang ngày càng phải vật lộn với thực tế kinh tế của việc mở rộng quy mô. Điều này tạo cơ hội cho Google tận dụng khả năng tích hợp theo chiều dọc của mình.

Việc chuyển nút thắt từ tính khả dụng của dữ liệu sang tốc độ và chi phí tạo mã thông báo thuần túy chính là “Thời đại suy luận”. Lợi thế cụ thể của Google nằm ở lớp silicon tùy chỉnh, có khả năng cho phép Google vượt qua cuộc chiến giá cả khốc liệt hơn so với những cuộc chiến chỉ phụ thuộc vào phần cứng Nvidia.

Các sản phẩm ra mắt gần đây, chẳng hạn như Gemini 3 Pro và Gemini 3 Pro Image, đã thúc đẩy nhu cầu này hơn nữa. Cuối cùng, kết quả phụ thuộc vào việc liệu các tính năng cao cấp như “Suy nghĩ sâu” và quy trình làm việc tự động có thể tạo ra doanh thu nhanh hơn tốc độ giảm giá của phần cứng hay không.

Bất chấp chi phí đáng kinh ngạc, Google cho đến nay dường như vẫn cam kết thực hiện chiến lược “cứ xây dựng và họ sẽ đến”.