Các nhà nghiên cứu của Google đã giới thiệu một khung mới có tên là Chuỗi tác nhân (CoA), được thiết kế để giải quyết một trong những hạn chế dai dẳng nhất của mô hình ngôn ngữ lớn (LLM): xử lý các tác vụ có ngữ cảnh dài.

CoA sử dụng mô hình cộng tác nhiều tác nhân để cải thiện đáng kể hiệu quả và độ chính xác của lý luận trong các nhiệm vụ như tóm tắt, trả lời câu hỏi và hoàn thành mã.

Bằng cách chia các đầu vào dài thành các phần nhỏ hơn, dễ quản lý hơn các khối và gán chúng cho các tác nhân chuyên biệt, khung này mang lại kết quả tốt hơn so với các phương pháp tiếp cận truyền thống như mô hình Thế hệ tăng cường truy xuất (RAG) và toàn ngữ cảnh.

Liên quan: Google ra mắt Agentspace để thách thức hệ sinh thái AI đang phát triển của Microsoft

Khung CoA mang lại sự thay đổi mô hình cho AI, đặc biệt là trong khả năng xử lý các đầu vào mở rộng của nó có thể vượt quá giới hạn của LLM. Google nhấn mạnh tính đơn giản và hiệu quả của phương pháp này, mô tả nó là “không cần đào tạo, bất khả tri về nhiệm vụ/độ dài, có thể giải thích được và hiệu quả về mặt chi phí”.

Những thách thức của Nhiệm vụ AI bối cảnh dài

Một trong những trở ngại lớn trong việc nâng cao khả năng của AI nằm ở việc quản lý đầu vào theo ngữ cảnh dài. Hầu hết các LLM hoạt động với cửa sổ ngữ cảnh cố định khiến chúng hạn chế khả năng xử lý các tập dữ liệu lớn mà không cần cắt bớt.

Các phương pháp giảm đầu vào, chẳng hạn như với tư cách là RAG, hãy cố gắng khắc phục điều này bằng cách chỉ truy xuất những phần có liên quan nhất của dữ liệu đầu vào. Tuy nhiên, phương pháp này thường có độ chính xác truy xuất thấp, dẫn đến thông tin không đầy đủ. NVIDIA cải tiến AI đặc tính với các mô hình Llama và Cosmos Nemotron

Mặt khác, các mô hình Toàn ngữ cảnh mở rộng khả năng xử lý nhưng lại gặp phải sự kém hiệu quả về mặt tính toán, đặc biệt khi độ dài đầu vào tăng lên. Vấn đề”bị mất giữa chừng”, trong đó thông tin quan trọng ở giữa tập dữ liệu không được ưu tiên.

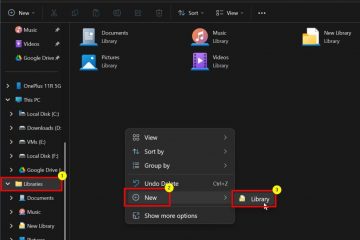

Khung CoA của Google giải quyết các vấn đề này bằng cách tận dụng hệ thống cộng tác trong đó các nhân viên xử lý các phân đoạn cụ thể của thông tin đầu vào một cách tuần tự. Mỗi tác nhân công nhân tinh chỉnh và chuyển những phát hiện của mình sang tác nhân tiếp theo, đảm bảo rằng không có bối cảnh nào bị mất.

Sau đó, tác nhân quản lý sẽ tổng hợp tất cả thông tin thu thập được để đưa ra phản hồi cuối cùng. Phương pháp tiếp cận từng bước này bắt chước cách giải quyết vấn đề của con người, trong đó các nhiệm vụ được chia thành các phần nhỏ hơn để tập trung và chính xác hơn.

Hình ảnh: Google

Hình ảnh: Google

Các nhà nghiên cứu của Google nhấn mạnh động lực đằng sau khuôn khổ này, nêu rõ, “Khi cửa sổ trở nên dài hơn cả khả năng đầu vào mở rộng của chúng, những LLM như vậy vẫn gặp khó khăn trong việc tập trung vào thông tin cần thiết để giải quyết nhiệm vụ và gặp phải tình trạng sử dụng ngữ cảnh không hiệu quả, chẳng hạn như vấn đề’lạc giữa chừng’.”

Chuỗi đại lý hoạt động như thế nào

Khung chuỗi đại lý hoạt động theo hai giai đoạn riêng biệt Trong giai đoạn đầu tiên, các tác nhân công nhân xử lý các khối đầu vào được chỉ định, thực hiện. các nhiệm vụ như trích xuất bằng chứng hỗ trợ hoặc chuyển tiếp các bằng chứng liên quan các phát hiện.

Chuỗi giao tiếp này đảm bảo rằng mỗi nhân viên được xây dựng dựa trên những hiểu biết sâu sắc của giai đoạn trước. Trong giai đoạn thứ hai, người quản lý tổng hợp tất cả các bằng chứng thu thập được và tạo ra kết quả cuối cùng gắn kết. Cấu trúc phân cấp này không chỉ cải thiện độ chính xác của lý luận mà còn giảm chi phí tính toán.

Liên quan: Salesforce ra mắt Agentforce 2.0, mở rộng các tác nhân AI ra ngoài CRM

Google đã giải thích thiết kế của framework là “xen kẽ việc đọc và suy luận, gán cho mỗi tác nhân một bối cảnh ngắn”. Cách tiếp cận này cho phép CoA xử lý các bối cảnh dài mà không yêu cầu LLM xử lý đồng thời tất cả các mã thông báo.

Bằng cách giảm độ phức tạp tính toán, CoA cung cấp một giải pháp hiệu quả hơn và có thể mở rộng cho các tác vụ có ngữ cảnh dài.

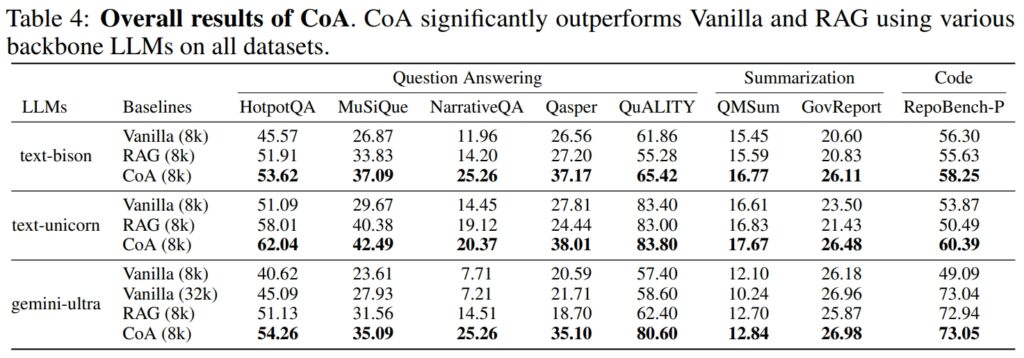

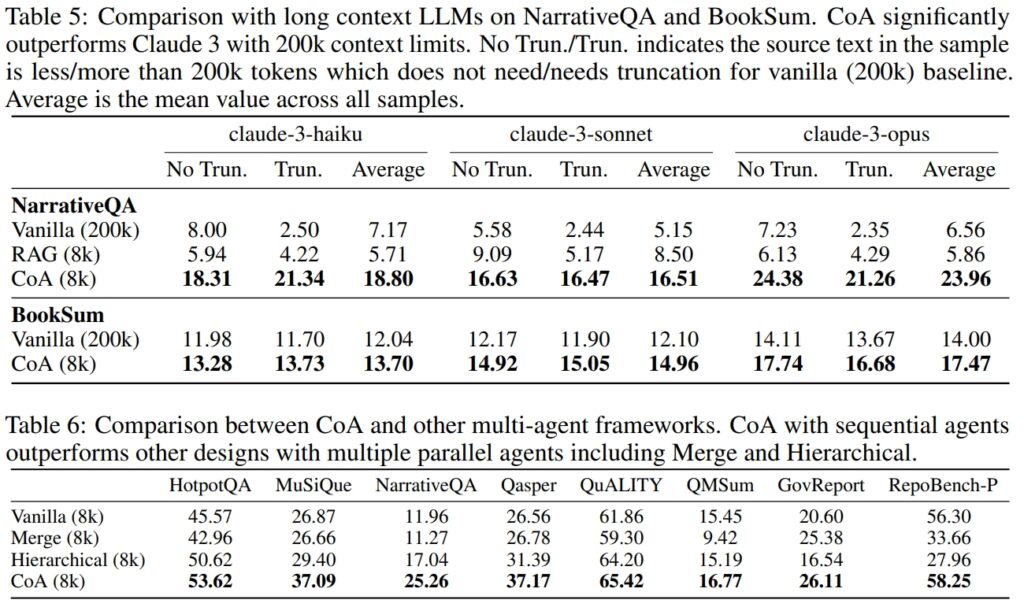

Hiệu suất vượt trội trên các điểm chuẩn

Google đã tiến hành thử nghiệm rộng rãi trên chín tập dữ liệu để đánh giá hiệu suất của CoA. bộ dữ liệu trải rộng trên nhiều lĩnh vực khác nhau, bao gồm trả lời câu hỏi (ví dụ: HotpotQA, MuSiQue), tóm tắt (ví dụ: QMSum, GovReport) và hoàn thành mã (ví dụ: RepoBench-P).

CoA luôn hoạt động tốt hơn các mô hình RAG và Full-Context cả về độ chính xác và hiệu quả.

Nguồn: Google

Nguồn: Google

Ví dụ: trên Với bộ dữ liệu HotpotQA, CoA đã xuất sắc trong khả năng suy luận nhiều bước, một nhiệm vụ yêu cầu tổng hợp thông tin từ nhiều nguồn để đi đến câu trả lời chính xác.

Mặc dù RAG thường không thể kết nối các phần thông tin rời rạc về mặt ngữ nghĩa nhưng có liên quan đến ngữ cảnh, CoA đã ghép các thông tin chi tiết lại với nhau một cách có hệ thống từ từng đoạn đầu vào. Google lưu ý: “Kết quả của chúng tôi cho thấy rằng trên tất cả chín tập dữ liệu, CoA đạt được sự cải thiện lên tới 10% so với tất cả các đường cơ sở.”

Trên tập dữ liệu NarrativeQA, CoA đã chứng tỏ khả năng vượt trội so với các mô hình Toàn bối cảnh, thậm chí những loại có khả năng xử lý 200 nghìn mã thông báo. Bằng cách giới hạn cửa sổ ngữ cảnh ở mức 8 nghìn mã thông báo và sử dụng phương pháp tiếp cận đa tác nhân, CoA đã duy trì hiệu suất cao đồng thời giảm đáng kể chi phí tính toán.

Nguồn: Google

Nguồn: Google

Ứng dụng trong các tình huống thực tế

Các ứng dụng thực tế của CoA mở rộng trên nhiều ngành. Trong phân tích pháp lý, CoA có thể xử lý các tài liệu pháp lý rộng rãi và xác định thông tin quan trọng mà không bỏ sót các chi tiết quan trọng. Trong chăm sóc sức khỏe, khuôn khổ này có thể tổng hợp hồ sơ bệnh nhân từ nhiều nguồn khác nhau để cung cấp thông tin chẩn đoán toàn diện.

Các tổ chức học thuật và chính phủ có thể sử dụng CoA để tóm tắt nghiên cứu, tổng hợp các phát hiện từ các bộ dữ liệu lớn.

Khả năng xử lý các nhiệm vụ hoàn thành mã của CoA cũng làm nổi bật tiềm năng của nó trong phát triển phần mềm. Bằng cách phân tích các cơ sở mã lớn và xác định các phần phụ thuộc, khung này có thể tối ưu hóa quy trình làm việc cho các nhà phát triển làm việc với các hệ thống phức tạp.

Liên quan: Cognition.ai Ra mắt Kỹ sư phần mềm Devin AI với giá 500 USD/tháng

So sánh với các đối thủ cạnh tranh trong ngành

Việc giới thiệu CoA của Google phản ánh sự chú trọng ngày càng tăng vào các tác nhân AI đơn lẻ và các khung tác nhân AI hợp tác trong ngành công nghệ. OpenAI vừa ra mắt Operator, một tác nhân AI dựa trên trình duyệt được thiết kế để tự động hóa tác vụ, trong khi Microsoft ra mắt AutoGen v0.4 với khung Magentic-One dành cho quy trình làm việc của nhiều tác nhân.

CoA của Google tạo nên sự khác biệt bằng cách tập trung cụ thể vào lý luận ngữ cảnh dài và xử lý tác vụ.

Theo các nhà nghiên cứu của Google, LLM thường nhận được ngữ cảnh không đầy đủ do những hạn chế trong các phương pháp truyền thống, nhưng CoA giải quyết vấn đề này bằng cách xử lý toàn bộ thông tin đầu vào một cách cộng tác thông qua nhiều tác nhân.

Việc tập trung vào các nhiệm vụ có ngữ cảnh dài mang lại cho CoA lợi thế độc đáo trong các lĩnh vực cần tổng hợp thông tin sâu rộng.

Một cái nhìn thoáng qua Vào trong Tương lai của AI

Việc giới thiệu CoA nêu bật xu hướng phát triển AI rộng lớn hơn theo hướng các hệ thống mô-đun và hợp tác. Bằng cách cho phép các tác nhân chuyên biệt làm việc cùng nhau, CoA cho thấy cách phân chia nhiệm vụ có thể nâng cao độ chính xác và khả năng mở rộng.

Khuôn khổ này có thể mở đường cho những tiến bộ trong trí tuệ nhân tạo tổng quát (AGI), trong đó các hệ thống có khả năng suy luận và giải quyết vấn đề ở cấp độ con người.

Những nỗ lực của Google cũng nhấn mạnh tầm quan trọng các giải pháp hiệu quả về mặt chi phí và dễ hiểu trong AI doanh nghiệp.