Google DeepMind đã ra mắt FACTS Grounding, một tiêu chuẩn mới được thiết kế để kiểm tra các mô hình ngôn ngữ lớn (LLM) về khả năng tạo ra phản hồi dựa trên tài liệu, chính xác về mặt thực tế.

Bài kiểm tra chuẩn, được tổ chức trên Kaggle, nhằm mục đích giải quyết một trong những thách thức cấp bách nhất trong trí tuệ nhân tạo: đảm bảo rằng kết quả đầu ra của AI được căn cứ vào dữ liệu được cung cấp cho chúng, thay vì dựa vào kiến thức bên ngoài hoặc tạo ra ảo giác—thông tin hợp lý nhưng không chính xác.

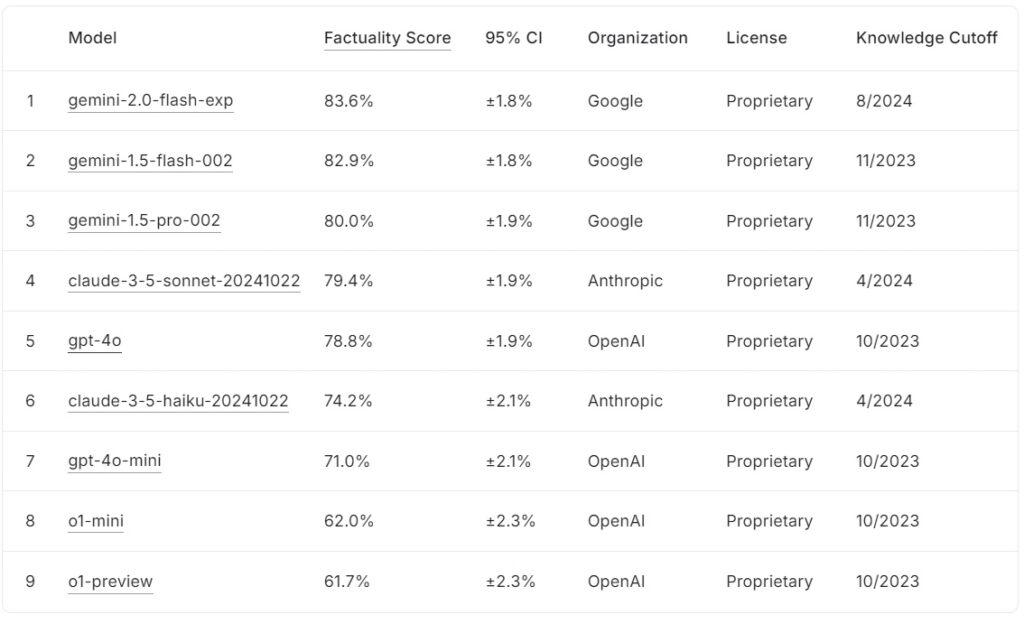

Bảng xếp hạng FACTS Grounding hiện tại xếp hạng các mô hình ngôn ngữ lớn dựa trên điểm số thực tế của chúng, cùng với Google gemini-2.0-flash-exp dẫn đầu với 83,6%, theo sát là gemini-1.5-flash-002 với 82,9% và gemini-1.5-pro-002 ở mức 80,0%.

claude-3.5-sonnet-20241022 của Anthropic đứng thứ tư với 79,4%, trong khi OpenAI gpt-4o đạt 78,8%, xếp thứ năm. Ở vị trí thấp hơn trong danh sách, claude-3.5-haiku-20241022 của Anthropic đạt điểm 74,2%, tiếp theo là gpt-4o-mini với 71,0%.

Các mô hình nhỏ hơn của OpenAI, o1-mini và o1-preview, đứng đầu bảng xếp hạng ở mức 62,0% và >61,7% tương ứng.

Nguồn: Kaggle

Nguồn: Kaggle

SỰ THẬT Căn cứ nổi bật nhờ yêu cầu các phản hồi dạng dài tổng hợp các tài liệu đầu vào chi tiết, khiến nó trở thành một trong những tiêu chuẩn khắt khe nhất về tính xác thực của AI cho đến nay.

FACTS Grounding thể hiện một bước phát triển quan trọng đối với ngành AI, đặc biệt là trong các ứng dụng nơi mà sự tin cậy và độ chính xác là rất cần thiết. Bằng cách đánh giá LLM trên các lĩnh vực như y học, luật, tài chính, bán lẻ và công nghệ, điểm chuẩn này tạo tiền đề cho việc cải thiện độ tin cậy của AI trong các tình huống thực tế.

Theo nhóm nghiên cứu của DeepMind, “điểm chuẩn đo lường khả năng LLM tạo ra phản hồi dựa hoàn toàn vào bối cảnh được cung cấp…ngay cả khi bối cảnh xung đột với kiến thức trước khi đào tạo.”

Bộ dữ liệu về độ phức tạp trong thế giới thực

FACTS Grounding bao gồm 1.719 ví dụ, được con người chú thích tuyển chọn để đảm bảo tính phù hợp và đa dạng. Các ví dụ này được rút ra từ các tài liệu chi tiết. trải dài tới 32.000 mã thông báo, tương đương với khoảng 20.000 từ

Mỗi nhiệm vụ yêu cầu LLM thực hiện tóm tắt, tạo câu hỏi và viết lại nội dung, với các hướng dẫn nghiêm ngặt chỉ tham chiếu dữ liệu được cung cấp. , lý luận toán học hoặc diễn giải của chuyên gia, thay vào đó tập trung vào việc kiểm tra khả năng tổng hợp và trình bày thông tin phức tạp của mô hình.

Để duy trì tính minh bạch và ngăn chặn việc khớp quá mức, DeepMind đã chia tập dữ liệu thành hai phân đoạn: 860 ví dụ công khai có sẵn để sử dụng bên ngoài và 859 ví dụ riêng tư dành riêng cho việc đánh giá bảng xếp hạng.

Cấu trúc kép này bảo vệ tính toàn vẹn của điểm chuẩn đồng thời khuyến khích sự hợp tác từ các nhà phát triển AI trên toàn thế giới. Nhóm nghiên cứu lưu ý: “Chúng tôi đánh giá nghiêm ngặt những người đánh giá tự động dựa trên dữ liệu thử nghiệm được lưu trữ để xác thực hiệu suất của họ trong nhiệm vụ của chúng tôi”, đồng thời nêu bật thiết kế cẩn thận làm nền tảng cho FACTS Grounding.

Đánh giá độ chính xác bằng thiết bị ngang hàng Mô hình AI

Không giống như các điểm chuẩn thông thường, FACTS Grounding sử dụng quy trình đánh giá ngang hàng liên quan đến ba LLM nâng cao: Gemini 1.5 Pro, GPT-4o và Claude 3.5 Sonnet. Các mô hình này đóng vai trò là giám khảo, chấm điểm các câu trả lời dựa trên hai tiêu chí quan trọng: tính đủ điều kiện và độ chính xác thực tế

Các câu trả lời trước tiên phải vượt qua quá trình kiểm tra tính đủ điều kiện để xác nhận rằng chúng giải quyết được truy vấn của người dùng một cách có ý nghĩa. vì nền tảng của họ dựa trên tài liệu nguồn, với điểm số được tổng hợp trên ba mô hình để giảm thiểu sai lệch.

Các nhà nghiên cứu của DeepMind nhấn mạnh tầm quan trọng của việc đánh giá nhiều lớp này, họ nêu rõ: “Các số liệu tập trung vào việc đánh giá tính xác thực của cái văn bản được tạo…có thể bị phá vỡ bằng cách bỏ qua mục đích đằng sau yêu cầu của người dùng. Bằng cách đưa ra những câu trả lời ngắn hơn nhằm tránh truyền tải thông tin toàn diện…có thể đạt được điểm số thực tế cao trong khi không đưa ra câu trả lời hữu ích.”

Việc sử dụng nhiều mẫu tính điểm, bao gồm các phương pháp tiếp cận dựa trên cấp độ phạm vi và dựa trên JSON , hơn nữa còn đảm bảo sự phù hợp với khả năng phán đoán của con người và khả năng thích ứng với các nhiệm vụ đa dạng.

Giải quyết thách thức của ảo giác AI

ảo giác AI là một trong những trở ngại đáng kể nhất đối với việc phổ biến rộng rãi áp dụng LLM trong các trường quan trọng. Những lỗi này, trong đó các mô hình tạo ra kết quả đầu ra có vẻ hợp lý nhưng thực tế không chính xác, gây ra rủi ro nghiêm trọng trong các lĩnh vực như chăm sóc sức khỏe, phân tích pháp lý và báo cáo tài chính. FACTS Grounding trực tiếp giải quyết vấn đề này bằng cách thực thi nghiêm ngặt. Việc tuân thủ dữ liệu đầu vào được cung cấp không chỉ đánh giá khả năng tránh đưa ra thông tin sai lệch của mô hình mà còn đảm bảo rằng kết quả đầu ra luôn phù hợp với mục đích của người dùng.

Ngược lại với các điểm chuẩn như của OpenAI. SimpleQA, đo lường tính thực tế trong quá trình truy xuất dữ liệu đào tạo, FACTS Grounding kiểm tra xem các mô hình tổng hợp thông tin mới tốt như thế nào.

Bài nghiên cứu nhấn mạnh sự khác biệt này: “Đảm bảo độ chính xác thực tế trong khi tạo ra phản hồi LLM là một thách thức. Những thách thức chính trong tính thực tế của LLM là mô hình hóa (tức là kiến trúc, đào tạo và suy luận) và đo lường (tức là phương pháp đánh giá, dữ liệu và số liệu).”

Thách thức kỹ thuật và thiết kế điểm chuẩn >

Sự phức tạp của đầu vào dạng dài đặt ra những thách thức kỹ thuật đặc biệt, đặc biệt trong việc thiết kế các phương pháp đánh giá tự động có thể đánh giá chính xác các phản hồi đó

FACTS Grounding dựa vào các quy trình tính toán chuyên sâu để xác thực các phản hồi. , sử dụng các tiêu chí khắt khe để đảm bảo độ tin cậy. Việc đưa vào nhiều mô hình đánh giá sẽ giảm thiểu những thành kiến tiềm ẩn và củng cố khung đánh giá tổng thể.

Nhóm nghiên cứu nhấn mạnh tầm quan trọng của việc loại bỏ các câu trả lời mơ hồ hoặc không liên quan, đồng thời lưu ý rằng: “Việc loại bỏ các câu trả lời không đủ điều kiện sẽ dẫn đến giảm đi…vì những phản hồi này được coi là không chính xác.”Việc thực thi nghiêm ngặt mức độ liên quan này đảm bảo rằng các mô hình không được khen thưởng vì phá vỡ tinh thần của nhiệm vụ.

Khuyến khích hợp tác thông qua tính minh bạch

Quyết định của DeepMind tổ chức FACTS Grounding trên Kaggle phản ánh cam kết của mình trong việc thúc đẩy sự hợp tác trong toàn ngành AI. Bằng cách làm cho phân đoạn công khai của tập dữ liệu có thể truy cập được, dự án mời các nhà nghiên cứu và nhà phát triển AI đánh giá mô hình của họ theo tiêu chuẩn mạnh mẽ và góp phần nâng cao các tiêu chuẩn thực tế.

Cách tiếp cận này phù hợp với các mục tiêu rộng hơn về tính minh bạch và tiến bộ chung trong AI, đảm bảo rằng những cải tiến về độ chính xác và nền tảng không chỉ giới hạn ở một tổ chức duy nhất.

Khác biệt với các tổ chức khác Điểm chuẩn

SỰ THẬT Việc nối đất khác biệt với các điểm chuẩn khác ở chỗ nó tập trung vào việc đặt nền tảng cho những đầu vào mới được giới thiệu hơn là kiến thức được đào tạo trước.

Trong khi các điểm chuẩn như SimpleQA của OpenAI đánh giá mức độ một mô hình truy xuất và sử dụng thông tin từ kho dữ liệu đào tạo của nó thì FACTS Grounding đánh giá các mô hình về khả năng tổng hợp và trình bày rõ ràng các phản hồi chỉ dựa trên dữ liệu được cung cấp.

Sự khác biệt này rất quan trọng trong việc giải quyết những thách thức do những định kiến về mô hình hoặc những thành kiến cố hữu đặt ra. Bằng cách tách biệt nhiệm vụ xử lý đầu vào bên ngoài, FACTS Grounding đảm bảo rằng các số liệu hiệu suất phản ánh khả năng hoạt động của mô hình trong các tình huống động, thực tế thay vì chỉ lấy lại thông tin đã học trước.

Như DeepMind giải thích trong tài liệu nghiên cứu của mình, điểm chuẩn được thiết kế để đánh giá LLM về khả năng quản lý các truy vấn dạng dài, phức tạp với nền tảng thực tế, mô phỏng các nhiệm vụ liên quan đến ứng dụng trong thế giới thực.

Các phương pháp thay thế để nối đất LLM

Một số phương pháp cung cấp các tính năng nối đất tương tự như nối đất FACTS, mỗi phương pháp đều có điểm mạnh và điểm yếu. Các phương pháp này nhằm mục đích nâng cao kết quả đầu ra LLM bằng cách cải thiện khả năng tiếp cận thông tin chính xác hoặc tinh chỉnh các quy trình đào tạo và liên kết của họ.

Thế hệ tăng cường truy xuất (RAG)

Thế hệ tăng cường truy xuất (RAG) nâng cao độ chính xác của kết quả đầu ra LLM bằng cách truy xuất động thông tin liên quan từ cơ sở kiến thức hoặc cơ sở dữ liệu bên ngoài và kết hợp nó vào các câu trả lời của mô hình. Thay vì đào tạo lại toàn bộ LLM, RAG hoạt động bằng cách chặn lời nhắc của người dùng và làm phong phú chúng bằng thông tin cập nhật.

Việc triển khai RAG nâng cao thường tận dụng khả năng truy xuất dựa trên thực thể, trong đó dữ liệu liên kết với các thực thể cụ thể được thống nhất để cung cấp bối cảnh có liên quan cao cho các phản hồi LLM.

RAG thường sử dụng các kỹ thuật tìm kiếm ngữ nghĩa để truy xuất thông tin. Các tài liệu hoặc các đoạn của chúng được lập chỉ mục dựa trên phần nhúng ngữ nghĩa của chúng, cho phép hệ thống khớp truy vấn của người dùng với các mục nhập phù hợp nhất theo ngữ cảnh. Cách tiếp cận này đảm bảo rằng LLM tạo ra phản hồi dựa trên dữ liệu mới nhất và thích hợp nhất.

Hiệu quả của RAG phụ thuộc rất nhiều vào chất lượng và cách tổ chức cơ sở kiến thức cũng như độ chính xác của thuật toán truy xuất. Trong khi FACTS Grounding đánh giá khả năng của LLM trong việc duy trì sự gắn kết với tài liệu ngữ cảnh được cung cấp, RAG bổ sung điều này bằng cách cho phép LLM mở rộng kiến thức của họ một cách linh hoạt, rút ra từ các nguồn bên ngoài để nâng cao tính xác thực và mức độ liên quan.

Chắt lọc kiến thức

Chắt lọc kiến thức liên quan đến việc chuyển giao khả năng của một hệ thống lớn, phức tạp mô hình (được gọi là giáo viên) sang mô hình nhỏ hơn, có nhiệm vụ cụ thể (học sinh). Phương pháp này cải thiện hiệu quả trong khi vẫn giữ được phần lớn độ chính xác của mô hình ban đầu. Hai phương pháp tiếp cận chính được sử dụng trong quá trình chắt lọc kiến thức:

Chắt lọc kiến thức dựa trên phản hồi: Tập trung vào việc nhân rộng kết quả đầu ra của mô hình giáo viên, đảm bảo mô hình học sinh tạo ra kết quả tương tự với những đầu vào nhất định.

Chắt lọc kiến thức dựa trên tính năng: Trích xuất các đặc điểm và biểu diễn nội bộ từ mô hình giáo viên, cho phép mô hình học sinh tái tạo những hiểu biết sâu sắc hơn.

Bằng cách tinh chỉnh các mô hình nhỏ hơn , chắt lọc kiến thức cho phép triển khai LLM trong môi trường hạn chế về tài nguyên mà không làm giảm hiệu suất đáng kể. Không giống như FACTS Grounding đánh giá độ trung thực của nền tảng, quá trình chắt lọc kiến thức quan tâm nhiều hơn đến việc mở rộng khả năng LLM và tối ưu hóa chúng cho các nhiệm vụ cụ thể.

Tinh chỉnh với Bộ dữ liệu nối đất

Tinh chỉnh liên quan đến việc điều chỉnh LLM được đào tạo trước cho phù hợp với các lĩnh vực hoặc nhiệm vụ cụ thể bằng cách đào tạo chúng về bộ dữ liệu được quản lý trong đó nền tảng thực tế là rất quan trọng. Ví dụ: các bộ dữ liệu bao gồm tài liệu khoa học hoặc hồ sơ lịch sử có thể được sử dụng để cải thiện khả năng của mô hình trong việc tạo ra kết quả đầu ra chính xác và theo từng miền cụ thể. Kỹ thuật này nâng cao hiệu suất LLM cho các ứng dụng chuyên biệt, chẳng hạn như phân tích tài liệu y tế hoặc pháp lý.

Tuy nhiên, việc tinh chỉnh tốn nhiều tài nguyên và có nguy cơ quên nghiêm trọng, trong đó mô hình mất đi kiến thức thu được trong quá trình đào tạo ban đầu. FACTS Grounding tập trung vào việc kiểm tra tính xác thực trong các bối cảnh biệt lập, trong khi tinh chỉnh nhằm cải thiện hiệu suất cơ bản của LLM trong các lĩnh vực cụ thể.

Học tăng cường với phản hồi của con người (RLHF)

Học tăng cường với phản hồi của con người (RLHF) kết hợp sở thích của con người vào quá trình đào tạo của LLM. Bằng cách đào tạo lặp đi lặp lại mô hình để điều chỉnh phản hồi của nó với phản hồi của con người, RLHF tinh chỉnh chất lượng, tính thực tế và tính hữu ích của kết quả đầu ra. Những người đánh giá là con người chấm điểm kết quả đầu ra của LLM và những điểm số này được sử dụng làm tín hiệu để tối ưu hóa mô hình.

RLHF đã đặc biệt thành công trong việc nâng cao sự hài lòng của người dùng và đảm bảo các phản hồi được tạo ra phù hợp với mong đợi của con người. Trong khi FACTS Grounding đánh giá nền tảng thực tế dựa trên các tài liệu cụ thể, thì RLHF nhấn mạnh việc điều chỉnh kết quả đầu ra LLM phù hợp với các giá trị và sở thích của con người.

Tuân theo hướng dẫn và Học tập trong bối cảnh

Việc học theo hướng dẫn và học theo ngữ cảnh liên quan đến việc thể hiện nền tảng của LLM thông qua các ví dụ được xây dựng cẩn thận trong lời nhắc của người dùng. Những phương pháp này dựa vào khả năng khái quát hóa của mô hình từ một cuộc trình diễn vài lần. Mặc dù phương pháp này có thể mang lại những cải tiến nhanh chóng nhưng nó có thể không đạt được mức chất lượng nền tảng tương tự như các phương pháp tinh chỉnh hoặc dựa trên truy xuất.

Các công cụ và API bên ngoài

LLM có thể được tích hợp với các công cụ và API bên ngoài để cung cấp quyền truy cập theo thời gian thực vào dữ liệu bên ngoài, nâng cao đáng kể khả năng nối đất của chúng. Các ví dụ bao gồm:

Khả năng duyệt: Cho phép LLM truy cập và truy xuất thông tin theo thời gian thực từ web để trả lời các câu hỏi cụ thể hoặc cập nhật kiến thức của họ.

Cuộc gọi API: Cho phép LLM tương tác với cơ sở dữ liệu hoặc dịch vụ có cấu trúc, làm phong phú phản hồi bằng thông tin chính xác và cập nhật.

Những công cụ này mở rộng tiện ích của LLM bằng cách kết nối chúng với thực tế-nguồn tri thức thế giới, nâng cao khả năng tạo ra chính xác và các đầu ra được nối đất. Trong khi FACTS Grounding đánh giá độ chính xác của nền tảng bên trong thì các công cụ bên ngoài cung cấp một phương tiện thay thế để mở rộng và xác minh tính xác thực.

Nối đất mô hình nguồn mở Tùy chọn

Một số triển khai nguồn mở có sẵn cho các phương pháp nối đất thay thế được thảo luận ở trên:

Ý nghĩa đối với các ứng dụng có mức độ quan trọng cao

Tầm quan trọng của độ chính xác và các phản ứng có căn cứ của AI trở nên đặc biệt rõ ràng trong các ứng dụng mang tính rủi ro cao, chẳng hạn như chẩn đoán y tế, đánh giá pháp lý và phân tích tài chính. Trong những bối cảnh này, ngay cả những sai sót nhỏ cũng có thể dẫn đến những hậu quả đáng kể, khiến độ tin cậy của kết quả đầu ra do AI tạo ra trở thành một yêu cầu không thể thương lượng.

SỰ THẬT Sự nhấn mạnh của Grounding vào tính thực tế và sự tuân thủ tài liệu nguồn đảm bảo rằng các mô hình được kiểm tra trong các điều kiện phản ánh chặt chẽ nhu cầu của thế giới thực.

Ví dụ: trong bối cảnh y tế, LLM được giao nhiệm vụ việc tóm tắt hồ sơ bệnh nhân phải tránh đưa ra những sai sót có thể đưa ra quyết định điều trị sai lệch. Tương tự, trong môi trường pháp lý, việc tạo ra các bản tóm tắt hoặc phân tích án lệ đòi hỏi phải có căn cứ chính xác về các tài liệu được cung cấp.

SỰ THẬT Nối đất không chỉ đánh giá các mô hình về khả năng đáp ứng các yêu cầu nghiêm ngặt này mà còn thiết lập một tiêu chuẩn để các nhà phát triển hướng tới trong việc tạo ra các hệ thống phù hợp cho các ứng dụng đó.

Mở rộng Bộ dữ liệu FACTS và Định hướng tương lai

DeepMind đã định vị FACTS Grounding là một “chuẩn mực sống”, một tiêu chuẩn sẽ phát triển cùng với những tiến bộ trong AI. Các bản cập nhật trong tương lai có thể sẽ mở rộng tập dữ liệu để bao gồm các miền mới và nhiệm vụ các loại, đảm bảo tính liên quan liên tục của nó khi khả năng LLM phát triển

Ngoài ra, việc giới thiệu các mẫu đánh giá đa dạng hơn có thể nâng cao hơn nữa tính mạnh mẽ của quy trình tính điểm, giải quyết các trường hợp khó khăn và giảm các sai lệch còn sót lại.

Như nhóm nghiên cứu của DeepMind thừa nhận, không có tiêu chuẩn nào có thể gói gọn đầy đủ sự phức tạp của các ứng dụng trong thế giới thực. Tuy nhiên, bằng cách lặp lại FACTS Grounding và thu hút cộng đồng AI rộng lớn hơn, dự án nhằm mục đích nâng cao tiêu chuẩn về tính thực tế và nền tảng trong AI. hệ thống.

Như nhóm của DeepMind tuyên bố, “Tính thực tế và nền tảng là một trong những yếu tố chính sẽ định hình sự thành công và hữu ích trong tương lai của LLM và các hệ thống AI rộng hơn, đồng thời chúng tôi mong muốn phát triển và lặp lại FACTS Grounding khi lĩnh vực này phát triển, liên tục nâng cao tiêu chuẩn.”