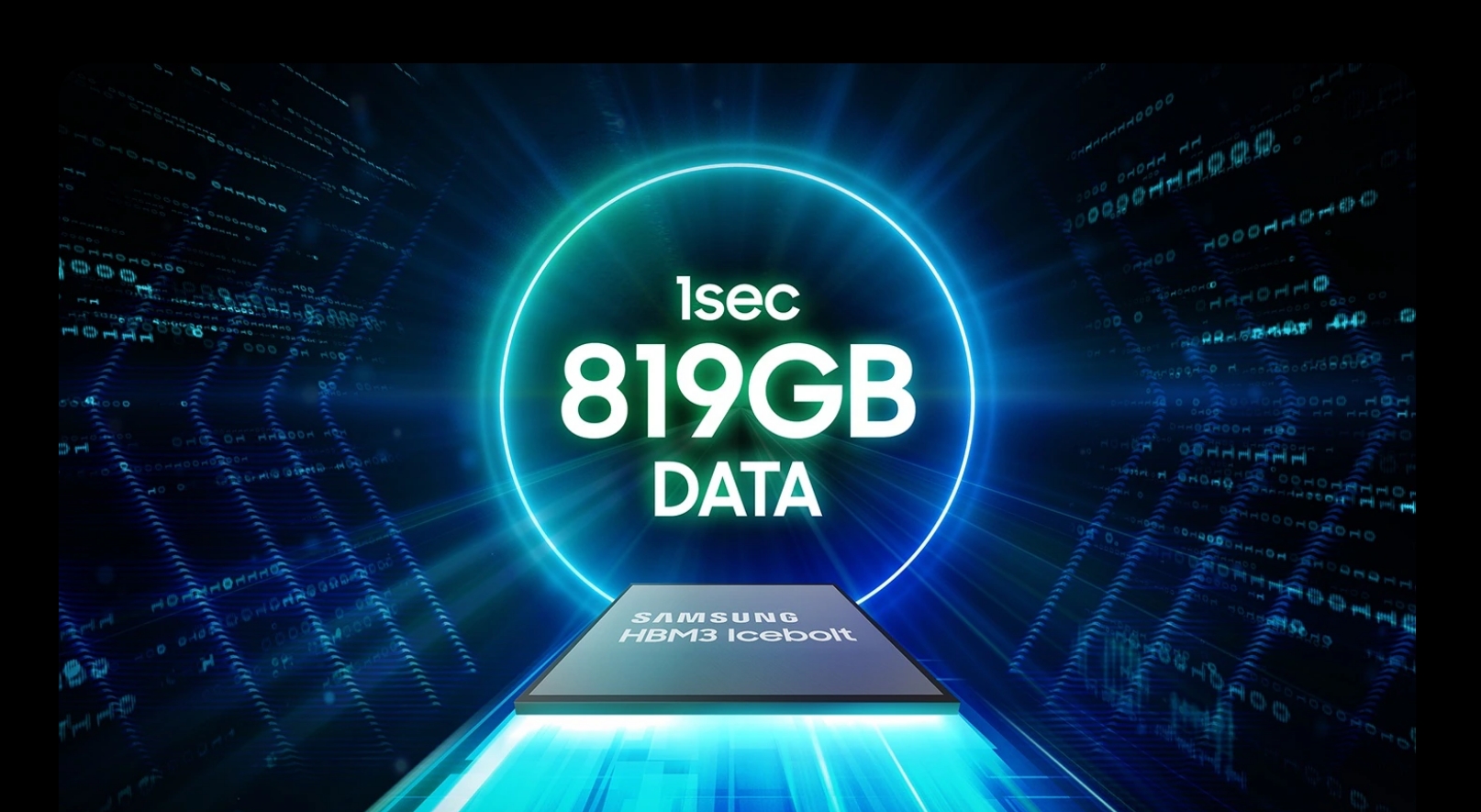

Các chip DRAM HBM3 của Samsung, được thiết kế để sử dụng trong bộ tăng tốc AI của Nvidia, đã gặp phải các vấn đề về hiệu suất trong quá trình thử nghiệm. Mối quan tâm chính xoay quanh việc sinh nhiệt quá mức và tiêu thụ điện năng cao, điều này làm dấy lên nghi ngờ về tính phù hợp của chúng đối với nhu cầu tính toán hiệu năng cao của Nvidia. HBM là viết tắt của Bộ nhớ băng thông cao, sử dụng thiết kế chip cung cấp băng thông cao hơn các mô-đun DDR4 hoặc GDDR5 trong khi sử dụng ít năng lượng hơn và ở dạng hệ số nhỏ hơn đáng kể. Điều này đạt được bằng cách xếp chồng tối đa tám DRAM chết và một khuôn đế tùy chọn có thể bao gồm mạch đệm và logic kiểm tra.

Mối lo ngại về tiêu thụ nhiệt và điện

Các vấn đề về nhiệt và tiêu thụ điện năng được báo cáo không chỉ riêng ở chip HBM3. Chip HBM3E của Samsung được ra mắt cách đây vài tháng cũng đang gặp vấn đề tương tự. Những vấn đề này trở nên rõ ràng khi kết quả chip HBM3E 8 lớp và 12 lớp của Samsung được ra mắt vào tháng 4 năm 2024.

Ngược lại, SK Hynix bắt đầu cung cấp chip HBM3E cho Nvidia vào tháng 3 năm 2024, định vị mình là một nhân tố chủ chốt trên thị trường HBM. SK Hynix hiện là nhà cung cấp chip HBM lớn nhất của Nvidia, loại chip rất cần thiết cho hoạt động của bộ tăng tốc AI. Sự thống trị của Nvidia trên thị trường AI, với 80% thị phần, khiến chứng nhận của Nvidia trở nên quan trọng đối với bất kỳ nhà sản xuất chip HBM nào.

Nỗ lực tối ưu hóa của Samsung

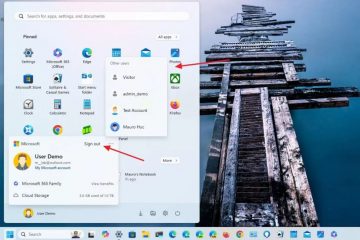

Samsung đã thừa nhận nhu cầu tối ưu hóa song song với yêu cầu của khách hàng. Công ty đã hợp tác chặt chẽ với khách hàng để giải quyết những vấn đề này và đã phấn đấu trong hơn một năm để vượt qua các bài kiểm tra nghiêm ngặt của Nvidia. Những thay đổi lãnh đạo gần đây của Samsung, bao gồm cả việc bổ nhiệm một cựu chuyên gia về phát triển flash DRAM và NAND, nhấn mạnh cam kết của họ trong việc giải quyết những thách thức này.

Chứng nhận từ Nvidia rất quan trọng đối với tham vọng của Samsung trên thị trường HBM. Các vấn đề về nhiệt và tiêu thụ điện năng chưa được giải quyết đã phủ bóng đen lên triển vọng của Samsung. Vẫn chưa chắc chắn liệu những vấn đề này có thể được giải quyết kịp thời hay không. Sự chứng thực của Giám đốc điều hành Nvidia Jensen Huang đối với chip nhớ HBM3E 12H (12 lớp) của Samsung tại hội nghị GTX AI 2024, nơi ông viết “Jensen Approved”trên chip, nêu bật tầm quan trọng của mối quan hệ hợp tác này.

Khả năng vượt qua những thách thức này của Samsung không chỉ quan trọng đối với hoạt động kinh doanh của họ mà còn đối với toàn bộ ngành công nghiệp. Cả AMD và Nvidia đều mong muốn Samsung giải quyết những vấn đề này để đảm bảo nguồn cung cấp chip HBM ổn định từ nhiều nhà cung cấp, giúp duy trì mức giá cạnh tranh. Samsung hiện đang cung cấp chip HBM cho AMD, điều này nhấn mạnh hơn nữa nhu cầu về các giải pháp bộ nhớ hiệu quả và đáng tin cậy.

Samsung đặt mục tiêu bắt đầu sản xuất hàng loạt chip HBM3E trước cuối quý 2 năm nay. Những nỗ lực hợp tác với khách hàng để tối ưu hóa chip HBM của họ phản ánh quyết tâm của họ trong việc đảm bảo chỗ đứng trong thị trường phần cứng AI đầy cạnh tranh. Kết quả của những nỗ lực này sẽ tác động đáng kể đến bối cảnh tương lai của máy gia tốc AI và điện toán hiệu năng cao.