Phần mềm TensorRT-LLM mã nguồn mở mới của NVIDIA, dự kiến phát hành trong những tuần tới, đã chứng tỏ hiệu suất tăng đáng kể. Trong các thử nghiệm sử dụng mẫu GPT-J 6B, hệ thống cập nhật đã cho thấy sự cải thiện hiệu suất gấp 8 lần so với A100, một bước nhảy vọt đáng kể so với lợi thế gấp 4 lần trước đó. Hơn nữa, khi được đánh giá trên Llama2 LLM của Meta, H100 được tăng cường TensorRT-LLM đã vượt qua A100 với hệ số 4,6, một sự cải thiện rõ rệt so với 2,6 lần trước khi cập nhật.

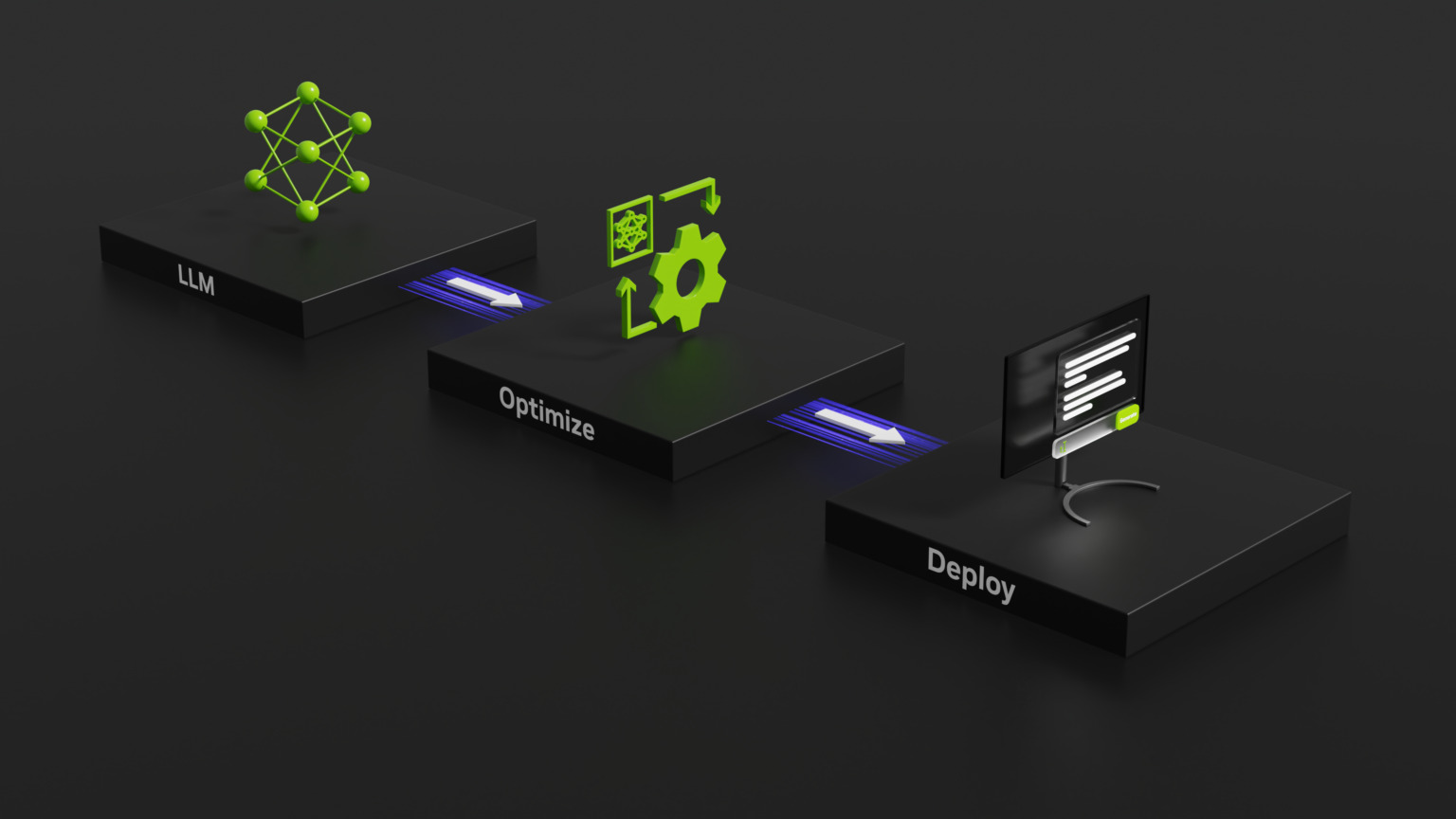

Nhằm nâng cao hiệu suất của Mô hình ngôn ngữ lớn (LLM), NVIDIA gần đây đã giới thiệu TensorRT-LLM, một thư viện nguồn mở được thiết kế để nâng cao hiệu suất của Mô hình ngôn ngữ lớn (LLM) trên phần cứng của NVIDIA.

TensorRT-LLM là thư viện mã nguồn mở hoạt động trên GPU NVIDIA Tensor Core. Chức năng chính của nó là cung cấp cho các nhà phát triển một môi trường để thử nghiệm và xây dựng các mô hình ngôn ngữ lớn mới, tạo thành nền tảng của các nền tảng AI tổng hợp như ChatGPT. Phần mềm này tập trung vào khả năng suy luận, giúp tinh chỉnh quy trình đào tạo của AI, giúp hệ thống hiểu cách liên kết các khái niệm và đưa ra dự đoán.

Vừa được công bố – NVIDIA TensorRT-LLM tăng cường mô hình ngôn ngữ lớn #inference trên GPU NVIDIA H100 Tensor Core. #LLM https://t.co/jMX0EDxkXJ

— Nhà phát triển AI của NVIDIA (@NVIDIAAIDEv) Ngày 8 tháng 9 năm 2023

Các kỹ thuật đổi mới đằng sau sự thúc đẩy

Thách thức với các mô hình ngôn ngữ lớn (LLM) nằm ở về tính linh hoạt của chúng, khiến việc phân nhóm các yêu cầu và thực hiện chúng đồng thời trở nên khó khăn. NVIDIA và các đối tác đã giải quyết thách thức này bằng cách tích hợp TensorRT-LLM với một phương pháp lập kế hoạch nâng cao có tên là”phân nhóm trong chuyến bay”. Cách tiếp cận đổi mới này cho phép phân đoạn việc tạo văn bản thành nhiều nhiệm vụ phụ.

Về cơ bản, hệ thống có thể xử lý đồng thời các lô mới từ các yêu cầu khác nhau thay vì đợi một lô hoàn thành. TensorRT-LLM bao gồm trình biên dịch học sâu TensorRT, hạt nhân được tối ưu hóa, các bước xử lý trước và sau, đồng thời tạo điều kiện giao tiếp giữa nhiều GPU và nút. với hiệu suất vượt trội trên GPU của NVIDIA, cho phép thử nghiệm mô hình ngôn ngữ lớn mới, tùy chỉnh nhanh và hiệu suất cao nhất.

Đo chuẩn sự xuất sắc và triển vọng trong tương lai

GH200 Grace của NVIDIA Hopper Superchip, kết hợp GPU Hopper với CPU Grace, đã cho thấy kết quả ấn tượng trong các tiêu chuẩn mới nhất của ngành MLPerf. Siêu chip này cùng với GPU H100 đã dẫn đầu trong tất cả các bài kiểm tra trung tâm dữ liệu của MLPerf, bao gồm thị giác máy tính, nhận dạng giọng nói, y tế hình ảnh và các nhiệm vụ đòi hỏi khắt khe hơn của hệ thống suy luận và đề xuất LLM. Hơn nữa, NVIDIA đã công bố một bản cập nhật phần mềm sắp tới sẽ nâng cao hơn nữa khả năng suy luận AI của Siêu chip GH200 Grace Hopper.

AI là một lĩnh vực tăng trưởng chính của Nvidia và công ty đã nhận thấy lợi ích khi tận dụng giữ vai trò chủ đạo trên thị trường. Các phân tích gần đây đã tiết lộ rằng Nvidia đang đảm bảo lợi nhuận gần 1.000% trên mỗi GPU H100 Tensor Core mà hãng bán ra. Những hiểu biết sâu sắc về tài chính từ Raymond James, một công ty dịch vụ tài chính uy tín, được chia sẻ trên Barron’s, đã ước tính chi phí sản xuất của một GPU như vậy vào khoảng 3.320 USD. Ngược lại, giá bán những GPU này của Nvidia dao động trong khoảng từ 25.000 đến 30.000 USD, tùy thuộc vào số lượng đặt hàng.