Binigyang-diin ni Mark Russinovich, Chief Technology Officer ng Microsoft Azure, ang lumalaking alalahanin sa seguridad na nauugnay sa generative AI. Sa pagsasalita sa Microsoft Build 2024 conference sa Seattle, binigyang-diin ni Russinovich ang magkakaibang hanay ng mga banta na dapat i-navigate ng mga Chief Information Security Officer (CISOs) at mga developer habang pinagsama-sama nila ang mga generative na teknolohiya ng AI. Binigyang-diin niya ang pangangailangan para sa isang multidisciplinary na diskarte sa seguridad ng AI, na kinabibilangan ng pagsusuri sa mga banta mula sa iba’t ibang anggulo gaya ng mga AI application, pinagbabatayan na code ng modelo, mga kahilingan sa API, data ng pagsasanay, at mga potensyal na backdoor.

Data Poisoning. at Misclassification ng Model

Isa sa mga pangunahing alalahanin na tinutugunan ni Russinovich ay ang pagkalason sa data. Sa mga pag-atakeng ito, minamanipula ng mga kalaban ang mga dataset na ginagamit upang sanayin ang AI o mga modelo ng machine learning, na humahantong sa mga sira na output. Inilarawan niya ito sa isang halimbawa kung saan ang digital na ingay na idinagdag sa isang imahe ay naging dahilan upang mali ang pagkaka-uri ng AI sa isang panda bilang isang unggoy. Ang ganitong uri ng pag-atake ay maaaring maging partikular na mapanlinlang dahil kahit na ang isang maliit na pagbabago, tulad ng isang backdoor insertion, ay maaaring makabuluhang makaapekto sa pagganap ng modelo.

Tinalakay din ni Russinovich ang isyu ng mga backdoor sa loob ng mga modelo ng AI. Bagama’t madalas na nakikita bilang isang kahinaan, ang mga backdoor ay maaari ding magsilbi upang i-verify ang pagiging tunay at integridad ng isang modelo. Ipinaliwanag niya na ang mga backdoor ay maaaring gamitin sa fingerprint ng isang modelo, na nagbibigay-daan sa software na suriin ang pagiging tunay nito. Kabilang dito ang pagdaragdag ng mga natatanging tanong sa code na malamang na hindi itanong ng mga totoong user, sa gayon ay tinitiyak ang integridad ng modelo.

Prompt Injection Techniques

Ang isa pang makabuluhang banta na itinampok ni Russinovich ay ang agarang mga diskarte sa pag-iniksyon. Kabilang dito ang paglalagay ng mga nakatagong text sa mga diyalogo, na maaaring humantong sa mga pagtagas ng data o makaimpluwensya sa gawi ng AI na higit pa sa mga nilalayong operasyon nito. Nakita namin kung paano mahina ang GPT-4 V ng OpenAI sa ganitong uri ng pag-atake. Ipinakita niya kung paano maaaring magresulta sa pagtagas ng pribadong data ang isang piraso ng nakatagong text na na-inject sa isang diyalogo, katulad ng mga pagsasamantala sa cross-site scripting sa seguridad sa web. Nangangailangan ito ng paghihiwalay ng mga user, session, at content sa isa’t isa para maiwasan ang mga ganitong pag-atake.

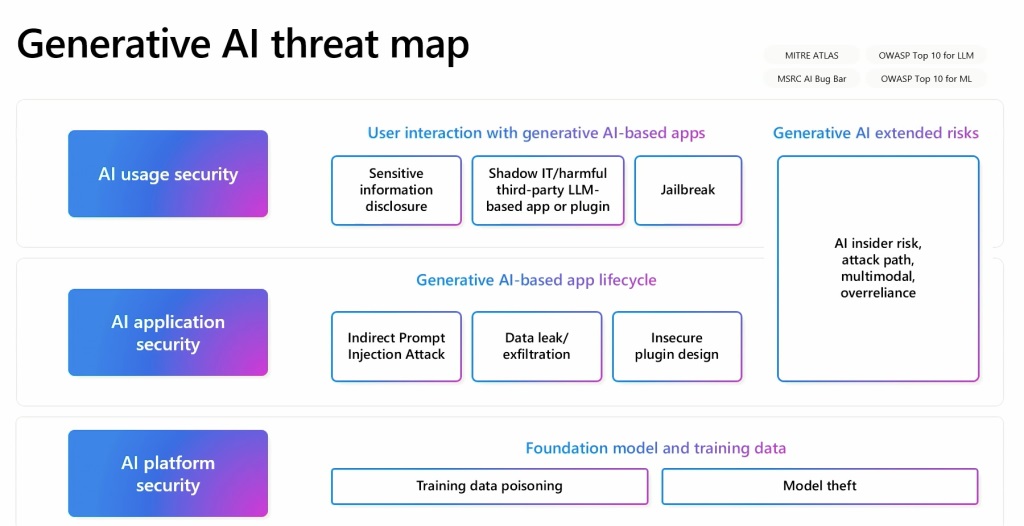

Nangunguna sa mga alalahanin ng Microsoft ang mga isyung nauugnay sa pagsisiwalat ng sensitibong data, mga diskarte sa pag-jailbreak upang maabutan ang mga modelo ng AI, at pagpilit sa ikatlong-mga application ng partido at modelo ng mga plugin upang i-bypass ang mga filter ng kaligtasan o gumawa ng pinaghihigpitang nilalaman. Binanggit ni Russinovich ang isang partikular na paraan ng pag-atake, ang Crescendo, na maaaring i-bypass ang mga hakbang sa kaligtasan ng nilalaman upang mahikayat ang isang modelo sa pagbuo ng mapaminsalang nilalaman.

Halistic Approach sa AI Security

Inihalintulad ni Russinovich ang mga modelo ng AI sa”talagang matalino ngunit junior o walang muwang na mga empleyado”na, sa kabila ng kanilang katalinuhan, ay madaling kapitan ng pagmamanipula at maaaring kumilos laban sa mga patakaran ng isang organisasyon nang walang mahigpit na pangangasiwa. Binigyang-diin niya ang mga likas na panganib sa seguridad sa loob ng malalaking modelo ng wika (LLM) at ang kailangan ng mahigpit na guardrail upang mabawasan ang mga kahinaan na ito.

Bumuo si Russinovich ng generative AI threat map na nagbabalangkas sa mga ugnayan ng iba’t ibang elementong ito Nagbigay siya ng isang halimbawa kung paano maaaring humantong sa mga pangmatagalang isyu ang pagtatanim ng nalason na data sa isang pahina ng Wikipedia, na kilala bilang isang data source, kahit na ang data ay naitama sa ibang pagkakataon umiiral sa orihinal na pinagmulan.