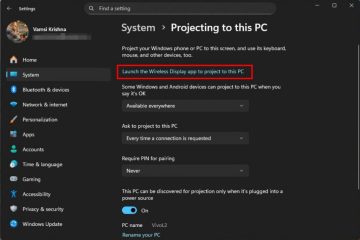

inihayag ng AMD noong Martes na ang pinakabagong hardware nito ay sumusuporta sa mga bagong modelo ng’GPT-oss` ng OpenAi. Ang suporta ay para sa pinakabagong mga produkto ng consumer, tulad ng Ryzen AI Chips at Radeon Graphics Cards. Sa isang susi muna, sinabi ng AMD na ang Ryzen Ai Max+ 395 chip ay maaaring magpatakbo ng malaking 120-bilyong modelo ng parameter sa isang lokal na PC. Ang pagbabago ay nagbibigay-daan para sa mas mabilis, mas pribado, at offline na AI apps. Maaaring gamitin ng mga nag-develop ang tool ng LM Studio upang patakbuhin ang mga modelo ngayon, na ginagawang mas madaling ma-access ang malakas na AI. href=”https://www.amd.com/en/blogs/2025/how-to-run-openai-gpt-oss-20b-120b-models-on-amd-ryzen-ai-radeon.html”target=”_ blangko”> inaangkin ang isang mundo-para sa consumer ng hardware nito . Inanunsyo ng kumpanya ang Ryzen AI Max+ 395 processor, kapag na-configure na may 128GB ng RAM, ay ang unang chip ng consumer na may kakayahang lokal na tumatakbo ang napakalaking 117-bilyong parameter ng Openai na `GPT-OSS-120B` na modelo.

This is a significant milestone. Nagbabago ito ng mga workload ng Datacenter-Class AI mula sa ulap hanggang sa isang desktop o laptop. Ayon sa AMD, nakamit ng system ang isang napaka-magagamit na pagganap ng hanggang sa 30 mga token bawat segundo, na ginagawang kumplikadong lokal na AI ang isang praktikal na katotohanan para sa mga nag-develop at mananaliksik.

[naka-embed na nilalaman]

Ang mga kinakailangan sa teknikal ay matarik ngunit nagsasabi. Ang modelo ng `gpt-oss-120b` ay nangangailangan ng tungkol sa 61GB ng VRAM. Ito ay umaangkop sa loob ng 96GB ng dedikadong memorya ng graphics na magagamit sa dalubhasang ryzen ai max+ 395 platform, isang kakayahan kamakailan-lamang na naka-highlight . Binibigyang diin ng kumpanya ang mahusay na oras-sa-unang-token (TTFT), na nagsisiguro na tumutugon sa pagganap para sa mga daloy ng ahente na umaasa sa mabilis na paunang mga output. Kinakatawan nila ang isang madiskarteng pivot para sa OpenAi. Ang disenyo na ito ay nagpapa-aktibo lamang ng isang maliit na bahagi ng kabuuang mga parameter para sa anumang naibigay na gawain, drastically na binabawasan ang computational na gastos at ginagawa silang mabubuhay para sa pagpapatupad ng on-device. Ang template na ito ay istruktura ang output ng modelo sa magkahiwalay na mga channel para sa pangangatuwiran, paggamit ng tool, at pangwakas na sagot, na nagbibigay sa mga developer ng mas malinaw na kontrol. href=”https://rocm.blogs.amd.com/developer-guides/2025/08/05/day-0-developer-guide-running-the-latest-open-models-from-openai-on-amd-ai-hardware.html”target=”_ blangko”> malinaw na landas para sa mga developer upang magsimula . Ang pangunahing tool ay ang LM Studio, isang libreng application na nagpapasimple sa pag-download at pagpapatakbo ng mga LLM. Kailangan ding i-install ng mga gumagamit ang pinakabagong AMD software: adrenalin edition driver (bersyon 25.8.1 o mas mataas) upang i-unlock ang mga kinakailangang tampok. Ang pag-offload ng lahat ng mga computational layer sa GPU, at pagkatapos ay i-load ang modelo sa memorya. Habang ang modelo ng 120B ay maaaring maglaan ng oras upang mai-load dahil sa laki nito, ang resulta ay isang malakas na pangangatuwiran na makina na tumatakbo nang lokal. Ito ay isang pangunahing bahagi ng isang maingat na na-orkestra na kaganapan sa buong industriya na idinisenyo upang maitaguyod ang `GPT-oss` at pagkakaisa bilang isang bagong pamantayan. Inihayag ng Microsoft ang Windows AI Foundry at Foundry Local Platform upang patakbuhin ang mga modelo sa Windows at MacOS. Sumali rin si Qualcomm, na nagpapagana ng suporta sa on-aparato para sa mga PC na pinapagana ng Snapdragon. Iminumungkahi ng mga analyst na”sa bahagi, ito ay tungkol sa muling pagsasaalang-alang sa pangingibabaw ni OpenAi sa ekosistema ng pananaliksik.”Ang sentimentong ito ay binibigkas sa sariling pag-frame ng Openai ng pagpapalaya, kasama ang kumpanya na nagsasabi na ang”malawak na pag-access sa mga may kakayahang open-weight na mga modelong nilikha sa US ay tumutulong na mapalawak ang mga demokratikong AI riles.”Sa pamamagitan ng pagbibigay ng malakas, naa-access, at malawak na suportadong mga modelo, ang kumpanya ay gumagawa ng isang nakakahimok na kaso para sa ekosistema nito. Tulad ng nabanggit ni Asha Sharma ng Microsoft,”Sa kauna-unahang pagkakataon, maaari kang magpatakbo ng mga modelo ng OpenAI tulad ng GPT-ISS-120B sa isang solong negosyo na GPU-o patakbuhin ang GPT-ISS-20B nang lokal.”Ang pag-highlight ng bagong Hybrid AI Reality