Ang

Anthropic ay nagpakilala ng isang bagong sistema ng seguridad para sa mga modelo ng Claude AI, na binabawasan ang rate ng tagumpay ng pag-atake ng jailbreak mula sa 86% hanggang sa 4.4% lamang.

AI-nabuo na mga tugon upang maiwasan ang mga pagtatangka sa pagmamanipula.

> Mga diskarte sa malikhaing upang makaligtaan ang mga built-in na mga paghihigpit. Ang mga umaatake ay matagumpay na sinamantala ang mga kahinaan ng AI sa pamamagitan ng mga pamamaraan tulad ng mga senaryo na naglalaro ng papel at pag-format ng mga trick na nalito ang mga filter ng pag-moder ng nilalaman.

Kaugnay: Anthropic On Top

Sa ngayon ay ganap na lumalaban sa mga jailbreaks. Ang kumpanya ay niraranggo ang pinakamataas sa 2024 AI Safety Index, na outperforming na mga kakumpitensya tulad ng OpenAi, Google, at Meta.

Gayunpaman, habang lumalawak ang mga kakayahan ng AI, ang mga panganib na nauugnay sa mga jailbreaks ay patuloy na nagbabago, na ginagawang mas kritikal ang mga diskarte sa seguridad kaysa dati. Oras ng Bandit’Pagsasamantalahan ng mga Bypasses Openai na Mga Pangangalaga sa Oras ng Pagkalito mula sa pagbuo ng nilalaman na may kaugnayan sa mga armas, cybercrime, o iba pang mga paghihigpit na mga paksa. Gayunpaman, ang mga gumagamit ay paulit-ulit na nakahanap ng mga paraan upang maiiwasan ang mga pangangalaga na ito. Ang mga karaniwang pamamaraan ng jailbreak ay kinabibilangan ng:

Ang pag-format ng pagmamanipula , tulad ng pagpasok ng mga espesyal na character o pagbabago ng mga istruktura ng pangungusap upang maiiwasan ang mga filter ng nilalaman. maaari pa ring bigyang-kahulugan habang ang mga layer ng seguridad ay nabigo upang makita ang kahilingan. Sa kabila ng patuloy na mga pagpipino sa seguridad ng AI, ang mga mananaliksik ay hindi pa nagkakaroon ng isang sistema na ganap na lumalaban sa mga pamamaraan na ito. Ang mga flaws

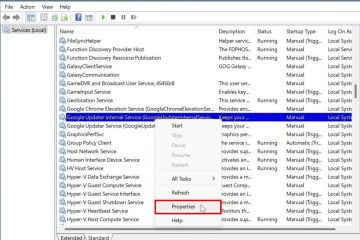

Ang Classifier ng Konstitusyon ay isang halimbawa kung paano inuuna ng kumpanya ang seguridad habang ang AI ay nagiging mas sopistikado. Model Architecture, binuo ng Anthropic ang konstitusyon ng konstitusyon bilang isang panlabas na sistema na nakikipag-ugnay at sinusuri ang parehong mga input ng gumagamit at mga generated output.

Kung ang isang query ay itinuturing na kahina-hinala, naharang ito bago maabot ang modelo ng AI, na pumipigil sa hindi sinasadyang mga tugon. P>

Ang system ay sinanay gamit ang sintetikong data, gamit ang mga halimbawa ng parehong katanggap-tanggap at hindi katanggap-tanggap, nabuo ang mga pakikipag-ugnay sa AI. Ginamit ni Anthropic ang pamamaraang ito upang ilantad ang classifier sa isang malawak na hanay ng mga diskarte sa kalaban, kabilang ang mga pagkakaiba-iba sa wika, syntax, at pag-format.

Ang system, binigyang diin sa MIT TECHNOLOGY REVIEW Ang kahalagahan ng pag-target sa pinaka matinding pagtatangka sa jailbreak.

ganap na.”

Maaaring pilitin si Claude na sagutin ang sampung mga paghihigpit na katanungan. Ang hamon ay iginuhit ang pakikilahok mula sa 183 mga tester, kasama na ang nakaranas ng mga jailbreaker ng AI at mga mananaliksik ng seguridad, na sama-sama na gumugol ng higit sa 3,000 oras na sinusubukan na malampasan ang system. mga paghihigpit na katanungan. Ang pinakamalapit na sinumang dumating ay matagumpay na lumampas sa filter sa lima sa sampung query. Bilang karagdagan, sa isang hiwalay na awtomatikong pagsubok, ang Anthropic ay nagpatakbo ng 10,000 AI-generated jailbreak na pagtatangka laban sa klasipikasyon nito.

Kaugnay: Nabigo ang modelo sa 86% ng mga kaso, na nagbibigay ng mga tugon na dapat na naharang. Sa lugar ng klasipikasyon, ang rate ng pagkabigo ay bumaba sa 4.4%./opera_2025-02-03_18-58-11-1024×619.jpg”>anthropic universal jailbreak testing site para sa mga konstitusyonal na klasipikasyon malakas.”Bihirang makita ang mga pagsusuri na ginawa sa scale na ito,”sabi ni Robey.”Malinaw na ipinakita nila ang katatagan laban sa mga pag-atake na kilala upang maiiwasan ang karamihan sa iba pang mga modelo ng produksiyon.”

Ang pagtaas ng mga gastos

Ibig sabihin ang ilang mga wastong kahilingan ay maaaring tanggihan pa. Bilang isang resulta, ang pagpapatupad ng system ay nagtataas ng mga gastos sa pagpapatakbo ng 23.7%. Maaari itong gawing mas mahal ang pag-deploy, lalo na para sa mga negosyo na nagpapatakbo ng mga malalaking aplikasyon ng AI. Ang pangako ng kumpanya sa kaligtasan ng AI ay isang pagtukoy ng tampok ng diskarte nito, tulad ng nakabalangkas sa responsableng patakaran sa pag-scale, na nag-uutos ng mahigpit na pagsusuri sa kaligtasan bago ilunsad ang mas advanced na mga modelo ng AI. Gayunpaman, ang pagbabalanse ng seguridad at kakayahang magamit ay nananatiling isang patuloy na hamon. at ang mga regulasyon na katawan ay nagdaragdag ng kanilang pagsisiyasat ng mga modelo ng AI. Sa mga alalahanin sa paglalagay ng maling impormasyon ng AI, mga banta sa cyber, at hindi awtorisadong paggamit ng mga kaso, ang mga regulator ay nagtutulak para sa higit na transparency at mas mahigpit na mga protocol ng kaligtasan. tulad ng EU AI Act, na naglalayong magtatag ng malinaw na mga alituntunin para sa pamamahala ng peligro ng AI. Gayunpaman, ang kumpanya ay nahaharap din sa pagsisiyasat para sa iba pang mga kadahilanan, lalo na tungkol sa mga pakikipagsosyo sa korporasyon. Its $2 billion investment from Google is currently under investigation by the UK’s Competition and Markets Authority (CMA), which is assessing whether such financial backing gives Google undue influence over AI development.

These regulatory efforts reflect growing concerns that Ang isang bilang ng mga malalaking tech firms ay maaaring makakuha ng labis na kontrol sa pagbabago ng AI. Habang ang Anthropic ay nakaposisyon mismo bilang isang tagapagtaguyod para sa responsableng AI, ang mga mapagkukunan ng pagpopondo at pakikipagsosyo ay mananatiling isang paksa ng debate sa loob ng mga bilog sa industriya at patakaran. Malakas>

Ang mga jailbreaker ay patuloy na bumubuo ng mga bagong pamamaraan upang manipulahin ang mga modelo ng AI, at binabalaan ng mga mananaliksik na ang mga pag-atake sa hinaharap ay maaaring maging mas sopistikado. Pinapayagan nito ang AI na bigyang-kahulugan ang mga ito habang ang mga layer ng seguridad ay nabigo upang makita ang pagmamanipula.

“Ang isang gumagamit ay maaaring makipag-usap sa modelo gamit ang naka-encrypt na teksto kung ang modelo ay sapat na matalino at madaling i-bypass ang ganitong uri ng pagtatanggol,”puna ni Li sa pagsusuri ng teknolohiya ng MIT. Ang Konstitusyon ng Konstitusyon para sa karagdagang pagsubok. Maghanap ng mga kahinaan sa system. Isang href=”https://t.co/9y0fit79pn”> https://t.co/9y0fit79pn

-jan leike (@janleike) Pebrero 3, 2025.//winbuzzer.com/wp-content/uploads/2025/02/anthropic-constitutional-classifier-jailbreak-test-demo-site-1024×619.jpg”>

Habang ang kumpanya ay nagpakita ng kahanga-hangang pag-unlad sa pagbabawas ng mga kahinaan sa jailbreak, Ang pangmatagalang pagiging epektibo ng diskarte nito ay depende sa kung gaano kabilis maaari itong umangkop sa mga bagong banta. Sa pamamagitan ng pag-iingat ng regulasyon na tumitindi at umuusbong ang mga Frameworks ng pamamahala ng AI, ang mga kumpanya na nagtatapon ng mga sistema ng AI ay haharapin ang pagtaas ng presyon upang maipatupad ang maaasahan at transparent na mga hakbang sa seguridad. Patuloy na lahi ng armas. Ang classifier ng konstitusyon ng Anthropic ay kumakatawan sa isang makabuluhang hakbang patungo sa mas ligtas na mga sistema ng AI, ngunit binibigyang diin din nito ang mga hamon ng kaligtasan, kakayahang magamit, at gastos.