Nakadepende ang artificial intelligence sa kakayahan nitong mag-interpret ng data, umangkop sa mga dynamic na kapaligiran, at gumawa ng mga desisyon na may hindi kumpletong impormasyon. Nasa gitna ng mga prosesong ito ang entropy—isang sukatan na sumusukat sa kawalan ng katiyakan at randomness.

Orihinal na cna dating sa thermodynamics, ang entropy ngayon ay gumaganap ng isang pangunahing papel sa AI, na gumagabay system upang balansehin ang istraktura na may kakayahang umangkop at pagpapahusay ng kanilang kakayahang pangasiwaan ang mga kumplikadong gawain.

Claude Shannon muling tinukoy ang entropy noong 1948, pagbabago nito sa isang sukatan ng kawalan ng katiyakan para sa mga sistema ng impormasyon. Ang gawa ni Shannon ay nagbigay ng mathematical framework para sa pag-optimize ng paghahatid ng data, at ang kanyang mga insight ay naka-embed na ngayon sa mga disiplina ng AI.

Ngayon, ang entropy ay nagtutulak ng mga inobasyon sa machine learning, paggawa ng synthetic data, mga generative na modelo , reinforcement learning, at quantum computing. Habang ang AI ay nagiging higit na mahalaga sa mga modernong teknolohiya, ang pag-unawa sa mga aplikasyon ng entropy ay susi para sa mas matalinong, mas adaptive na mga system.

Ang Pinagmulan ng Entropy

Ang Entropy ay unang ipinakilala noong ika-19 na siglo habang hinahangad ng mga siyentipiko na maunawaan ang kahusayan ng enerhiya sa mga thermodynamic system. Sadi Carnot’s pioneering mga pag-aaral sa init mga makina ay nagbigay inspirasyon kay Rudolf Clausius upang tukuyin ang entropy pormal.

Inilarawan ito ni Clausius bilang bahagi ng enerhiya sa isang sistema na hindi maaaring gawing trabaho, na sumasalamin sa pagkahilig ng uniberso sa mas malaking kaguluhan. Ang konseptong thermodynamic na ito ay naglatag ng batayan para sa pag-unawa sa randomness at irreversibility sa mga pisikal na system.

Claude Shannon’s Breakthrough

Binago ni Claude Shannon ang entropy sa pamamagitan ng paglalapat nito sa mga information system. Sa kanyang seminal paper na A Mathematical Theory of Communication, Inilarawan ni Shannon ang entropy bilang isang sukatan ng kawalan ng katiyakan sa isang dataset. Sumulat siya,”Ang pangunahing problema ng komunikasyon ay ang pagpaparami sa isang punto nang eksakto o humigit-kumulang sa isang mensahe na pinili sa isa pang punto.”

Ang entropy ni Shannon ay sumukat sa hindi mahuhulaan ng impormasyon, na nagbibigay-daan sa mga inhinyero na kalkulahin ang kahusayan ng Ang paghahatid at compression ng data ay itinatag ng kanyang formula bilang isang unibersal na sukatan para sa pagsukat ng kawalan ng katiyakan, pag-uugnay nito sa mga pamamahagi ng posibilidad at paglikha ng isang pundasyon para sa modernong data-driven. mga teknolohiya.

Entropy sa Machine Learning

Sa machine learning, sinusuri ng entropy ang randomness o karumihan sa loob ng mga dataset, na gumagabay sa mga algorithm na gumawa ng mga desisyon na nagpapaliit ng kawalan ng katiyakan

Decision trees, halimbawa, gumamit ng entropy upang matukoy ang pinaka-kaalaman na mga hati. Pinipili ang mga katangiang nagpapalaki ng impormasyon, o ang pagbawas sa entropy, bilang pamantayan sa paghahati, na nagpapahusay sa katumpakan ng pag-uuri ng modelo.

Isaalang-alang ang isang dataset na may mga mixed-class na label: ang mataas na entropy nito ay nagpapakita ng hindi mahuhulaan. Sa pamamagitan ng paghahati ng data sa mga subset batay sa isang partikular na katangian, nababawasan ang entropy, na nagreresulta sa mas magkakatulad na mga grupo.

Ang umuulit na prosesong ito ay bumubuo ng isang puno ng desisyon na sistematikong nagpapababa ng kawalan ng katiyakan, na lumilikha ng isang istraktura na na-optimize para sa mga tumpak na hula.

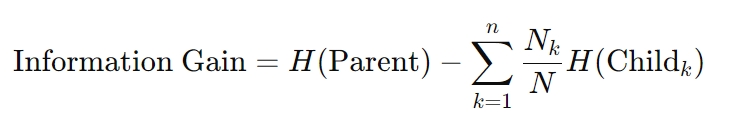

Ang formula para sa pagkuha ng impormasyon ay ang mga sumusunod:

Dito, H ay kumakatawan sa entropy, Nk ay ang bilang ng sample sa k-th child node, at ang N ay ang kabuuang bilang ng sample sa parent node. Tinitiyak ng kalkulasyong ito na ang bawat desisyon ay lubos na nakakabawas ng kawalan ng katiyakan, isang prinsipyong batayan sa mga algorithm ng decision tree.

Cross-Entropy Loss sa Neural Networks

Entropy also underpins optimization mga diskarte sa neural network. Ang Cross-entropy loss, isang sukatan na malawakang ginagamit sa mga gawain sa pag-uuri, ay sumusukat sa pagkakaiba sa pagitan ng mga hinulaang probabilidad at aktwal na mga label. Ang pag-minimize sa pagkawala na ito ay iniayon ang mga hula ng modelo sa mga tunay na kinalabasan, na nagpapahusay sa katumpakan.

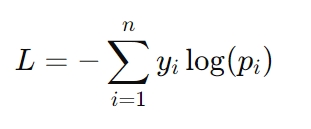

Ang formula para sa cross-entropy loss ay:

Narito, Ang yi ay kumakatawan sa aktwal na label (hal., 0 o 1), at pi ang hinulaang posibilidad para sa label na iyon. Ang cross-entropy loss ay partikular na kritikal sa mga gawain tulad ng pagkilala sa larawan at pagmomodelo ng wika, kung saan ang mga tiyak na hula sa posibilidad ay kinakailangan para sa tagumpay.

Ang Papel ng Entropy sa Paglikha ng Synthetic na Data

Ang synthetic na data ay naging isang kritikal na mapagkukunan sa pagbuo ng AI, na nag-aalok ng mga solusyon sa mga hamon tulad ng limitadong pag-access sa mga real-world na dataset, mga alalahanin sa privacy, at mga hadlang sa gastos.

Gayunpaman, ang pagiging epektibo ng mga sintetikong dataset ay lubos na nakadepende sa kanilang mga antas ng entropy. Ipinapakilala ng high-entropy synthetic data ang pagkakaiba-iba na kailangan para gayahin ang mga tunay na kondisyon, na nagbibigay-daan sa mga modelo ng AI na mag-generalize nang mas mahusay sa mga bagong senaryo.

Gayunpaman, ang sobrang entropy ay maaaring magpasok ng ingay, na humahantong sa overfitting—kung saan ang modelo ay nagiging sobrang nakatutok sa data ng pagsasanay at nabigong gumanap nang maayos sa mga hindi nakikitang halimbawa.

Sa kabaligtaran, pinapasimple ng mga low-entropy na dataset ang pag-aaral ngunit maaaring hindi gaanong kinakatawan ang pagiging kumplikado ng data sa totoong mundo. Ang kawalan ng timbang na ito ay nanganganib sa underfitting, kung saan nabigo ang mga modelo na kumuha ng mga makabuluhang pattern, na nagreresulta sa hindi magandang generalization. Ang pagkakaroon ng tamang balanse sa pagitan ng mga sukdulang ito ay susi sa paglikha ng mataas na kalidad na sintetikong data.

Mga Teknik para sa Pag-optimize ng Synthetic Data na may Entropy

Upang matugunan ang mga hamon na iniharap sa pamamagitan ng entropy sa mga synthetic na dataset, gumagamit ang mga mananaliksik ng mga advanced na diskarte na nagpapahusay sa kalidad ng data habang pinapanatili ang kaugnayan:

Entropy Selection na may Real-Synthetic Similarity Maximization (ESRM): Kinikilala ng ESRM ang mga synthetic na sample na malapit na sumasalamin sa totoong-world na data, pagtiyak na ang mga dataset ng pagsasanay ay mananatiling magkakaibang ngunit mapapamahalaan. Tinitiyak ng pagbabalanse ng entropy sa mga sintetikong dataset na sinasanay ang mga modelo sa magkakaibang ngunit nauugnay na mga halimbawa, na nagpapababa ng ingay habang pinapanatili ang utility. Paglilinis at Pag-normalize ng Data: Nakakatulong ang mga prosesong ito na alisin ang labis na randomness sa pamamagitan ng pag-align ng mga synthetic na pamamahagi ng data sa mga dataset sa totoong mundo. Tinitiyak ng normalization na ang mga dataset ay tugma sa mga machine learning algorithm, na nagpapadali sa mas maayos na convergence ng modelo. Pagpipilian ng Feature: Sa pamamagitan ng pagtuon sa mga feature na mayaman sa entropy na nagbibigay ng pinakamaraming impormasyon, binabawasan ng pagpili ng feature ang redundancy at ingay, na ginagawang mas epektibo ang synthetic data para sa pagsasanay ng modelo.

Ang mga pamamaraang ito ay nagpapahusay sa pagiging maaasahan ng synthetic na data, na tumutulong sa mga AI system na makamit ang matatag na generalization nang walang overfitting o underfitting.

Generative AI: Creativity and Control Through Entropy

Generative AI, na kinabibilangan ng mga system tulad ng mga text generator, image creator, at audio synthesis tool, ay umaasa sa entropy upang makontrol ang balanse sa pagitan ng pagkamalikhain at pagkakaugnay-ugnay.

Sa pamamagitan ng pagsasaayos ng mga entropy threshold, maaaring maimpluwensyahan ng mga developer kung gaano mahuhulaan o iba-iba ang mga nabuong output.

Halimbawa, tinitiyak ng mababang-entropy na setting na ang mga tugon ay nakatuon at may kaugnayan, perpekto para sa mga application tulad ng mga chatbot sa serbisyo sa customer o mga awtomatikong katulong sa pagsulat. Sa kabaligtaran, ang mas mataas na entropy ay nagpapakilala ng pagkakaiba-iba at pagiging bago, na nagbibigay-daan sa mga malikhaing gawain tulad ng pagbuo ng sining o pagkukuwento.

Ang kontrol na ito ay kritikal para sa pag-angkop ng generative AI sa mga partikular na kaso ng paggamit. Sa mga praktikal na aplikasyon, nakakatulong ang mga pagsasaayos ng entropy na mapanatili ang balanse sa pagitan ng pagbabago at katumpakan, na tinitiyak na ang mga output ay nakakatugon sa mga gustong layunin nang hindi nakompromiso ang kalidad.

Pagpapatunay ng AI-Generated Content

Ang masusukat na puwang na ito ay nagbibigay ng benchmark para sa pagkilala sa synthetic na nilalaman mula sa mga tunay na ekspresyon ng tao.

Ang mga naturang sukatan ay may praktikal na aplikasyon sa paglaban sa maling impormasyon at pagtiyak sa integridad ng nilalamang binuo ng AI. Gumagamit ang mga organisasyon ng pagsusuri sa entropy upang matukoy ang potensyal na maling paggamit ng generative AI sa mga deepfakes, fake news, o automated na propaganda, na itinatampok ang lumalaking kahalagahan nito sa pag-verify ng content.

Reinforcement Learning: Exploring the Unknown with Entropy

Sa reinforcement pag-aaral (RL), ang entropy ay kritikal para sa pagpapanatili ng maselang balanse sa pagitan ng paggalugad at pagsasamantala. Kasama sa pag-explore ang pagsubok ng mga bagong aksyon para makatuklas ng mas mahuhusay na diskarte, habang ang pagsasamantala ay nakatuon sa pagpino ng mga kilalang aksyon para ma-maximize ang mga reward. Ang mga patakarang may mataas na entropy ay naghihikayat ng magkakaibang pagpili ng aksyon, na pumipigil sa mga ahente na maipit sa mga suboptimal na solusyon.

Ang prinsipyong ito ay lalong mahalaga sa mga dynamic na kapaligiran, gaya ng autonomous robotics, AI na naglalaro ng laro, at adaptive logistics system, kung saan flexibility at adaptability ay mahalaga.

Entropy regularization—isang pamamaraan na nagpapakilala ng termino ng parusa batay sa policy entropy—nagtitiyak na mananatili ang mga ahente sapat na randomness upang galugarin ang mga alternatibong estratehiya nang hindi nakompromiso ang pangmatagalang pagganap.

Pagpapatatag ng Pag-aaral gamit ang Entropy

Mga paraan ng gradient ng patakaran, isang klase ng mga RL algorithm, nakikinabang din sa mga epekto ng pag-stabilize ng entropy. Sa pamamagitan ng pagpapanatili ng kontroladong randomness sa proseso ng paggawa ng desisyon ng ahente, pinipigilan ng entropy ang maagang convergence at nagpapaunlad ng mas malawak na paggalugad.

Siguraduhin ng entropy na ang mga ahente ng reinforcement learning ay mananatiling madaling ibagay, na nagbibigay-daan sa kanila na umunlad sa kumplikado at hindi mahuhulaan na mga kapaligiran.

Entropy sa Quantum Computing at Data Compression

Sa quantum computing, ang entropy ay gumaganap ng mahalagang papel sa pagsusuri ng pagkakaugnay-ugnay at pagkakabuhol ng mga estadong quantum. Hindi tulad ng mga klasikal na sistema, kung saan binibilang ng entropy ang kaguluhan sa mga distribusyon ng data, nakukuha ng quantum entropy ang probabilistikong katangian ng mga quantum system.

Ang mga sukatan tulad ng von Neumann entropy ay malawakang ginagamit upang sukatin ang kawalan ng katiyakan at gabayan ang pag-optimize ng hybrid quantum-mga klasikal na algorithm.

Ang mga algorithm na ito ay gumagamit ng quantum entropy upang malutas ang mga problema na hindi magagawa sa computation para sa mga classical na system, tulad ng kumplikadong pag-optimize mga gawain, cryptography, at simulation ng mga istrukturang molekular.

Halimbawa, ang von Neumann entropy ay nakatulong sa pagpino ng mga quantum neural network, na pinaghalo ang probabilistikong mga prinsipyo ng quantum mechanics sa mga tradisyonal na machine learning frameworks. Ang entropy ay karaniwang tinutulay ang kawalan ng katiyakan na likas sa quantum mechanics na may predictability na hinihingi ng mga klasikal na system.

Ang quantum entropy ay tumutulong din sa pagwawasto ng error, isang pangunahing hamon sa quantum computing. Sa pamamagitan ng pagtukoy at pagliit ng mga pinagmumulan ng entropy sa loob ng mga quantum system, mapapabuti ng mga developer ang katatagan at pagiging maaasahan ng mga qubit, na nagbibigay daan para sa mas mahusay na mga teknolohiyang quantum.

Entropy-Driven Data Compression h4>

Sinusuportahan ng entropy ang compression ng data algorithm, na nagpapagana ng mahusay na pag-iimbak at paghahatid sa pamamagitan ng pagbabawas ng redundancy habang pinapanatili ang mahahalagang impormasyon. Sinusuri ng mga diskarte sa compression ang mga antas ng entropy sa loob ng mga dataset para ma-optimize ang mga scheme ng pag-encode, na nagbibigay ng balanse sa pagitan ng pagliit ng mga laki ng file at pagpapanatili ng integridad ng data.

Partikular na mahalaga ang diskarteng ito sa mga kapaligirang nalilimitahan ng bandwidth tulad ng mga IoT network at edge computing system.

Halimbawa, ang mga paraan ng compression na nakabatay sa entropy ay nagbibigay-daan sa mga IoT device na magpadala ng data ng sensor nang mas mahusay, pagbabawas ng pagkonsumo ng kuryente at paggamit ng bandwidth. Sa pamamagitan ng paggamit ng entropy bilang isang gabay na sukatan, nakakamit ng mga system na ito ang mataas na pagganap nang hindi nakompromiso ang katumpakan o pagiging maaasahan.

Mga Etikal na Pagsasaalang-alang: Pagkakasama, Bias, at Transparency

Ang mga dataset na may mataas na entropy ay kadalasang may kasamang magkakaibang at hindi gaanong karaniwang mga halimbawa, tulad ng bilang data na kumakatawan sa mga grupong kulang sa representasyon. Ang mga punto ng data na ito ay mahalaga para sa pagbuo ng mga patas na sistema ng AI, ngunit maaari silang hindi sinasadyang maibukod sa panahon ng mga proseso ng pag-optimize ng entropy, na humahantong sa mga bias na resulta.

Dapat tiyakin ng mga developer na ang mga diskarteng nakabatay sa entropy ay isinasaalang-alang ang lahat ng nauugnay na punto ng data upang maiwasan ang pagbubukod ng mga marginalized na grupo.

Sa AI, habang ang entropy ay nagbibilang ng kawalan ng katiyakan, responsibilidad nating tiyakin na ang paraan ng paghawak namin dito ay sumasalamin sa isang pangako sa pagiging patas at inclusivity. Ang pagbuo ng mga transparent na system na nagbibigay-priyoridad sa inclusivity ay hindi lamang nagpapabuti sa pagiging patas ngunit pinapahusay din ang katatagan ng mga modelo ng AI sa pamamagitan ng paglalantad sa mga ito sa isang mas malawak na hanay ng mga sitwasyon.

Transparency sa Entropy-Driven Decision-Making

Habang lalong umaasa ang mga AI system sa entropy upang gabayan ang paggawa ng desisyon, nagiging kritikal ang pagpapanatili ng transparency. Ito ay partikular na totoo sa mga sensitibong aplikasyon tulad ng pangangalaga sa kalusugan at legal na paggawa ng desisyon, kung saan mataas ang stake.

Ang pagpapaliwanag kung paano naiimpluwensyahan ng mga sukatan ng entropy ang mga hula o desisyon ng modelo ay mahalaga para sa pagbuo ng tiwala at pagtiyak ng pananagutan.

Halimbawa, sa medikal na AI, ang entropy ay kadalasang ginagamit upang sukatin ang kawalan ng katiyakan sa mga diagnostic na hula. Sa pamamagitan ng pakikipag-usap sa kawalan ng katiyakan na ito sa mga propesyonal sa pangangalagang pangkalusugan, ang mga system na ito ay nagbibigay-daan sa mas matalinong paggawa ng desisyon, na tumutulay sa agwat sa pagitan ng mga algorithmic na output at kadalubhasaan ng tao.

Pagpapalawak ng Tungkulin ng Entropy sa AI

Ang Quantum AI ay kumakatawan sa isang convergence ng artificial intelligence at quantum computing, at ang entropy ay nasa gitna ng intersection na ito. Sinisiyasat ng mga mananaliksik kung paano ma-optimize ng mga sukatan ng quantum entropy, gaya ng von Neumann entropy, ang mga quantum neural network at iba pang hybrid system.

Nangangako ang mga pagsulong na ito para sa paglutas ng mga kumplikadong problema sa mga larangan tulad ng logistik, pagtuklas ng droga, at secure na komunikasyon.

Halimbawa, ang mga quantum AI system ay maaaring gumamit ng entropy upang magmodelo ng masalimuot na pakikipag-ugnayan ng molekular sa hindi pa nagagawa katumpakan, pagpapabilis ng mga tagumpay sa mga parmasyutiko. Sa pamamagitan ng pagsasama-sama ng probabilistikong lakas ng mga quantum system na may kakayahang umangkop ng AI, patuloy na pinapalawak ng entropy ang impluwensya nito sa mga makabagong teknolohiya.

Pagsasama-sama sa Mga Daloy ng Trabaho ng AI

Ang entropy ay lalong isinasama sa bawat yugto ng AI workflows, mula sa data preprocessing hanggang sa real-time na paggawa ng desisyon. Nagsisilbi itong sukatan na pinag-iisa para sa pagbibilang ng kawalan ng katiyakan, na nagbibigay-daan sa mga system na dynamic na umangkop sa nagbabagong mga kondisyon.

Ang pagsasama-samang ito ay tumitiyak na ang AI ay nananatiling flexible, maaasahan, at may kakayahang harapin ang mga hamon ng mga kumplikadong kapaligiran.

Ang mga industriya mula sa mga autonomous na sasakyan hanggang sa financial modeling ay nakikinabang mula sa entropy-driven approaches, na kung saan pahusayin ang katumpakan ng hula, bilis ng paggawa ng desisyon, at kakayahang umangkop. Sa pamamagitan ng pag-embed ng entropy sa core ng AI development, ang mga mananaliksik ay bumubuo ng mga system na hindi lamang teknikal na matatag ngunit naaayon din sa mga layuning etikal at panlipunan.

What Lies Ahead

Ang entropy ay umunlad mula sa isang termodinamikong konsepto tungo sa isang pundasyon ng artificial intelligence. Sa pamamagitan ng pagbibilang ng kawalan ng katiyakan, binibigyang-daan nito ang mga AI system na balansehin ang randomness at istraktura, na nagpapatibay ng kakayahang umangkop, pagkamalikhain, at katumpakan. Gabay man sa mga algorithm sa pag-aaral ng machine, pamamahala ng synthetic data, o pagmamaneho ng mga inobasyon ng quantum AI, malinaw nating makikita kung paano muling hinuhubog ng entropy kung paano natututo at umaangkop ang artificial intelligence.

Habang ang AI ay patuloy na lumalaki sa pagiging kumplikado at epekto, pag-unawa at Ang paglalapat ng entropy ay magiging mahalaga para sa pagbuo ng mga system na hindi lamang mas matalino ngunit mas patas din, mas transparent, at mas mahusay na kagamitan upang mag-navigate sa mga kawalan ng katiyakan ng totoong mundo.