Nakuha ng AWS ang isang makabuluhang hakbang sa imprastraktura ng AI sa pamamagitan ng paglalahad ng pangalawang henerasyon nitong Trainium2 chips at pagpapakilala ng Trn2 UltraServers, na idinisenyo upang itulak ang mga hangganan ng pagganap ng large language model (LLM).

Inanunsyo sa muling:Mag-imbento ng kumperensya, ipinoposisyon ng mga pag-unlad na ito ang AWS bilang isang mabigat na manlalaro sa mabilis na umuusbong na landscape ng AI. Ipinasilip din ng AWS ang Trainium3, isang susunod na henerasyong chip na nangangako ng apat na beses na pagtaas ng performance, na nakatakdang ilabas sa huling bahagi ng 2025.

Inilarawan ni David Brown, Bise Presidente ng Compute at Networking sa AWS, ang kahalagahan ng mga inobasyong ito:

“Ang Trainium2 ang pinakamataas na gumaganap na AWS chip na nilikha hanggang sa kasalukuyan. At sa mga modelong lumalapit sa trilyong parameter, alam naming kakailanganin ng mga customer ang isang bagong diskarte para sanayin at patakbuhin ang mga malalaking modelong iyon. Ang bagong Trn2 UltraServers ay nag-aalok ng pinakamabilis na pagsasanay at inference na pagganap sa AWS para sa pinakamalaking mga modelo sa mundo.”

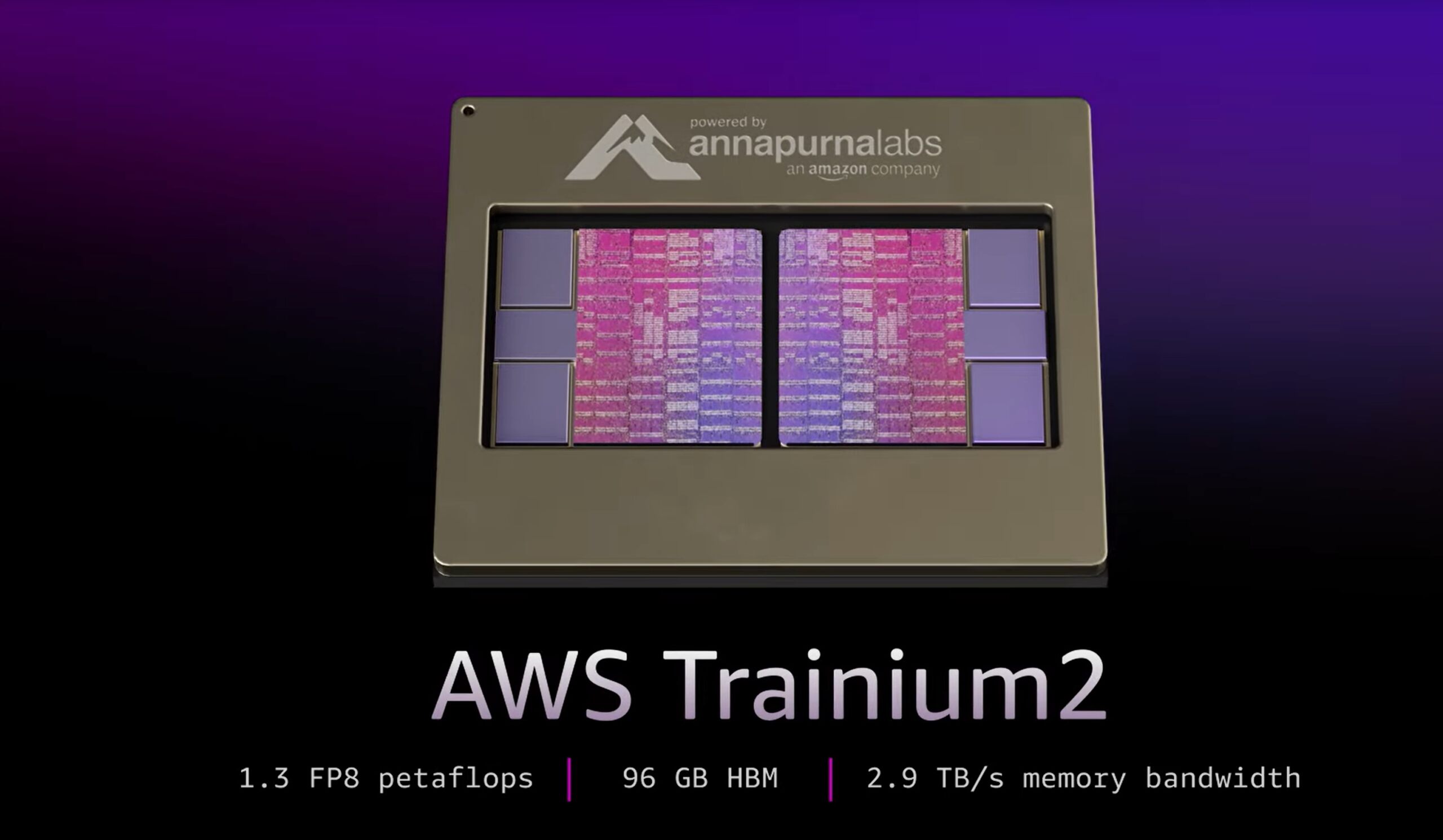

Trainium2: Pag-unlock ng Walang Katulad na Compute Power

Ang mga trainium2 chips ay inengineered upang matugunan ang tumataas na computational demand ng mga modernong AI model, na nag-aalok ng hanggang 20.8 petaflops ng siksik na FP8 compute bawat instance.

Bawat EC2 Trn2 instance. isinasama ang 16 na Trainium2 chip na konektado sa pamamagitan ng pagmamay-ari ng NeuronLink interconnect ng AWS, na nagsisiguro ng mababang latency, mataas na bandwidth na komunikasyon Ang arkitektura ay nagbibigay-daan para sa tuluy-tuloy na scalability, kritikal para sa pagsasanay at pag-deploy ng mga malalawak na LLM.

Ipinakita ng AWS ang mga kakayahan ng Trainium2 gamit ang Meta’s Llama 405B model, na nakamit ang”tatlong beses na mas mataas na throughput ng token-generation kumpara sa iba pang available na mga alok ng mga pangunahing cloud provider ,”ayon sa kumpanya.

Ang pagpapahusay na ito ay makabuluhang nagpapabilis sa mga gawain tulad ng pagbuo ng teksto, pagbubuod, at real-time na hinuha, na tumutugon sa mga pangangailangan ng mga negosyong umaasa sa generative AI.

[embedded content]

UltraServers: Scaling Beyond Limits

Para sa mga negosyong tumutugon sa trilyon-parameter na mga modelo, ipinakilala ng AWS ang Trn2 UltraServers, na pinagsama ang 64 na Trainium2 chips para makapaghatid ng hanggang 83.2 petaflops ng kalat-kalat na pagganap ng FP8.

Ang mga server ay nagbibigay-daan sa mas mabilis na mga oras ng pagsasanay at real-time na inference para sa mga ultra-large AI models, na kumakatawan sa isang kritikal na pag-unlad para sa mga negosyong naglalayong mag-deploy ng napakakumplikadong mga system.

Gadi Hutt, Senior Director sa Annapurna Labs, ipinaliwanag ang mga kakayahan ng UltraServers:

“Susunod, sinisira namin ang [16-chip] na hangganan at nagbibigay 64 chips sa UltraServer, at iyon ay para sa napakalaking modelo. Kaya kung mayroon kang 7 bilyong parameter na modelo, dati ay malaki, ngunit hindi na—o isang napakalaking modelo, tawagin natin itong 200 bilyon o 400 bilyon. Gusto mong maglingkod sa pinakamabilis na latency na posible. Kaya, ginagamit mo ang UltraServer.”

Collaboration with Anthropic: Building the Largest AI Cluster

Nakipagsosyo ang AWS sa Anthropic para bumuo ng Project Ranier, isang compute cluster na magtatampok ng daan-daang libong Trainium2 chips.

Inilalarawan ito ng AWS bilang Limang beses na mas malakas kaysa sa kasalukuyang mga system ng Anthropic, at ang pinakamalaking AI compute cluster sa mundo Iniulat hanggang sa kasalukuyan. Binibigyang-diin ng pakikipagtulungang ito ang pangako ng AWS na bigyang kapangyarihan ang mga kasosyo nito gamit ang makabagong teknolohiya.

Ang Anthropic, na kilala sa Claude 3.5 Sonnet LLM nito, ay umaasa sa imprastraktura ng AWS upang mapanatili ang isang mapagkumpitensyang bentahe laban sa mga karibal tulad ng OpenAI at Dinoble kamakailan ng AWS ang pamumuhunan nito sa Anthropic sa $8 bilyon, na nagpapatibay sa estratehikong pagtuon nito sa generative AI.

Trainium3: Paghubog sa Kinabukasan ng AI Compute

Inihayag din ng AWS ang Trainium3, ang paparating nitong chip na binuo sa isang prosesong may tatlong nanometer, na nangangakong maghahatid ng apat na beses ng pagganap ng UltraServers. Inaasahang ilulunsad sa huling bahagi ng 2025, ang Trainium3 ay magbibigay-daan sa mas mabilis na pagsasanay at paghihinuha para sa mga susunod na henerasyong modelo ng AI, na higit na magpapatibay sa pamumuno ng AWS sa AI compute.

Ibinalangkas ni David Brown ang pananaw ng AWS para sa bagong chip: “Sa aming mga third-generation na Trainium3 chips, papayagan namin ang mga customer na bumuo ng mas malalaking modelo nang mas mabilis at maghatid ng mahusay na real-time na performance kapag ini-deploy ang mga ito.”

Ang diskarte ng AWS kasama ang Trainium3 ay naglalayong hamunin ang pangingibabaw ng Nvidia sa merkado ng hardware ng AI Habang ipinagmamalaki ng mga paparating na Blackwell GPU ng Nvidia ang hanggang 720 petaflops ng pagganap ng FP8, nag-aalok ang pinagsamang mga solusyon sa Trainium ng AWS ng isang cost-effective at nasusukat na alternatibo na iniakma para sa enterprise-scale AI. workloads.

Ecosystem Support: Tools for Seamless Integration

Upang umakma sa mga inobasyon nito sa hardware, ibinibigay ng AWS ang Neuron SDK, isang development toolkit na na-optimize para sa mga frameworks tulad ng PyTorch at JAX.

Ang SDK ay may kasamang mga tool para sa distributed na pagsasanay at inference, na nagbibigay-daan sa mga developer na gamitin ang mga Trainium chips nang walang malawak na reconfiguration.

Nag-aalok din ang AWS ng mga paunang na-configure na Deep Learning AMI, na tinitiyak na mabilis na mai-deploy ng mga developer ang kanilang AI mga aplikasyon.