Ang Tech Expert at IT columnist na Mark Pesce ay natukoy ang isang malaking depekto na nakakaapekto sa malawak na hanay ng malalaking language models (LLMs), kabilang ang mga ginagamit sa sikat na AI chatbots tulad ng ChatGPT, Microsoft Copilot, at Google Gemini. Ang kapintasan, na na-trigger ng isang tila simpleng prompt, ay nagiging sanhi ng mga modelo upang makagawa ng hindi magkakaugnay at walang katapusang output, na nagpapataas ng mga alalahanin tungkol sa katatagan at pagiging maaasahan ng mga AI system na ito.

Walang Katuturan at Patuloy na Output

Habang nagsusulat si Pesce sa kanyang artikulo para sa The Register, natuklasan ang isyu noong sinubukan niyang gumawa ng prompt para sa isang AI-based classifier. Nilalayon ng classifier na tulungan ang isang abogado ng intelektwal na ari-arian sa pamamagitan ng pag-automate ng mga gawain na nangangailangan ng mga pansariling paghatol. Kapag sinubukan sa Microsoft Copilot Pro, na gumagamit ng OpenAI’s GPT-4 na modelo, ang prompt ay naging sanhi ng chatbot upang makabuo ng walang kapararakan at tuluy-tuloy na output. Ang katulad na pag-uugali ay naobserbahan sa iba pang mga modelo ng AI, kabilang ang Mixtral at ilang iba pa, maliban sa Claude 3 Sonnet ng Anthropic. Sumulat si Pesce:

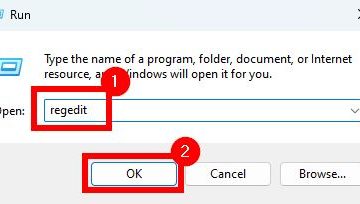

“Itinakda kong magtrabaho sa pagsusulat ng prompt para sa classifier na iyon, simula sa isang bagay na napakasimple – hindi masyadong naiiba sa prompt na ipapakain ko sa anumang chatbot. Upang subukan ito bago ako magsimulang gumamit ng mga mamahaling tawag sa API, inilagay ko ito sa Microsoft Copilot Pro. Sa ilalim ng pagba-brand ng Microsoft, ang Copilot Pro ay nasa tuktok ng pinakamahusay na modelo ng OpenAI, ang GPT-4. Nag-type ng prompt, at pindutin ang return.

Nagsimula nang maayos ang chatbot – para sa mga unang salita sa tugon nito. Pagkatapos ay naging parang kabaliwan ito.”

Tugon sa Industriya at Mga Hamon

Iniulat ni Pesce ang isyu sa iba’t ibang tagapagbigay ng serbisyo ng AI, kabilang ang xAI ng Microsoft at Elon Musk, na nasa likod ng mga produkto ng Grok AI na kinumpirma ng xAI ang kapintasan sa maraming modelo, na nagpapahiwatig ng isang pangunahing problema sa halip na isang nakahiwalay na bug, gayunpaman, ang tugon mula sa iba pang mga kumpanya ay hindi gaanong nakapagpapatibay sa isyu bilang isang bug na hindi nauugnay sa seguridad, habang ang iba pang mga kilalang kumpanya ng AI ay nabigong tumugon. sapat o sa lahat. Ang ilang kumpanya ay walang direktang impormasyon sa pakikipag-ugnayan para sa pag-uulat ng mga naturang kritikal na isyu, na nagpapakita ng malaking agwat sa kanilang suporta sa customer at mga proseso ng seguridad.

Mga Implikasyon para sa AI Development

Ang pagtuklas ay binibigyang-diin ang mga potensyal na panganib na nauugnay sa mabilis na pag-deploy ng mga teknolohiya ng AI nang walang matatag na suporta at mga mekanismo ng feedback. Ang kakulangan ng malinaw na channel para sa pag-uulat at pagtugon sa mga bug sa mga system na ito ay nagdudulot ng banta sa kanilang pagiging maaasahan at seguridad. Binibigyang-diin ng mga eksperto sa industriya ang pangangailangan para sa mga kumpanya ng AI na magtatag ng mga mahusay na proseso para sa paghawak ng feedback ng customer at pagresolba ng mga isyu kaagad. Hanggang sa naisagawa ang mga hakbang na ito, ang kaligtasan at pagiging maaasahan ng mga application na hinimok ng AI ay mananatiling pinag-uusapan.

Ang karanasan ni Pesce ay tumuturo sa isang mas malawak na isyu sa loob ng industriya ng AI: ang pangangailangan para sa mas mahigpit na pagsubok at mas mahusay na komunikasyon sa pagitan ng mga developer at mga gumagamit. Habang patuloy na isinasama ang AI sa iba’t ibang aspeto ng pang-araw-araw na buhay at negosyo, ang pagtiyak na parehong epektibo at secure ang mga system na ito ay pinakamahalaga.