Naglunsad ang Hugging Face ng isang inisyatiba upang magbigay ng $10 milyon na halaga ng GPU compute sa publiko, na naglalayong maibsan ang pinansiyal na stress sa mas maliliit na AI development team. Ang program, na pinangalanang ZeroGPU, ay ipinakilala ni CEO Clem Delangue sa X.

Pagtugon sa Mga Disparidad ng Resource

Binigyang-diin ng Delangue ang agwat ng mapagkukunan sa pagitan ng malalaking kumpanya ng tech at ng open-source na komunidad, na kadalasang kulang sa imprastraktura na kailangan para sanayin at i-deploy ang mga modelo ng AI. Ang pagkakaibang ito ay nag-ambag sa pangingibabaw ng mga application tulad ng ChatGPT. Nilalayon ng ZeroGPU na tulay ang agwat na ito sa pamamagitan ng pag-aalok ng nakabahaging imprastraktura para sa mga independiyente at akademikong AI developer para magpatakbo ng mga AI demo sa Hugging Face Spaces, sa gayon ay binabawasan ang kanilang pinansiyal na pasanin.

GPU-Poor no more: super excited to opisyal na inilabas ang ZeroGPU sa beta ngayon. Binabati ka namin @victormustar at koponan para sa pagpapalabas!

Sa nakalipas na ilang buwan, umuunlad ang open-source AI community. Hindi lang Meta kundi pati na rin ang Apple, NVIDIA, Bytedance, Snowflake, Databricks, Microsoft,… pic.twitter.com/6UzWvYhmpw

— clem 🤗 (@ClementDelangue) Mayo 16, 2024

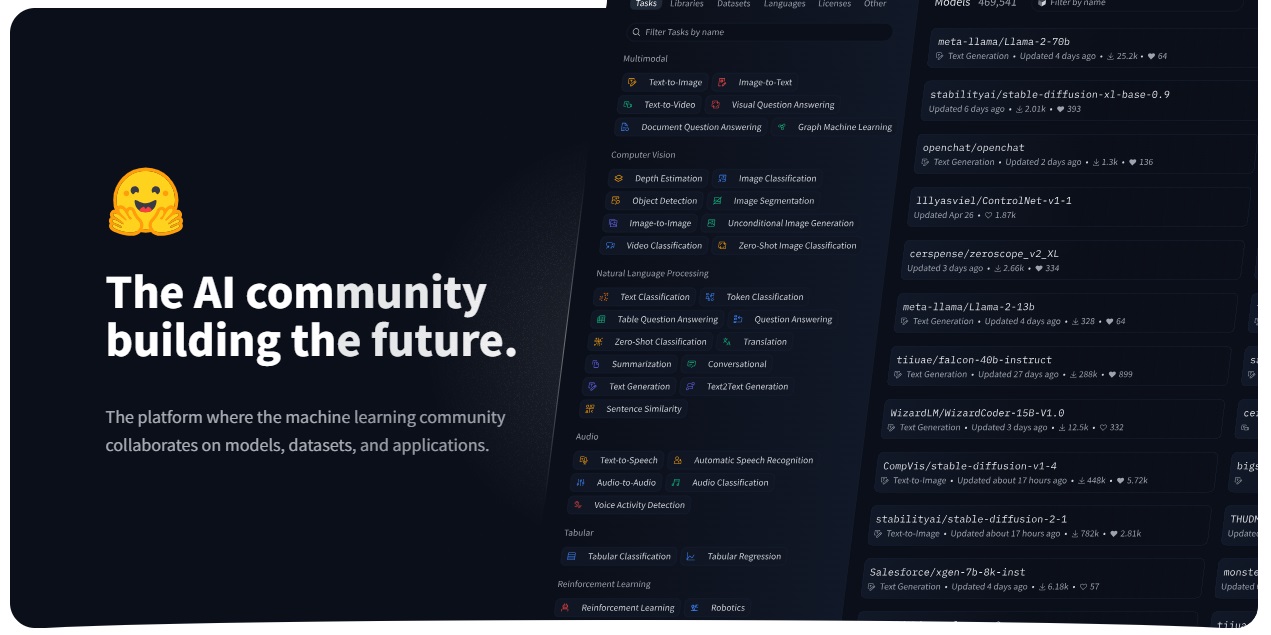

Itinatag noong 2016, ang Hugging Face ay naging nangungunang provider ng mga open-source AI model na na-optimize para sa iba’t ibang hardware platform, salamat sa pakikipagsosyo sa mga higante sa industriya gaya ng Nvidia, Intel, at AMD. Itinuturing ni Delangue ang open-source bilang kinabukasan ng innovation at adoption ng AI, at ang ZeroGPU initiative ay isang hakbang tungo sa demokrasya ng access sa mahahalagang resource.

Nakabahaging GPU Infrastructure

Isinasaad ng dokumentasyon ng suporta na ang mga function ng GPU ay nililimitahan sa 120 segundo, na hindi sapat para sa mga layunin ng pagsasanay. Kinumpirma ng isang tagapagsalita ng Hugging Face na ang focus ay pangunahin sa paghihinuha, bagama’t may mga planong galugarin ang iba pang mga application sa hinaharap.

Technical Implementation

Ang Ang mga teknikal na detalye ng kung paano pinamamahalaan ng Hugging Face ang pagbabahagi ng mga mapagkukunan ng GPU nang mahusay ay nananatiling medyo hindi malinaw. Binanggit ni Delangue na ang system ay maaaring”mahusay na humawak at maglabas ng mga GPU kung kinakailangan,”ngunit ang mga eksaktong mekanismo ay hindi detalyado. Kasama sa mga potensyal na pamamaraan ang paghiwa ng oras upang magpatakbo ng maraming workload nang sabay-sabay, Ang multi-instance GPU (MIG) na teknolohiya ng Nvidia, at GPU-accelerated container na isinaayos ng Kubernetes. Ang mga diskarteng ito ay ginamit ng iba pang cloud provider para gawing mas accessible ang GPU compute.

Ang mga A100 GPU na ginagamit ay may 40GB memory kapasidad, na maaaring suportahan ang malaki ngunit limitadong mga workload ng modelo ay magiging available sa pamamagitan ng Hugging Face’s Spaces, isang platform ng pagho-host para sa pag-publish ng mga app, na mayroong higit sa 300,000 AI demo na ginawa sa ngayon sa CPU o bayad na GPU.

Funding and Vision

Ang pangako ng Hugging Face sa inisyatiba na ito ay naging posible sa pamamagitan ng financial stability nito, dahil ang kumpanya ay “kumikita, o malapit sa kumikita” at kamakailan ay nakalikom ng $235 milyon sa pagpopondo, pinahahalagahan ito ng $4.5 bilyon. Nagpahayag si Delangue ng mga alalahanin tungkol sa kakayahan ng mga startup ng AI na makipagkumpitensya sa mga tech giant, na nagpapanatili ng makabuluhang pag-unlad sa pagmamay-ari ng AI at may malaking mapagkukunan ng computational. Nilalayon ng Hugging Face na gawing naa-access ng lahat ang mga advanced na teknolohiya ng AI, hindi lang ang mga tech giant.

Epekto sa Komunidad

Nagdudulot ng malaking hamon ang access sa pag-compute sa pagbuo ng malalaking mga modelo ng wika, kadalasang pinapaboran ang mga kumpanya tulad ng OpenAI at Anthropic. Si Andrew Reed, isang machine learning engineer sa Hugging Face, ay gumawa ng app na nagpapakita ng pag-usad ng proprietary at open-source na mga LLM sa paglipas ng panahon, na nagpapakita ng agwat sa pagitan ng dalawang unti-unting magkakalapit. Mahigit 35,000 variation ng Meta’s open-source AI model Llama ang ibinahagi sa Hugging Face mula noong unang bersyon ng Meta noong isang taon.