Ang kamakailang pag-unveil ng MLPerf Inference v3.1 ay naglabas ng mga bagong benchmark para sa Large Language Models (LLMs) at mga rekomendasyon, na nagpapahiwatig ng makabuluhang hakbang sa pagsubok ng AI. Ang mga benchmark ng MLPerf—na binuo ng MLCommons, isang consortium ng mga akademikong pinuno ng AI, mga research lab, at sa buong industriya— ay idinisenyo upang magbigay ng walang pinapanigan na mga pagsusuri ng pagsasanay at hinuha na pagganap para sa hardware, software, at mga serbisyo.

Nasaksihan ng bagong bersyon ang isang hindi pa naganap na antas ng pakikilahok, na may higit sa 13,500 resulta ng pagganap, na nagmamarka ng hanggang 40% na pagpapahusay sa pagganap. Ang pagkakaiba-iba sa pakikilahok ay makikita sa 26 na natatanging nagsumite, kabilang ang mga pangunahing kumpanya ng teknolohiya tulad ng Google, Intel, at NVIDIA, pati na rin ang mga unang beses na kalahok gaya ng Connect Tech, Nutanix, Oracle, at TTA.

David Binigyang-diin ni Kanter, ang Executive Director ng MLCommons, ang kahalagahan ng kontribusyong ito, na nagsasaad,”Ang pagsusumite sa MLPerf ay hindi mahalaga… Nangangailangan ito ng tunay na gawaing inhinyero at isang testamento sa pangako ng aming mga nagsumite sa AI, sa kanilang mga customer, at sa ML.”

@MLCommons, kakalabas lang namin! Bagong @MLPerf Mga resulta ng Inference at Storage. Itinatala ang paglahok sa MLPerf Inference v3.1 at unang beses na mga resulta ng MLPerf Storage v0.5 ang lumalaking kahalagahan ng GenAI at storage. Tingnan ang lahat ng resulta at matuto nang higit pa https://t.co/7eycrrmOdw

— MLCommons (@ MLCommons) Setyembre 11, 2023

Mga Resulta ng Benchmarks

Ang pangunahing layunin ng MLPerf Inference ay upang sukatin ang bilis kung saan ang mga AI system ay maaaring magpatakbo ng mga modelo sa iba’t ibang deployment scenario. Ang mga ito ay mula sa mga advanced na generative AI chatbots hanggang sa mga feature sa kaligtasan ng sasakyan tulad ng mga awtomatikong lane-keeping at speech-to-text na mga interface. Ang spotlight sa bersyong ito ay sa pagpapakilala ng dalawang benchmark:

Isang LLM na gumagamit ng GPT-J reference model upang i-summarize ang mga artikulo ng balita sa CNN, na sumasalamin sa mabilis na paggamit ng generative AI na may 15 kalahok. Isang na-update na benchmark ng tagapagrekomenda, na mas naaayon sa mga pamantayan ng industriya, gamit ang DLRM-DCNv2 reference model at mas malalaking dataset, na nakakatanggap ng siyam na pagsusumite.

Upang tingnan ang mga resulta para sa MLPerf Inference v3.1 at MLPerf Storage v0.5, at upang makahanap ng karagdagang impormasyon tungkol sa mga benchmark pakibisita ang:

https://mlcommons.org/en/storage-results-05/

https://mlcommons.org/en/inference-edge-31/

https://mlcommons.org/en/inference-datacent >

Ang Dominance ng NVIDIA at ang Close Pursuit ng Intel

Ang mga advanced na chip ng NVIDIA ay lumitaw bilang mga nangungunang kalaban sa mga pagsubok sa isang malaking modelo ng wika, na may mahigpit na pagsunod sa hardware ng Intel. Ang MLCommons, na kilala sa neutral benchmarking ng AI chipset performance, ay inihayag ang mga resulta ng bago nitong MLPerf Inference 3.1 benchmarks.

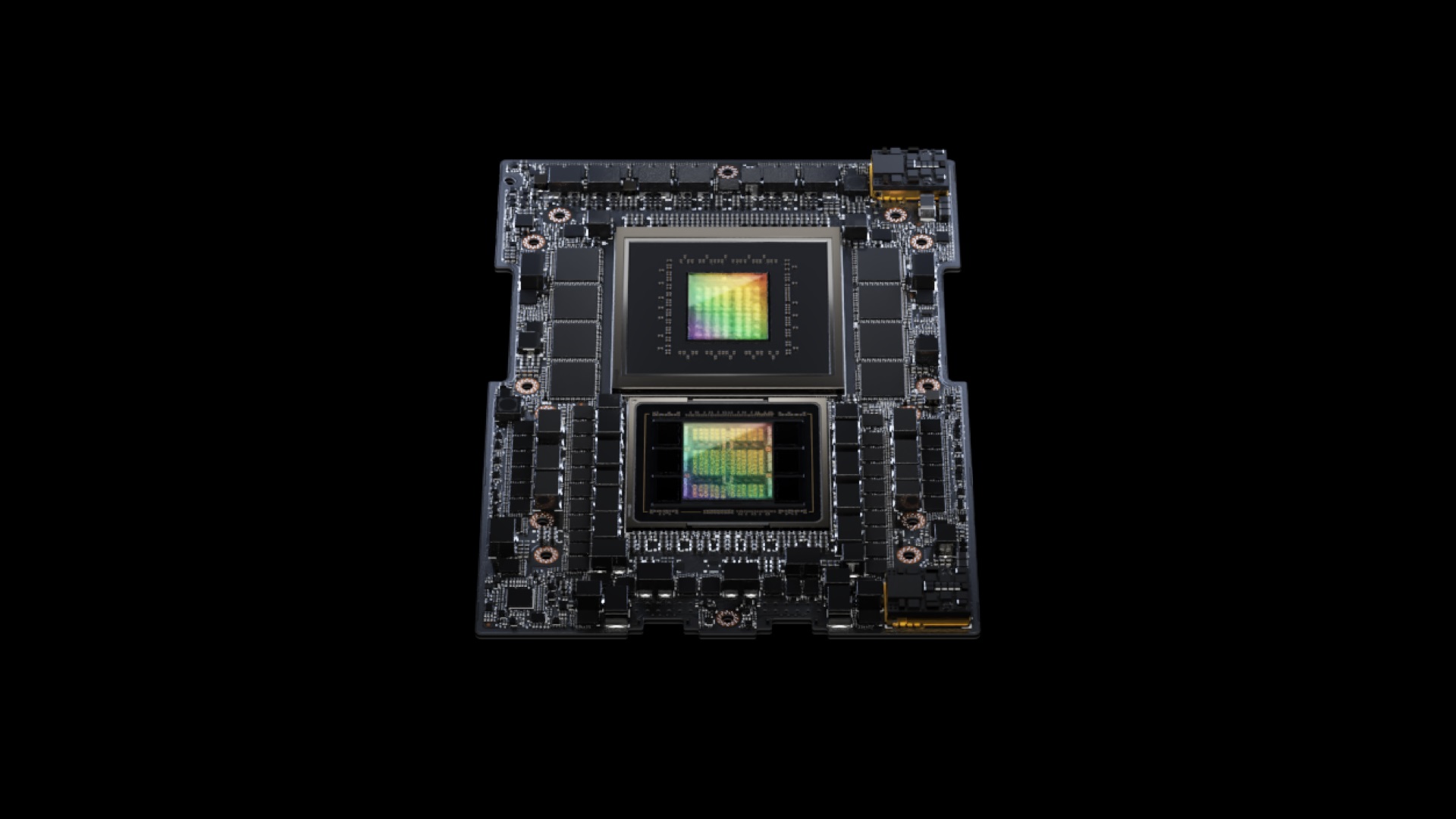

Ipinakita ng NVIDIA ang GH200 Grace Hopper Superchip, na pinagsasama ang isang Hopper graphic processing unit na may isang Grace central processing unit, na nag-aalok ng pinahusay na memory, bandwidth, at mga kakayahan sa paglilipat ng gawain sa pagitan ng GPU at isang Arm-based na CPU. Nahigitan ng chipset na ito ang HGX 100 system ng NVIDIA nang humigit-kumulang 17%. Gayunpaman, ang Intel’s Habana Gaudi2 ay hindi nalalayo, na nagpapakita ng performance lag na 10% lang kumpara sa mga system ng NVIDIA.

Sa linggong ito, nag-anunsyo ang Nvidia ng bagong update ng software na epektibong nagdodoble sa performance ng H100 AI GPU nito. Ang bagong open-source na TensorRT-LLM software ng kumpanya, na naka-iskedyul para sa paglabas sa mga paparating na linggo, ay nagpakita ng makabuluhang pagpapalakas ng performance.

Sa mga pagsubok gamit ang modelong GPT-J 6B, ang na-update na system ay nagpakita ng walong beses na pagpapabuti ng pagganap kaysa sa A100, isang makabuluhang paglukso mula sa nakaraang apat na beses na kalamangan. Higit pa rito, kapag nasuri sa Llama2 LLM ng Meta, nalampasan ng TensorRT-LLM-enhanced H100s ang mga A100 sa pamamagitan ng isang factor na 4.6, isang markang pagpapabuti mula sa 2.6 na beses bago ang update.