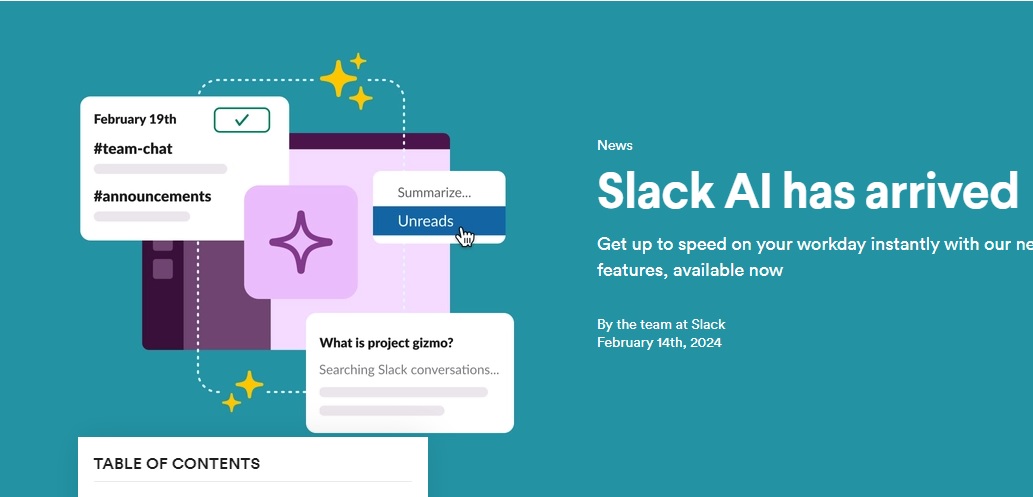

Slack ของ Salesforce เผชิญกับการวิพากษ์วิจารณ์เกี่ยวกับนโยบายความเป็นส่วนตัว ซึ่งอนุญาตให้ แพลตฟอร์มเพื่อวิเคราะห์ข้อมูลผู้ใช้สำหรับการฝึกอบรม AI เว้นแต่ผู้ใช้จะเลือกไม่ใช้ บริษัทชี้แจงว่าข้อมูลนี้ยังคงอยู่ในแพลตฟอร์มและไม่ได้ใช้ในการฝึกโมเดลของบุคคลที่สาม

Slack อธิบายว่าโมเดลการเรียนรู้ของเครื่องทำงานในระดับแพลตฟอร์มเพื่อปรับปรุงฟังก์ชันการทำงาน เช่น คำแนะนำช่องและอีโมจิและการค้นหา ผลลัพธ์. โมเดลเหล่านี้ไม่สามารถเข้าถึงเนื้อหาข้อความต้นฉบับจากข้อความส่วนตัว ช่องทางส่วนตัว หรือช่องทางสาธารณะเพื่อสร้างข้อเสนอแนะ บริษัทเน้นย้ำว่าโมเดลไม่ได้ออกแบบมาเพื่อจดจำหรือทำซ้ำข้อมูลลูกค้า

Generative AI และข้อมูลลูกค้า

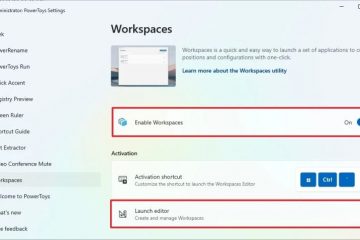

Slack ใช้ generative AI ใน Slack AI ผลิตภัณฑ์โดยใช้โมเดลภาษาขนาดใหญ่ (LLM) ของบุคคลที่สาม ตามที่บริษัทระบุ ไม่มีการใช้ข้อมูลลูกค้าในการฝึกอบรม LLM บุคคลที่สามเหล่านี้ แต่ Slack จะใช้ LLM ทั่วไปที่ไม่เก็บข้อมูลลูกค้าแทน โมเดลเหล่านี้โฮสต์อยู่บนโครงสร้างพื้นฐาน AWS ของ Slack เพื่อให้มั่นใจว่าข้อมูลลูกค้าจะไม่ออกจากขอบเขตความน่าเชื่อถือของ Slack และผู้ให้บริการ LLM จะไม่สามารถเข้าถึงข้อมูลนี้ได้

หลักการความเป็นส่วนตัวที่ได้รับการอัปเดตในปี 2023 ในตอนแรกมีภาษาที่ระบุว่าระบบของ Slack วิเคราะห์ข้อมูลลูกค้า เช่น ข้อความ เนื้อหา และไฟล์ เพื่อ พัฒนาโมเดล AI/ML การใช้ข้อมูลในวงกว้างนี้นำไปสู่การตอบโต้ของผู้ใช้อย่างมีนัยสำคัญ โดยหลายคนแสดงความกังวลเกี่ยวกับข้อมูลของพวกเขาที่ถูกนำมาใช้สำหรับการฝึกอบรม AI

ข้อกังวลของผู้ใช้และการตอบสนองของบริษัท

Slack ยืนยันว่าข้อมูลจะไม่รั่วไหลไปทั่วพื้นที่ทำงาน แม้ว่าจะรับทราบว่าโมเดลระดับโลกใช้ข้อมูลลูกค้าก็ตาม อย่างไรก็ตาม ข้อความภายในพื้นที่ทำงานแต่ละรายการจะได้รับการวิเคราะห์ บริษัทได้แก้ไขหลักการความเป็นส่วนตัวเพื่อระบุว่า: “ในการพัฒนาโมเดล AI/ML แบบไม่สร้างสรรค์สำหรับฟีเจอร์ต่างๆ เช่น อิโมจิและการแนะนำช่อง ระบบของเราจะวิเคราะห์ข้อมูลลูกค้า”

โฆษกของ Slack เน้นย้ำว่านโยบายของบริษัท และแนวทางปฏิบัติไม่มีการเปลี่ยนแปลง มีเพียงภาษาเท่านั้นที่ได้รับการอัปเดตเพื่อความชัดเจน ฟีเจอร์การวิเคราะห์ข้อมูลจะถูกเปิดใช้งานตามค่าเริ่มต้น ซึ่งอาจก่อให้เกิดข้อกังวลด้านกฎระเบียบ จะต้องส่งอีเมลถึงทีมประสบการณ์ลูกค้าของ Slack แม้ว่าบริษัทจะไม่ได้ระบุระยะเวลาก็ตาม กระบวนการนี้ใช้เวลา

การเลือกไม่ใช้หมายความว่าลูกค้าจะยังคงได้รับประโยชน์จากโมเดลที่ได้รับการฝึกอบรมทั่วโลกโดยไม่ต้องให้ข้อมูลกับโมเดลเหล่านี้ Slack อธิบายว่าข้อมูลนี้ถูกใช้เพื่อปรับปรุงคุณลักษณะต่างๆ เช่น การแยกวิเคราะห์คำค้นหา การเติมข้อความอัตโนมัติ และคำแนะนำอิโมจิ บริษัทเชื่อว่าการปรับปรุงส่วนบุคคลเหล่านี้เป็นไปได้โดยการศึกษาการโต้ตอบของผู้ใช้กับ Slack เท่านั้น

การตรวจสอบข้อเท็จจริงและการอัปเดตเอกสารประกอบ

นักข่าวที่ครอบคลุมประเด็นนี้ได้รายงาน ได้รับคำเตือนจาก Slack เกี่ยวกับ”ความไม่ถูกต้อง”ในบทความ ซึ่งอิงจากเอกสารของ Slack เอง บริษัทได้อัปเดตเอกสารนี้เพื่อชี้แจงแนวทางปฏิบัติของตน ณ วันที่ 17 พฤษภาคม Slack ระบุอย่างชัดเจนว่า: “เราไม่ได้พัฒนา LLM หรือโมเดลการสร้างอื่นๆ โดยใช้ข้อมูลลูกค้า” และระบุว่าระบบจะวิเคราะห์ข้อมูลลูกค้า รวมถึงไฟล์ เพื่อ “พัฒนาโมเดล AI/ML ที่ไม่สร้างสำหรับคุณสมบัติต่างๆ เช่น อิโมจิและคำแนะนำช่อง”

เอกสารที่อัปเดตของ Slack ยังตั้งข้อสังเกตด้วยว่าสำหรับการเติมข้อความอัตโนมัติ”คำแนะนำนั้นมาจากท้องถิ่นและมาจากวลีข้อความสาธารณะทั่วไปในพื้นที่ทำงานของผู้ใช้ อัลกอริทึมของเราที่เลือกจากคำแนะนำที่เป็นไปได้นั้นได้รับการฝึกอบรมทั่วโลกก่อนหน้านี้ การกรอกที่แนะนำและยอมรับ เราปกป้องความเป็นส่วนตัวของข้อมูลโดยใช้กฎเกณฑ์เพื่อให้คะแนนความคล้ายคลึงกันระหว่างข้อความที่พิมพ์และข้อเสนอแนะในรูปแบบต่างๆ รวมถึงการใช้เฉพาะคะแนนตัวเลขและจำนวนการโต้ตอบที่ผ่านมาในอัลกอริทึม”

บริบทและการเปรียบเทียบของอุตสาหกรรม

เหตุการณ์ดังกล่าวซึ่งทำให้ผู้ใช้จำนวนมากปิดสถานที่ทำงาน Slack ของตน เน้นย้ำถึงความท้าทายที่บริษัทซอฟต์แวร์ต้องเผชิญในการสื่อสารว่าพวกเขาใช้ข้อมูลผู้ใช้สำหรับแอปพลิเคชัน AI เชิงสร้างสรรค์อย่างไร ความซับซ้อนของการอธิบายเวิร์กโฟลว์การดึงข้อมูล (RAG) และวิธีการเรียนรู้ของเครื่องอื่น ๆ ในนโยบายความเป็นส่วนตัวก่อให้เกิดความเสี่ยงต่อชื่อเสียงสำหรับบริษัทต่างๆ

Slack กล่าวว่า: “หลักการชี้นำของเราในขณะที่เราสร้างผลิตภัณฑ์นี้ก็คือ ความเป็นส่วนตัวและความปลอดภัยของข้อมูลลูกค้าถือเป็นสิ่งศักดิ์สิทธิ์ ดังที่ให้รายละเอียดไว้ในนโยบายความเป็นส่วนตัว เอกสารความปลอดภัยของเรา และ SPARC และข้อกำหนดของ Slack”อย่างไรก็ตาม การตรวจสอบโดย The Stack เมื่อวันที่ 17 พฤษภาคม ระบุว่าไม่มีเอกสารใดที่กล่าวถึง AI เชิงสร้างสรรค์หรือการเรียนรู้ของเครื่อง

Slack ยังรวบรวมข้อมูลผู้ใช้เพื่อ “ระบุแนวโน้มและข้อมูลเชิงลึกขององค์กร” ตามนโยบายความเป็นส่วนตัว บริษัทยังไม่ได้ตอบคำถามเกี่ยวกับแนวโน้มขององค์กรที่ดึงมาจากข้อมูลลูกค้า

Dropbox ประสบปัญหาที่คล้ายกันในเดือนธันวาคม 2023 เมื่อเกิดความสับสนเกี่ยวกับปุ่มสลับเริ่มต้นใหม่ที่ตั้งเป็น”แชร์กับบุคคลที่สาม”party AI”ทำให้เกิดความโกลาหล CTO ของ AWS แจ้งข้อกังวลด้านความเป็นส่วนตัวของเขาต่อสาธารณะไปยัง Dropbox ซึ่งชี้แจงในภายหลังว่า “เฉพาะเนื้อหา [ของพวกเขา] ที่เกี่ยวข้องกับคำขอหรือคำสั่งที่ชัดเจนเท่านั้นที่ถูกส่งไปยังพันธมิตร AI บุคคลที่สามของเรา [OpenAI] เพื่อสร้างคำตอบ สรุป หรือถอดเสียง… ข้อมูลของคุณจะไม่ถูกใช้เพื่อฝึกโมเดลภายใน และจะถูกลบออกจากเซิร์ฟเวอร์ของ OpenAI ภายใน 30 วัน”