Qualcomm จับมือเป็นพันธมิตรกับ Ampere Computing ผู้ออกแบบโปรเซสเซอร์เซิร์ฟเวอร์ Arm เพื่อเสริมความสามารถด้านโครงสร้างพื้นฐาน AI ความร่วมมือนี้เปิดตัวระหว่างการอัปเดตกลยุทธ์และแผนงานประจำปีของ Ampere โดยเปิดตัวเซิร์ฟเวอร์ 2U ที่ติดตั้งตัวเร่งความเร็ว Qualcomm AI 100 Ultra แปดตัว และคอร์ CPU 192 Ampere สำหรับการอนุมานของแมชชีนเลิร์นนิง

Qualcomm Cloud AI 100 Ultra นำเสนอ โซลูชันการอนุมาน AI ที่มีประสิทธิภาพและคุ้มต้นทุน ซึ่งปรับแต่งมาสำหรับ Generative AI และแบบจำลองภาษาขนาดใหญ่ (LLM) โดยมี SRAM ในตัวสูงสุด 576 MB และคอร์ AI 64 คอร์ต่อการ์ด ตอบสนองความต้องการที่โดดเด่นในการปรับขนาดปริมาณงาน AI ทั้งแบบคลาสสิกและแบบเจนเนอเรทีฟ รวมถึงคอมพิวเตอร์วิทัศน์ การประมวลผลภาษาธรรมชาติ และ LLM ที่ใช้หม้อแปลงไฟฟ้า

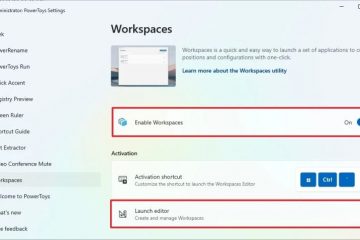

โซลูชัน ARM AI ความหนาแน่นสูง

Ampere กล่าวว่าการกำหนดค่านี้สามารถรองรับตัวเร่งความเร็ว AI ได้มากถึง 56 ตัวและคอร์ประมวลผล 1,344 คอร์ในแร็คมาตรฐาน 12.5kW ทำให้ไม่จำเป็นต้องใช้ราคาแพง ระบบระบายความร้อนด้วยของเหลว บริษัทยังได้ประกาศด้วยว่าโปรเซสเซอร์เซิร์ฟเวอร์ล่าสุดจะมี CPU คอร์ 256 คอร์ และช่องหน่วยความจำสูงสุด 12 ช่อง โดยจะเปลี่ยนไปใช้เทคโนโลยีการผลิต 3 นาโนเมตรของ TSMC ในปีหน้า

Ampere และ Oracle ได้แสดงให้เห็นว่าโมเดลภาษาขนาดใหญ่ (LLM) สามารถทำงานบน CPU ได้ แม้ว่าจะมีข้อจำกัดบางประการก็ตาม โดยทั่วไป CPU จะเหมาะกับรุ่นขนาดเล็กที่มีพารามิเตอร์เจ็ดถึงแปดพันล้านและขนาดแบทช์ที่เล็กกว่า ตัวเร่งความเร็ว AI 100 ของ Qualcomm ซึ่งมีแบนด์วิธหน่วยความจำที่สูงกว่า ได้รับการออกแบบมาเพื่อรองรับโมเดลที่ใหญ่กว่าหรือขนาดแบตช์ที่สูงกว่า ทำให้มีประสิทธิภาพมากขึ้นในการอนุมานงาน

AI 100 Ultra Accelerators ของ Qualcomm

ตัวเร่งความเร็ว AI 100 Ultra ของ Qualcomm แม้ว่าจะไม่ได้รับการยอมรับอย่างกว้างขวางในตลาดชิป AI สำหรับศูนย์ข้อมูลเท่ากับ GPU ของ Nvidia หรือ Gaudi ของ Intel แต่ก็มีวางจำหน่ายมาหลายปีแล้ว ซีรีส์ AI 100 Ultra ซึ่งเปิดตัวเมื่อฤดูใบไม้ร่วงปีที่แล้ว เป็นการ์ด PCIe แบบสล็อตเดี่ยวขนาดบางที่มุ่งเป้าไปที่การอนุมาน LLM ที่ 150W ความต้องการพลังงานนั้นค่อนข้างเจียมเนื้อเจียมตัวเมื่อเทียบกับ GPU 600W และ 700W จาก AMD และ Nvidia Qualcomm อ้างว่า AI 100 Ultra ตัวเดียวสามารถเรียกใช้โมเดลพารามิเตอร์ได้ 1 แสนล้านรายการ โดยอีกคู่รองรับโมเดลขนาด GPT-3 (พารามิเตอร์ 175 พันล้านพารามิเตอร์)

การ์ด AI 100 Ultra แบบ 64 คอร์มอบ 870 TOP ที่ความแม่นยำ INT8 และติดตั้งหน่วยความจำ LPDDR4x ขนาด 128GB ให้แบนด์วิธ 548GB/s แบนด์วิดท์หน่วยความจำเป็นสิ่งจำเป็นสำหรับการขยาย AI ที่อนุมานเป็นขนาดแบตช์ที่ใหญ่ขึ้น Qualcomm ได้ใช้การปรับแต่งซอฟต์แวร์ให้เหมาะสม เช่น การถอดรหัสแบบเก็งกำไรและรูปแบบไมโครสเกล (MX) เพื่อปรับปรุงปริมาณงานและประสิทธิภาพ การถอดรหัสแบบเก็งกำไรใช้โมเดลที่เล็กกว่าเพื่อสร้างการตอบสนองเริ่มต้น ซึ่งจากนั้นจะถูกตรวจสอบและแก้ไขโดยโมเดลที่ใหญ่กว่า รูปแบบการปรับขนาดย่อยซึ่งเป็นรูปแบบหนึ่งของการหาปริมาณจะช่วยลดพื้นที่หน่วยความจำของโมเดลโดยการบีบอัดน้ำหนักของโมเดลให้มีความแม่นยำน้อยลง