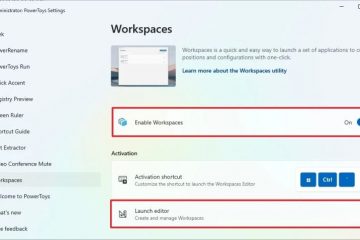

Hugging Face ได้เปิดตัวโครงการริเริ่มเพื่อมอบการประมวลผล GPU มูลค่า 10 ล้านดอลลาร์แก่สาธารณะ โดยมีเป้าหมายเพื่อบรรเทาความเครียดทางการเงินให้กับทีมพัฒนา AI ขนาดเล็ก โปรแกรมชื่อ ZeroGPU ได้รับการแนะนำโดย CEO Clem Delangue บน X.

การจัดการกับความไม่เท่าเทียมกันของทรัพยากร

Delangue เน้นย้ำถึงช่องว่างทรัพยากรระหว่างบริษัทเทคโนโลยีขนาดใหญ่และชุมชนโอเพ่นซอร์ส ซึ่งมักจะขาดโครงสร้างพื้นฐานที่จำเป็นในการฝึกอบรมและปรับใช้โมเดล AI ความแตกต่างนี้มีส่วนทำให้แอปพลิเคชันอย่าง ChatGPT ครอบงำ ZeroGPU มุ่งหวังที่จะเชื่อมช่องว่างนี้ด้วยการนำเสนอโครงสร้างพื้นฐานที่ใช้ร่วมกันสำหรับนักพัฒนา AI อิสระและเชิงวิชาการเพื่อสาธิต AI บน Hugging Face Spaces ซึ่งจะช่วยลดภาระทางการเงินของพวกเขา

GPU-Poor no more: ตื่นเต้นสุด ๆ ที่จะ เปิดตัว ZeroGPU อย่างเป็นทางการในรุ่นเบต้าแล้ววันนี้ ขอแสดงความยินดี @victormustar และทีมงานสำหรับการเปิดตัว!

ในช่วงไม่กี่เดือนที่ผ่านมา ชุมชน AI แบบโอเพ่นซอร์สเจริญรุ่งเรือง ไม่เพียงแต่ Meta เท่านั้น แต่ยังรวมถึง Apple, NVIDIA, Bytedance, Snowflake, Databricks, Microsoft,… pic.twitter.com/6UzWvYhmpw

— clem 🤗 (@ClementDelangue) 16 พฤษภาคม 2024

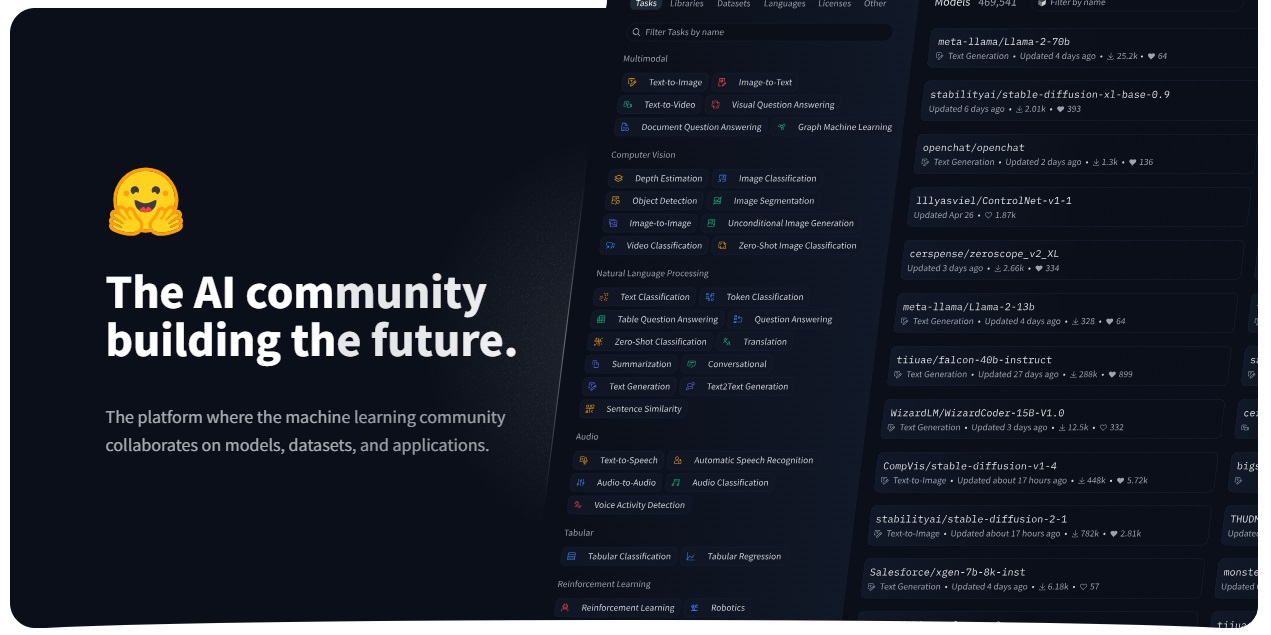

Hugging Face ก่อตั้งขึ้นในปี 2559 และกลายเป็นผู้ให้บริการชั้นนำของโมเดล AI แบบโอเพ่นซอร์สที่ได้รับการปรับให้เหมาะกับแพลตฟอร์มฮาร์ดแวร์ต่างๆ ต้องขอบคุณความร่วมมือกับยักษ์ใหญ่ในอุตสาหกรรม เช่น Nvidia, Intel และ AMD Delangue มองว่าโอเพ่นซอร์สเป็นอนาคตของนวัตกรรม AI และการนำไปใช้ และโครงการริเริ่ม ZeroGPU ก็เป็นอีกก้าวหนึ่งในการทำให้การเข้าถึงทรัพยากรที่จำเป็นเป็นประชาธิปไตย

โครงสร้างพื้นฐาน GPU ที่ใช้ร่วมกัน

ZeroGPU จะสามารถเข้าถึงได้ผ่านบริการโฮสติ้งแอปพลิเคชันของ Hugging Face และจะใช้ตัวเร่งความเร็ว A100 รุ่นเก่าของ Nvidia บนพื้นฐานที่ใช้ร่วมกัน แตกต่างจากผู้ให้บริการคลาวด์แบบดั้งเดิมที่มักต้องการข้อตกลงระยะยาวในการเช่า GPU ที่คุ้มค่า แนวทางของ Hugging Face ช่วยให้การใช้งานมีความยืดหยุ่นมากขึ้น ซึ่งเป็นประโยชน์สำหรับนักพัฒนารายย่อยที่ไม่สามารถคาดการณ์ความสำเร็จของโมเดลล่วงหน้าได้ โครงสร้างพื้นฐานที่ใช้ร่วมกันนี้ในตอนแรกถูกจำกัดไว้ที่การอนุมาน AI มากกว่าการฝึกอบรม เนื่องจากทรัพยากรการคำนวณจำนวนมากที่จำเป็นสำหรับการฝึกอบรมแม้แต่รุ่นขนาดเล็ก

เอกสารสนับสนุนระบุว่าฟังก์ชัน GPU ถูกจำกัดไว้ที่ 120 วินาที ซึ่งไม่เพียงพอสำหรับ วัตถุประสงค์การฝึกอบรม โฆษกของ Hugging Face ยืนยันว่าการมุ่งเน้นไปที่การอนุมานเป็นหลัก แม้ว่าจะมีแผนที่จะสำรวจการใช้งานอื่นๆ ในอนาคตก็ตาม

การใช้งานทางเทคนิค

ข้อมูลเฉพาะทางเทคนิคของวิธีที่ Hugging Face จัดการเพื่อแบ่งปันทรัพยากร GPU อย่างมีประสิทธิภาพยังคงค่อนข้างไม่ชัดเจน Delangue กล่าวว่าระบบสามารถ “จับและปล่อย GPU ได้อย่างมีประสิทธิภาพตามต้องการ” แต่กลไกที่แน่นอนยังไม่มีรายละเอียด วิธีการที่เป็นไปได้ ได้แก่ การแบ่งเวลาเพื่อเรียกใช้ปริมาณงานหลายรายการพร้อมกัน เทคโนโลยี GPU หลายอินสแตนซ์ (MIG) ของ Nvidia และ คอนเทนเนอร์ที่เร่ง GPU ซึ่งควบคุมโดย Kubernetes ผู้ให้บริการระบบคลาวด์รายอื่นใช้เทคนิคเหล่านี้เพื่อทำให้การประมวลผล GPU เข้าถึงได้ง่ายขึ้น

GPU A100 ที่ใช้มีหน่วยความจำ 40GB ความจุซึ่งสามารถรองรับเวิร์กโหลดโมเดลจำนวนมากแต่มีจำกัด ZeroGPU จะพร้อมใช้งานผ่าน Hugging Face’s Spaces ซึ่งเป็นแพลตฟอร์มโฮสต์สำหรับการเผยแพร่แอป ซึ่งมีการสาธิต AI มากกว่า 300,000 รายการที่สร้างขึ้นบน CPU หรือ GPU แบบชำระเงิน

การระดมทุนและวิสัยทัศน์

ความมุ่งมั่นของ Hugging Face ในโครงการริเริ่มนี้เกิดขึ้นได้จากความมั่นคงทางการเงินของบริษัท เนื่องจากบริษัท”มีกำไรหรือใกล้เคียงกับผลกำไร”และเพิ่งระดมเงินทุนได้ 235 ล้านดอลลาร์เมื่อเร็ว ๆ นี้ มีมูลค่า 4.5 พันล้านดอลลาร์ Delangue แสดงความกังวลเกี่ยวกับความสามารถของสตาร์ทอัพด้าน AI ในการแข่งขันกับบริษัทยักษ์ใหญ่ด้านเทคโนโลยี ซึ่งยังคงรักษาความก้าวหน้าที่สำคัญในกรรมสิทธิ์ของ AI และมีทรัพยากรด้านการคำนวณจำนวนมาก Hugging Face มุ่งหวังที่จะทำให้ทุกคนสามารถเข้าถึงเทคโนโลยี AI ขั้นสูง ไม่ใช่แค่ยักษ์ใหญ่ด้านเทคโนโลยี

ผลกระทบต่อชุมชน

การเข้าถึงการประมวลผลถือเป็นความท้าทายที่สำคัญในการสร้างเทคโนโลยีขนาดใหญ่ โมเดลภาษา ซึ่งมักนิยมบริษัทอย่าง OpenAI และ Anthropic Andrew Reed วิศวกรการเรียนรู้ของเครื่องที่ Hugging Face ได้สร้างแอปที่แสดงภาพความคืบหน้าของ LLM ที่เป็นกรรมสิทธิ์และโอเพ่นซอร์สเมื่อเวลาผ่านไป ซึ่งแสดงช่องว่างระหว่างทั้งสองที่ใกล้ชิดกันมากขึ้น มีการแชร์โมเดล AI โอเพ่นซอร์ส Llama ของ Meta มากกว่า 35,000 รูปแบบบน Hugging Face นับตั้งแต่เวอร์ชันแรกของ Meta เมื่อปีที่แล้ว