OpenAI กำลังต่อสู้กับความสับสนอลหม่านภายในเนื่องจากทีม Superalignment ซึ่งรับผิดชอบในการจัดการและชี้แนะระบบ AI”อัจฉริยะขั้นสูง”เผชิญกับข้อจำกัดด้านทรัพยากรที่รุนแรง ทีมงานซึ่งเดิมสัญญาไว้ 20% ของทรัพยากรการประมวลผลของบริษัท มักได้รับการร้องขอให้แม้แต่ เศษเสี้ยวของการประมวลผลนั้นถูกปฏิเสธ ตามที่คนวงในระบุ

การลาออกที่สำคัญและคำชี้แจงสาธารณะ

ปัญหาการจัดสรรทรัพยากรได้นำไปสู่การลาออกของหลายทีม สมาชิกซึ่งรวมถึง Jan Leike อดีตนักวิจัย DeepMind ซึ่งมีบทบาทสำคัญในการพัฒนา ChatGPT, GPT-4 และ InstructGPT กล่าวถึงความไม่เห็นด้วยกับผู้นำ OpenAI ต่อสาธารณะเกี่ยวกับลำดับความสำคัญหลักของบริษัท ในโพสต์ชุดหนึ่งบน X Leike แสดงความกังวลเกี่ยวกับจุดมุ่งเน้นของบริษัท โดยระบุว่าควรทุ่มเทความพยายามมากขึ้นเพื่อเตรียมพร้อมสำหรับ AI ในอนาคต โมเดลที่เน้นความปลอดภัย การตรวจสอบ ความปลอดภัย และผลกระทบต่อสังคม

เมื่อวานเป็นวันสุดท้ายของฉันในฐานะหัวหน้าฝ่ายการจัดแนว ผู้นำระดับสูง และผู้บริหาร @OpenAI

— แจน ไลค์ (@janleike) 17 พฤษภาคม 2024

การจัดตั้งและเป้าหมายของทีม Superalignment

ก่อตั้งขึ้นในเดือนกรกฎาคมของปีที่แล้ว ทีม Superalignment นำโดย Leike และ Ilya Sutskever ผู้ร่วมก่อตั้ง OpenAI ทีมงานมีเป้าหมายเพื่อจัดการกับความท้าทายด้านเทคนิคในการควบคุม AI อัจฉริยะภายในสี่ปี ประกอบด้วยนักวิทยาศาสตร์และวิศวกรจากแผนกการจัดตำแหน่งของ OpenAI และนักวิจัยจากองค์กรอื่นๆ ภารกิจของทีมคือการมีส่วนร่วมในความปลอดภัยของโมเดล AI ผ่านการวิจัยและโครงการทุนสนับสนุนที่สนับสนุนนักวิจัยภายนอก

แม้จะเผยแพร่งานวิจัยด้านความปลอดภัยและแจกจ่ายเงินสนับสนุนหลายล้านดอลลาร์ แต่ทีม Superalignment ก็ประสบปัญหาในขณะที่ผู้นำของ OpenAI มุ่งเน้นที่มากขึ้นเรื่อยๆ เปิดตัวผลิตภัณฑ์ ความขัดแย้งภายในรุนแรงขึ้นเนื่องจากการจากไปของ Sutskever หลังจากอดีตคณะกรรมการของ OpenAI พยายามล้มเหลวในการขับไล่ CEO Sam Altman บทบาทของ Sutskever มีความสำคัญในการเชื่อมโยงทีม Superalignment เข้ากับแผนกอื่นๆ และสนับสนุนความสำคัญของทีมต่อผู้มีอำนาจตัดสินใจคนสำคัญ

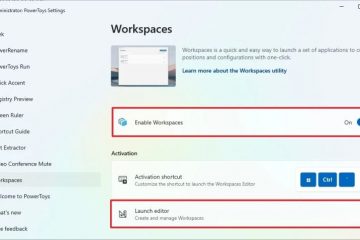

[เนื้อหาที่ฝังไว้]

การไล่ออกและการออกเดินทางเพิ่มเติม

ความวุ่นวายภายในทีม Superalignment ยังส่งผลให้นักวิจัยสองคนคือ Leopold Aschenbrenner และ Pavel Izmailov ถูกไล่ออกเนื่องจากเปิดเผยความลับของบริษัท สมาชิกในทีมอีกคน William Saunders ออกจาก OpenAI ในเดือนกุมภาพันธ์ นอกจากนี้ นักวิจัย OpenAI สองคนที่ทำงานเกี่ยวกับนโยบายและการกำกับดูแล AI, Cullen O’Keefe และ Daniel Kokotajlo ดูเหมือนจะลาออกจากบริษัทเมื่อเร็วๆ นี้ OpenAI ปฏิเสธที่จะแสดงความคิดเห็นเกี่ยวกับการจากไปของ Sutskever หรือสมาชิกคนอื่นๆ ของทีม Superalignment หรืออนาคตของการทำงานเกี่ยวกับความเสี่ยงด้าน AI ในระยะยาว

หลังจากการลาออก John Schulman ผู้ร่วมก่อตั้ง OpenAI อีกคน เข้ามารับผิดชอบงานที่ทีม Superalignment จัดการก่อนหน้านี้ อย่างไรก็ตาม ทีมจะไม่ดำรงอยู่ในฐานะเอนทิตีเฉพาะอีกต่อไป แต่ฟังก์ชันต่างๆ จะถูกรวมเข้ากับแผนกต่างๆ ทั่วทั้งบริษัทแทน โฆษกของ OpenAI อธิบายว่าการเปลี่ยนแปลงนี้เป็นการเคลื่อนไหวเพื่อ”บูรณาการ [ทีม] ให้ลึกซึ้งยิ่งขึ้น”แม้ว่าจะมีความกังวลว่าการบูรณาการนี้อาจทำให้การมุ่งเน้นไปที่ความปลอดภัยของ AI ลดลง

ความปลอดภัย AI ที่กว้างขึ้นของ OpenAI ความพยายาม

การยุบทีม Superalignment ทำให้เกิดคำถามเกี่ยวกับความมุ่งมั่นของ OpenAI ในการสร้างความมั่นใจในความปลอดภัยและการจัดแนวการพัฒนา AI OpenAI มีกลุ่มวิจัยอีกกลุ่มที่เรียกว่าทีมเตรียมความพร้อม ซึ่งมุ่งเน้นไปที่ประเด็นต่างๆ เช่น ความเป็นส่วนตัว การบงการทางอารมณ์ และความเสี่ยงด้านความปลอดภัยทางไซเบอร์ บริษัทยังอยู่ในช่วงเริ่มต้นของการพัฒนาและเผยแพร่โครงการทดลอง AI ต่อสาธารณะ รวมถึง ChatGPT เวอร์ชันใหม่ที่ใช้โมเดลต่อเนื่องหลายรูปแบบ GPT-4o ซึ่งช่วยให้ ChatGPT มองเห็นโลกและสนทนาใน วิธีที่เป็นธรรมชาติและเหมือนมนุษย์มากขึ้น ในระหว่างการสาธิตสด ChatGPT เวอร์ชันใหม่ได้เลียนแบบอารมณ์ของมนุษย์และพยายามจีบผู้ใช้

กฎบัตรของ OpenAI ผูกมัดไว้กับการพัฒนาปัญญาประดิษฐ์ทั่วไปอย่างปลอดภัยเพื่อประโยชน์ของมนุษยชาติ ทีม Superalignment ได้รับการเปิดเผยต่อสาธารณะว่าเป็นทีมหลักที่ทำงานเกี่ยวกับปัญหาในการควบคุม AI ที่อาจเป็นอัจฉริยะยิ่งยวด ความขัดแย้งภายในและปัญหาการจัดสรรทรัพยากรเมื่อเร็วๆ นี้ส่งผลต่อภารกิจของบริษัทในการพัฒนา AI อย่างมีความรับผิดชอบ