หลังจากการเปิดตัวซิลิคอน M5 ในเดือนตุลาคม Apple ได้เปิดตัวพิมพ์เขียวทางสถาปัตยกรรมสำหรับ”Neural Accelerator”ของชิป ซึ่งเป็นส่วนประกอบ GPU เฉพาะที่ออกแบบมาเพื่อท้าทายการครอบงำของ Nvidia ในด้านปริมาณงาน AI ในท้องถิ่น

รายละเอียดในรายงานทางเทคนิคฉบับใหม่วันนี้ สถาปัตยกรรมใช้ประโยชน์จากเฟรมเวิร์กการเรียนรู้ของเครื่อง MLX ที่ได้รับการอัปเดต เพื่อส่งมอบการอนุมาน”time-to-first-token”(TTFT) ที่เร็วขึ้นถึง 4 เท่า เมื่อเทียบกับ M4

การเปิดเผยข้อมูลนี้จะแปลงสิ่งที่เคยเป็นหัวข้อย่อยทางการตลาดในตอนแรกให้กลายเป็นความสามารถของฮาร์ดแวร์ที่ได้รับการบันทึกไว้ ซึ่งยืนยันว่าแบนด์วิดท์หน่วยความจำ 153GB/s ของ M5 และหน่วยเมทริกซ์เฉพาะทางได้รับการออกแบบทางวิศวกรรมมาโดยเฉพาะเพื่อทำลายปัญหาคอขวดของหน่วยความจำที่รบกวนการทำงานของโมเดลภาษาขนาดใหญ่ (LLM) บนอุปกรณ์ของผู้บริโภค

ภายใน M5: สถาปัตยกรรม Neural Accelerator

แทนที่จะอาศัยความเร็วสัญญาณนาฬิกาเพียงอย่างเดียว วิศวกรของ Apple ได้ออกแบบแกน GPU ภายใน M5 ใหม่โดยพื้นฐานเพื่อรวม”ตัวเร่งประสาท”แบบพิเศษไว้ด้วย หน่วยเหล่านี้สร้างขึ้นโดยมีจุดประสงค์เพื่อรองรับการดำเนินการคูณเมทริกซ์หนาแน่นซึ่งเป็นรากฐานของ AI สมัยใหม่

ในการเปิดตัวชิป M5 ผู้บริหารวางตำแหน่งซิลิคอนเป็นการก้าวกระโดด แต่ข้อมูลเฉพาะทางเทคนิคยังคงคลุมเครือจนกว่าจะมีการเปิดตัวรายงานทางเทคนิคอย่างเป็นทางการของ Apple

เอกสารทางเทคนิคที่อัปเดต ชี้แจงว่าตัวเร่งกำหนดเป้าหมายโดยเฉพาะในระยะการอนุมาน”เติมล่วงหน้า”ซึ่งเป็นขั้นตอนเริ่มต้นที่เน้นการประมวลผลซึ่งโมเดลจะประมวลผลพร้อมท์ของผู้ใช้

เมื่อเปิดตัว Johny Srouji รองประธานอาวุโสฝ่ายเทคโนโลยีฮาร์ดแวร์ของ Apple ได้วางกรอบความสามารถในการเปลี่ยนแปลงเชิงโครงสร้าง โดยสังเกตว่า”M5 เป็นการก้าวกระโดดครั้งใหญ่ครั้งต่อไปในประสิทธิภาพ AI สำหรับซิลิคอนของ Apple ด้วยการเปิดตัว Neural Accelerators ใน GPU M5 มอบความยิ่งใหญ่ครั้งใหญ่ เพิ่มประสิทธิภาพให้กับปริมาณงาน AI”

สิ่งสำคัญที่สุดคือ ประสิทธิภาพที่เพิ่มขึ้นจะไม่เหมือนกันในทุกงาน แม้ว่าระยะการเติมล่วงหน้าจะมีการปรับปรุงอย่างมีนัยสำคัญถึง 4 เท่าเนื่องจากหน่วยประมวลผลใหม่ แต่ระยะการสร้างโทเค็นที่ตามมายังคงถูกจำกัดด้วยความเร็วของข้อมูลที่สามารถเคลื่อนย้ายผ่านระบบได้ ตามที่อธิบายไว้ในรายงานทางเทคนิคอย่างเป็นทางการ:

“ในการอนุมาน LLM การสร้างโทเค็นแรกนั้นเกี่ยวข้องกับการคำนวณ และใช้ประโยชน์จากตัวเร่งความเร็วประสาทอย่างเต็มที่ การสร้างโทเค็นต่อมานั้นถูกจำกัดด้วยแบนด์วิดท์หน่วยความจำมากกว่าความสามารถในการคำนวณ

สำหรับสถาปัตยกรรมที่เราทดสอบในโพสต์นี้ M5 ให้การเพิ่มประสิทธิภาพ 19-27% เมื่อเทียบกับ M4 ด้วยแบนด์วิดท์หน่วยความจำที่มากขึ้น (120GB/s สำหรับ M4, 153GB/s สำหรับ M5 ซึ่งสูงกว่า 28%)

ในส่วนของพื้นที่หน่วยความจำ MacBook Pro 24GB สามารถเก็บ 8B ในความแม่นยำ BF16 หรือ 30B MoE 4 บิตได้อย่างง่ายดาย ทำให้ปริมาณงานการอนุมานต่ำกว่า 18GB สำหรับสถาปัตยกรรมทั้งสองนี้”

ความแตกต่างดังกล่าวเน้นให้เห็นถึงลักษณะที่เป็นคู่ของเส้นทางการอัปเกรดของ M5 แบนด์วิดธ์หน่วยความจำซึ่งปัจจุบันโอเวอร์คล็อกไว้ที่ 153GB/วินาที แสดงถึงการเพิ่มขึ้น 28% จาก 120GB/วินาที ของ M4 ซึ่งมีความสัมพันธ์โดยตรงกับความเร็วในการสร้างที่เพิ่มขึ้น 19-27% ที่สังเกตได้

สำหรับนักพัฒนา นี่หมายความว่า M5 มีความเชี่ยวชาญเป็นพิเศษในการจัดการข้อความแจ้งบริบทยาวที่ซับซ้อน โดยที่เวลาประมวลผลเริ่มต้นคือคอขวดหลัก ด้วยความจุหน่วยความจำแบบรวม 24GB ระบบจึงสามารถดำเนินการกับโมเดลที่สำคัญได้ เช่น โมเดลพารามิเตอร์ 8B ที่มีความแม่นยำ BF16 หรือโมเดล Mixture of Experts (MoE) 30B ในรูปแบบการหาปริมาณ 4 บิตบนอุปกรณ์ทั้งหมด

ทีมวิจัยของ Apple กล่าวว่า”Neural Accelerators มอบการดำเนินการคูณเมทริกซ์โดยเฉพาะ ซึ่งมีความสำคัญต่อเวิร์กโหลดแมชชีนเลิร์นนิงจำนวนมาก และช่วยให้ประสบการณ์การอนุมานโมเดลเร็วยิ่งขึ้นไปอีก บน Apple Silicon”

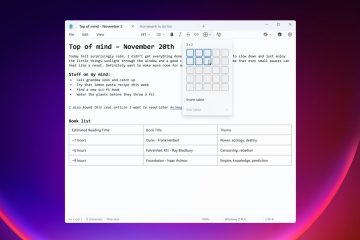

ปลดล็อกซิลิคอน: MLX Framework Evolution

นอกเหนือจากซิลิคอนแล้ว เรื่องราวของซอฟต์แวร์ยังได้พัฒนาเพื่อให้ตรงกับความสามารถของฮาร์ดแวร์ หากต้องการใช้ Neural Accelerators ใหม่ นักพัฒนาจะต้องอัปเดตเป็น เวอร์ชัน 0.30.0 ของเฟรมเวิร์ก MLX ซึ่งเป็นไลบรารีอาร์เรย์โอเพ่นซอร์สของ Apple ที่ออกแบบมาสำหรับสถาปัตยกรรมหน่วยความจำแบบรวม

เอกสารระบุว่าการรองรับฟีเจอร์เหล่านี้อย่างเต็มรูปแบบต้องใช้”macOS 26.2″ซึ่งเป็นหมายเลขเวอร์ชันที่น่าจะหมายถึง โครงสร้างภายในหรือการพิมพ์ผิดสำหรับ macOS 16.2 (Tahoe) เบต้าที่กำลังจะมาถึง ข้อกำหนดเบื้องต้นดังกล่าวเน้นย้ำถึงความสัมพันธ์ที่แนบแน่นระหว่างเคอร์เนล OS และตัวเชเดอร์ประสิทธิภาพของโลหะที่ขับเคลื่อนตัวเร่งความเร็ว

ด้วยสแต็กที่อัปเดต Apple อ้างว่า “GPU Neural Accelerators โดดเด่นด้วย MLX บนเวิร์กโหลด ML ที่เกี่ยวข้องกับการคูณเมทริกซ์ขนาดใหญ่ ซึ่งให้ความเร็วเพิ่มขึ้นถึง 4 เท่า เมื่อเทียบกับบรรทัดฐาน M4 สำหรับโทเค็นเวลาถึงครั้งแรกในการอนุมานโมเดลภาษา”

นักพัฒนายังสามารถใช้ประโยชน์จาก MLX Swift เพื่อสร้างแอปพลิเคชันที่ทำงานโดยธรรมชาติทั่วทั้งระบบนิเวศของ Apple ตั้งแต่ macOS ไปจนถึง iOS ความเข้ากันได้ข้ามแพลตฟอร์มทำหน้าที่เป็นตัวสร้างความแตกต่างที่สำคัญ ช่วยให้โค้ดที่เขียนขึ้นสำหรับ MacBook Pro สามารถนำไปใช้งานบน iPad Pro โดยมีการแก้ไขเพียงเล็กน้อย เอกสารของ Apple ให้รายละเอียดเกี่ยวกับการผสานรวมนี้:

“MLX ใช้งานได้กับระบบ Apple Silicon ทั้งหมด และด้วย macOS รุ่นเบต้าล่าสุด ทำให้ตอนนี้ใช้ประโยชน์จาก Neural Accelerators ในชิป M5 ใหม่ ซึ่งเปิดตัวใน MacBook Pro รุ่น 14 นิ้ว ใหม่ Neural Accelerators ให้การดำเนินการคูณเมทริกซ์โดยเฉพาะ ซึ่งมีความสำคัญต่อเวิร์กโหลดการเรียนรู้ของเครื่องจำนวนมาก และช่วยให้ได้รับประสบการณ์การอนุมานโมเดลที่รวดเร็วยิ่งขึ้นบน Apple Silicon”

ในเชิงกลยุทธ์ การผลักดันของซอฟต์แวร์ สอดคล้องกับโครงการริเริ่มที่กว้างขึ้น รวมถึงโครงการริเริ่มแบ็กเอนด์ CUDA ที่ Apple สนับสนุนอย่างเงียบๆ ด้วยการเปิดใช้”สะพานทางเดียว”สำหรับโค้ด MLX เพื่อทำงานบนฮาร์ดแวร์ของ Nvidia นั้น Apple กำลังวางตำแหน่งเฟรมเวิร์กเป็นสภาพแวดล้อมการพัฒนาที่ใช้งานได้ซึ่งสามารถปรับขนาดเป็นคลัสเตอร์ศูนย์ข้อมูลได้หากจำเป็น

อย่างไรก็ตาม จุดเน้นหลักยังคงอยู่ที่การดำเนินการในเครื่อง การที่ขาดการรองรับ GPU ภายนอกบน Apple Silicon หมายความว่านักพัฒนาจะต้องพึ่งพาสถาปัตยกรรมหน่วยความจำแบบรวมภายในทั้งหมด ทำให้ประสิทธิภาพของเฟรมเวิร์ก MLX มีความสำคัญอย่างยิ่งต่อประสิทธิภาพ

การหยุดชะงักของ’Mac Cluster’: การท้าทายศูนย์ข้อมูล

ในขณะที่ชิป M5 แต่ละตัวให้พลังท้องถิ่นที่สำคัญ การพัฒนาใหม่ในชุมชนโอเพ่นซอร์สกำลังท้าทายโมเดลศูนย์ข้อมูลแบบดั้งเดิม เครื่องมือโอเพ่นซอร์สใหม่ เช่น ซอฟต์แวร์การทำคลัสเตอร์ ExoLabs ช่วยให้ผู้ใช้สามารถเชื่อมโยง Mac Studios หลายเครื่องเข้าด้วยกันผ่าน Thunderbolt 5 ทำให้เกิดคลัสเตอร์การอนุมานแบบกระจายที่สามารถเรียกใช้โมเดลขนาดใหญ่ได้

ความสามารถในการจัดคลัสเตอร์นี้สามารถปรับขนาดเพื่อรองรับโมเดลที่มีขนาดใหญ่เท่ากับโมเดล Kimi K2 Thinking ใหม่ ซึ่งเป็นสถาปัตยกรรม MoE พารามิเตอร์ 1 ล้านล้านพารามิเตอร์ ด้วยการรวมหน่วยความจำแบบรวมของชิป M5 Ultra หรือ Max หลายตัว คลัสเตอร์เหล่านี้สามารถข้ามข้อจำกัด VRAM ของ GPU สำหรับผู้บริโภครายเดียวได้

นักวิจัยของ Apple เน้นย้ำถึงประสิทธิภาพของแนวทางนี้ โดยสังเกตว่า “M5 ผลักดันการสร้างโทเค็นเวลาถึงโทเค็นแรกภายใต้ 10 วินาทีสำหรับสถาปัตยกรรม 14B ที่หนาแน่น และน้อยกว่า 3 วินาทีสำหรับ 30B MoE ซึ่งมอบประสิทธิภาพที่แข็งแกร่งสำหรับสถาปัตยกรรมเหล่านี้บน MacBook Pro”

ขุมพลัง ข้อโต้แย้งด้านประสิทธิภาพเป็นสิ่งที่น่าสนใจอย่างยิ่งสำหรับห้องปฏิบัติการวิจัยและองค์กรขนาดเล็ก Mac Studios สี่คลัสเตอร์กินไฟน้อยกว่า 500 วัตต์ ซึ่งเป็นเสี้ยวหนึ่งของพลังงานที่จำเป็นสำหรับแร็คเซิร์ฟเวอร์ Nvidia H100 ที่เทียบเคียงได้

แม้ว่าเวลาแฝงบน Thunderbolt 5 จะไม่สามารถเทียบได้กับความเร็วของการเชื่อมต่อระหว่างกัน NVLink ที่เป็นเอกสิทธิ์ของ Nvidia แต่การตั้งค่านี้นำเสนอโซลูชัน”AI อธิปไตย”สำหรับองค์กรที่ต้องการความเป็นส่วนตัวของข้อมูลและไม่สามารถพึ่งพาการอนุมานบนคลาวด์ได้ การทำให้อนุมานในระดับซูเปอร์คอมพิวเตอร์มีความเป็นประชาธิปไตย แสดงให้เห็นถึงการเปลี่ยนแปลงที่สำคัญในการปรับใช้โมเดลขนาดใหญ่นอกศูนย์ข้อมูลไฮเปอร์สเกล