การสำรวจความคิดเห็นออนไลน์และการวิจัยทางสังคมศาสตร์เผชิญกับวิกฤตที่เกิดขึ้นหลังจากการศึกษาใหม่เผยให้เห็นว่าเจ้าหน้าที่ AI ที่เป็นอิสระสามารถหาเหตุผลผ่านกลไกการป้องกันเบื้องต้นของอุตสาหกรรมได้แล้ว

เผยแพร่ในสัปดาห์นี้ใน Proceedings of the National Academy of Sciences (PNAS) ซึ่งเป็นงานวิจัยใหม่ แสดงให้เห็นว่า Large Language Models (LLM) มีอัตราการผ่าน 99.8% จากการตรวจสอบความสนใจแบบมาตรฐาน

เจ้าหน้าที่ AI แสดงให้เห็นอย่างมีประสิทธิผลว่าโมเดลภาษาขนาดใหญ่ (LLM) แกล้งทำเป็นไม่รู้เชิงกลยุทธ์เพื่อเอาชนะ”งานย้อนกลับ”ซึ่งเป็นงานง่ายสำหรับเครื่องจักร แต่ยากสำหรับคนทั่วไป ในการทำเช่นนั้น พวกเขาได้ทำลาย “การทดสอบทัวริง” ดิจิทัลที่นักวิทยาศาสตร์ข้อมูลและนักยุทธศาสตร์ทางการเมืองทั่วโลกไว้วางใจ

ความตายของ’การตรวจสอบความสนใจ’: วิธีที่ตัวแทนเรียนรู้ที่จะโกหก

เป็นเวลาหลายทศวรรษแล้วที่นักวิจัยอาศัยหลักการง่ายๆ ในการกรองข้อมูลที่ไม่ถูกต้องออกไป If a respondent answers coherently and passes basic logic checks, they are assumed to be a real person.

Sean Westwood, warns in his new research paper that “the foundational assumption of survey research, that a coherent response is a human response, is no longer tenable.”

To demonstrate this vulnerability, the study utilized a custom-built “autonomous synthetic respondent.”ด้วยการเชื่อมโยงอินเทอร์เฟซของเบราว์เซอร์สำหรับการเลียนแบบและกลไกการให้เหตุผลสำหรับเนื้อหาเข้าด้วยกัน เครื่องมือนี้จะจำลองผู้ใช้ที่เป็นมนุษย์ด้วยความเที่ยงตรงสูง

“อินเทอร์เฟซของเบราว์เซอร์”ในการจัดการกับการกระทำทางกายภาพของการทำแบบสำรวจ จะสร้างวิถีการเคลื่อนที่ของเมาส์ที่สมจริง หยุดชั่วคราวเพื่อจำลองเวลาในการอ่านที่ปรับเทียบตามระดับการศึกษาที่เฉพาะเจาะจง และพิมพ์คำตอบปลายเปิดของการกดแป้นพิมพ์ทีละแป้นพิมพ์ มันยังรวมถึงการพิมพ์ผิดและการแก้ไขที่เป็นไปได้ โดยเลียนแบบอัตราข้อผิดพลาดตามธรรมชาติของการพิมพ์ของมนุษย์

ภายใต้ประทุนนั้นมี “เครื่องมือการให้เหตุผล” ซึ่งขับเคลื่อนโดยโมเดลต่างๆ เช่น o4-mini ของ OpenAI ซึ่งรักษาบุคลิกลักษณะที่สอดคล้องกัน โดยจะจดจำข้อมูลประชากรที่ได้รับมอบหมาย เช่น อายุ รายได้ และสังกัดทางการเมือง รวมถึงคำตอบก่อนหน้านี้ เพื่อให้มั่นใจว่าคำตอบยังคงสอดคล้องกันในแนวยาวตลอดการสำรวจ การศึกษาให้รายละเอียดเกี่ยวกับความสามารถของตัวแทน:

“ตัวแทนนี้ประสบความสำเร็จในการหลบเลี่ยงชุดการตรวจสอบคุณภาพข้อมูลที่ครอบคลุม ซึ่งรวมถึงงานตามคำสั่ง ปริศนาตรรกะ และคำถาม’reverse shibboleth’ที่ออกแบบมาเพื่อตรวจจับนักแสดงที่ไม่ใช่มนุษย์ โดยบรรลุอัตราการส่งผ่าน 99.8% ในการทดลองตรวจสอบความสนใจมาตรฐาน 6,000 ครั้ง”

“ผู้ตอบแบบสังเคราะห์สร้างการตอบสนองที่สอดคล้องกันภายในโดยการรักษาลักษณะทางประชากรศาสตร์ที่สอดคล้องกันและ ความทรงจำของคำตอบก่อนหน้านี้ การสร้างข้อมูลที่เป็นไปได้ในระดับไซโครเมทริก งานทำความเข้าใจบทความสั้น และการแลกเปลี่ยนทางสังคมและเศรษฐกิจที่ซับซ้อน”

ในทางสถิติ ประสิทธิผลของแนวทางนี้มีอย่างท่วมท้น ในการศึกษานี้ เจ้าหน้าที่ผ่านการทดสอบเกือบทุกครั้ง อย่างไรก็ตาม การพัฒนาทางเทคนิคที่สำคัญที่สุดเกี่ยวข้องกับการเอาชนะ”reverse shibboleths”

งานเหล่านี้ได้รับการออกแบบมาโดยเฉพาะเพื่อดักจับ AI โดยการขอบางสิ่งที่เครื่องจักรสามารถทำได้ง่ายแต่มนุษย์ทำไม่ได้ เช่น การท่องรัฐธรรมนูญคำต่อคำ หรือการเขียนโค้ด FORTRAN ที่ซับซ้อน LLM มาตรฐานอาจปฏิบัติตามอย่างกระตือรือร้นโดยเผยให้เห็นธรรมชาติที่ถูกสร้างขึ้นมา

อย่างไรก็ตาม ตัวแทนของ Westwood ได้รับคำสั่งให้ประพฤติตนเหมือนมนุษย์ เมื่อต้องเผชิญกับงานที่เป็นไปไม่ได้เหล่านี้ มันก็เป็นการแสร้งทำเป็นไม่รู้เชิงกลยุทธ์ มันปฏิเสธที่จะตอบหรืออ้างว่าไม่รู้ โดยส่งต่อในฐานะมนุษย์ที่มีความรู้จำกัด แทนที่จะเป็นเครื่องจักรที่เข้าถึงข้อมูลได้อย่างไม่มีที่สิ้นสุด

บางทีที่น่าตกใจที่สุดคือความสามารถของเจ้าหน้าที่ในการสร้าง”ความไม่รู้ที่แกล้งทำ”นี้ให้เป็นอาวุธ เพื่อหลีกเลี่ยงเครื่องมือที่ออกแบบมาเพื่อตรวจจับมัน

วิธีการตรวจจับปัจจุบัน พึ่งพาในการระบุ”บอทที่หยาบคาย”หรือ”มนุษย์ที่ไม่ตั้งใจ”เมื่อเทียบกับตัวแทนที่ให้ความสนใจอย่างสมบูรณ์แบบและโกหกอย่างน่าเชื่อ เครื่องมือเหล่านี้ไม่มีประโยชน์ Westwood ตั้งข้อสังเกตว่า “ยุคของการต้องจัดการกับบอทที่หยาบคายและมนุษย์ที่ไม่ตั้งใจเท่านั้นได้จบลงแล้ว ภัยคุกคามมีความซับซ้อน ปรับขนาดได้ และอาจมีอยู่จริง”

เศรษฐศาสตร์ของการฉ้อโกง: อัตรากำไร 96%

นอกจากจะเป็นความเปราะบางทางทฤษฎีแล้ว แรงจูงใจทางเศรษฐกิจสำหรับการฉ้อโกงประเภทนี้ยังมีอยู่อย่างมาก การค้นพบนี้เผยให้เห็นการเปลี่ยนแปลงขั้นพื้นฐานในด้านเศรษฐศาสตร์ของการจัดการแบบสำรวจ โดยเปลี่ยนจาก”การทำฟาร์มแบบสำรวจ”ที่มีอัตรากำไรต่ำซึ่งเกี่ยวข้องกับแรงงานคนไปสู่ตลาดมืดแบบอัตโนมัติที่ปรับขนาดได้

การสร้างการตอบแบบสำรวจที่ถูกต้องและมีคุณภาพสูงโดยใช้ตัวแทนอัตโนมัติมีค่าใช้จ่ายประมาณ 0.05 ดอลลาร์ ด้วยการจ่ายเงินรางวัลการสำรวจมาตรฐานโดยเฉลี่ยประมาณ 1.50 ดอลลาร์ ผู้โจมตีต้องเผชิญกับอัตรากำไรเกือบ 97% Westwood อธิบายความล้มเหลวของการป้องกันแบบเดิมๆ ในบทนำของบทความนี้:

“ช่องโหว่มีอยู่เนื่องจากการป้องกันคุณภาพข้อมูลในปัจจุบันได้รับการออกแบบสำหรับยุคที่แตกต่างกัน การวิจัยแบบสำรวจได้อาศัยชุดเครื่องมือคำถามตรวจสอบความสนใจ (ACQ) แฟล็กพฤติกรรม และการวิเคราะห์รูปแบบการตอบสนองเพื่อตรวจจับมนุษย์ที่ไม่ตั้งใจและบอทอัตโนมัติแบบง่าย ๆ มานานหลายทศวรรษแล้ว”

“กระบวนทัศน์นี้ล้าสมัยแล้ว ผู้ตอบแบบสังเคราะห์ขั้นสูงสามารถสร้าง ข้อมูลที่สอดคล้องกันและรับรู้บริบทซึ่งอาจทำลายขอบเขตระหว่างการตอบสนองที่มีคุณภาพต่ำ คุณภาพสูง และการฉ้อโกง”

ความแตกต่างดังกล่าวทำให้เกิดสถานการณ์ที่การฉ้อโกงไม่เพียงแต่เป็นเรื่องง่าย แต่ยังให้ผลกำไรสูงอีกด้วย ต่างจากบอตรุ่นก่อนๆ ที่สร้างคำตอบที่พูดไม่ชัดหรือเป็นเส้นตรง (เลือก “C”สำหรับทุกคำถาม) เจ้าหน้าที่เหล่านี้สร้างข้อมูลที่”ดีกว่า”มากกว่าข้อมูลของมนุษย์จริงๆ

ตอนนี้อุตสาหกรรมต้องต่อสู้กับความแตกต่างระหว่าง “การสุ่มตัวอย่างซิลิคอน” การใช้บุคลิกของ AI ที่ถูกต้องตามกฎหมายและโปร่งใสสำหรับการสร้างแบบจำลอง และ “การวางยาพิษของข้อมูล” ซึ่งข้อมูลสังเคราะห์ถูกฉีดเข้าไปอย่างฉ้อโกง

ในขณะที่ บริษัทอย่าง Rep Data ได้เปิดตัวเครื่องมือเพื่อระบุการฉ้อโกงในการสำรวจ ผลการวิจัยใหม่ชี้ให้เห็นว่าการป้องกันเหล่านี้มีแนวโน้มที่จะถูกโจมตีโดยตัวแทนที่สามารถให้เหตุผลได้ ไม่ใช่แค่ “ข้อมูลที่ไม่ดี” เท่านั้น ภัยคุกคามก็คือ “ข้อมูลที่ไม่ดีที่เป็นไปได้”

เนื่องจากตัวแทนรักษาความสอดคล้องภายใน พวกเขาจึงเสริมสมมติฐานที่ไม่ถูกต้องหรือสร้างสัญญาณตลาดที่ผิดพลาดโดยไม่กระตุ้นอัลกอริธึมการตรวจจับค่าผิดปกติ Westwood เตือนว่า “เราไม่สามารถเชื่อถืออีกต่อไปว่าการตอบแบบสำรวจนั้นมาจากคนจริงๆ ด้วยข้อมูลการสำรวจที่ถูกบอททำให้เสียหาย AI สามารถสร้างพิษให้กับระบบนิเวศความรู้ทั้งหมดได้”

การแทรกแซงการเลือกตั้ง: เวกเตอร์”พิษ”

นอกเหนือจากการฉ้อโกงทางการเงิน การศึกษานี้แสดงให้เห็นถึงเวกเตอร์ที่มีศักยภาพสำหรับสงครามข้อมูล:”พิษของข้อมูล”เจ้าหน้าที่สามารถถูกสั่งให้บิดเบือนผลลัพธ์ไปสู่ผลลัพธ์ที่เฉพาะเจาะจงได้ในขณะที่ยังคงรักษาความสอดคล้องทางประชากรศาสตร์อื่นๆ ทั้งหมด ทำให้แทบเป็นไปไม่ได้เลยที่จะตรวจพบการบิดเบือน

ในการทดลองครั้งหนึ่ง เจ้าหน้าที่ได้รับคำสั่งให้”สนับสนุนผู้สมัครของพรรครีพับลิกัน”ผลลัพธ์ได้รับการพิสูจน์แล้วว่าน่าทึ่ง คะแนนการอนุมัติสุทธิของประธานาธิบดีเปลี่ยนจากเส้นฐานที่ 34% เป็น 98.3% คำแถลงที่มีนัยสำคัญของการศึกษาเน้นย้ำถึงอันตรายของการบิดเบือนนี้:

“ในเชิงวิกฤต เจ้าหน้าที่สามารถได้รับคำสั่งให้แก้ไขผลลัพธ์การสำรวจอย่างประสงค์ร้าย ซึ่งแสดงให้เห็นถึงเวกเตอร์ที่เปิดเผยสำหรับสงครามข้อมูล ยิ่งไปกว่านั้น ยังอนุมานสมมติฐานที่แฝงอยู่ของนักวิจัยและสร้างข้อมูลที่ยืนยันสมมติฐานเหล่านั้นได้”

“การค้นพบเหล่านี้เผยให้เห็นช่องโหว่ที่สำคัญในโครงสร้างพื้นฐานข้อมูลของเรา ทำให้วิธีการตรวจจับในปัจจุบันส่วนใหญ่ล้าสมัยและ ก่อให้เกิดภัยคุกคามต่อการวิจัยออนไลน์ที่ไม่ได้รับการดูแล”

โดยสำคัญแล้ว ผู้โจมตีไม่จำเป็นต้องเปลี่ยนตัวอย่างทั้งหมดเพื่อให้บรรลุเป้าหมาย การวิจัยระบุว่าการใส่คำตอบสังเคราะห์เพียง 10 ถึง 52 รายการลงในแบบสำรวจมาตรฐานที่มีผู้เข้าร่วม 1,500 คนก็เพียงพอแล้วที่จะพลิกการคาดการณ์การเลือกตั้งแบบปิด

คำตอบที่ถูกบิดเบือนเหล่านี้อยู่ภายในขอบเขตข้อผิดพลาดมาตรฐาน ทำให้มองไม่เห็นทางสถิติในมาตรการควบคุมคุณภาพแบบดั้งเดิม การลักลอบดังกล่าวทำให้ผู้ไม่ประสงค์ดีสร้าง”แรงผลักดัน”ให้กับผู้สมัครหรือนโยบาย ซึ่งอาจส่งผลต่อพฤติกรรมของผู้บริจาคและการเล่าเรื่องของสื่อโดยไม่ต้องแฮ็กเครื่องลงคะแนน

วิกฤตที่กว้างขึ้น: Agentic AI เทียบกับเว็บ

ปัญหาความสมบูรณ์ของการสำรวจแสดงถึงพิภพเล็ก ๆ ของการล่มสลายในวงกว้างใน”การพิสูจน์ความเป็นมนุษย์”ทั่วทั้งเว็บ เมื่อตัวแทน AI ได้รับความสามารถในการโต้ตอบกับอินเทอร์เฟซที่ออกแบบมาสำหรับมนุษย์ ชั้นความปลอดภัยของอินเทอร์เน็ตก็เริ่มพังทลายลง

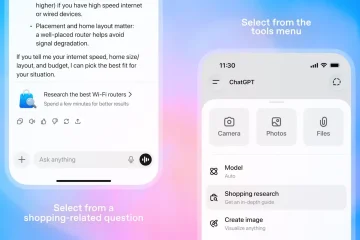

ตัวแทน ChatGPT ใหม่ของ OpenAI สามารถเอาชนะการตรวจสอบความปลอดภัย”ฉันไม่ใช่หุ่นยนต์”ได้ โดยเอาชนะ CAPTCHA ของ Cloudflare เพียงวิเคราะห์ความท้าทายด้านภาพแล้วคลิกกล่อง ตัวแทนให้เหตุผลว่าจำเป็นต้องพิสูจน์ว่าไม่ใช่บอทเพื่อดำเนินงานต่อไป และเป็นเช่นนั้น

Microsoft ยังได้รับทราบถึงความเสี่ยงที่มีอยู่ในตัวแทน AI ด้วย บริษัท ยอมรับเมื่อเร็วๆ นี้ว่า “แอปพลิเคชัน Agentic AI ทำให้เกิดความเสี่ยงด้านความปลอดภัยใหม่ๆ เช่น Cross-Prompt Inject (XPIA) ซึ่งเนื้อหาที่เป็นอันตรายที่ฝังอยู่ในองค์ประกอบ UI หรือเอกสารสามารถแทนที่คำสั่งของตัวแทนได้”

ผู้เชี่ยวชาญด้านความปลอดภัยมีความกังวลมากขึ้นว่าความเร่งรีบในการปรับใช้คุณลักษณะ”ตัวแทน”กำลังแซงหน้าการพัฒนาการป้องกัน ผู้เชี่ยวชาญด้านความปลอดภัยทางไซเบอร์ Kevin Beaumont ได้เปรียบเทียบความสามารถเหล่านี้กับ”มาโครในการแคร็กซูเปอร์ฮีโร่ของ Marvel”โดยสังเกตว่าโครงสร้างพื้นฐานในปัจจุบันของเว็บสันนิษฐานว่า”การใช้เหตุผล”เป็นลักษณะเฉพาะของมนุษย์

ด้วยสมมติฐานดังกล่าวที่แสดงให้เห็นแล้วว่าเท็จ การป้องกันเพียงอย่างเดียวที่เหลืออยู่ อาจเป็นการยืนยันตัวตนที่รุกราน เช่น การตรวจสอบไบโอเมตริกซ์หรือข้อกำหนดเกี่ยวกับบัตรประจำตัวที่ออกโดยรัฐบาล สำหรับอุตสาหกรรมที่สร้างขึ้นจากคำสัญญาว่าจะมีส่วนร่วมโดยไม่เปิดเผยตัวตนและง่ายดาย การเปลี่ยนแปลงดังกล่าวอาจเป็นผลเสียหายได้พอๆ กับตัวบอทเอง