สถาบัน Allen Institute for AI (AI2) ได้เปิดตัว OLMo 3 ซึ่งเป็นตระกูลโมเดลภาษาใหม่ที่ท้าทายคำจำกัดความทั่วไปของ”โอเพ่นซอร์ส”ในปัญญาประดิษฐ์

ฉีกออกจากมาตรฐานอุตสาหกรรมที่เพียงแค่ปล่อยน้ำหนักโมเดลแบบแช่แข็งเท่านั้น AI2 กำลังเผยแพร่”การไหลของโมเดล”ทั้งหมด ซึ่งเป็นระบบนิเวศที่สมบูรณ์ซึ่งประกอบด้วยชุดข้อมูล โค้ดการฝึกอบรม และจุดตรวจสอบระดับกลาง

กำหนดนิยามโอเพ่นซอร์สใหม่:”โฟลว์โมเดล”กระบวนทัศน์

โมเดลที่”เปิด”ส่วนใหญ่ในปัจจุบันคือกล่องดำที่มีประสิทธิภาพพร้อมที่จับสาธารณะ นักพัฒนาสามารถใช้สิ่งเหล่านี้ได้แต่ไม่สามารถตรวจสอบได้ว่าถูกสร้างขึ้นมาอย่างไร

AI2 พยายามพลิกกลับเทรนด์นี้ด้วยการเปิดตัว Dolma 3 ชุดข้อมูลการฝึกอบรมล่วงหน้าขนาดใหญ่ ควบคู่ไปกับ Dolci ซึ่งเป็นชุดข้อมูลการฝึกอบรมเฉพาะทาง คลังข้อมูลสำหรับการปรับแต่งคำสั่งหลังการฝึกอบรม

ด้วยการให้การเข้าถึงจุดตรวจสอบจากทุกขั้นตอนการพัฒนา การฝึกล่วงหน้า การฝึกกลาง และหลังการฝึกอบรม สถาบันช่วยให้นักวิจัยสามารถแทรกแซงที่จุดเฉพาะได้

แทนที่จะปรับแต่งผลิตภัณฑ์สำเร็จรูปอย่างละเอียด วิศวกรสามารถแยกแบบจำลองในระหว่างระยะ”การฝึกกลาง”เพื่ออัดฉีดทักษะเฉพาะโดเมน

การทำให้’ระบบ 2’เป็นประชาธิปไตย การใช้เหตุผล

ส่วนสำคัญของการเปิดตัวนี้คือ OLMo 3-Think (32B) ซึ่งเป็นโมเดลที่ออกแบบมาเพื่อจำลองความสามารถในการให้เหตุผลแบบ”ลูกโซ่แห่งความคิด”ซึ่งได้รับความนิยมจากระบบที่เป็นกรรมสิทธิ์ เช่น o1 ของ OpenAI ต่างจากทางเลือกอื่นแบบปิดที่ซ่อนตรรกะไว้เบื้องหลังการเรียก API OLMo 3-Think เปิดเผยขั้นตอนการให้เหตุผลระดับกลาง

ผู้ใช้สามารถสังเกตได้อย่างชัดเจนว่าแบบจำลองแยกโครงสร้างปัญหาทางคณิตศาสตร์หรือการเขียนโค้ดที่ซับซ้อนได้อย่างไร ดังที่ระบุไว้ในรายงานทางเทคนิค “Olmo 3-Think (32B)… ช่วยให้คุณตรวจสอบร่องรอยการให้เหตุผลระดับกลาง และติดตามพฤติกรรมเหล่านั้นกลับไปยังข้อมูลและการฝึกอบรมการตัดสินใจที่ก่อให้เกิดพฤติกรรมเหล่านั้น”

เกณฑ์มาตรฐานแนะนำว่าความโปร่งใสนี้ไม่ได้แลกกับต้นทุนความสามารถ ตัวแปร 32B แข่งขันโดยตรงกับ Qwen 3 และ DeepSeek R1 ซึ่งช่วยลดช่องว่างด้านประสิทธิภาพระหว่างโมเดลการให้เหตุผลแบบเปิดเต็มรูปแบบและแบบเปิดน้ำหนัก

ยังมีเวอร์ชัน 7B อีกด้วย โดยนำความสามารถ”ระบบ 2″เหล่านี้มาสู่ฮาร์ดแวร์ระดับผู้บริโภคเพื่อการทดลองที่กว้างขึ้น

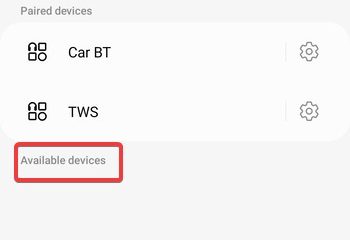

[เนื้อหาแบบฝัง]

ประสิทธิภาพมาตรฐาน: ปิดช่องว่างด้วยโมเดลแบบปิด

การเปิดตัว OLMo เวอร์ชัน 3 ถือเป็นการเปลี่ยนแปลงที่สำคัญในด้านประสิทธิภาพสำหรับโมเดลแบบเปิดโดยสมบูรณ์ โดยเฉพาะอย่างยิ่งเมื่อต้องรับมือกับคู่แข่งแบบ”open Weights”ที่เก็บข้อมูลการฝึกอบรมของตนไว้เป็นกรรมสิทธิ์ จากการประเมินตามมาตรฐานอุตสาหกรรม ตัวแปร 32B แสดงให้เห็นถึงความสามารถที่มักจะทัดเทียมหรือเกินกว่าโมเดลที่มีจำนวนพารามิเตอร์มากกว่าอย่างมาก

ในงานเขียนโค้ดพื้นฐาน OLMo 3-Base (32B) ให้ผลลัพธ์ที่โดดเด่น ในเกณฑ์มาตรฐาน HumanEval ได้คะแนน 66.5% เหนือกว่า Llama 3.1 70B (57.4%) ของ Meta และแซงหน้า Qwen 2.5 32B (65.6%)

ประสิทธิภาพนี้บ่งบอกว่าระยะ”การฝึกกลาง”ที่ได้รับการดูแลจัดการของโมเดล ซึ่งเน้นที่โค้ดและคณิตศาสตร์เป็นอย่างมาก ได้ประสบความสำเร็จในการก้าวข้ามระดับน้ำหนัก ทำให้โมเดล 32B สามารถจัดการงานการเขียนโปรแกรมโดยทั่วไปได้ สงวนไว้สำหรับระบบพารามิเตอร์ 70B+

ความสามารถในการให้เหตุผล “System 2″ของตัวแปร OLMo 3-Think มีการแข่งขันที่เท่าเทียมกัน โดยเฉพาะอย่างยิ่งในคณิตศาสตร์และตรรกะที่ซับซ้อน:

คณิตศาสตร์ขั้นสูง: บนเกณฑ์มาตรฐาน MATH ที่ท้าทาย OLMo 3-Think (32B) ได้คะแนน 96.1% เหนือกว่าทั้ง Qwen 3 32B (95.4%) และ DeepSeek R1 Distill 32B (92.6%). เหตุผลในการเขียนโค้ด: ในการประเมิน HumanEvalPlus ซึ่งทดสอบการสร้างโค้ดที่มีประสิทธิภาพ โมเดลดังกล่าวได้คะแนน 91.4% ซึ่งเป็นผู้นำในสนามอีกครั้งเมื่อเทียบกับโมเดลน้ำหนักเปิดที่เทียบเคียงได้ การปฏิบัติตามคำแนะนำ: โมเดลดังกล่าวยังครองตำแหน่งสูงสุดในเกณฑ์มาตรฐาน IFEval ด้วยคะแนน 89.0% ซึ่งบ่งชี้ว่ามีความน่าเชื่อถือในระดับสูงโดยปฏิบัติตามข้อจำกัดที่ซับซ้อนของผู้ใช้

ผลลัพธ์เหล่านี้ยืนยันสมมติฐานของ AI2 ที่ว่าความโปร่งใสไม่จำเป็นต้องลดทอนคุณภาพ ด้วยการบรรลุความเท่าเทียมกับโมเดลน้ำหนักเปิดชั้นนำ เช่น Qwen 3 และ Llama 3.1 ทำให้ OLMo 3 พิสูจน์ได้ว่า”โฟลว์โมเดล”ที่ตรวจสอบได้อย่างสมบูรณ์สามารถรองรับประสิทธิภาพที่ล้ำสมัยในโดเมนที่มีมูลค่าสูง เช่น การใช้เหตุผลเชิงปริมาณและการพัฒนาซอฟต์แวร์

ประสิทธิภาพทางวิศวกรรมและ 32B Sweet Spot

AI2 ได้วางตำแหน่งขนาดพารามิเตอร์ 32B ให้เป็นความสมดุลที่เหมาะสมที่สุด นำเสนอความสามารถในการวิจัยประสิทธิภาพสูงที่ยังคงปรับใช้ได้บนคลัสเตอร์ฮาร์ดแวร์ที่สามารถเข้าถึงได้ การจะบรรลุผลนี้จำเป็นต้องมีการเพิ่มประสิทธิภาพทางสถาปัตยกรรมที่สำคัญภายในพื้นที่เก็บข้อมูล GitHub สำหรับ OLMo-core

การปรับปรุงด้านเทคนิคทำให้ปริมาณการประมวลผลการฝึกอบรมเร็วขึ้นอย่างมาก

ประสิทธิภาพหลังการฝึกอบรมยังได้รับการปรับปรุงอย่างมากอีกด้วย ด้วยการย้ายกระบวนการปรับแต่งแบบละเอียดภายใต้การดูแล (SFT) ไปยังเฟรมเวิร์กหลักโดยตรง ทีมงานจึงเพิ่มปริมาณงานขึ้น 8 เท่าเมื่อเทียบกับการทำซ้ำครั้งก่อน

Ali Farhadi ซีอีโอของ Allen Institute for AI เน้นย้ำว่า”ประสิทธิภาพสูงไม่จำเป็นต้องมีต้นทุนสูง… AI ที่มีความรับผิดชอบและยั่งยืนสามารถปรับขนาดได้โดยไม่มีการประนีประนอม”

ความเป็นส่วนตัว ใบอนุญาต และระบบนิเวศที่กว้างขึ้น

ทั้งหมด อาร์ติแฟกต์ใน คอลเลกชัน Hugging Face ได้รับการเผยแพร่ภายใต้ใบอนุญาต Apache 2.0 ที่ได้รับอนุญาต ข้อกำหนดดังกล่าวอนุญาตให้ใช้ ดัดแปลง และปรับใช้เชิงพาณิชย์ได้อย่างไม่จำกัด ซึ่งตรงกันข้ามกับ”สิทธิ์การใช้งานชุมชน”ที่จำกัดซึ่งมักใช้โดยห้องปฏิบัติการเทคโนโลยีรายใหญ่

ความโปร่งใสขยายไปสู่ห่วงโซ่อุปทานข้อมูล ด้วยการเปิดตัว Dolma 3 ทำให้ AI2 จัดการกับการตรวจสอบลิขสิทธิ์และแหล่งที่มาของข้อมูลที่เพิ่มขึ้น ด้วยการเปิดเผยไปป์ไลน์ทั้งหมด สถาบันมีเป้าหมายที่จะเปลี่ยนมาตรฐานอุตสาหกรรมจาก”เชื่อเรา”เป็น”ยืนยันด้วยตัวเอง”ซึ่งจะทำให้สามารถตรวจสอบได้ทางวิทยาศาสตร์ในระดับที่หาได้ยากในภาคส่วน Generative AI