ไม่ถึงสี่เดือนหลังจากเปิดตัว Segment Anything Model 2 ที่เน้นวิดีโอ Meta ได้เปิดตัว SAM 3 และ SAM 3D ซึ่งปรับใช้โมเดลคอมพิวเตอร์วิทัศน์ขั้นสูงในผลิตภัณฑ์สำหรับผู้บริโภค เช่น Facebook Marketplace และ Instagram ทันที

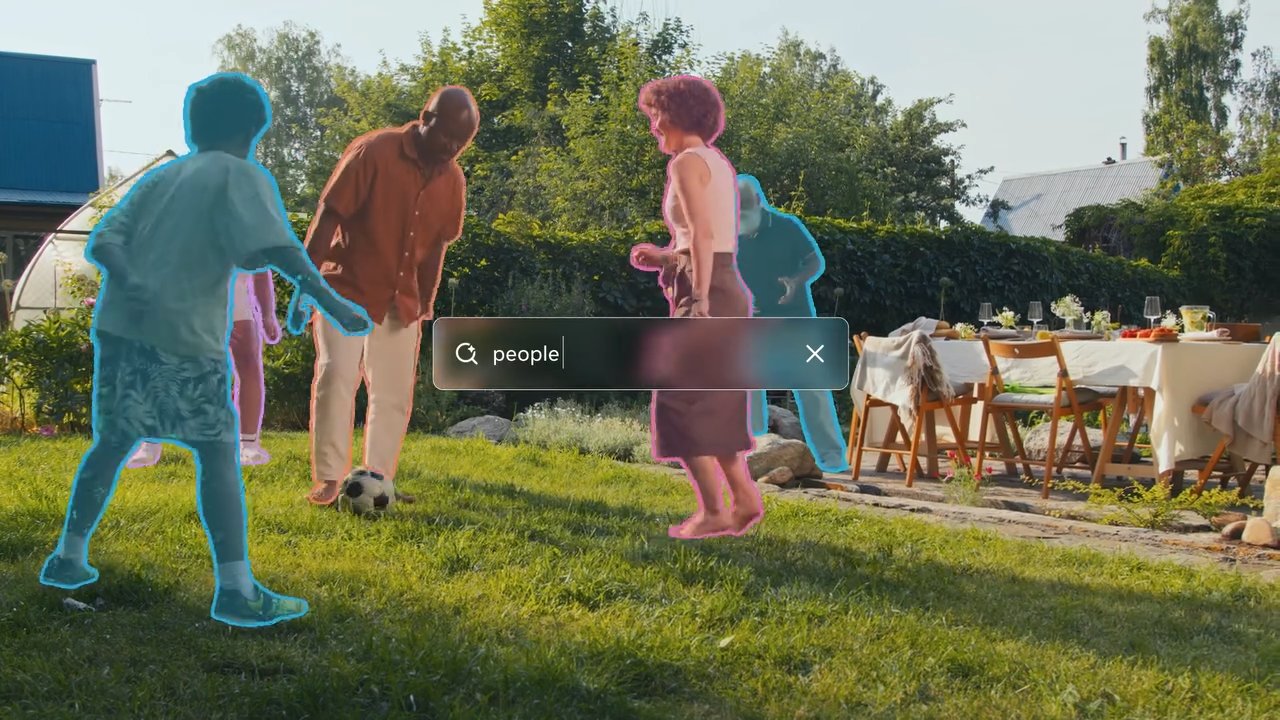

เครื่องมือทั้งสองช่วยให้คอมพิวเตอร์เข้าใจสิ่งที่พวกเขากำลังดูได้ดีขึ้นมาก SAM 3 ช่วยให้ผู้ใช้สามารถพิมพ์คำอธิบายและให้ AI ค้นหาและไฮไลต์ทุกวัตถุที่ตรงกันในภาพถ่ายหรือวิดีโอได้ทันที

SAM 3D ก้าวไปอีกขั้นด้วยการถ่ายภาพแบนสองมิติและคาดการณ์ว่าวัตถุจะมีลักษณะอย่างไรจากมุมอื่น ๆ โดยเปลี่ยนภาพถ่ายมาตรฐานให้เป็นโมเดล 3 มิติที่หมุนได้อย่างมีประสิทธิภาพ

แม้ว่าการทำซ้ำครั้งก่อนจะยังคงอยู่ในขอบเขตการวิจัยเป็นส่วนใหญ่ การอัปเดตนี้ถือเป็นการเปลี่ยนแปลงอย่างรวดเร็วไปสู่ยูทิลิตี้ที่นำไปใช้ โดยขับเคลื่อนฟีเจอร์ที่ช่วยให้ผู้ใช้เห็นภาพเฟอร์นิเจอร์ในบ้านของตน หรือใช้เอฟเฟกต์กับวัตถุเฉพาะในวิดีโอ

โมเดลใหม่นำเสนอ”Promptable Concept”การแบ่งส่วน”ช่วยให้สามารถระบุวัตถุที่ตรงกันทั้งหมดในฉากด้วยข้อความ และการสร้าง 3 มิติที่มีความเที่ยงตรงสูงจากภาพ 2 มิติเดียว ความสามารถที่ Meta อ้างว่ามีประสิทธิภาพเหนือกว่าเกณฑ์มาตรฐานที่มีอยู่ด้วยระยะขอบที่กว้าง

SAM 2 ที่เปิดตัวในปี 2024 มุ่งเน้นไปที่ประสิทธิภาพการแบ่งส่วนวิดีโออย่างมาก แต่การประกาศในวันนี้ได้ขยายขอบเขตออกไปอย่างมากเพื่อรวมความเข้าใจเชิงความหมายและการสร้าง 3 มิติ

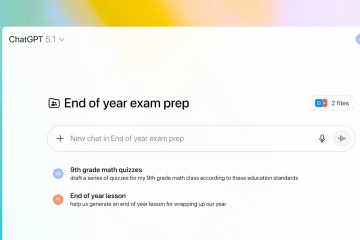

จากการวิจัยสู่ผลิตภัณฑ์: ทันที การบูรณาการ

การแตกหักจากวงจรการวิจัยสู่ผลิตภัณฑ์แบบดั้งเดิม Meta กำลังข้ามขั้นตอนการบ่มเพาะโดยทั่วไปเพื่อรวม SAM 3 เข้ากับแอปพลิเคชันหลักโดยตรง

ผู้ใช้ Facebook Marketplace ตอนนี้จะพบกับฟีเจอร์”ดูในห้อง”ที่ขับเคลื่อนโดย SAM 3D ซึ่งช่วยให้ผู้ซื้อที่มีศักยภาพเห็นภาพว่าสินค้าเฟอร์นิเจอร์จะมีลักษณะอย่างไรในพื้นที่อยู่อาศัยของตนเองก่อนที่จะตัดสินใจซื้อ

แอปพลิเคชันนี้ใช้ประโยชน์จากความสามารถของโมเดลในการ สร้างวัตถุ 3 มิติขึ้นมาใหม่จากภาพ 2 มิติเดียว โดยจัดการกับจุดเสียดสีทั่วไปในการค้าออนไลน์

ในขณะเดียวกัน แอป “แก้ไข” ของ Instagram และฟีเจอร์ “Vibes” ภายใน Meta AI กำลังใช้ SAM 3 เพื่อเปิดใช้งานเอฟเฟกต์วิดีโอเฉพาะวัตถุที่แม่นยำ ขณะนี้ผู้สร้างสามารถใช้การแก้ไขต่างๆ เช่น สปอตไลท์หรือเส้นทางการเคลื่อนไหวกับวัตถุเฉพาะภายในเฟรมวิดีโอ ซึ่งเป็นงานที่ก่อนหน้านี้จำเป็นต้องมีการมาสก์ที่ซับซ้อนในซอฟต์แวร์ตัดต่อระดับมืออาชีพ

ดูบนเธรด

ด้วยการทำให้กระบวนการเหล่านี้เป็นอัตโนมัติ Meta มีเป้าหมายที่จะขายสินค้าเอฟเฟกต์ภาพขั้นสูง ทำให้สามารถเข้าถึงได้เป็นยูทิลิตี้มาตรฐานสำหรับผู้ใช้ทั่วไป

เพื่ออำนวยความสะดวกในการทดลองที่กว้างขึ้น บริษัท ได้เปิดตัว “Segment Anything Playground” ซึ่งเป็นอินเทอร์เฟซบนเว็บที่ช่วยให้สาธารณชนสามารถทดสอบโมเดลเหล่านี้ได้โดยไม่ต้องมีความเชี่ยวชาญด้านเทคนิค

ผู้ใช้สามารถอัปโหลดรูปภาพหรือวิดีโอและแจ้งให้ระบบพร้อมคำอธิบายข้อความเพื่อดูความสามารถในการแบ่งส่วนแบบเรียลไทม์ กลยุทธ์นี้แตกต่างอย่างมากกับการเปิดตัว SAM 2 ซึ่งยังคงเป็นเครื่องมือหลักสำหรับชุมชนการวิจัยการมองเห็นด้วยคอมพิวเตอร์

การติดตั้งใช้งานทันทีในแอปสำหรับผู้บริโภคแสดงให้เห็นจุดสำคัญเชิงกลยุทธ์เพื่อใช้ประโยชน์จากความก้าวหน้าของ AI สำหรับการรักษาผู้ใช้และการมีส่วนร่วมทั่วทั้งระบบนิเวศทางสังคมของ Meta

การก้าวกระโดดทางเทคนิค: การแบ่งส่วนแนวคิดและ 3 มิติ

SAM 3 นำเสนอความสามารถที่สำคัญที่เรียกว่า”Promptable Concept Segmentation”(PCS) ต่างจากรุ่นก่อนซึ่งมุ่งเน้นไปที่การแบ่งส่วนวัตถุเดี่ยวตามการแสดงภาพ เช่น การคลิกหรือกล่อง SAM 3 สามารถระบุและปกปิดอินสแตนซ์ทั้งหมดของแนวคิดที่อธิบายด้วยข้อความได้

ตัวอย่างเช่น ผู้ใช้สามารถแจ้งโมเดลด้วย”หมวกเบสบอลสีแดง”และมันจะแบ่งส่วนที่ตรงกันทุกรายการในเฟรม การเปลี่ยนแปลงนี้ต้องการให้โมเดลมีทั้งความเข้าใจเชิงความหมายของข้อความและความสามารถในการแปลที่แม่นยำ

เพื่อให้บรรลุเป้าหมายนี้ สถาปัตยกรรมจะแยกการรับรู้ออกจากการแปลเป็นภาษาท้องถิ่นโดยใช้”โทเค็นการแสดงตน”กลไกนี้จะกำหนดก่อนว่าแนวคิดมีอยู่ภายในเฟรมหรือไม่ก่อนที่โมเดลจะพยายามแบ่งส่วน ซึ่งช่วยลดผลบวกลวงและปรับปรุงความแม่นยำในการตรวจจับโดยรวม

ตามรายงานของทีมวิจัย Meta “SAM 3 เพิ่มความแม่นยำเป็นสองเท่าของระบบที่มีอยู่ทั้งในรูปภาพและวิดีโอ PCS และปรับปรุงความสามารถของ SAM ก่อนหน้านี้ในงานการแบ่งส่วนด้วยภาพ”

แนวทางคู่นี้ทำให้โมเดลสามารถจัดการกับคำสั่งที่ซับซ้อนในขณะที่ยังคงรักษาประสิทธิภาพสูงในงานการแบ่งส่วนมาตรฐาน

Meta Sam 3 แบ่งส่วนอะไรก็ได้ด้วย แนวคิด

ในการสร้าง 3 มิติ SAM 3D ช่วยให้สามารถสร้างวัตถุและฉากขึ้นมาใหม่จากรูปภาพ 2 มิติเดียว ซึ่งเป็นงานที่เดิมต้องใช้มุมมองหลายมุมมองหรือข้อมูลเชิงลึก Meta อ้างว่าโมเดลใหม่นี้มีประสิทธิภาพเหนือกว่าวิธีการที่มีอยู่อย่างมาก

ทีมงาน Meta AI ตั้งข้อสังเกตว่า “ในการทดสอบการตั้งค่าของมนุษย์แบบตัวต่อตัว โมเดลจะได้รับอัตราการชนะอย่างน้อย 5:1 เหนือโมเดลชั้นนำอื่น ๆ” สิ่งนี้มีความเกี่ยวข้องเป็นพิเศษสำหรับแอปพลิเคชันในความเป็นจริงเสริมและการเล่นเกม ซึ่งการสร้างเนื้อหาอย่างรวดเร็วเป็นสิ่งสำคัญ

ดูบนเธรด

ตัวชี้วัดประสิทธิภาพที่เผยแพร่โดย Meta ระบุว่า SAM 3 มีประสิทธิภาพสูง ทีมวิจัย Meta ยังระบุด้วยว่า “SAM 3 ทำงานใน 30 มิลลิวินาทีสำหรับภาพเดียวที่มีวัตถุที่ตรวจพบมากกว่า 100 ชิ้นบน GPU H200″ ความเร็วดังกล่าวเป็นสิ่งจำเป็นสำหรับแอปพลิเคชันแบบเรียลไทม์บนอุปกรณ์ของผู้บริโภค ซึ่งเวลาแฝงสามารถลดประสบการณ์ของผู้ใช้ได้

สำหรับการสร้างใหม่โดยมนุษย์ SAM 3D Body ใช้รูปแบบโอเพ่นซอร์สใหม่

“SAM 3D Body… ใช้ประโยชน์จากรูปแบบตาข่ายโอเพ่นซอร์ส 3 มิติใหม่ที่เรียกว่า Meta Momentum Human Rig (MHR) ซึ่งนำเสนอความสามารถในการตีความที่ดีขึ้นโดยการแยกโครงสร้างโครงกระดูกและรูปร่างเนื้อเยื่ออ่อน”

การแยกนี้ช่วยให้ โมเดลมนุษย์ที่สมจริงและปรับได้มากขึ้น ซึ่งอาจมีผลกระทบต่ออวาตาร์และแอนิเมชั่นเสมือน

แม้จะมีความก้าวหน้าเหล่านี้ แต่โมเดลก็ไม่มีข้อจำกัด ทีมงาน Meta AI ยอมรับว่า “SAM 3 พยายามดิ้นรนที่จะสรุปแนวคิดนอกโดเมนที่มีรายละเอียดละเอียดในลักษณะที่เป็นศูนย์ เช่น การระบุคำศัพท์เฉพาะที่ต้องใช้ความรู้ในโดเมน เช่น’เกล็ดเลือด'”

สิ่งนี้ชี้ให้เห็นว่าแม้ว่าแบบจำลองจะมีประสิทธิภาพสำหรับวัตถุทั่วไป แต่ก็อาจต้องมีการปรับแต่งอย่างละเอียดหรือข้อมูลเพิ่มเติมเพื่อจัดการกับหมวดหมู่เฉพาะหรือที่หายากได้อย่างมีประสิทธิภาพ

กลไกข้อมูลและการเปรียบเทียบ

ด้วยการใช้ประโยชน์ เอ็นจิ้นข้อมูลไฮบริดทำให้ Meta สามารถปรับขนาดข้อมูลการฝึกได้อย่างมีนัยสำคัญ บริษัทพัฒนาระบบโดยใช้ “คำอธิบายประกอบ AI” ที่ใช้ Llama เพื่อตรวจสอบมาสก์และตรวจสอบความอ่อนล้า ซึ่งเป็นงานที่อาจช้าอย่างห้ามสำหรับมนุษย์เพียงอย่างเดียว

Meta อธิบายว่า “โดยการมอบหมายงานบางอย่างให้กับคำอธิบายประกอบ AI ซึ่งเป็นแบบจำลองที่ตรงกันหรือเกินความแม่นยำของมนุษย์ ทำให้เรามีปริมาณงานมากกว่าสองเท่าเมื่อเทียบกับไปป์ไลน์คำอธิบายประกอบสำหรับมนุษย์เท่านั้น”

วิธีนี้อนุญาตให้สร้างชุดข้อมูล SA-Co ซึ่งมีมากกว่า 4 รายการ ล้านแนวคิดที่ไม่ซ้ำใครและมาสก์ 52 ล้านชิ้น ซึ่งเป็นพื้นที่ฝึกอบรมที่หลากหลายสำหรับโมเดลใหม่

นอกเหนือจากโมเดลแล้ว Meta ยังได้เปิดตัวเกณฑ์มาตรฐาน”แบ่งส่วนอะไรก็ได้ด้วยแนวคิด”(SA-Co) ชุดข้อมูลนี้มีแนวคิดที่ไม่ซ้ำกัน 207,000 แนวคิดที่ออกแบบมาเพื่อทดสอบความสามารถในการจดจำคำศัพท์แบบเปิด ซึ่งเป็นการผลักดันมาตรฐานอุตสาหกรรมสำหรับการประเมิน

กลไกข้อมูลยังขุดค้น”คำเชิงลบอย่างหนัก”ซ้ำๆ ซึ่งเป็นวลีที่ไม่มีอยู่ในรูปภาพแต่เป็นปฏิปักษ์ต่อแบบจำลอง เพื่อปรับปรุงความทนทานต่อผลบวกลวง

นอกเหนือจากแอปสำหรับผู้บริโภคแล้ว เทคโนโลยีกำลังค้นหาแอปพลิเคชันในการวิจัยทางวิทยาศาสตร์ ความร่วมมือกับ Conservation X Labs ได้นำ SAM 3 มาใช้กับชุดข้อมูล SA-FARI ซึ่งช่วยในการติดตามสัตว์ป่าโดยอัตโนมัติผ่านการแบ่งส่วนวิดีโอ กรณีการใช้งานนี้แสดงให้เห็นถึงประโยชน์ที่เป็นไปได้ของโมเดลในการประมวลผลข้อมูลวิดีโอที่ไม่ได้รับการดูแลจัดการปริมาณมากเพื่อวัตถุประสงค์ในการวิจัย

การเปิดตัวประกอบด้วยน้ำหนักโมเดล โค้ด และชุดข้อมูลการประเมินผล ซึ่งเป็นการสานต่อกลยุทธ์ของ Meta ในด้านเทคโนโลยี AI ที่สำคัญแบบโอเพ่นซอร์ส ด้วยการทำให้เครื่องมือเหล่านี้พร้อมใช้งาน Meta มุ่งหวังที่จะกำหนดมาตรฐานอุตสาหกรรมและสนับสนุนการพัฒนาเพิ่มเติมภายในชุมชน AI

งานในอนาคตจะมุ่งเน้นไปที่การปรับปรุงความสามารถของแบบจำลองในการจัดการคำถามที่ใช้เหตุผลที่ซับซ้อนโดยการรวม SAM 3 เข้ากับ Multimodal Large Language Models (MLLM) ซึ่งอาจทำให้เกิดการโต้ตอบที่ซับซ้อนยิ่งขึ้นได้