นักวิจัยที่ Tencent AI Lab ได้เปิดตัวเฟรมเวิร์ก AI ใหม่ที่ออกแบบมาเพื่อทำลายขีดจำกัดความเร็วของโมเดลภาษาขนาดใหญ่ในปัจจุบัน

ซึ่งมีรายละเอียดในบทความที่เผยแพร่ทางออนไลน์ในสัปดาห์นี้ ระบบนี้มีชื่อว่า CALM สำหรับโมเดลภาษาแบบถอยหลังอัตโนมัติต่อเนื่อง มันท้าทายโดยตรงต่อกระบวนการที่ช้าแบบโทเค็นต่อโทเค็นซึ่งขับเคลื่อน AI ที่สร้างได้มากที่สุดในปัจจุบัน

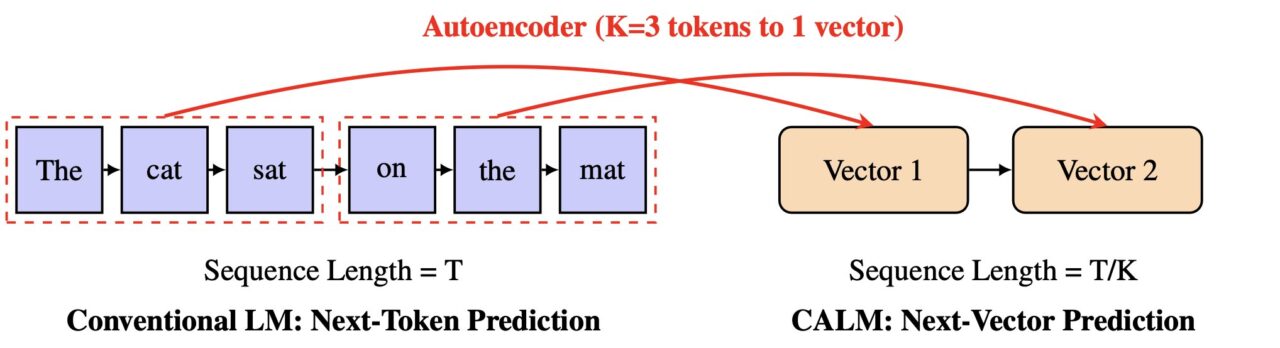

แทนที่จะคาดเดาคำเล็กๆ ทีละคำ CALM เรียนรู้ที่จะทำนายเวกเตอร์เดี่ยวที่แสดงถึงข้อความทั้งก้อน วิธีการนี้อาจทำให้การสร้าง AI เร็วขึ้นและมีประสิทธิภาพมากขึ้น โดยเป็นการเปิดเส้นทางใหม่สำหรับการปรับขนาดโมเดล

The Tyranny of the Token: Autoregressive ของ AI คอขวด

จุดอ่อนพื้นฐานของ LLM สมัยใหม่คือการพึ่งพาการสร้างโทเค็นต่อโทเค็นแบบอัตโนมัติ การพึ่งพาตามลำดับนี้เป็นคอขวดที่ใหญ่ที่สุดเพียงข้อเดียวซึ่งจำกัดความเร็วและความสามารถในการปรับขนาดของ AI

การสร้างบทความขนาดยาวต้องใช้ขั้นตอนการทำนายตามลำดับหลายพันขั้นตอน ทำให้กระบวนการในการคำนวณมีราคาแพงและช้า นี่ไม่ใช่แค่ปัญหาทางวิชาการเท่านั้น นั่นเป็นสาเหตุที่การใช้โมเดลที่มีประสิทธิภาพมีค่าใช้จ่ายสูงและการสร้างรูปแบบยาวแบบเรียลไทม์ยังคงเป็นความท้าทาย

ปัญหาด้านประสิทธิภาพนี้ได้กลายเป็นสมรภูมิสำคัญสำหรับนักพัฒนา AI ดังที่ฝ่ายวิจัยของ Google ระบุไว้ก่อนหน้านี้ “ในขณะที่เราปรับใช้โมเดลเหล่านี้กับผู้ใช้จำนวนมากขึ้น การทำให้โมเดลเหล่านี้เร็วขึ้นและถูกลงโดยไม่กระทบต่อคุณภาพถือเป็นความท้าทายที่สำคัญ”

อุตสาหกรรมได้สำรวจโซลูชันมากมาย ตั้งแต่การเก็งกำไรแบบต่อเนื่องของ Google ไปจนถึงเทคนิคการบีบอัดแบบใหม่ ขณะนี้ งานของ Tencent เสนอวิธีแก้ปัญหาที่รุนแรงยิ่งขึ้น

บทความนี้เสนอพิมพ์เขียวสำหรับโมเดลภาษาที่มีประสิทธิภาพเป็นพิเศษระดับใหม่ และปัญหาคอขวดที่เกิดจากโทเค็นในด้านความเร็ว

เป้าหมายคือการเปลี่ยนหน่วยการทำนายโดยพื้นฐานจากโทเค็นข้อมูลต่ำเพียงโทเค็นเดียวไปเป็นสิ่งที่สมบูรณ์ยิ่งขึ้น

กระบวนทัศน์ใหม่: การทำนายเวกเตอร์แทนโทเค็น

ใน ความท้าทายโดยตรงต่อสภาพที่เป็นอยู่ของ generative AI ทำให้ CALM ปรับกรอบงานการทำนายใหม่ทั้งหมด นักวิจัยเสนอแกนมาตราส่วนใหม่สำหรับ LLM

“เรายืนยันว่าการเอาชนะปัญหาคอขวดนี้จำเป็นต้องมีแกนการออกแบบใหม่สำหรับมาตราส่วน LLM นั่นคือการเพิ่มแบนด์วิดท์ความหมายของแต่ละขั้นตอนการกำเนิด”พวกเขาเขียนไว้ในรายงาน

ด้วยการเพิ่ม”แบนด์วิดท์ความหมาย”นี้ โมเดลจึงสามารถประมวลผลข้อมูลเพิ่มเติมได้ในขั้นตอนเดียว CALM บรรลุเป้าหมายนี้ผ่านกระบวนการสองขั้นตอนที่เป็นนวัตกรรมซึ่งทำงานในพื้นที่ต่อเนื่องแทนที่จะแยกจากกัน

หัวใจของการออกแบบของ CALM คือตัวเข้ารหัสอัตโนมัติที่มีความเที่ยงตรงสูง ส่วนประกอบนี้เรียนรู้ที่จะบีบอัดโทเค็น K จำนวนหนึ่ง เช่น โทเค็นสี่ตัว ให้เป็นเวกเตอร์ต่อเนื่องที่มีความหนาแน่นเพียงตัวเดียว

สิ่งสำคัญที่สุดคือ สามารถสร้างโทเค็นดั้งเดิมขึ้นใหม่จากเวกเตอร์นี้ด้วยความแม่นยำมากกว่า 99.9% จากนั้น โมเดลภาษาที่แยกออกมาจะดำเนินการทำนายแบบถดถอยอัตโนมัติในพื้นที่เวกเตอร์ใหม่นี้

ตามเอกสารประกอบอย่างเป็นทางการของโครงการ“แทนที่จะทำนายโทเค็นแยกกันทีละโทเค็น CALM เรียนรู้ที่จะทำนายเวกเตอร์ต่อเนื่องเดี่ยวที่แสดงถึงโทเค็น K ทั้งหมด”

ซึ่งจะช่วยลดจำนวนขั้นตอนการสร้าง ด้วยปัจจัย K ซึ่งนำไปสู่การเพิ่มประสิทธิภาพอย่างมีนัยสำคัญ

ชุดเครื่องมือไร้โอกาส: วิธีที่ CALM เรียนรู้และวัดความสำเร็จ

การเปลี่ยนจากโทเค็นแบบแยกไปสู่เวกเตอร์แบบต่อเนื่องทำให้เกิดความท้าทายที่สำคัญ: แบบจำลองไม่สามารถคำนวณการกระจายความน่าจะเป็นที่ชัดเจนเหนือผลลัพธ์ที่เป็นไปได้ทั้งหมดโดยใช้เลเยอร์ softmax มาตรฐาน

วิธีนี้ทำให้วิธีการฝึกอบรมและการประเมินผลแบบดั้งเดิมซึ่งต้องอาศัยการคำนวณความน่าจะเป็น ใช้ไม่ได้ เพื่อแก้ไขปัญหานี้ ทีมงาน Tencent ได้พัฒนากรอบการทำงานที่ครอบคลุมและปราศจากความเป็นไปได้

สำหรับการฝึกอบรม CALM ใช้วิธีการฝึกอบรมแบบใช้พลังงาน ซึ่งใช้กฎการให้คะแนนที่เหมาะสมอย่างเคร่งครัดเพื่อเป็นแนวทางในแบบจำลองโดยไม่จำเป็นต้องคำนวณความน่าจะเป็น

สำหรับการประเมิน นักวิจัยได้แนะนำตัวชี้วัดใหม่ที่เรียกว่า BrierLM BrierLM แตกต่างจากตัวชี้วัดแบบเดิมๆ เช่น ความฉงนสนเท่ห์ โดยได้มาจากคะแนน Brier ซึ่งเป็นเครื่องมือจากการพยากรณ์ความน่าจะเป็น

ช่วยให้สามารถเปรียบเทียบความสามารถของโมเดลตามตัวอย่างอย่างยุติธรรม โดยการตรวจสอบว่าการคาดการณ์สอดคล้องกับความเป็นจริงได้ดีเพียงใด ซึ่งเป็นวิธีการที่เหมาะสมอย่างยิ่งสำหรับแบบจำลองที่แนวโน้มไม่น่าจะเป็นไปได้

แกนใหม่สำหรับการปรับขนาด AI และการแข่งขันเพื่อประสิทธิภาพ

ผลกระทบเชิงปฏิบัติของสถาปัตยกรรมใหม่นี้คือการแลกเปลี่ยนระหว่างการประมวลผลและประสิทธิภาพที่เหนือกว่า

โมเดล CALM ลดข้อกำหนดด้านการประมวลผลเพื่อการฝึกอบรมลง 44% และการอนุมานลง 33% เมื่อเทียบกับพื้นฐานที่แข็งแกร่ง สิ่งนี้แสดงให้เห็นว่าการปรับขนาดแบนด์วิดท์ความหมายของแต่ละขั้นตอนเป็นกลไกใหม่ที่มีประสิทธิภาพในการปรับปรุงประสิทธิภาพการคำนวณ

งานวางตำแหน่ง CALM ให้เป็นคู่แข่งสำคัญในการแข่งขันทั่วทั้งอุตสาหกรรมเพื่อสร้าง AI ที่เร็วขึ้น ถูกลง และเข้าถึงได้มากขึ้น

Google ได้จัดการกับปัญหาความเร็วของ AI ด้วยวิธีการต่างๆ เช่น การเรียงซ้อนแบบเก็งกำไรและการเรียนรู้แบบซ้อน บริษัทสตาร์ทอัพอื่นๆ เช่น Inception กำลังสำรวจสถาปัตยกรรมที่แตกต่างกันอย่างสิ้นเชิง เช่น LLM ที่อิงการแพร่กระจายใน “Mercury Coder” เพื่อหลีกหนีจาก”คอขวดเชิงโครงสร้าง”ของการถดถอยอัตโนมัติ

แนวทางที่หลากหลายเหล่านี้ร่วมกันเน้นย้ำถึงการเปลี่ยนแปลงในการพัฒนา AI อุตสาหกรรมกำลังย้ายจากการมุ่งเน้นไปที่ขนาดเพียงอย่างเดียวไปสู่การแสวงหาปัญญาประดิษฐ์ที่ชาญฉลาดและประหยัดมากขึ้นอย่างยั่งยืนมากขึ้น วิธีการแบบเวกเตอร์ของ CALM นำเสนอเส้นทางใหม่ไปข้างหน้าในแนวหน้านั้น