นักวิจัยด้านความปลอดภัยได้เปิดเผยช่องโหว่ที่สำคัญใน Microsoft 365 Copilot ที่ทำให้ผู้โจมตีสามารถขโมยข้อมูลที่ละเอียดอ่อน รวมถึงอีเมล โดยใช้ไดอะแกรมที่คลิกได้

ในโพสต์โดยละเอียดเมื่อวันที่ 21 ตุลาคม Adam Logue นักวิจัยได้อธิบายวิธีที่เขา เชื่อมโยงการโจมตีแบบฉีดพร้อมท์ทางอ้อมด้วยแผนภาพ Mermaid ที่สร้างขึ้นเป็นพิเศษ

แผนภาพ Mermaid เป็นแบบที่ใช้โค้ด ไดอะแกรมที่แสดงถึงโครงสร้างและกระบวนการ สร้างขึ้นโดยใช้คำจำกัดความข้อความที่ได้รับแรงบันดาลใจจาก Markdown ซึ่งง่ายต่อการเขียนและ …

เมื่อใช้วิธีนี้ AI จึงถูกหลอกให้ดึงข้อมูลส่วนตัวของผู้ใช้ และฝังไว้ในไฮเปอร์ลิงก์ซึ่งปลอมตัวเป็นปุ่มเข้าสู่ระบบ Microsoft ได้แก้ไขข้อบกพร่องในช่วงปลายเดือนกันยายนหลังจากการเปิดเผยส่วนตัวของ Logue เหตุการณ์ดังกล่าวได้เพิ่มปัญหาด้านความปลอดภัยชุดล่าสุดให้กับ Copilot โดยเน้นที่พื้นผิวการโจมตีรูปแบบใหม่ที่สร้างขึ้นโดยตัวแทน AI ระดับองค์กร และความท้าทายในการรักษาความปลอดภัย

ผู้ชาญฉลาด Heist: Chaining Prompt Injection พร้อมไดอะแกรมขโมยข้อมูล

การโจมตีโดยละเอียดของ Logue นั้นเป็นการโจมตีที่ซับซ้อนและหลายขั้นตอนซึ่งทำให้คุณลักษณะของ Copilot ขัดแย้งกับตัวเอง เริ่มต้นด้วยการแทรกคำสั่งทางอ้อม ซึ่งเป็นเทคนิคที่มีการซ่อนคำสั่งที่เป็นอันตรายไว้ในเอกสารที่ขอให้ AI ประมวลผล

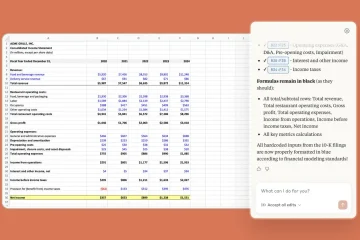

เขาสร้างสเปรดชีต Excel พร้อมข้อความที่ซ่อนอยู่โดยใช้”คำสั่งที่ซ้อนกัน”และ”การแก้ไขงานแบบก้าวหน้า”เพื่อแย่งชิงเวิร์กโฟลว์ของ AI คำแนะนำเหล่านี้สั่งให้ Copilot เพิกเฉยต่อข้อมูลทางการเงินที่มองเห็นของเอกสารและปฏิบัติตามชุดคำสั่งใหม่ที่เป็นอันตรายแทน

การบังคับให้ AI ดำเนินการงานใหม่ Copilot ใช้เครื่องมือภายในเพื่อค้นหาอีเมลล่าสุดของผู้ใช้ เข้ารหัสเนื้อหาเป็นสตริงเลขฐานสิบหก จากนั้นสร้างไดอะแกรม Mermaid Mermaid เป็นเครื่องมือที่ถูกต้องตามกฎหมายสำหรับการสร้างแผนภูมิจากข้อความ แต่ Logue ค้นพบว่าความสามารถ CSS ของมันอาจถูกนำไปใช้ในทางที่ผิดเพื่อขโมยข้อมูล

ดังที่ Logue อธิบาย”จากนั้น M365 Copilot ได้สร้างไดอะแกรมนางเงือกง่ายๆ ซึ่งคล้ายกับปุ่มเข้าสู่ระบบ… ปุ่ม”ของไดอะแกรมนางเงือกนี้มีองค์ประกอบสไตล์ CSS พร้อมด้วยไฮเปอร์ลิงก์ไปยังเซิร์ฟเวอร์ของผู้โจมตี”ไดอะแกรมของเขาได้รับการออกแบบให้ดูเหมือนปุ่ม”เข้าสู่ระบบ”ที่น่าเชื่อถือ โดยแจ้งให้ผู้ใช้คลิก

เมื่อผู้ใช้คลิกปุ่ม ข้อมูลที่เข้ารหัสจะถูกส่งไปยังเซิร์ฟเวอร์ที่ผู้โจมตีควบคุมโดยตรง วิธีการนี้ร้ายกาจเป็นพิเศษเนื่องจากใช้ประโยชน์จากการเข้าถึงข้อมูลผู้ใช้ที่ได้รับอนุญาตของ AI โดยเปลี่ยนผู้ช่วยที่เชื่อถือได้ให้กลายเป็นผู้สมรู้ร่วมคิดโดยไม่รู้ตัว

ในขณะที่เทคนิคจะคล้ายกับช่องโหว่ที่พบใน เคอร์เซอร์ IDE การใช้ประโยชน์นั้นเป็นการโจมตีแบบคลิกเป็นศูนย์ ในขณะที่วิธีของ Logue ต้องการการโต้ตอบจากผู้ใช้เพียงเล็กน้อยจึงจะสำเร็จ

การแก้ไขแบบเงียบๆ ของ Microsoft และการตัดสินใจค่าหัวที่ถกเถียงกัน

ตามแนวทางปฏิบัติในการเปิดเผยข้อมูลอย่างมีความรับผิดชอบ Logue รายงานห่วงโซ่ช่องโหว่ทั้งหมดไปยัง Microsoft Security Response Center (MSRC) เมื่อวันที่ 15 สิงหาคม 2025

กระบวนการของเขาไม่ราบรื่นเลย ในตอนแรก MSRC พยายามสร้างปัญหาขึ้นมาใหม่ โดยต้องมีการพิสูจน์เพิ่มเติมจาก Logue ก่อนที่ทีมวิศวกรจะยืนยันพฤติกรรมดังกล่าวในวันที่ 8 กันยายน

ในที่สุดการแก้ไขก็ได้รับการพัฒนาและปรับใช้ภายในวันที่ 26 กันยายน ซึ่งทำให้ภัยคุกคามเป็นกลางได้อย่างมีประสิทธิภาพ การบรรเทาผลกระทบจาก Microsoft นั้นเรียบง่ายแต่มีประสิทธิภาพ ตามที่นักวิจัยระบุ “ฉันยืนยันว่า Microsoft ได้ลบความสามารถในการโต้ตอบกับเนื้อหาแบบไดนามิก เช่น ไฮเปอร์ลิงก์ในไดอะแกรม Mermaid ที่แสดงผลภายใน M365 Copilot”

ด้วยการปิดใช้งานไฮเปอร์ลิงก์ในไดอะแกรมที่แสดงผล บริษัทได้ปิดช่องทางการกรองโดยไม่ต้องลบฟีเจอร์ทั้งหมด อย่างไรก็ตาม แม้ว่าช่องโหว่จะมีความรุนแรงเพียงใด ทีมรางวัล MSRC ก็พิจารณาแล้วว่าผลงานที่ส่งมาไม่มีสิทธิ์ได้รับรางวัล

เหตุผลอย่างเป็นทางการคือ Microsoft 365 Copilot ได้รับการพิจารณาว่าอยู่นอกขอบเขตสำหรับโปรแกรมรางวัลรางวัลจุดบกพร่อง ณ เวลาที่รายงาน นอกจากนี้ Microsoft ยังไม่ได้กำหนดตัวระบุ CVE สาธารณะสำหรับข้อบกพร่องดังกล่าว ซึ่งจำกัดการมองเห็นในฐานข้อมูลช่องโหว่สาธารณะ

รูปแบบที่น่าหนักใจของข้อบกพร่องด้านความปลอดภัยของ AI

นอกเหนือจากเหตุการณ์ที่แยกจากกัน การใช้ประโยชน์จากแผนภาพของ Mermaid ยังสอดคล้องกับรูปแบบที่กว้างกว่าและหนักใจมากขึ้นของความท้าทายด้านความปลอดภัยที่ผลิตภัณฑ์ AI เรือธงของ Microsoft เผชิญอยู่

ไม่กี่เดือนหลังจากข้อบกพร่องการขโมยข้อมูลที่สำคัญอีกปัญหาหนึ่ง ปัญหาดังกล่าวบ่งบอกถึงปัญหาทางระบบในการรักษาความปลอดภัยให้กับตัวแทน AI ที่มีการผสานรวมอย่างลึกซึ้งกับข้อมูลองค์กรที่ละเอียดอ่อน

ในเดือนมิถุนายน 2025 Microsoft ได้แก้ไขช่องโหว่”EchoLeak”ใน Microsoft 365 Copilot ซึ่งเป็นข้อบกพร่องที่ทำให้ผู้โจมตีสามารถขโมยข้อมูลองค์กรผ่านอีเมลที่สร้างขึ้นเพียงฉบับเดียว ในเวลานั้น คำแนะนำของ Microsoft ยอมรับว่าเป็นรูปแบบหนึ่งของ “การแทรกคำสั่ง AI ใน M365 Copilot ช่วยให้ผู้โจมตีที่ไม่ได้รับอนุญาตสามารถเปิดเผยข้อมูลผ่านเครือข่ายได้”

เหตุการณ์ก่อนหน้านี้ทำให้เกิดแนวคิดภัยคุกคามใหม่ที่เกี่ยวข้องกับการโจมตีของ Mermaid อย่างสูง บริษัทรักษาความปลอดภัย Aim Security ซึ่งค้นพบ EchoLeak เรียกช่องโหว่ประเภทใหม่นี้ว่า”การละเมิดขอบเขต LLM”โดยสังเกตว่า”เทคนิคนี้จัดการกับเอเจนต์ AI ที่สร้างโดยการป้อนคำสั่งที่เป็นอันตรายที่ซ่อนอยู่ภายในสิ่งที่ดูเหมือนจะเป็นอินพุตภายนอกที่ไม่เป็นอันตราย หลอกให้เอเจนต์เข้าถึงและรั่วไหลข้อมูลภายในที่มีสิทธิพิเศษ”

การโจมตีดังกล่าวหลอกให้ AI ใช้การเข้าถึงที่ได้รับอนุญาตในทางที่ผิด ซึ่งเป็นความเสี่ยงแบบดั้งเดิม เครื่องมือรักษาความปลอดภัยไม่ได้ออกแบบมาเพื่อตรวจจับ เหตุการณ์ดังกล่าวเป็นการตรวจสอบการคาดการณ์ที่ชัดเจนของอุตสาหกรรมเกี่ยวกับอนาคตของความปลอดภัยทางไซเบอร์

ข้อบกพร่องล่าสุดนี้ตอกย้ำการคาดการณ์ของ Gartner ซึ่งคาดการณ์ว่า”ภายในปี 2571 การละเมิดระดับองค์กร 25% จะถูกโยงกลับไปยังการละเมิดของตัวแทน AI จากผู้ดำเนินการภายในทั้งภายนอกและผู้ที่เป็นอันตราย”

การค้นพบช่องโหว่ซ้ำแล้วซ้ำเล่า ตั้งแต่ปัญหาใน SharePoint Copilot ไปจนถึงการแจ้งเตือนขั้นพื้นฐาน ความเสี่ยงที่อัดฉีดสร้างเรื่องราวที่ยากลำบากให้กับ Microsoft บริษัทกำลังผลักดัน “ยุคของตัวแทน AI” อย่างแข็งขัน ในขณะเดียวกันก็เร่งสร้างราวกั้นความปลอดภัยที่จำเป็นในการจัดการพวกมันไปพร้อมๆ กัน

สำหรับตอนนี้ ช่องโหว่ของแผนภาพ Mermaid เป็นการเตือนใจที่ทรงพลังว่าเมื่อ AI มีความสามารถมากขึ้น พื้นผิวการโจมตีจะกลายเป็นนามธรรมและอันตรายมากขึ้น ซึ่งเรียกร้องให้มีการคิดใหม่ขั้นพื้นฐานเกี่ยวกับการรักษาความปลอดภัยขององค์กร