AMD ประกาศเมื่อวันอังคารว่าฮาร์ดแวร์ใหม่ล่าสุดรองรับโมเดล `GPT-OSS’ใหม่ของ OpenAI การสนับสนุนสำหรับผลิตภัณฑ์อุปโภคบริโภคล่าสุดเช่น Ryzen AI Chips และ Radeon Graphics Cards ในคีย์แรก AMD กล่าวว่าชิป Ryzen AI Max+ 395 สามารถเรียกใช้โมเดลพารามิเตอร์ขนาดใหญ่ 120 พันล้านบนพีซีท้องถิ่น

สิ่งนี้นำ AI ระดับบนออกจากคลาวด์และเข้าสู่คอมพิวเตอร์ที่บ้าน การเปลี่ยนแปลงช่วยให้แอพ AI ที่เร็วขึ้นเป็นส่วนตัวมากขึ้นและออฟไลน์ นักพัฒนาสามารถใช้เครื่องมือ LM Studio เพื่อเรียกใช้โมเดลในวันนี้ทำให้ AI ที่ทรงพลังเข้าถึงได้ง่ายขึ้น

AMD อ้างว่าผู้บริโภคก่อนสำหรับ AI ในอุปกรณ์ AI

href=”https://www.amd.com/en/blogs/2025/how-to-run-openai-gpt-oss-20b-120b-models-on-amd-ryzen-ai-radeon.html”target=”blank”บริษัท ประกาศโปรเซสเซอร์ Ryzen AI Max+ 395 เมื่อกำหนดค่าด้วย RAM 128GB เป็นชิปผู้บริโภครายแรกที่สามารถใช้งานพารามิเตอร์ขนาดใหญ่ 117 พันล้านของ OpenAI ของ OpenAI `GPT-OSS-120B` รุ่น

src=”https://winbuzzer.com/wp-content/uploads/2025/08/amd-openai-parntership.jpg”>

นี่เป็นเหตุการณ์สำคัญที่สำคัญ มันเปลี่ยนเวิร์กโหลด AI DataCenter-Class จากคลาวด์เป็นเดสก์ท็อปหรือแล็ปท็อป จากข้อมูลของ AMD ระบบนี้ได้รับประสิทธิภาพสูงสุดถึง 30 โทเค็นต่อวินาทีทำให้ AI ในท้องถิ่นที่ซับซ้อนเป็นจริงสำหรับนักพัฒนาและนักวิจัย

[เนื้อหาฝังตัว]

ข้อกำหนดทางเทคนิคนั้นสูงชัน แต่บอก โมเดล `GPT-OSS-120B` ต้องการ VRAM ประมาณ 61GB ซึ่งเหมาะกับหน่วยความจำกราฟิกเฉพาะ 96GB ที่มีอยู่บนแพลตฟอร์ม Ryzen AI Max+ 395 พิเศษความสามารถ amd เมื่อเร็ว ๆ นี้ได้เน้น .

สำหรับผู้ที่ทำงานกับรุ่นที่มีขนาดเล็กกว่า บริษัท เน้นถึงเวลาที่ยอดเยี่ยมในการฝึกหัด (TTFT) ซึ่งช่วยให้มั่นใจถึงประสิทธิภาพการตอบสนองสำหรับเวิร์กโฟลว์ตัวแทนที่ต้องพึ่งพาผลลัพธ์เริ่มต้นอย่างรวดเร็ว

[เนื้อหาที่ฝังอยู่]

การเปิดใช้งานฮาร์ดแวร์นี้เป็นส่วนหนึ่งของการเปิดตัวแบบเปิดตัว พวกเขาเป็นตัวแทนของคำหมุนเชิงกลยุทธ์สำหรับ Openai.

โมเดลถูกสร้างขึ้นบนสถาปัตยกรรมผสมผสานที่มีประสิทธิภาพ (MOE) การออกแบบนี้เปิดใช้งานเพียงเศษเสี้ยวของพารามิเตอร์ทั้งหมดสำหรับงานที่กำหนดใด ๆ ลดค่าใช้จ่ายในการคำนวณอย่างมากและทำให้พวกเขาทำงานได้อย่างรุนแรง

ชิ้นส่วนที่สำคัญของระบบนิเวศใหม่นี้คือ’Harmony’รูปแบบการแชทที่บังคับใช้ เทมเพลตนี้จัดโครงสร้างเอาต์พุตของโมเดลออกเป็นช่องทางแยกต่างหากสำหรับการใช้เหตุผลการใช้เครื่องมือและคำตอบสุดท้ายทำให้นักพัฒนาควบคุมการควบคุมโปร่งใสมากขึ้น

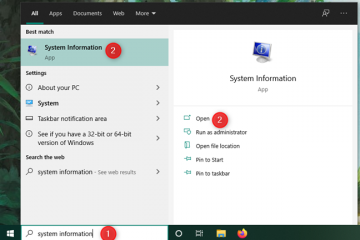

วิธีเรียกใช้ AI ดาต้าเซ็นเตอร์ระดับบนโต๊ะทำงานของคุณวันนี้

href=”https://rocm.blogs.amd.com/developer-guides/2025/08/05/day-0-developer-guide-running-the-latest-open-models-from-openai-on-amd-amd-ai-hardware.html”เครื่องมือหลักคือ LM Studio ซึ่งเป็นแอปพลิเคชั่นฟรีที่ทำให้การดาวน์โหลดและเรียกใช้ LLMS ง่ายขึ้น ผู้ใช้ยังต้องติดตั้ง amd ซอฟต์แวร์: adrenalin editions (เวอร์ชัน 25.8.1 หรือสูงกว่า) การปิดเลเยอร์การคำนวณทั้งหมดไปยัง GPU จากนั้นโหลดโมเดลลงในหน่วยความจำ ในขณะที่รุ่น 120B อาจใช้เวลาในการโหลดเนื่องจากขนาดของมันผลที่ได้คือเอ็นจิ้นที่ให้เหตุผลที่ทรงพลังทำงานได้อย่างสมบูรณ์ในพื้นที่ทั้งหมด

การเปิดตัวที่ประสานงานกันเพื่อสร้างมาตรฐานเปิดใหม่

การประกาศของ AMD ไม่ได้เกิดขึ้นในสูญญากาศ มันเป็นส่วนสำคัญของเหตุการณ์ทั่วทั้งอุตสาหกรรมที่จัดทำขึ้นอย่างรอบคอบซึ่งออกแบบมาเพื่อสร้าง `GPT-OSS` และ Harmony เป็นมาตรฐานใหม่ Microsoft เปิดตัว Windows AI Foundry และ Foundry Local Platforms เพื่อเรียกใช้โมเดลบน Windows และ MacOS

ในการเคลื่อนไหวที่น่าประหลาดใจของ“ Co-Opetition” AWS ประกาศว่าจะนำเสนอรุ่นบนถนน Amazon และ Sagemaker Qualcomm ยังเข้าร่วมเพื่อเปิดใช้งานการสนับสนุนอุปกรณ์สำหรับพีซีที่ขับเคลื่อนด้วย Snapdragon

การสนับสนุนในวงกว้างนี้ส่งสัญญาณการผลักดันเชิงกลยุทธ์โดย OpenAI เพื่อเรียกคืนอิทธิพลในชุมชนโอเพนซอร์ซ นักวิเคราะห์แนะนำว่า“ ในส่วนนี้เป็นเรื่องเกี่ยวกับการยืนยันการครอบงำของ Openai ในระบบนิเวศการวิจัย” ความเชื่อมั่นนี้สะท้อนออกมาในการวางกรอบของ Openai โดย บริษัท ระบุว่า“ การเข้าถึงแบบเปิดกว้างที่มีความสามารถเหล่านี้ที่สร้างขึ้นในสหรัฐอเมริกาช่วยขยายราง AI ของพรรคประชาธิปัตย์”

การย้ายตำแหน่ง Openai ด้วยการจัดหาโมเดลที่ทรงพลังเข้าถึงได้และได้รับการสนับสนุนอย่างกว้างขวาง บริษัท กำลังสร้างกรณีที่น่าสนใจสำหรับระบบนิเวศ ดังที่ Asha Sharma ของ Microsoft กล่าวไว้ว่า“ เป็นครั้งแรกที่คุณสามารถเรียกใช้โมเดล OpenAI เช่น GPT-OSS-1220B ใน GPU องค์กรเดียว-หรือเรียกใช้ GPT-OSS-20B ในพื้นที่” เน้นความเป็นจริงไฮบริด AI ใหม่