อัลกอริธึมของ Meta ในการระบุเนื้อหาที่เป็นอันตรายทำเครื่องหมายพันธกิจของตนอย่างผิดพลาด โดย”ทำให้โลกอยู่ใกล้กันมากขึ้น”ซึ่งแสดงให้เห็นถึงความสัมพันธ์ที่สูงมากระหว่าง”Meta”และแนวคิดของ”องค์กรก่อการร้าย”

เหตุการณ์ดังกล่าวนำไปสู่การไล่ออกอย่างรวดเร็วของ Sebastian Carlos พนักงานใหม่ที่ได้รับมอบหมายให้ยกเครื่องอัลกอริทึม ทำให้เกิดคำถามด้านจริยธรรมและทางเทคนิคเกี่ยวกับบทบาทของ AI ในการกลั่นกรองเนื้อหา ในขณะที่เขาเล่า ในบล็อกโพสต์.

การยกเครื่องการกลั่นกรองเนื้อหาใหม่อย่างกล้าหาญ

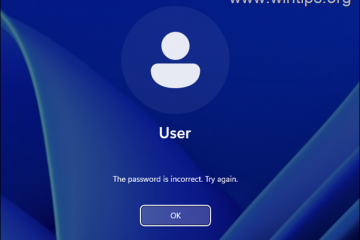

ความขัดแย้งเริ่มต้นขึ้นเมื่อผู้พัฒนา Sebastian Carlos เข้าร่วมทีม”Harmful Content Detection”ของ Meta ในสัปดาห์แรกของเขา ในฐานะพนักงานใหม่ มอบหมายให้ปรับปรุงประสิทธิภาพและความแม่นยำของระบบกลั่นกรองเนื้อหาของ Meta โดยระบุข้อบกพร่องที่สำคัญในอัลกอริทึมที่มีอยู่

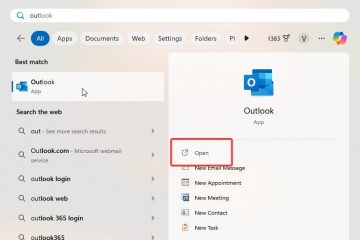

Carlos เสนอการเขียนใหม่ที่รุนแรงโดยใช้ Prolog ซึ่งเป็นภาษาโปรแกรมที่มีชื่อเสียงในด้านความสามารถในการจัดการการใช้เหตุผลเชิงสัญลักษณ์และความสัมพันธ์ที่ซับซ้อน ลักษณะการประกาศของ Prolog ทำให้เหมาะสมอย่างยิ่งในการวิเคราะห์คำจำกัดความที่เหมาะสมของเนื้อหาที่เป็นอันตราย

เพื่อเสริมสร้างความเข้าใจตามบริบทของอัลกอริทึม การยกเครื่องใหม่ได้รวมชุดข้อมูลที่หลากหลาย รวมถึง Wikipedia ข้อความทางศาสนา และสารานุกรม ด้วยแนวทางแบบหลายแง่มุมนี้ Carlos มุ่งหวังที่จะรับประกันความครอบคลุมทางวัฒนธรรมและบริบท อย่างไรก็ตาม วิธีการนี้ยังต้องใช้ทรัพยากรการคำนวณที่กว้างขวางอีกด้วย

ที่เกี่ยวข้อง: การเคลื่อนไหวของ Zuckerberg เพื่อหยุดการตรวจสอบข้อเท็จจริงได้รับการยกย่องจาก Trump และ Musk นักวิจารณ์ต่างตกตะลึง

Carlos อธิบายว่าการวัดต้นทุนภายในของ Meta เรียกอย่างตลกขบขันว่า”ปีกัวเตมาลา”(เทียบเท่ากับ GDP ของกัวเตมาลา) ถูกนำมาใช้เพื่อพิสูจน์ค่าใช้จ่ายในการคำนวณ

อัลกอริทึมที่ปรับปรุงใหม่ได้รับการออกแบบเพื่อประมวลผลคนนับล้าน ของโพสต์ทุกวัน โดยวิเคราะห์เนื้อหาเทียบกับโทโพโลยีทางศีลธรรมที่มีรายละเอียดสูง ตามที่ Carlos กล่าว เป้าหมายคือการสร้างระบบที่เป็นกลางซึ่งสามารถจัดหมวดหมู่เนื้อหาที่เป็นอันตรายได้อย่างถูกต้อง เขารับรองว่าระบบจะทำงานโดยไม่มีอคติและดำเนินการตามกฎเกณฑ์อย่างเคร่งครัด โปรแกรมให้ติดตาม

เมื่อ AI หันเข้ามา

ในระหว่างการทดสอบหลักครั้งแรก อัลกอริธึมที่อัปเดตจะทำเครื่องหมายพันธกิจของ Meta ว่าเป็นเนื้อหาที่เป็นอันตราย

การดีบักไม่พบข้อผิดพลาดในตรรกะ แต่การวิเคราะห์ขั้นสูงของระบบระบุถึงความสัมพันธ์ที่สูงระหว่างคำว่า”Meta”และวลีที่เกี่ยวข้องกับ”การก่อการร้าย”และ”การเข้าถึงข้อมูลขององค์กรมากเกินไป”ผลลัพธ์ที่ไม่คาดคิดเน้นย้ำถึงความท้าทายในการฝึกอบรมระบบ AI เพื่อนำทางแนวคิดที่คลุมเครือ เช่น คุณธรรมและอันตราย

ดังที่ Carlos เขียน ข้อความที่ถูกตั้งค่าสถานะกระตุ้นให้เกิดการอภิปรายภายในทันที วิศวกรบางคนชื่นชมความเข้มงวดของอัลกอริทึม ในขณะที่บางคนกังวลเกี่ยวกับผลเสียจากการประชาสัมพันธ์ที่อาจเกิดขึ้น มีรายงานว่าผู้จัดการอาวุโสคนหนึ่งบอกกับ Carlos ว่า “ดูสิ นี่เป็น… น่าประทับใจ แต่เราไม่สามารถบรรลุ OKR ของเราแบบนี้ได้” โดยเน้นถึงความตึงเครียดและการแบ่งแยกที่เพิ่มมากขึ้นระหว่างความแม่นยำทางเทคนิคและลำดับความสำคัญขององค์กร

The Fallout: จริยธรรมและ NDA

เหตุการณ์ดังกล่าวรุนแรงขึ้นเมื่อ Carlos นำเสนอสิ่งที่ค้นพบในระหว่างการประชุมทีม แม้จะแสดงให้เห็นถึงตรรกะเบื้องหลังการตัดสินใจของอัลกอริทึม แต่งานของพนักงานก็พบกับการต่อต้าน หลังจากนั้นไม่นาน เขาถูกไล่ออกและขอให้ลงนามใน “NDA สองเท่า” ซึ่งเป็นกลไกทางกฎหมายที่ไม่ชัดเจนซึ่งออกแบบมาเพื่อบังคับใช้การรักษาความลับที่เข้มงวด

A NDA สองเท่า หรือที่เรียกว่า NDA ทวิภาคีหรือร่วมกัน NDA เป็นข้อตกลงที่มีผลผูกพันทางกฎหมายซึ่งทั้งสองฝ่ายที่เกี่ยวข้องจะเปิดเผยข้อมูลที่เป็นความลับแก่กันและกัน และตกลงที่จะปกป้องข้อมูลนั้นจากการเปิดเผยเพิ่มเติม

Carlos เขียนว่าทนายความของเขาแนะนำว่าข้อตกลงดังกล่าวอาจทำให้กันและกันเป็นโมฆะ โดยอนุญาตให้พนักงานหารือเกี่ยวกับประสบการณ์ของพวกเขาในที่สาธารณะ เมื่อพิจารณาถึงการเลิกจ้างของเขา เขาเขียนว่า”เมื่อพิจารณาว่าพวกเขาไล่ฉันออกเนื่องจากบอกความจริงบางอย่าง ฉันคิดว่าฉันเป็นหนี้อินเทอร์เน็ตในเรื่องราวทั้งหมด”

บทบาทของ AI ในการกลั่นกรอง

เครื่องมือกลั่นกรองเนื้อหาของ Meta เป็นส่วนสำคัญในการจัดการเนื้อหาจำนวนมหาศาลที่ผู้ใช้สร้างขึ้นบนแพลตฟอร์ม การพึ่งพา AI ของบริษัทเป็นทั้งความจำเป็นและแหล่งที่มาของความขัดแย้ง นักวิจารณ์ชี้ไปที่กรณีของการเข้าถึงเนื้อหาที่เป็นอันตรายมากเกินไปหรือไม่เพียงพอ

เหตุการณ์ดังกล่าวเพิ่มการตรวจสอบข้อเท็จจริง ทำให้เกิดคำถามเกี่ยวกับความโปร่งใสและความรับผิดชอบในการตัดสินใจของ AI นักวิจารณ์ของ Meta ในอีกด้านหนึ่งอาจตีความได้ว่า สัญญาณของประสิทธิภาพของอัลกอริธึม

แนวทางปฏิบัติของ Meta และอคติทางอุดมการณ์อาจคล้ายคลึงกับองค์กรก่อการร้ายและอัลกอริธึมนั้นถูกต้องเฉพาะเจาะจงใช่หรือไม่ หากไม่มีรายละเอียดทางเทคนิคเท่านั้น เดาสิ แต่สำหรับ Carlos ผลลัพธ์นี้ได้ยุติการเริ่มต้นที่ลำบากอยู่แล้วที่บริษัท

ดังที่ Carlos เขียนไว้ แว่นตาเสริมความเป็นจริงของ Meta ถูกใช้ในระหว่างกระบวนการสัมภาษณ์ของเขา เมื่อนักพัฒนาที่เกี่ยวข้องอาศัยแว่นตาเหล่านั้น แก้ปัญหาความท้าทายในการเขียนโค้ด แก้ไขและปรับปรุงโซลูชันที่เสนอโดย Carlos จากนั้นเขาก็เผชิญหน้ากับผู้สัมภาษณ์พร้อมกับสิ่งที่เขาค้นพบ และใช้เหตุการณ์นี้เพื่อต่อรองเงินเดือนที่สูงขึ้นเมื่อเริ่มต้นที่ Meta และแบล็กเมล์เขาจริงๆ

นอกเหนือจากเรื่องราวข้างเคียงนี้ ประสบการณ์ของ Carlos ยังให้ความสำคัญกับผลที่ตามมาโดยไม่ได้ตั้งใจ ของระบบ AI และเน้นย้ำถึงความยากลำบากของอัลกอริธึมการเขียนโปรแกรมเพื่อทำความเข้าใจและประยุกต์ใช้แนวคิดที่ซับซ้อนของมนุษย์ เช่น อันตราย ศีลธรรม และความปลอดภัย

พันธกิจที่ถูกตั้งค่าสถานะอาจมีความผิดปกติหรือตรงกันทุกประการ ไม่ว่าในกรณีใด Meta จะไม่เจาะลึกเรื่องนี้อย่างแน่นอน