Sam Altman ซีอีโอของ OpenAI และ Greg Brockman ผู้ร่วมก่อตั้งและปัจจุบันเป็นประธานของ OpenAI ได้กล่าวถึงข้อกังวลเกี่ยวกับความปลอดภัยของ AI หลังจากการลาออกของ Jan Leike พวกเขาตอกย้ำความมุ่งมั่นของ OpenAI ที่จะทดสอบอย่างเข้มงวด ให้ข้อเสนอแนะอย่างต่อเนื่อง และความร่วมมือกับรัฐบาลและผู้มีส่วนได้ส่วนเสียเพื่อให้มั่นใจถึงระเบียบการด้านความปลอดภัยที่แข็งแกร่ง

การเปลี่ยนแปลงของผู้นำและข้อกังวลด้านความปลอดภัย

ม.ค. Leike ผู้ร่วมเป็นผู้นำทีม Superalignment ร่วมกับ Ilya Sutskever ลาออกหลังจากแสดงความกังวลว่าความปลอดภัยถูกกีดกันเนื่องจากความก้าวหน้าอย่างรวดเร็ว การจากไปของทั้ง Leike และ Sutskever ได้เน้นย้ำถึงความขัดแย้งภายในในเรื่องการจัดลำดับความสำคัญของความปลอดภัยและนวัตกรรม ทีม Superalignment ซึ่งก่อตั้งขึ้นเมื่อไม่ถึงปีที่แล้ว ได้รับมอบหมายให้สำรวจวิธีต่างๆ ในการจัดการ AI ที่ชาญฉลาด

Jan Leike ในกระทู้บน X (ชื่อเดิมคือ Twitter) อธิบายว่าเขาไม่เห็นด้วยกับความเป็นผู้นำของบริษัท เกี่ยวกับ”ลำดับความสำคัญหลัก”ใน”ระยะเวลาหนึ่ง”ซึ่งนำไปสู่ ”จุดแตกหัก”Leike กล่าวว่า”วัฒนธรรมและกระบวนการด้านความปลอดภัยของ OpenAI ได้นำเบาะหลังไปสู่ผลิตภัณฑ์ที่แวววาว”ในช่วงไม่กี่ปีที่ผ่านมา และทีมงานของเขาพยายามดิ้นรนเพื่อให้ได้มาซึ่งสิ่งที่จำเป็น แหล่งข้อมูลสำหรับงานด้านความปลอดภัย

Altman ตอบกลับเป็นคำตอบสั้นๆ ก่อน ไปยังโพสต์ของ Leike เมื่อวันศุกร์ โดยยอมรับว่า OpenAI มี”สิ่งที่ต้องทำอีกมาก”และ”มุ่งมั่นที่จะทำ”โดยสัญญาว่าจะมีการโพสต์ที่ยาวกว่านี้ในเร็วๆ นี้ เมื่อวันเสาร์ Brockman โพสต์คำตอบร่วมกันจากทั้งตัวเขาเองและ Altman ใน X โดยแสดงความขอบคุณต่องานของ Leike และตอบคำถามหลังจากการลาออก

เรารู้สึกขอบคุณ Jan จริงๆ สำหรับทุกสิ่งที่เขาทำเพื่อ OpenAI และเรารู้ว่าเขาจะมีส่วนร่วมในภารกิจจากภายนอกต่อไป เมื่อพิจารณาจากคำถามที่เขาจากไป เราต้องการอธิบายเล็กน้อยเกี่ยวกับวิธีคิดของเราเกี่ยวกับกลยุทธ์โดยรวมของเรา

ก่อนอื่น เรามี… https://t.co/djlcqEiLLN

— เกร็ก บร็อคแมน (@gdb) 18 พฤษภาคม 2024

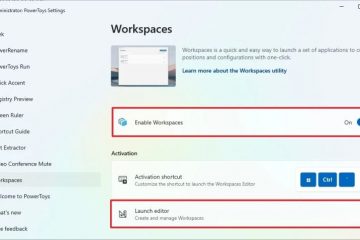

Brockman และ Altman เน้นย้ำว่า OpenAI ได้”แสดงให้เห็นซ้ำแล้วซ้ำเล่าถึงความเป็นไปได้อันเหลือเชื่อจากการขยายขนาดการเรียนรู้เชิงลึกและวิเคราะห์ผลกระทบ”และ เรียกร้องให้มีธรรมาภิบาลระดับสากลด้านปัญญาประดิษฐ์ทั่วไป (AGI) ก่อนที่จะได้รับความนิยม พวกเขาอ้างถึงกรอบการเตรียมความพร้อมของบริษัท ซึ่งคาดการณ์”ความเสี่ยงจากภัยพิบัติ”และพยายามบรรเทาความเสี่ยงดังกล่าว เพื่อเป็นแนวทางในการยกระดับงานด้านความปลอดภัย

ในคำแถลงโดยละเอียด อัลท์แมนและบร็อคแมนรับทราบถึงความซับซ้อนในการรับรองว่าเทคโนโลยีใหม่มีความปลอดภัย และได้สรุปแนวทางด้านความปลอดภัยของ AI พวกเขาเน้นย้ำถึงความพยายามของ OpenAI ในการสร้างความตระหนักรู้เกี่ยวกับความเสี่ยงและโอกาสของ AGI, สนับสนุนการกำกับดูแลระหว่างประเทศ และพัฒนาวิธีในการประเมินระบบ AI สำหรับความเสี่ยงที่เป็นหายนะ พวกเขายังชี้ให้เห็นถึงการทำงานที่ครอบคลุมในการใช้งาน GPT-4 อย่างปลอดภัย และการปรับปรุงอย่างต่อเนื่องตามความคิดเห็นของผู้ใช้

ทิศทางในอนาคตและการวิจัยด้านความปลอดภัย

กำลังมองหา ข้างหน้า Altman และ Brockman คาดหวังว่าโมเดล AI ในอนาคตจะถูกรวมเข้ากับแอปพลิเคชันในโลกแห่งความเป็นจริงมากขึ้น และสามารถทำงานในนามของผู้ใช้ได้ พวกเขาเชื่อว่าระบบเหล่านี้จะให้ประโยชน์มากมาย แต่จะต้องมีการทำงานพื้นฐาน รวมถึงการกำกับดูแลที่ปรับขนาดได้ และการพิจารณาข้อมูลการฝึกอบรมอย่างรอบคอบ พวกเขาเน้นย้ำถึงความสำคัญของการรักษามาตรฐานความปลอดภัยระดับสูง แม้ว่าจะต้องชะลอกำหนดเวลาการปลดปล่อยก็ตาม

Altman และ Brockman สรุปโดยระบุว่าไม่มีแนวทางที่กำหนดไว้สำหรับการนำทางไปยัง AGI พวกเขาเชื่อว่าความเข้าใจเชิงประจักษ์จะเป็นแนวทางในการก้าวไปข้างหน้า และมุ่งมั่นที่จะสร้างสมดุลระหว่างผลประโยชน์ที่อาจเกิดขึ้นกับการลดความเสี่ยงร้ายแรง พวกเขายืนยันอีกครั้งถึงความมุ่งมั่นในการวิจัยด้านความปลอดภัยในช่วงเวลาต่างๆ และความร่วมมืออย่างต่อเนื่องกับรัฐบาลและผู้มีส่วนได้ส่วนเสีย