Kuaishou ซึ่งเป็นแพลตฟอร์มวิดีโอสั้นที่โดดเด่นในปักกิ่ง เปิดตัวโมเดลภาษาขนาดใหญ่ที่พัฒนาขึ้นเองในชื่อ KwaiYii ต่อสาธารณะเมื่อสัปดาห์ที่แล้ว ตามข้อมูลของ รายงานจาก TechNode นอกจากนี้ บริษัทยังเปิดเผยงานวิจัยเกี่ยวกับ Spiking Neural Networks และการพัฒนา SpikeGPT

การเปิดตัวนี้เกิดขึ้นหลังจากช่วงทดสอบเบต้า สำหรับบริการคล้าย ChatGPT สำหรับอุปกรณ์ Android ที่เริ่มเมื่อวันที่ 18 สิงหาคม บริการโต้ตอบซึ่งมีพารามิเตอร์ 13,000 ล้านตัวที่หยั่งรากใน KwaiYii เป็นคู่แข่งกับ OpenAI GPT-3.5 ในแง่ของความสามารถในการสร้างเนื้อหา การให้คำปรึกษา และการแก้ปัญหา

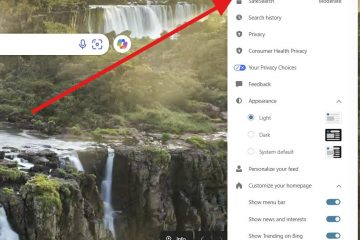

รายละเอียด LLM อยู่ในหน้า GitHub ของ KwaiYii แอปพลิเคชันหลักสำหรับแชทบอท AI ของ Kuaishou ได้รับการค้นหา โดยใช้เนื้อหาต้นฉบับจากแพลตฟอร์มเพื่อจัดการกับ”ภาพหลอน”ของ AI ซึ่งเป็นความไม่ถูกต้องที่เป็นผลมาจากการฝึกอบรมข้อมูลไม่เพียงพอ

SpikeGPT: ก้าวกระโดดในประสิทธิภาพพลังงาน

Kuaishou วางตำแหน่งตัวเองเป็นกำลังสำคัญใน การวิจัยและพัฒนา AI ทั้งในผลิตภัณฑ์กระแสหลักสาธารณะและโครงการ R&D KwaiYii เป็นตัวอย่างของ AI สาธารณะกระแสหลัก ในขณะที่ Kuaishou ยังได้กล่าวถึง SpikeGPT ซึ่งเป็นตัวอย่างของความพยายามในการวิจัย AI

ความต้องการด้านการคำนวณ ของโมเดลภาษาขนาดใหญ่ร่วมสมัย (LLM) เป็นจำนวนมาก อย่างไรก็ตาม Spiking Neural Networks (SNNs) ได้รับการระบุว่าเป็นพลังงานที่มากกว่า-ทางเลือกที่มีประสิทธิภาพสำหรับเครือข่ายประสาทเทียมทั่วไป แม้ว่าประสิทธิภาพของงานในการสร้างภาษาจะไม่จดที่แผนที่ก็ตาม

ความร่วมมือด้านการวิจัยระหว่างมหาวิทยาลัยแห่งแคลิฟอร์เนียและ Kuaishou Technology ได้เปิดตัว SpikeGPT (ผ่าน รีวิวแบบซิงค์) การเปิดตัวครั้งแรก โมเดลภาษาเครือข่ายประสาทเทียม (SNN) กำเนิด โมเดลนี้ซึ่งมีเวอร์ชันพารามิเตอร์ 260M ตรงกับประสิทธิภาพของ

SpikeGPT เป็นโมเดลภาษาเชิงกำเนิดที่โดดเด่นด้วยหน่วยการเปิดใช้งานแบบสไปค์แบบไบนารีที่ขับเคลื่อนด้วยเหตุการณ์ รวมการเกิดซ้ำเข้ากับบล็อกหม้อแปลงทำให้เข้ากันได้กับ SNN การผสานรวมนี้ไม่เพียงแต่ขจัดความซับซ้อนของการคำนวณกำลังสองเท่านั้น แต่ยังอำนวยความสะดวกในการแสดงคำเป็นหนามแหลมตามเหตุการณ์ แบบจำลองสามารถประมวลผลการสตรีมข้อมูลแบบคำต่อคำ เริ่มต้นการคำนวณก่อนที่จะสร้างประโยคที่สมบูรณ์ ในขณะที่ยังคงจับภาพการพึ่งพาระยะยาวในโครงสร้างวากยสัมพันธ์ที่ซับซ้อน ทีมวิจัยยังได้รวมเทคนิคต่างๆ เพื่อเพิ่มประสิทธิภาพการทำงานของ SpikeGPT เช่น ขั้นตอนการฝังแบบไบนารี ตัวดำเนินการเปลี่ยนโทเค็น และวานิลลา RWKV เพื่อแทนที่กลไกการให้ความสนใจตนเองแบบเดิม โครงข่ายประสาทเทียมที่พุ่งสูงขึ้น (SNNs) เป็นโครงข่ายประสาทเทียมประเภทหนึ่งที่ได้รับแรงบันดาลใจจากวิธีการทำงานของเซลล์ประสาททางชีวภาพ ใน SNNs เซลล์ประสาทสื่อสารกันโดยการส่งสัญญาณแหลม ซึ่งเป็นกิจกรรมทางไฟฟ้าสั้นๆ หนามแหลมไม่ต่อเนื่อง แต่เกิดขึ้นในช่วงเวลาที่ไม่ต่อเนื่องกัน สิ่งนี้ตรงกันข้ามกับเครือข่ายประสาทเทียมแบบดั้งเดิมซึ่งใช้ค่าต่อเนื่องเพื่อแสดงการเปิดใช้งานของเซลล์ประสาท SNN มีข้อได้เปรียบหลายประการเหนือเครือข่ายประสาทเทียมแบบดั้งเดิม อย่างแรกคือประหยัดพลังงานมากกว่า นี่เป็นเพราะหนามจะถูกส่งเมื่อจำเป็นเท่านั้นแทนที่จะส่งอย่างต่อเนื่อง ประการที่สอง SNN มีความสมจริงทางชีววิทยามากกว่า ทำให้เป็นตัวเลือกที่ดีสำหรับการใช้งานที่ต้องการความสมจริงระดับสูง เช่น หุ่นยนต์และภาพทางการแพทย์ อย่างไรก็ตาม SNN ก็มีความท้าทายเช่นกัน ความท้าทายประการหนึ่งคือการฝึกฝนได้ยากกว่าเครือข่ายประสาทเทียมแบบดั้งเดิม นี่เป็นเพราะสไปค์เป็นเหตุการณ์ที่ไม่ต่อเนื่อง ซึ่งทำให้ยากต่อการเผยแพร่ข้อผิดพลาดผ่านเครือข่าย ความท้าทายอีกประการหนึ่งคือ SNN ไม่เข้าใจดีเท่าเครือข่ายประสาทเทียมแบบดั้งเดิม ทำให้การออกแบบและเพิ่มประสิทธิภาพ SNN สำหรับงานเฉพาะนั้นทำได้ยาก ในการศึกษาเชิงประจักษ์ SpikeGPT ได้รับการฝึกด้วยมาตราส่วนพารามิเตอร์ที่แตกต่างกันสามแบบ (พารามิเตอร์ 45M, 125M และ 260M) และได้รับการวัดประสิทธิภาพเทียบกับเส้นฐานของหม้อแปลง เช่น Reformer, Synthesizer, Linear Transformer และ Performer โดยใช้ชุดข้อมูล Enwik8 ผลการวิจัยพบว่า SpikeGPT ให้ผลลัพธ์ที่เทียบเคียงได้กับการดำเนินการ synaptic (SynOps) ที่น้อยลง 22 เท่า งานวิจัยนี้เน้นย้ำถึงศักยภาพของการฝึกอบรม SNN ขนาดใหญ่เพื่อใช้ประโยชน์จากความก้าวหน้าในหม้อแปลง ซึ่งบ่งชี้ว่าความต้องการด้านการคำนวณของ LLMs ลดลงอย่างมาก โดยใช้การเปิดใช้งานแบบเร่งความเร็วตามเหตุการณ์กับการสร้างภาษา นักวิจัยได้แสดงเจตจำนงในการปรับแต่งโมเดลต่อไปและจะปรับปรุงกระดาษพิมพ์ล่วงหน้าตามนั้น รหัสสำหรับ SpikeGPT คือ มีอยู่ใน GitHub ของโครงการ และ กระดาษรายละเอียดโมเดลสามารถเข้าถึงได้บน arXivทำความเข้าใจเกี่ยวกับ Spike โครงข่ายประสาทเทียม

วิธีการทำงานของ SpikeGPT