การวิเคราะห์ล่าสุดเปิดเผยว่า Nvidia ได้รับผลกำไรเกือบ 1,000% จาก H100 Tensor Core GPU ทุกตัวที่จำหน่าย ข้อมูลเชิงลึกทางการเงินจาก Raymond James ซึ่งเป็นบริษัทที่ให้บริการทางการเงินที่มีชื่อเสียงซึ่งแบ่งปันบน Barron’s ได้ประมาณการต้นทุนการผลิตของ GPU ดังกล่าวไว้ประมาณ 3,320 ดอลลาร์ ในทางตรงกันข้าม ราคาขาย GPU เหล่านี้ของ Nvidia ผันผวนระหว่าง $25,000 ถึง $30,000 ขึ้นอยู่กับปริมาณการสั่งซื้อ

การเข้าถึงการประมวลผล GPU Nvidia H100 นั้นขายหมดจนถึงปี 2024 การเริ่มต้นใช้งาน AI กำลังเริ่มต้นขึ้น กังวลว่าพวกเขาจะไม่สามารถรับความจุ GPU ที่จำเป็นเพื่อรองรับโมเดลของตนได้ https://t.co/qyQNk34Mkw pic.twitter.com/1CWndW6Xbq

— แทคิม (@firstadopter) 10 สิงหาคม 2023

— แทคิม (@firstadopter) 16 สิงหาคม 2023

H100 AI Accelerator คือขุมทรัพย์ทองคำ

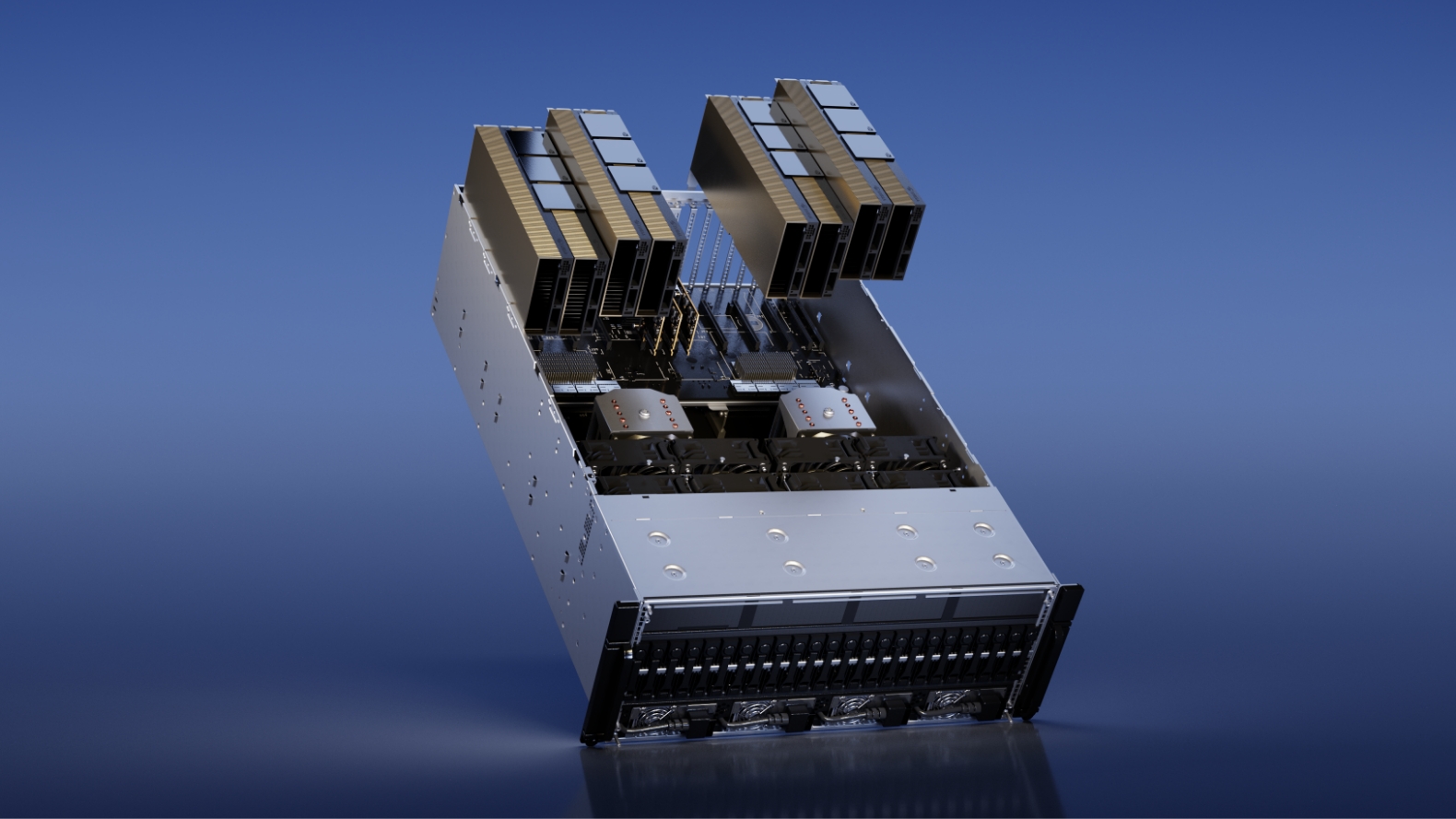

H100 Tensor Core GPU ซึ่งมักเรียกกันว่า “Hopper” AI Accelerator คือ GPU ล้ำสมัยที่ออกแบบมาสำหรับการประมวลผลประสิทธิภาพสูง โดยเฉพาะอย่างยิ่งในด้านปัญญาประดิษฐ์ GPU หรือหน่วยประมวลผลกราฟิกเป็นส่วนประกอบที่สำคัญในคอมพิวเตอร์ ช่วยให้ทำงานที่ซับซ้อนได้ โดยเฉพาะที่เกี่ยวข้องกับกราฟิกและการคำนวณ AI H100 โดดเด่นเนื่องจากความสามารถขั้นสูง ทำให้เป็นส่วนประกอบที่เป็นที่ต้องการในอุตสาหกรรมเทคโนโลยี

การเปรียบเทียบส่วนต่างระหว่างผลิตภัณฑ์

หากต้องการระบุสิ่งเหล่านี้ ตัวเลขกำไรในมุมมอง เมื่อเปรียบเทียบกับผลิตภัณฑ์อื่น อัตรากำไรของ H100 ดูน่าทึ่งยิ่งกว่า ตัวอย่างเช่น EVGA ซึ่งครั้งหนึ่งเคยร่วมมือกับ Nvidia เปิดเผยว่าอัตรากำไรสำหรับหน่วยจ่ายไฟ (PSU) นั้นสูงกว่าอัตรากำไรของ GPU ถึง 300% สิ่งนี้เป็นการตอกย้ำว่าอัตรากำไรของ Nvidia สำหรับ GPU GeForce ที่ใช้งานกับผู้บริโภคอาจน้อยกว่า GPU ที่เน้นเซิร์ฟเวอร์เป็นอย่างมาก

ต้นทุนที่ต่ำกว่าพื้นผิว

แม้ว่าอัตรากำไรดังกล่าวอาจดูสูงเกินไปในแวบแรก แต่สิ่งสำคัญคือต้องเจาะลึกลงไปในต้นทุนที่เกี่ยวข้องในการนำผลิตภัณฑ์อย่าง H100 ออกสู่ตลาด GPU ที่มีความซับซ้อนดังกล่าวจำเป็นต้องมีการวิจัยและพัฒนาที่กว้างขวาง ซึ่งมักจะใช้เวลาหลายปี Nvidia จ่ายค่าตอบแทนแก่วิศวกรอย่างไม่เห็นแก่ตัว โดยเงินเดือนเฉลี่ยสำหรับวิศวกรฮาร์ดแวร์อิเล็กทรอนิกส์ อยู่ที่ประมาณ 202,000 ดอลลาร์ต่อปี ความพยายามสะสมเพื่อพัฒนา GPU เช่น H100 เกี่ยวข้องกับพนักงานที่เชี่ยวชาญหลายพันคน ซึ่งแต่ละคนทำงานกันหลายชั่วโมงนับไม่ถ้วน ปัจจัยเหล่านี้เมื่อรวมกับค่าใช้จ่ายเริ่มต้น เช่น ความจุของแผ่นเวเฟอร์และการชำระเงินในห่วงโซ่อุปทาน สามารถหักล้างส่วนต่างกำไรที่เห็นได้อย่างชัดเจน

ตลาด AI GPU กำลังลุกเป็นไฟ

วิถีปัจจุบันของอุตสาหกรรมเทคโนโลยีบ่งชี้ถึงความต้องการที่ไม่รู้จักพอสำหรับ GPU H100 ของ Nvidia TSMC เซมิคอนดักเตอร์ไททันสัญชาติไต้หวัน คาดว่าจะจัดส่งชิป H100 มูลค่า 2.2 หมื่นล้านดอลลาร์ในปี 2566 เพียงปีเดียว ความต้องการที่เพิ่มขึ้นนี้ขับเคลื่อนโดยการปฏิวัติ AI ที่กำลังดำเนินอยู่ โดยบริษัท AI จำนวนมากแข่งขันกันเพื่อจัดหา GPU H100 ของ Nvidia ในปริมาณมหาศาล

ด้วยการประเมินมูลค่าของตลาดตัวเร่งความเร็ว AI ที่คาดว่าจะสูงถึง 150 พันล้านดอลลาร์ภายในปี 2570 Nvidia การตั้งหลักในภาคนี้ดูแข็งแกร่ง แนวโน้มของตลาดในปัจจุบันบ่งชี้ว่าผลิตภัณฑ์ที่เน้น AI ของ Nvidia ซึ่งรวมถึง H100 นั้นมีแนวโน้มที่จะขาดตลาด โดยคาดว่าจะได้รับคำสั่งซื้อภายในปี 2024 เท่านั้น

Microsoft เป็นเพียงลูกค้าหลักรายเดียวที่ใช้ H100 และ GPU ศูนย์ข้อมูล A100 จาก Nvidia เพื่อขับเคลื่อนเครื่องเสมือน AI บนโครงสร้างพื้นฐานคลาวด์ Azure เมื่อเดือนพฤศจิกายนปีที่แล้ว ทั้งสองบริษัทได้เริ่มความร่วมมือระยะยาวโดยมีแผนพัฒนา”หนึ่งในซูเปอร์คอมพิวเตอร์ AI ที่ทรงพลังที่สุดในโลก”ในเดือนมีนาคม Microsoft ได้เปิดตัวซีรีส์เครื่องเสมือน AI ที่ทรงพลังที่สุดเท่าที่เคยมีมาบน Azure ซึ่งรู้จักกันในชื่อ ND H100 v5 VM ซึ่งเป็น AI VM แบบออนดีมานด์ที่มีให้เลือกในขนาดต่างๆ ตั้งแต่แปดถึงพัน GPUs ที่เชื่อมต่อ

Inflection AI เริ่มต้นจาก Palo Alto โดยร่วมมือกับ CoreWeave และ NVIDIA กำลังสร้างคลัสเตอร์ AI ที่ใหญ่ที่สุดในโลก ซึ่งประกอบด้วย NVIDIA H100 Tensor Core GPU จำนวน 22,000 ตัว การใช้งานที่ไม่เคยมีมาก่อนนี้จะสนับสนุนการฝึกอบรมและการใช้งานโมเดล AI ขนาดใหญ่รุ่นใหม่ คลัสเตอร์นี้คาดว่าจะพัฒนา 22 exaFLOPS ในโหมดความแม่นยำ 16 บิต และยิ่งกว่านั้นหากความแม่นยำต่ำกว่า นำไปใช้ประโยชน์

ซูเปอร์คอมพิวเตอร์ AI ที่กำลังเติบโต

ซูเปอร์คอมพิวเตอร์ AI เป็นแกนหลักของการวิจัยและพัฒนา AI ทำให้สามารถสร้างแบบจำลองและอัลกอริทึมที่ซับซ้อนได้. ต่อไปนี้คือระบบปัจจุบันบางส่วนที่กำลังพัฒนาและ/หรือใช้อยู่ในปัจจุบัน

Summit: พัฒนาโดย IBM และ Oak Ridge National Laboratory ทำให้ Summit เป็นหนึ่งในซูเปอร์คอมพิวเตอร์ AI ที่โดดเด่นที่สุด มีประสิทธิภาพสูงสุดที่ 200 เพตาฟล็อป และสามารถรองรับข้อมูลได้ 3.3 เอ็กซาไบต์ การประชุมสุดยอดใช้สำหรับโครงการวิจัยทางวิทยาศาสตร์และการแพทย์ต่างๆ เช่น การจำลองการเปลี่ยนแปลงสภาพภูมิอากาศ การค้นพบยาใหม่ และการวิเคราะห์ข้อมูลจีโนม

Sunway TaihuLight: สร้างโดยศูนย์วิจัยวิศวกรรมคอมพิวเตอร์ขนานและเทคโนโลยีแห่งชาติของจีน Sunway TaihuLight มีประสิทธิภาพสูงสุดที่ 125 เพตาฟล็อป และสามารถประมวลผลข้อมูลได้ 10.65 เพตะไบต์ ส่วนใหญ่จะใช้สำหรับการใช้งานด้านอุตสาหกรรมและวิศวกรรม เช่น การพยากรณ์อากาศ การสำรวจน้ำมัน และการออกแบบการบินและอวกาศ

Selene: พัฒนาโดย NVIDIA และโฮสต์โดย New Mexico Consortium Selene มีประสิทธิภาพสูงสุดที่ 63 เพตาฟล็อป และสามารถเก็บข้อมูลได้ 1.6 เพตะไบต์ Selene ได้รับการออกแบบมาเพื่อสนับสนุนการวิจัยและพัฒนาของ NVIDIA ใน AI เช่น การประมวลผลภาษาธรรมชาติ คอมพิวเตอร์วิทัศน์ และระบบผู้แนะนำ

IBM Vela: Vela ซูเปอร์คอมพิวเตอร์แบบเนทีฟที่ปรับแต่งด้วย AI ตัวแรกของ IBM ได้รับการออกแบบมาโดยเฉพาะสำหรับ AI ขนาดใหญ่ ตั้งอยู่ใน IBM Cloud และปัจจุบันใช้โดยชุมชน IBM Research การออกแบบของ Vela มอบความยืดหยุ่นในการปรับขนาดตามต้องการและปรับใช้โครงสร้างพื้นฐานที่คล้ายกันในศูนย์ข้อมูล IBM Cloud ทั่วโลกได้อย่างง่ายดาย

DGX SuperPOD: DGX SuperPOD ของ NVIDIA เป็นซูเปอร์คอมพิวเตอร์ AI อันทรงพลังที่ออกแบบมาสำหรับโครงสร้างพื้นฐาน AI ระดับองค์กร ขับเคลื่อนโดย NVIDIA A100 Tensor Core GPU และมอบประสิทธิภาพ AI 700 petaflops

AI Research SuperCluster (RSC) ของ Meta: RSC ของ Meta เป็นซูเปอร์คอมพิวเตอร์ที่ออกแบบมาเพื่อเร่งการวิจัย AI เป็นหนึ่งในซูเปอร์คอมพิวเตอร์ AI ที่เร็วที่สุดในโลก และใช้ในการฝึกโมเดล AI ขนาดใหญ่ รวมถึงการประมวลผลภาษาธรรมชาติและโมเดลการมองเห็นด้วยคอมพิวเตอร์