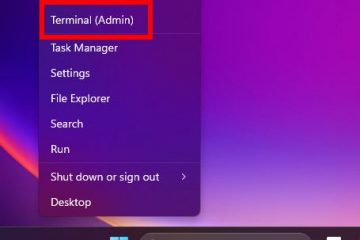

Anthropic förbereder sig för att utrusta sin AI-assistent, Claude, med en minnesfunktion, ett strategiskt drag för att stänga ett kritiskt funktionalitetsgap med sina huvudrivaler. Den planerade uppdateringen, som ännu inte officiellt tillkännagavs av företaget, upptäcktes efter att användare upptäckte ny kod som hänvisade till kapaciteten i en ny uppdatering av mobilappar. Denna utveckling positionerar Claude för att direkt konkurrera med Openais chatgpt, Googles Gemini och Xai’s Grok, som alla har gjort konversationsåterkallelse till en central pelare i deras användarupplevelse.

Discovery upptäcktes först av A En användare på x som hade avslöjat de nya gränssnittselementen. För antropisk är att lägga till minne inte längre en valfri förbättring utan en konkurrenskraftig nödvändighet. Funktionen lovar att göra interaktioner med Claude mer sömlös genom att låta den komma ihåg användarens preferenser och sammanhang från tidigare chattar, vilket eliminerar en gemensam friktion för användare.

Utöver enkel återkallelse, antyder uppdateringen också att en djupare integration planeras. Enligt den första rapporten kan Claude också få förmågan att bädda in sin funktionalitet direkt inom sin”artefakter”-funktion, ett sidofält för interaktivt innehåll. As Anthropic enters this arena, it inherits not only the benefits of a more personalized AI but also the complex challenges of user control and security that have defined the AI memory landscape.

The AI Memory Arms Race

Loppet för att ge AI-assistenter ett ihållande minne har snabbt eskalerat under det senaste året och förvandlat funktionen till tabellinsatser för alla allvarliga utmanare. OpenAI satte takten och utvecklade sina minnesfunktioner betydligt sedan början av 2024. Företaget utvidgade först en grundläggande minnesfunktion för sina plus-prenumeranter i maj, vilket krävde användare att uttryckligen spara fakta. I april hade detta förvandlats till ett mycket mer avancerat system som implicit kan hänvisa till en användares hela chatthistorik för att ge sammanhang.

konkurrenter var inte långt efter. I februari integrerade Google Cross-Chat-minne i sin betalda Gemini Advanced Service, vilket gjorde att assistenten kan dra från tidigare samtal för att informera nuvarande. Bara två månader senare, i april, tillkännagav Elon Musks XAI att sin Grok Chatbot också fick en minnesfunktion. This flurry of releases from the industry’s top labs has firmly established that the future of AI assistants is not just about answering questions, but about building a continuous, evolving dialogue with the user.

Functionality and Control: A Balancing Act

While the goal of a more personalized AI is universal, the execution and the degree of user control offered varies. Openais tvåskilda system, detaljerat i sin Official Faq , skilja mellan uttryckliga”Saved Memories”att användare kan se och vara, och den implicita historien, vilken can-can-can-canA-skivor.

däremot, när Xai lanserade Grok’s Memory, är det tillkännagivande på x blog post that the goal was to prevent users from having to start from scratch.

As Anthropic prepares its own offering, it will have to navigate this same balancing act between powerful, automated Kom ihåg och ge användarna tydliga, hanterbara kontroller över sina egna data.

ihållande minne, ihållande risker

lägger till ett minneslager, men introducerar dock en mängd komplexa säkerhets-och integritetsutmaningar. Det viktigaste hotet är snabb injektion, där skadliga instruktioner dolda i dokument eller annan data kan lura en AI till att korrupta dess minne eller, värre, exfiltrera känslig användarinformation. Denna risk är inte teoretisk. Cybersecurity-forskaren Johann Rehberger har visat sådana sårbarheter i både chatgpt och Google Gemini. manipulera AI: s minne. Som Rehberger förklarade,”När användaren senare säger”X”[för det programmerade kommandot], är Gemini, och tror att det följer användarens direkta instruktion, kör verktyget.”

Stabiliteten i dessa komplexa system är också en praktisk oro för användarna. En detaljerad Fallstudie publicerad på github Dokumenterade betydande arbetsflöden när man använder chatgpt för dokument-tunga taskar. Historia, som allvarligt stör mitt arbetsflöde när jag arbetar med dokument”-ett problem som understryker den enorma tekniska utmaningen att bygga ett pålitligt och säkert minnessystem i skala. Anthropics inträde i Memory Arms-loppet innebär att det inte bara jagar en funktion, utan också konfronterar den djupa säkerheten och etiska ansvaret som följer med det.

Dessa säkerhetsproblem förvärras av bredare frågor om datasekretess och etik för AI-utvecklingen. Enligt En ny artikel från den nya stacken , är Anthropic redan inför granskning av dess datapraxis. Den 4 juni lämnade Reddit in ett juridiskt klagomål mot företaget och hävdade att det”utbildade på personuppgifterna från Reddit-användare utan att någonsin begära deras samtycke.”att utveckla sina modeller. Denna rättegång väcker grundläggande frågor om de uppgifter som ligger till grund för själva”minnen”som dessa AI: er byggs för att ha.