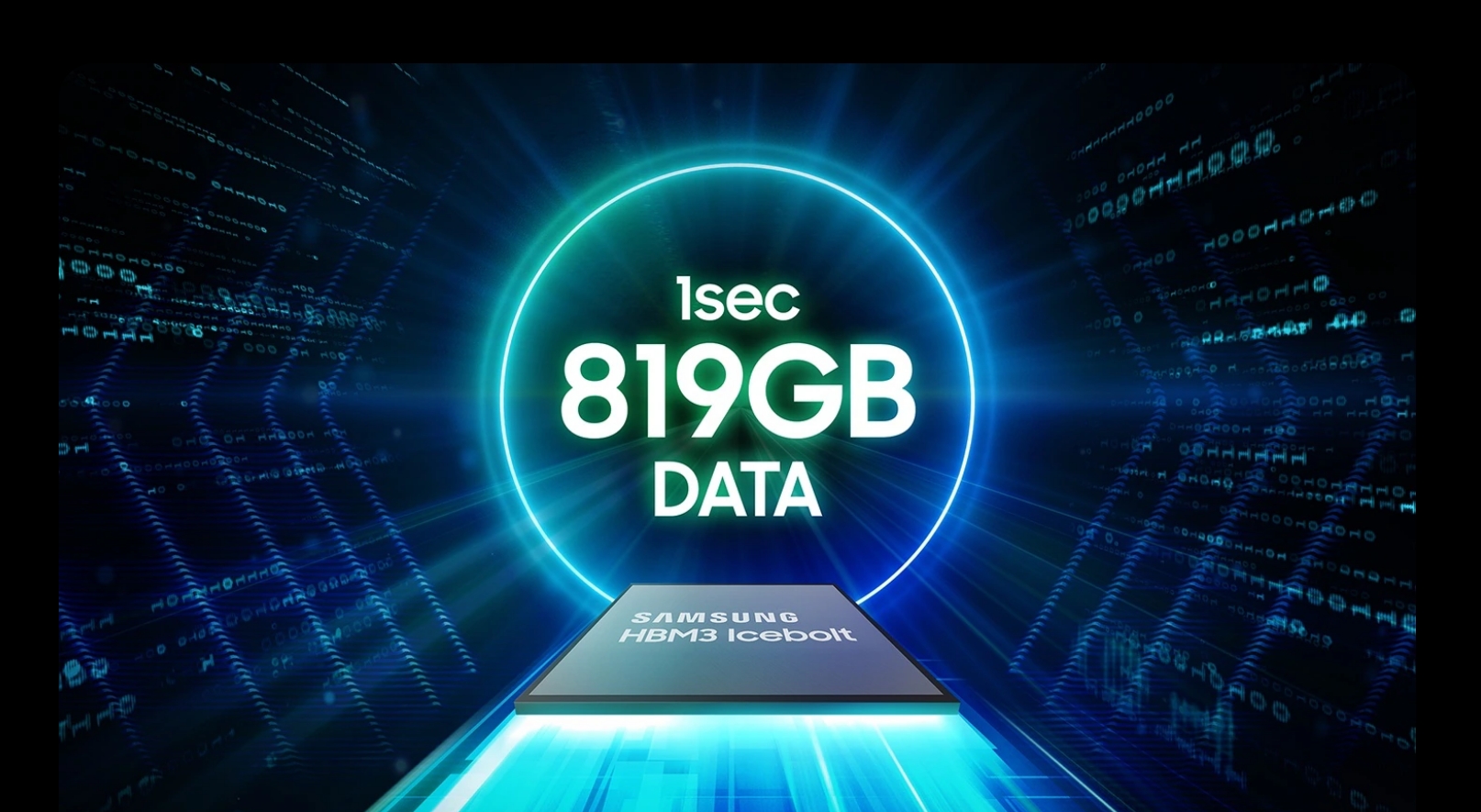

Samsungs HBM3 DRAM-chip, designade för användning i Nvidias AI-acceleratorer, har stött på prestandaproblem under testning. De primära problemen kretsar kring överdriven värmegenerering och hög strömförbrukning, vilket har väckt tvivel om deras lämplighet för Nvidias högpresterande datorbehov. HBM står för High Bandwidth Memory och använder en chipdesign som ger högre bandbredd än DDR4-eller GDDR5-moduler samtidigt som den använder mindre ström och i en betydligt mindre formfaktor. Detta uppnås genom att stapla upp till åtta DRAM matriser och en valfri basplatta som kan inkludera buffertkretsar och testlogik.

Värme-och strömförbrukningsproblem

De rapporterade värme-och strömförbrukningsproblemen är inte isolerade enbart till HBM3-chipsen. Samsungs HBM3E-chips, som visades upp för några månader sedan, upplever också liknande problem. Dessa problem blev uppenbara när resultaten av Samsungs 8-lagers och 12-lagers HBM3E-chips släpptes i april 2024.

Däremot började SK Hynix leverera HBM3E-chips till Nvidia i mars 2024 och positionerade sig som en nyckelaktör på HBM-marknaden. SK Hynix är för närvarande Nvidias största leverantör av HBM-chips, som är avgörande för att AI-acceleratorer ska fungera. Nvidias dominans på AI-marknaden, med en andel på 80 %, gör dess certifiering avgörande för alla HBM-chiptillverkare.

Samsungs optimeringssatsningar

Samsung har erkänt behovet av optimering i takt med kundernas krav. Företaget har arbetat nära sina kunder för att ta itu med dessa problem och har strävat efter att klara Nvidias stränga tester i över ett år. Samsungs senaste ledarskapsförändringar, inklusive utnämningen av en tidigare expert inom utveckling av DRAM och NAND-blixt, understryker dess engagemang för att lösa dessa utmaningar.

Certifieringen från Nvidia är avgörande för Samsungs ambitioner på HBM-marknaden. De olösta problemen med värme och strömförbrukning har kastat en skugga över Samsungs framtidsutsikter. Det är fortfarande osäkert om dessa problem kan åtgärdas snabbt. Nvidias vd Jensen Huangs stöd för Samsungs HBM3E 12H (12-lagers) minneschip vid GTX AI 2024-konferensen, där han skrev”Jensen Approved”på chipet, understryker vikten av detta partnerskap.

Samsungs förmåga att övervinna dessa utmaningar är inte bara avgörande för dess verksamhet utan också för den bredare industrin. Både AMD och Nvidia är angelägna om att Samsung ska lösa dessa problem för att säkerställa en stabil tillgång på HBM-chips från flera leverantörer, vilket skulle hjälpa till att hålla priserna konkurrenskraftiga. Samsung levererar redan HBM-chips till AMD, vilket ytterligare betonar behovet av tillförlitliga och effektiva minneslösningar.

Samsung siktar på att starta massproduktion av HBM3E-chips före slutet av årets andra kvartal ansträngningar för att optimera sina HBM-chips i samarbete med kunder återspeglar dess beslutsamhet att säkra fotfästet på den konkurrensutsatta AI-hårdvarumarknaden. Resultatet av dessa ansträngningar kommer att påverka det framtida landskapet för AI-acceleratorer och högpresterande datorer.