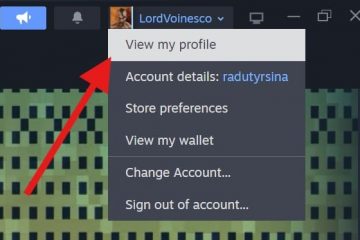

Kuaishou, en framstående kort videoplattform baserad i Peking, presenterade sin egenutvecklade stora språkmodell som heter KwaiYii för allmänheten förra veckan, enligt en rapport från TechNode. Dessutom avslöjade företaget också sin forskning om Spiking Neural Networks och utvecklingen av SpikeGPT.

Denna version kommer efter en beta-testfas för en ChatGPT-liknande tjänst för Android-enheter som startade den 18 augusti. Dialogtjänsten, som har 13 miljarder parametrar rotade i KwaiYii, konkurrerar med OpenAI GPT-3.5 i sin förmåga att skapa innehåll, konsultation och problemlösning.

LLM finns detaljerat på KwaiYiis GitHub-sida. Den primära applikationen för Kuaishous AI-chattbot har varit sökning, som använder originalinnehåll från plattformen för att ta itu med AI-“hallucinationer”– felaktigheter som beror på otillräcklig dataträning.

SpikeGPT: A Leap in Energy Efficiency

Kuaishou positionerar sig som en stor kraft i AI forskning och utveckling, både inom offentliga vanliga produkter och FoU-projekt. KwaiYii är ett exempel på den vanliga offentliga AI, medan Kuaishou också denna vecka diskuterade SpikeGPT, ett exempel på dess AI-forskningsinsatser.

Beräkningskraven av samtida stora språkmodeller (LLM) är betydande. Men Spiking Neural Networks (SNN) har identifierats som en mer energi-effektivt alternativ till konventionella artificiella neurala nätverk, även om deras effektivitet i språkgenereringsuppgifter förblir okända.

Ett forskningssamarbete mellan University of California och Kuaishou Technology har introducerat SpikeGPT (via Synced Review), den första Generative Spiking Neural Network (SNN) språkmodell. Denna modell, med sin 260M parameterversion, matchar prestandan hos djupa neurala nätverk (DNN) ) samtidigt som de energibesparande fördelarna med spikbaserade beräkningar behålls.

SpikeGPT är en generativ språkmodell som kännetecknas av rena binära, händelsedrivna spikaktiveringsenheter. Den integrerar upprepning i ett transformatorblock, vilket gör den kompatibel med SNN. Denna integrering eliminerar inte bara den kvadratiska beräkningskomplexiteten utan underlättar också representationen av ord som händelsedrivna toppar.

Modellen kan bearbeta strömmande data ord för ord, och initiera beräkning redan innan en hel mening bildats, samtidigt som de fortfarande fångar långväga beroenden i invecklade syntaktiska strukturer. Forskargruppen har också införlivat olika tekniker för att förbättra SpikeGPT:s prestanda, såsom ett binärt inbäddningssteg, en token shift-operatör och en vanilj RWKV för att ersätta den traditionella självuppmärksamhetsmekanismen.

Förstå spikning. Neurala nätverk

Spikande neurala nätverk (SNN) är en typ av artificiella neurala nätverk som är inspirerade av hur biologiska neuroner fungerar. I SNN kommunicerar neuronerna med varandra genom att skicka spikar, som är korta skurar av elektrisk aktivitet. Piggarna är inte kontinuerliga, utan uppträder snarare med diskreta tidsintervall. Detta till skillnad från traditionella artificiella neurala nätverk, som använder kontinuerliga värden för att representera aktiveringen av neuroner.

SNN:er har flera potentiella fördelar jämfört med traditionella artificiella neurala nätverk. För det första är de mer energieffektiva. Detta beror på att spikarna bara skickas när det behövs, snarare än kontinuerligt. För det andra är SNN:er mer biologiskt realistiska. Detta gör dem till ett bra val för tillämpningar som kräver en hög grad av realism, såsom robotik och medicinsk bildbehandling.

Men SNN har också vissa utmaningar. En utmaning är att de är svårare att träna än traditionella artificiella neurala nätverk. Detta beror på att spikarna är diskreta händelser, vilket gör det svårt att backpropagera felet genom nätverket. En annan utmaning är att SNN inte är lika välkända som traditionella artificiella neurala nätverk. Detta gör det svårt att designa och optimera SNN för specifika uppgifter.

Hur SpikeGPT presterar

I en empirisk studie tränades SpikeGPT med tre olika parameterskalor (45M, 125M och 260M parametrar) och benchmarkades mot transformatorbaslinjer som Reformer, Synthesizer, Linear Transformer och Performer med hjälp av Enwik8-datauppsättningen. Resultaten avslöjade att SpikeGPT levererade jämförbara resultat med 22 gånger färre synaptiska operationer (SynOps).

Denna forskning understryker potentialen i att träna stora SNN:er för att utnyttja framstegen inom transformatorer, vilket tyder på en betydande minskning av LLM:s beräkningskrav genom att tillämpa händelsedrivna spikaktiveringar för språkgenerering. Forskarna har uttryckt sin avsikt att fortsätta förfina sin modell och kommer att uppdatera sitt förtryckta papper därefter. Koden för SpikeGPT är tillgänglig på projektets GitHub och papper som beskriver modellen kan nås på arXiv.