Google har släppt VaultGemma, en ny 1 miljard parameter öppen modell som markerar ett betydande steg framåt i integritetsbevarande

ai. VaultGemma, som tillkännagavs den 12 september av sin forskning och DeepMind-team, är den största modellen i sitt slag Tränade från marken upp med olika privat-

While the Sekretessåtgärder resulterar i en avvägning i råprestanda, VaultGemma skapar en kraftfull ny grund för att utveckla säkrare ai.

Modellen, dess vikter och tekniska rapport är nu öppna för forskare på kramar ansikte .

en ny gräns i AI Privacy

The Släpp av VaultGemma Konfronterar direkt en av de största utmaningarna i AI-utvecklingen: Internt privatliv i utbildningsmodeller för utbildningsmodeller för utbildningsmodeller för utbildningsmodeller på VAST, Web-SCALES. LLM: er har visat sig vara mottagliga för memorering, där de oavsiktligt kan reproducera känsliga eller personuppgifter som de utbildades på.

Vaultgemmas tillvägagångssätt ger en slutgiltig integritetsgaranti från grunden. Detta säkerställer att grundmodellen är byggd för att förhindra memorering av specifika detaljer, vilket gör att den kan lära sig allmänna mönster utan att vara alltför påverkade av någon enskild data.

Under huven: Vaultgemma’s Architecture och Training

arkitekturalt, Vaultgem är en decoder-only transformation baserad på Google’s Gemma 2-modell. Den har 26 lager och använder Multi-Query-uppmärksamhet (MQA).

Ett viktigt designval var att minska sekvenslängden till 1024 tokens, vilket hjälper till att hantera de intensiva beräkningskraven för privat utbildning.

hela förträningsprocessen genomfördes med differentiellt privat stokastisk gradient härkomst (DP-SGD) Med en formell garanti för (ε ≤ 2,0, Δ ≤ 1.1e-10). Denna teknik lägger till kalibrerat brus under träning för att skydda enskilda träningsexempel.

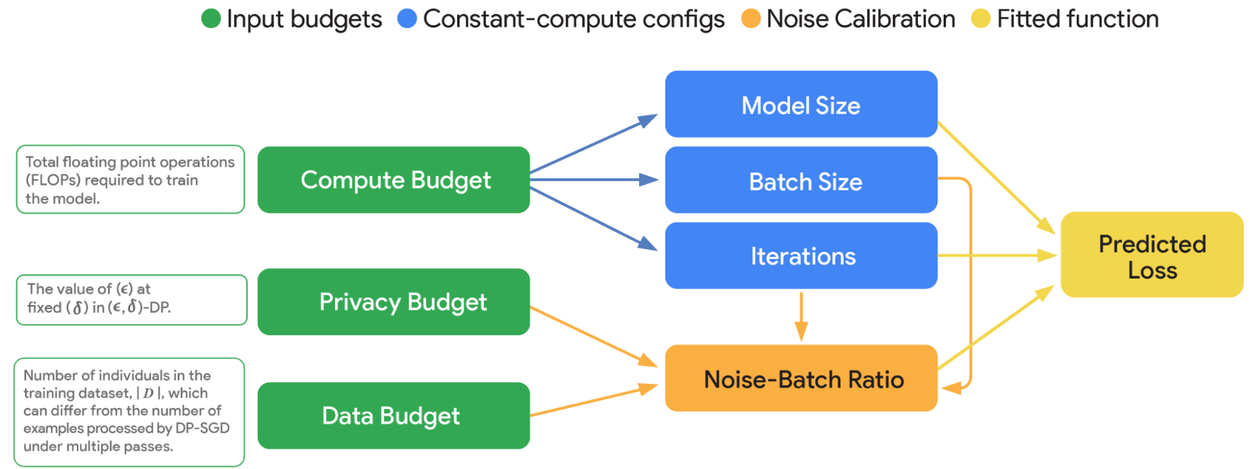

Modellens utveckling styrdes av en ny uppsättning av”DP-skalningslagar”, säger Google. Denna forskning ger en ram för att balansera de komplexa avvägningarna mellan datorkraft, integritetsbudget och modellverktyg. Träning genomfördes på ett massivt kluster på 2048 TPUV6E-chips.

Priset på integritet: Prestanda och riktmärken

Denna stränga integritet kommer till en kostnad. Det finns en inneboende avvägning mellan styrkan i integritetsgarantin och modellens användbarhet.

på standard akademiska riktmärken, Vaultgemma underpresterar jämfört med icke-privata modeller av liknande storlek, som Gemma-3 1b.

Men dess prestanda är märkbart jämförbara till det av icke-privat från grovt modeller från det gemma-3.

men dess prestanda är märkbart jämförbara till det av icke-privat från modeller från grovt, såsom gP-2. illustrerar att dagens privata träningsmetoder producerar modeller med betydande användbarhet, även om ett gap kvarstår. Det belyser en tydlig väg för framtida forskning.

Att sätta garantier på testet: Ingen påvisbar memorisering

Den ultimata valideringen av Vaultgemmas tillvägagångssätt ligger i dess motstånd mot memorisering. Google genomförde empiriska tester för att mäta modellens tendens att reproducera sekvenser från dess träningsdata, en metod som beskrivs i tidigare GEMMA-tekniska rapporter.

Modellen uppmanades med prefix från träningskorpuset för att se om den skulle generera motsvarande suffix. Resultaten var definitiva: Vaultgemma uppvisade ingen påvisbar memorering, varken exakt eller ungefärlig. Detta fynd validerar starkt effektiviteten i DP-SGD-förträningsprocessen.

Genom att öppna modellen och dess metodik syftar Google till att sänka barriären för att bygga integritetsbevarande teknik. Släppet ger samhället en kraftfull baslinje för nästa generation av säker, ansvarsfull och privat AI.