Meta har lanserat ett nytt AI-översättningsverktyg för att hjälpa skapare på Facebook och Instagram att nå globala publik. Funktionen, som tillkännagavs tisdag, dubsar automatiskt in i nya språk medan du bevarar skaparens egen röst och ton. Den innehåller också en valfri läppsync-funktion för att videon ser mer naturlig ut.

Ursprungligen rullar ut med engelska och spanska stöd, verktyget syftar till att bryta ner språkbarriärer. Uppdateringen är tillgänglig globalt för alla offentliga Instagram-konton och Facebook-skapare med över 1 000 följare i regioner där Meta AI erbjuds. Denna rörelse signalerar Metas aggressiva tryck in i praktiska AI-applikationer.

Lanseringen placerar meta i direkt konkurrens med liknande AI-driven kommunikationsverktyg från Google och Microsoft, i en ongoint-kamp för dominans i ai-förbättrade plattformar.

How Meta’s AI Dubbing and Lip-Syncing Works

Head of Instagram Adam Mosseri framed the new feature as a core part of the platform’s mission to connect människor.”Vi tror att det finns massor av fantastiska skapare där ute som har potentiella publik som inte nödvändigtvis talar samma språk,”förklarade han i ett inlägg. Han tror att genom att överbrygga språkliga klyftor kommer verktyget att hjälpa skaparna att låsa upp nya möjligheter för tillväxt och engagemang på plattformen.

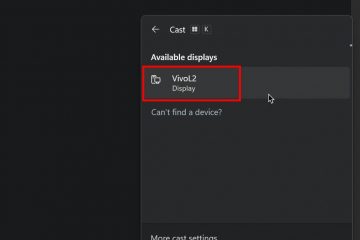

Skapare kan aktivera den nya funktionen direkt i rullarna som publicerar arbetsflödet genom att välja alternativet”Översätt din röst med Meta AI”-alternativet. Enligt Metas tillkännagivande är systemet utformat för att vara en Gratis verktyg som, en gång aktiverat, automatiskt dubbar innehåll . AI genererar ett nytt ljudspår som bevarar användarens autentiska ljud och ton, vilket skapar en sömlös upplevelse för tittaren. En valfri läppsynkfunktion förbättrar ytterligare effekten genom att exakt matcha skaparens munrörelser till de översatta orden, vilket gör att den verkar som om de flytande talar det nya språket.

Denna teknik, som först förhandsvisades på META: s Connect Conference i september 2024, lägger en stark betoning på Creator Control. Användare kan välja att granska och godkänna översättningar innan de publiceras genom att aktivera en specifik växling. Den skickar ett meddelande till skaparen, som sedan kan acceptera eller avvisa den dubblerade versionen från sin professionella instrumentpanel. Meta klargör att avvisa en översättning inte kommer att påverka den ursprungliga, icke-translaterade rulle.

För transparens kommer tittarna att se ett meddelande som indikerar att rulle översattes med Meta AI och kan inaktivera framtida översättningar för specifika språk genom inställningsmenyn. Denna funktion ger en uppdelning av synräkningar efter språk, vilket ger tydliga insikter om hur översättningar presterar med nya internationella publik. För bättre resultat råder Meta skapare att fotografera ansikte-till-kamera-videor, tala tydligt utan att täcka munnen och minimera bakgrundsbrus eller musik. Verktyget stöder för närvarande upp till två högtalare, som bör undvika att prata över varandra för den mest exakta översättningen.

Ett manuellt alternativ för flerspråkiga skapare

för skapare som kräver mer granulärt kontroll eller arbete på språk som ännu inte stöttas av AI, har meta också introducerat en robust manual. Facebook-sidor har nu förmågan att ladda upp upp till 20 av sina egna förtranslaterade ljudspår till en enda rulle.

Detta hanteras genom avsnittet”stängda bildtexter och översättningar”i Meta Business Suite. Unlike the AI tool’s pre-publish workflow, these manually uploaded tracks can be added, replaced, or removed both before and after the Reel is published, offering a flexible solution for professional production workflows.

The AI Translation Arms Race: Meta vs. The Competition

Meta’s new tool enters a fiercely competitive landscape. Microsoft tillkännagav sin”tolk i team”-funktionen i slutet av 2024, som syftar till att klona en användares röst för sömlösa översättningar i realtid. Microsofts CMO, Jared Spataro, framhöll målet att göra tvärspråkskommunikation mer personlig och bad användare att”föreställa sig att kunna låta precis som du på ett annat språk.”

I maj 2025 följde Google efter att integrera Gemini AI i Google Meet för live-talöversättning. Googles tillvägagångssätt betonar att bevara talarens unika vokala egenskaper, inklusive ton och kadens. As one expert noted, this focus on nuance is critical: “This isn’t just about words; it’s about conveying intent. Google’s focus on vocal nuance could be revolutionary for how distributed teams connect.”

Meanwhile, translation specialist DeepL launched DeepL Voice in November 2024. The company leveraged its reputation for accuracy and security, with CEO Jarek Kutylowski stating,”Att ta med den kvalitet och säkerhet som DeEpl är känd för till realtidens talöversättning var nästa gräns för oss som ett företag och vi är glada över att äntligen avslöja våra första produkter.”

Denna flur av innovation understryker ett betydande branschövergripande drivkraft för att avlägsna språkbarriärer med sofistikerade AI. För Meta sammanfaller lanseringen också med en stor intern omstrukturering av sin AI-division, vilket signalerar ett förnyat fokus på att integrera avancerad AI direkt i sina konsumentvända produkter.