AI Company Anthropic har introducerat en minnesfunktion för sin Claude Chatbot, utformad för att göra interaktioner mer effektiva. Tillkännagiven den 11 augusti, tillåter den nya kapaciteten AI att söka och referera till tidigare samtal när de uppmanas av en användare, vilket hjälper dem att fortsätta projekt utan att upprepa information.

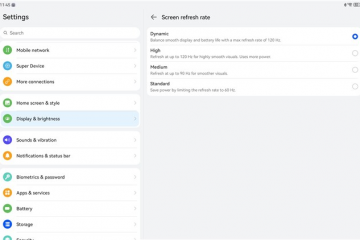

Funktionen är tillgänglig på Claude’s Web, Desktop och mobilplattformar. Till skillnad från det ihållande minnet av rivaler som Openais chatgpt, är Anthropics version användarinitierad. Detta placerar det som ett mer transparent och kontrollerat alternativ. Det rullar ut först till betalda prenumeranter på max-, team-och företagsnivåerna.

Flytten eskalerar den pågående kampen för användarlojalitet bland AI-assistenter, där personliga, kontextmedvetna interaktioner är en viktig differentierare. Anthropic is betting that its deliberate, privacy-centric approach can carve out a significant niche against more aggressive rivals.

How Claude’s Memory Fungerar

Mekaniken i funktionen är enkel. Användare kan få Claude att återkalla information från tidigare diskussioner, och AI kommer Sök sin historia för att ge relevant sammanhang för den nuvarande chat

För användare som vill förhindra att specifika samtal ingår i framtida sökningar är den enda metoden som för närvarande är tillgänglig att ta bort chatten helt. This all-or-nothing approach underscores the feature’s current design, prioritizing simplicity over granular control of individual memories, a potential area for future refinement.

[embedded content]

A Cautious, User-Controlled Approach to AI Memory

Anthropic is deliberately framing its new, hotly anticipated memory function around user control and transparency, a calculated Flytta på en marknad där AI minns kapacitet har lett till både spänning och kontroverser. Rather than simply replicating the persistent, always-on memory of its rivals, the company is positioning its implementation as a more thoughtful and privacy-preserving alternative.

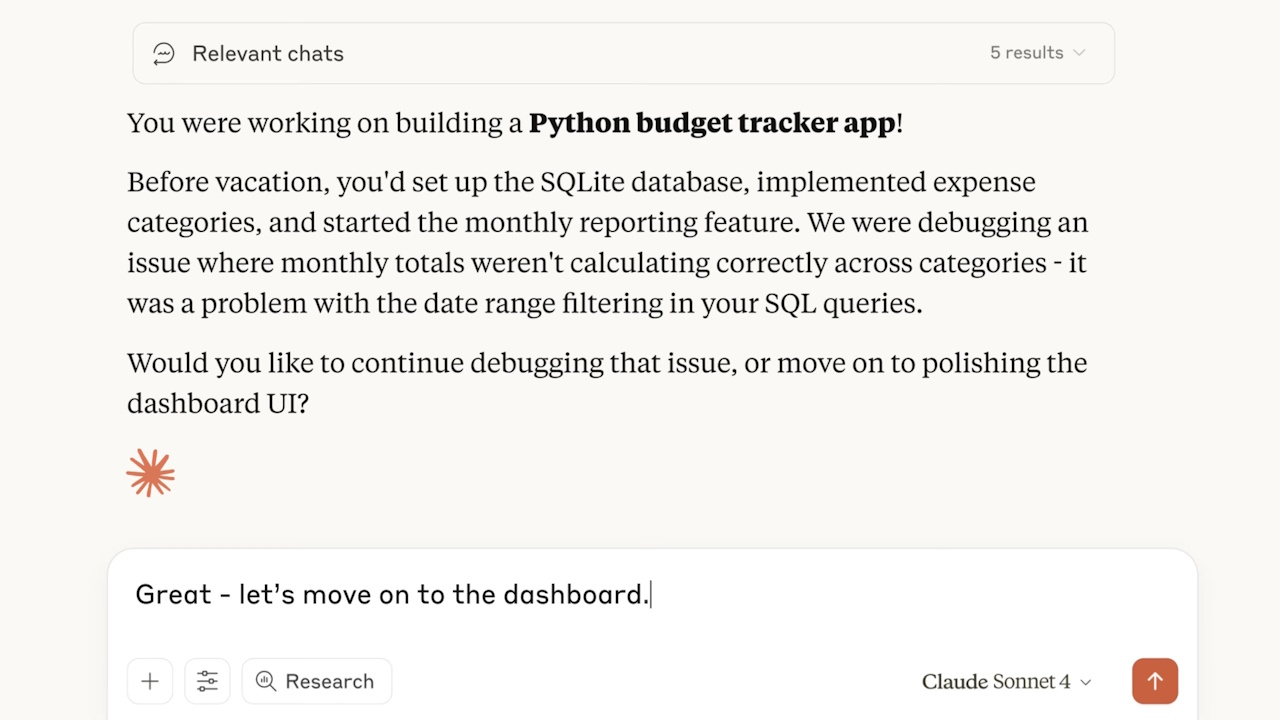

The company’s official announcement highlights the feature’s core benefit, stating, “never lose track of your work again. Claude now remembers your past conversations, so you can seamlessly continue projects, reference previous discussions, and build on your ideas without starting from scratch every time.”Denna meddelanden fokuserar kvadratiskt på produktivitet och kontinuitet i arbetsflödet, en viktig smärtpunkt för professionella användare som arbetar med flera sessionsprojekt.

Den avgörande skillnaden ligger dock i sin mekanik, som direkt tar upp växande oro över datasekretess och AI-autonomi. Enligt antropisk talesman Ryan Donegan,”Det är ännu inte en ihållande minnesfunktion som Openais chatgpt. Claude kommer bara att hämta och referera till dina tidigare chattar när du ber det till, och det är inte att bygga en användarprofil.”Denna on-demand-modell säkerställer att användaren förblir den slutliga myndigheten när och hur deras samtalshistoria används.

Denna designfilosofi anpassar sig till de principer som beskrivs i Anthropics nyligen publicerade säkerhetsram, som betonar att hålla människor i kontroll och säkerställa transparens. Genom att göra minnet till en uttrycklig, användarutlösad handling snarare än en implicit, bakgrundsprocess, är Anthropic att genomföra sin säkerhet-första retorik i praktiken. Det är en direkt kontrapunkt till system där användare kan vara osäkra på vad AI vet om dem eller hur det lärde sig det.

Dessutom är denna funktion bara en del av en flerskiktad strategi för personalisering. Såsom beskrivs i sin supportdokumentation erbjuder Anthropic redan verktyg som kontoövergripande profilpreferenser och projektspecifika instruktioner för att ge Claude Context. The new chat search capability is therefore not a blanket memory solution but a specific tool for retrieving historical information, complementing other methods for guiding the AI’s behavior.

This strategy supports CEO Dario Amodei’s broader vision of a future where “we’re heading to a world where a human developer can manage a fleet of agents, but I think continued human involvement is going to be important for the quality control…”In this model, the user acts as the manager, and the ability to selectively pull in historical context is another tool at their disposal, reinforcing a collaborative, human-steered approach to AI interaction.

The Competitive Race for a More Personal AI

Anthropic’s launch is the latest move in an escalating arms race among AI giants to make their chatbots more personalized and “sticky.”Förmågan att komma ihåg sammanhang över sessioner ses som en viktig drivkraft för användarlojalitet. Varje större spelare erbjuder nu någon form av denna kapacitet, men med olika filosofier.

OpenAI var en tidig flyttare och utvidgade sin minnesfunktion för chatgpt plus användare i maj 2024. Det uppgraderade senare systemet i april 2025 för att implicit referera till en användares hela chatthistoria och flytta utöver uttryckligen sparade minnen. This approach is designed to build a comprehensive understanding of the user over time.

Google followed a similar path, adding cross-chat recall to its Gemini assistant in February 2025. Even Elon Musk’s xAI entered the fray, rolling out a memory feature for its Grok chatbot in April 2025. Anthropic’s user-initiated model is a clear strategic differentiator in this crowded field.

Part av en bredare drivkraft för företagsklar verktyg

Denna nya funktion är inte en isolerad produktuppdatering utan en del av en bredare, avsiktlig strategi av antropisk. Företaget bygger stadigt en svit med verktyg för företagsklass som betonar säkerhet, kontroll och praktisk affärsapplikation. Detta är i linje med VD Dario Amodeis vision där”vi är på väg till en värld där en mänsklig utvecklare kan hantera en flotta av agenter, men jag tror att fortsatt mänskligt engagemang kommer att bli viktigt för kvalitetskontrollen…”.

Minneslanseringen följer en serie av de senaste utgivningar med hög värde. I juli 2025 riktade företaget Wall Street med”Claude for Financial Services”och rullade ut”underagenter”för sin Claude-kodplattform för att effektivisera komplexa utvecklararbetsflöden.

Dessa produktrörelser underbyggs av ett offentligt engagemang för säkerhet. I början av augusti publicerade Anthropic en ny ram för att utveckla pålitliga AI-agenter. Detta kom strax efter utgivningen av Claude Opus 4.1, en uppdatering som fokuserade på att förbättra kodningen och säkerheten inom befintliga protokoll.

Detta står i kontrast till”flytta snabbt och bryta saker”som har lett till offentliga misslyckanden på rivaliserande laboratorier. Genom att koppla kapacitetsförbättringar med transparenta kontroller syftar antropiska att bygga förtroende med en professionell användarbas som värderar tillförlitlighet lika mycket som rå kraft i ett allt mer flyktigt AI-ekosystem.