Akademiska forskare har utvecklat ett automatiserat system med generativ AI som kan jaga, verifiera och generera korrigeringar för en kritisk sårbarhet för mjukvaru som tyst har spridit sig över öppna källprojekt i 15 år. Den AI-drivna rörledningen har redan identifierat 1 756 sårbara node.js-projekt på GitHub och har framgångsrikt lett till att 63 av dem lappas, vilket bevisar att en enkel sårbarhetsdetektering har en slutförbarhet. The system not only finds the flaw but also uses OpenAI’s GPT-4 to write and validate a patch, effectively closing a security hole that allows attackers to access restricted server files.

In a recently published paper, the Dutch and Iranian research team explained that their work hanterar den fulla livscykeln för sårbarhetshantering i en skala som tidigare inte kan uppnås. However, their findings also came with a stark warning: the very AI models being heralded as the future of software development are often “poisoned,”having learned to replicate the same insecure code they are now being asked to fix.

anatomi av en evigt bug

Sårbarhetens uthållighet är en fallstudie i den komplexa sociala dynamiken i öppen källkodsprogramvara. Forskare spårade den felaktiga node.js-koden till ett utdrag som först delades på GitHub-gist 2010. Därifrån kopierades och klistrades in över utvecklarforum och i tusentals projekt, och blev ett slags digitalt spöke i maskinen. Felens vilseledande natur bidrog till dess spridning; Eftersom moderna webbläsare automatiskt sanerar den skadliga ingången som utlöser felet, misslyckades utvecklarens egna tester med att avslöja faran. Detta skapade en falsk känsla av säkerhet, vilket gjorde det möjligt för det sårbara mönstret att bli djupt förankrat i DNA från otaliga applikationer.

Utöver detektion: Att bygga en AI-driven fixare

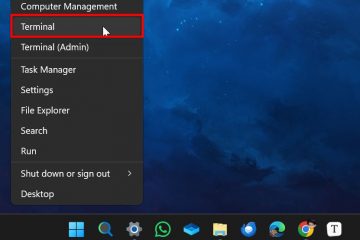

för att bekämpa buggen i skala, utgör forskarna en sofistikerad, multi-steg. Det börjar med att skanna GitHub efter kodmönster associerade med sårbarheten, använder statisk analys för att flagga kandidater med hög sannolikhet och sedan aktivt försöka utnyttja bristen i en säker miljö för att eliminera falska positiva effekter. För bekräftade sårbarheter uppmanar det GPT-4 att generera en patch, som sedan testas för att säkerställa att den fixar problemet utan att bryta applikationen.

Denna ände-till-end-modell speglar en bredare branschtryck mot automatiserade säkerhetslösningar. På liknande sätt Meta tillkännagav År 2025 a New Benchmark, Autopatch, till Evaluate Hower Well Can Can Can Canaty tillkännagav fix. Även om potentialen är enorm, har tillvägagångssättet sina kritiker. I sitt tillkännagivande i april 2025 avslöjade Meta också llamafire Generera en sådan osäker kod.

I november Googles Big Sleep AI-agent för att hitta säkerhetsproblem i programvara, avslöjade en allvarlig sårbarhet i SQLite, en öppen källkodsdatabasmotor som används allmänt i programvaruapplikationer och inbäddade system. Stor sömn kom ut från Googles tidigare projekt naptime , ett samarbete mellan Project Zero och DeepMind, är en experimentell AI-agent för Autonomously Identonomy.

Även förra året lanserade Startup Protect AI Vulnhuntr, ett kommersiellt verktyg som använder Anthropics Claude-modell för att hitta nolldagars sårbarheter i Python-koden. The company is now open-sourcing the project to foster community development.

When the Cure Becomes the Contagion

Perhaps the most troubling insight from the research is how Sårbarheten har infekterat AI-modellerna själva. Eftersom stora språkmodeller utbildas på stora troves av offentlig kod från GitHub, har de lärt sig det osäkra mönstret som standardpraxis. Forskarna upptäckte att när de blev ombedda att skapa en enkel filserver skulle många populära LLM: er med säkerhet reproducera det 15-åriga felet, även när de uttryckligen uppmanades att skriva en säker version.

Detta”förgiftade LLM”-problem är ett snabbt växande problem. Enligt Endor Labs , en häpnadsväckande 62% av AI-genererad kod innehåller buggar eller säkerhetsfel. Utmaningen är inte längre bara att fixa äldre kod, men att säkerställa att verktygen som bygger framtida kod inte upprätthåller tidigare misstag.

Det akademiska projektet är en viktig strid i ett större, eskalerande AI-vapenkapp för cybersäkerhet. Fältet ser en massiv tillströmning av investeringar och innovation när företag rusar för att bygga AI-drivna försvar.

Denna trend accelererar. In March 2025, security firm Detectify announced a system it calls “Alfred,”which he described as a tool for “creating a sleepless ethical hacker who is Autonomt samla in hotintelligens, prioritera sårbarheter och bygga nyttolastbaserade säkerhetstester.”

Denna innovationsvåg understryker en grundläggande förändring. Forskarprojektet, även om det är akademiskt, är ett kraftfullt bevis-av-koncept inom ett område som nu definieras av en dubbel utmaning: utnyttja AI som ett kraftfullt defensivt vapen samtidigt som de nya säkerhetsrisker som AI själv skapar. Framtiden för mjukvarusäkerhet kommer sannolikt att bero på vem som kan behärska denna komplexa balansåtgärd först.