till och med metapattformar är inte immun mot de häpnadsväckande kostnaderna för AI-loppet. Företaget tillbringade delar av det senaste året närmar sig konkurrenter, inklusive Microsoft, Amazon och andra och sökte ekonomisk hjälp för att utbilda sina flaggskepp lama stora språkmodeller, enligt fyra individer som informeras om diskussionerna .

Dessa överturer, som enligt uppgift kallades”Llama Consortium”-planet, drevs av oro inom Meta om de eskalerande resurserna som behövs för dess konstgjorda intelligensutveckling, sade två personer. Som en sötningsmedel diskuterade Meta tydligen att ge potentiella ekonomiska stödjare ett ord i Llamas framtida funktionsutveckling.

Källor tyder på att den första reaktionen på Metas förslag var ljummet, och det är osäkert om några formella finansieringsavtal träffades. Still, the attempt reveals the intense financial burden involved in building leading AI systems, putting pressure even on companies with Meta’s deep pockets and signalling the high stakes in generative AI.

Llama 4 – Metas senaste modeller

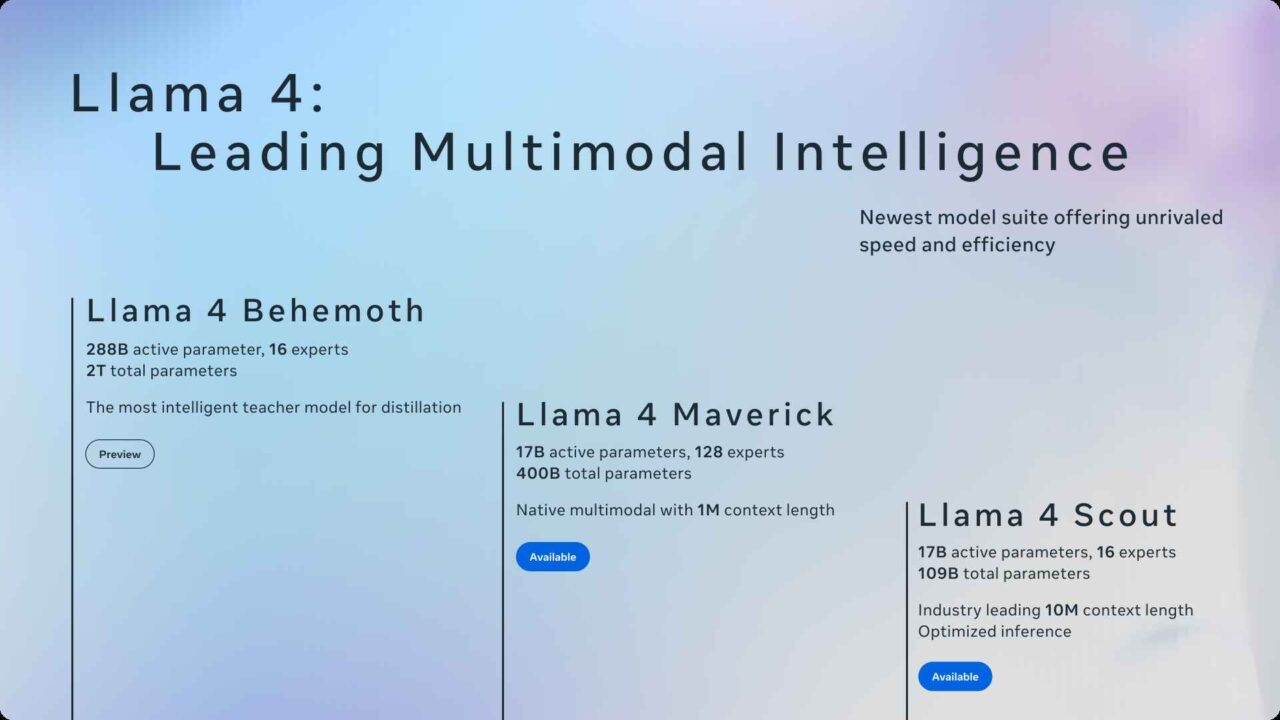

Metas sökning efter finansieringspartners kastar sitt senaste Llama 4-tillkännagivande i ett nytt ljus. Den utgåvan introducerade Llama 4 Scout (109B totala parametrar, 17b aktiv) riktad till enstaka GPU-användning med ett exceptionellt stort 10 miljoner token-kontextfönster-som kan bearbeta ungefär 7,5 miljoner ord på en gång.

Det avslöjade också det mycket större lama 4 maverick (400b total parameters, 17b aktiva, 128 experter) för större arbetslast. Båda använder en blandning av experter (MOE) arkitektur, en teknik som använder specialiserade undernätverk (‘experter’) där endast de nödvändiga är aktiverade per uppgift, som syftar till större effektivitet under drift jämfört med täta modeller där alla parametrar alltid används.

de också byggdes med infödda multimodalitet, hanterar text och bilder tillsammans tillsammans med tidiga fusion, snarare än att lägga till, därefter senare.

som ligger till grund för dessa är den ännu inte utelämnade Llama 4 Behemoth, en 2-biljon parametermodell som används internt för destillation (undervisning av mindre modeller), som krävde utbildning över upp till 32 000 GPU: er. Meta employed techniques like FP8 precision – a lower-precision number format that speeds up calculations – and novel architectural components like interleaved rotary positional embeddings (iRoPE) to handle long sequences effectively.

Building, training, and refining models of this scale and complexity—integrating MoE, multimodality, advanced positional encoding, and achieving competitive benchmarks—inherently Kräver enorm beräkningskraft och teknisk ansträngning och förklarar direkt det potentiella behovet av delade investeringar. Medan MOE erbjuder potentiell inferenseffektivitet förblir utbildningskostnaden i förväg en betydande faktor.

Utvecklingshinder och datafrågor

Beyond Raw Compute, meta dedikerade resurser för att ställa in Llama 4 för specifika utgångar och säkerhet. Företaget uppgav offentligt att sitt mål motverkade upplevda politiska fördomar i LLM och noterade: “Det är välkänt att alla ledande LLM: er har haft problem med förspänning-specifikt har de historiskt lutat sig när det gäller debatterade politiska och sociala ämnen… Detta beror på de typer av träningsdata på Internet.”Vid sidan av att distribuera säkerhetsverktyg som Llama Guard och getrödlagssystemet-en metod för motståndare för att hitta sårbarheter. Dessa finjusterings-och säkerhetslager lägger till vidareutvecklingsjakter.

Potentiellt lägger till Metas finansiella beräkning är ihållande juridiska frågor om dess utbildningsdata, vilket representerar en annan aspekt av utvecklingsutmaningar och kostnader. Aktiva stämningar, inklusive en som involverar komiker Sarah Silverman, hävdar att företaget utbildade Llama-modeller på massiva datasätt av piratkopierade böcker som kommer från bibliotek som Libgen via BitTorrent File-delning. Domstolsdokument avslöjade enligt uppgift intern uppfattning, med en ingenjör som citeras för att säga,”Torrenting från en [meta-ägd] företagens bärbara dator känns inte rätt.”

anklagelser dök upp i slutet av mars 2025 att meta kan också ha uppladdat ungefär 30% av denna information, potentiellt försvagande”rättvisa”argument och ökande potentiella rättsliga eventuella kostnader. Sådana kontroverser kan representera en betydande, om mindre synlig, drivkraft för övergripande AI-utvecklingskostnader.

strategiska spel inom ett konkurrenskraftigt område

Metas finansiering i linje med sin tydliga strategi för att göra Lama Central i sin verksamhet. Modellerna integrerades i Meta AI-funktioner över WhatsApp, Instagram och Facebook kort efter lanseringen. De gjordes också tillgängliga för nedladdning och via molnpartners-inklusive Amazon Sagemaker Jumpstart och Microsofts -men särskilt under en anpassad kommersiell licens, inte en typisk öppen källkod. Denna kontrollerade frisläppningsstrategi håller Meta involverad i Llamas distribution, och balanserade öppenhet med kommersiella intressen.

Ytterligare understrykning av Metas fokus på sin egen AI var dess rörelse, rapporterade runt för att blockera Apples systembredda Apple-intelligensfunktioner inom META: s iOS-appar. Detta förhindrar iPhone-användare från att använda Apples AI-skrivverktyg eller GenMoji i Facebook eller Instagram, och pressar dem mot Metas Llama-baserade alternativ istället.

Denna konkurrensmanöver hände trots tidigare, misslyckade samtal i mitten av 2024 om ett potentiellt AI-partnerskap mellan META och Apple, rapporterade om slut. Metas tillvägagångssätt skiljer sig också från Apples mer sekretessfokuserade, ofta på enhetsmodell, en åtskillnad som framhävs av Metas offentliga diskussion om att stämma Llama 4: s politiska lutningar och dess samtidiga, kontroversiella återkoppling av tredjepartsfakta-faktakontroll i USA med början av januari 2025.

meta planerar att dela mer detaljer vid dess Llamacon-evenemang Planerad till 29 april, vilket potentiellt erbjuder uppdateringar om den massiva Behemoth-modellen eller den kommande Llama 4-V Vision.