Qualcomm ka hyrë në një partneritet me projektuesin e procesorit të serverëve Arm Ampere Computing për të forcuar aftësitë e infrastrukturës së AI. Ky bashkëpunim u zbulua gjatë përditësimit vjetor të strategjisë dhe udhërrëfyesit të Ampere, duke prezantuar një server 2U të pajisur me tetë përshpejtues Qualcomm AI 100 Ultra dhe 192 bërthama CPU Ampere për konkluzionet e mësimit të makinës.

Qualcomm Cloud AI 100 Ultra ofron një zgjidhje konkluzionesh të AI të optimizuar me performancë dhe kosto të përshtatur për AI gjeneruese dhe modele të mëdha gjuhësore (LLM). Ai përmban deri në 576 MB SRAM në linjë dhe 64 bërthama AI për kartë, duke plotësuar nevojat e veçanta të shkallëzimit të ngarkesave klasike dhe gjeneruese të AI, duke përfshirë vizionin kompjuterik, përpunimin e gjuhës natyrore dhe LLM-të e bazuara në transformator.

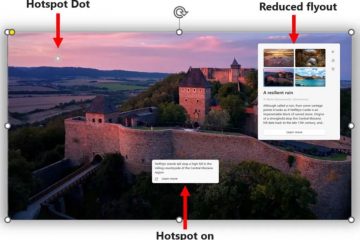

Zgjidhjet e ARM AI me densitet të lartë

Ampere thotë se ky konfigurim mund të mbështesë deri në 56 përshpejtues të AI dhe 1,344 bërthama llogaritëse në një raft standard 12,5 kW, duke eliminuar nevojën për të shtrenjtë sistemet e ftohjes së lëngshme. Kompania njoftoi gjithashtu se procesori i saj i fundit i serverit do të ketë 256 bërthama CPU dhe deri në 12 kanale memorie, duke kaluar në teknologjinë e procesit 3nm të TSMC vitin e ardhshëm.

Ampere dhe Oracle kanë demonstruar se modelet e mëdha të gjuhës (LLM) mund të funksionojnë në CPU, megjithëse me disa kufizime. CPU-të në përgjithësi janë më të përshtatshme për modele më të vogla me shtatë deri në tetë miliardë parametra dhe madhësi më të vogla të grupeve. Përshpejtuesit AI 100 të Qualcomm, me gjerësinë e brezit të tyre më të lartë të memories, janë projektuar për të trajtuar modele më të mëdha ose madhësi më të larta të grupeve, duke i bërë ata më efikas për detyrat e konkludimit.