Hugging Face ka nisur një iniciativë për t’i ofruar publikut një llogaritje GPU me vlerë 10 milionë dollarë, duke synuar të lehtësojë tendosjen financiare në ekipet më të vogla të zhvillimit të AI. Programi, i quajtur ZeroGPU, u prezantua nga CEO Clem Delangue në X.

Drejtimi i pabarazive të burimeve

Delangue theksoi hendekun e burimeve midis kompanive të mëdha të teknologjisë dhe komunitetit me burim të hapur, të cilit shpesh i mungon infrastruktura e nevojshme për të trajnuar dhe vendosur modele të AI. Kjo pabarazi ka kontribuar në dominimin e aplikacioneve si ChatGPT. ZeroGPU synon të kapërcejë këtë boshllëk duke ofruar infrastrukturë të përbashkët për zhvilluesit e pavarur dhe akademikë të AI për të ekzekutuar demonstrime të AI në Hugging Face Spaces, duke reduktuar kështu barrën e tyre financiare.

GPU-Poor jo më shumë: shumë i emocionuar për të. lëshon zyrtarisht ZeroGPU në beta sot. Urime @victormustar dhe ekipit për publikimin!

Në muajt e fundit, komuniteti i AI me burim të hapur ka lulëzuar. Jo vetëm Meta, por edhe Apple, NVIDIA, Bytedance, Snowflake, Databricks, Microsoft,… pic.twitter.com/6UzWvYhmpw

— clem 🤗 (@ClementDelangue) 16 maj 2024

E themeluar në vitin 2016, Hugging Face është bërë ofruesi kryesor i modeleve të AI me burim të hapur të optimizuar për platforma të ndryshme harduerike, falë partneriteteve me gjigantët e industrisë si Nvidia, Intel dhe AMD. Delangue e sheh burimin e hapur si të ardhmen e inovacionit dhe adoptimit të AI, dhe nisma ZeroGPU është një hap drejt demokratizimit të aksesit në burimet thelbësore.

Infrastruktura e përbashkët GPU

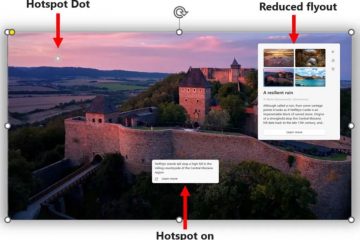

ZeroGPU do të jetë i aksesueshëm përmes shërbimit të pritjes së aplikacioneve të Hugging Face dhe do të përdorë përshpejtuesit më të vjetër A100 të Nvidia në baza të përbashkëta. Ndryshe nga ofruesit tradicionalë të reve kompjuterike që shpesh kërkojnë angazhime afatgjata për marrjen me qira të GPU-ve me kosto efektive, qasja e Hugging Face lejon përdorim më fleksibël, gjë që është e dobishme për zhvilluesit më të vegjël që nuk mund të parashikojnë suksesin e modeleve të tyre paraprakisht. Kjo infrastrukturë e përbashkët fillimisht është e kufizuar në konkluzionet e AI dhe jo në trajnime, për shkak të burimeve të konsiderueshme llogaritëse që kërkohen për trajnimin edhe të modeleve të vogla.

Dokumentacioni mbështetës tregon se funksionet e GPU-së janë të kufizuara në 120 sekonda, gjë që është e pamjaftueshme për të. qëllimet e trajnimit. Një zëdhënës i Hugging Face ka konfirmuar se fokusi është kryesisht në konkluzionet, megjithëse ka plane për të eksploruar aplikacione të tjera në të ardhmen.

Zbatimi teknik

The Specifikat teknike se si Hugging Face arrin të ndajë burimet e GPU në mënyrë efikase mbeten disi të paqarta. Delangue përmend se sistemi mund të”mbajë dhe lëshojë në mënyrë efikase GPU-të sipas nevojës”, por mekanizmat e saktë nuk janë të detajuara. Metodat e mundshme përfshijnë ndarjen e kohës për të ekzekutuar ngarkesa të shumta pune njëkohësisht, Teknologjia GPU (MIG) me shumë instanca të Nvidia dhe Kontejnerët e përshpejtuar me GPU të orkestruara nga Kubernetes. Këto teknika janë përdorur nga ofrues të tjerë të resë kompjuterike për ta bërë llogaritjen GPU më të aksesueshme.

GPU-të A100 që përdoren kanë një memorie 40 GB. kapaciteti, i cili mund të mbështesë ngarkesa të konsiderueshme, por të kufizuara të modeleve, ZeroGPU do të jetë i disponueshëm përmes Hugging Face’s Spaces, një platformë pritëse për publikimin e aplikacioneve, e cila ka mbi 300,000 demonstrime të AI të krijuara deri tani në CPU ose GPU me pagesë.

<. fortë>Financimi dhe Vizioni

Angazhimi i Hugging Face ndaj kësaj nisme është bërë i mundur nga stabiliteti i saj financiar, pasi kompania është”profitabile, ose afër fitimprurëse”dhe së fundmi ka mbledhur 235 milionë dollarë fonde, duke e vlerësuar atë në 4.5 miliardë dollarë. Delangue shprehu shqetësime në lidhje me aftësinë e startupeve të AI për të konkurruar me gjigantët e teknologjisë, të cilët mbajnë përparime të rëndësishme në AI dhe kanë burime të konsiderueshme llogaritëse. Hugging Face synon t’i bëjë teknologjitë e avancuara të AI të aksesueshme për të gjithë, jo vetëm për gjigantët e teknologjisë.

Ndikimi në komunitet

Qasja në llogaritje paraqet një sfidë të rëndësishme për ndërtimin e madh të madh. modele gjuhësore, shpesh duke favorizuar kompani si OpenAI dhe Anthropic. Andrew Reed, një inxhinier i mësimit të makinerive në Hugging Face, krijoi një aplikacion që vizualizon përparimin e LLM-ve të pronarit dhe me burim të hapur me kalimin e kohës, duke treguar hendekun midis të dyve që afrohen më shumë. Mbi 35,000 variacione të modelit AI me burim të hapur të Metës, Llama, janë shpërndarë në Hugging Face që nga versioni i parë i Metës një vit më parë.