OpenAI po përballet me trazira të brendshme pasi ekipi i tij Superalignment, përgjegjës për menaxhimin dhe drejtimin e sistemeve”superinteligjente”të AI, përballet me kufizime të rënda të burimeve. Ekipi, i cili fillimisht premtoi 20% të burimeve llogaritëse të kompanisë, ka pasur shpesh kërkesat e tij për madje një pjesë e kësaj llogaritje u mohua, sipas një burimi të brendshëm.

Dorëheqjet kryesore dhe deklaratat publike

Çështjet e shpërndarjes së burimeve kanë çuar në dorëheqjen e disa ekipeve. anëtarë, duke përfshirë bashkë-udhëheqësin Jan Leike, një ish-kërkues i DeepMind, i cili ka luajtur një rol të rëndësishëm në zhvillimin e ChatGPT, GPT-4 dhe InstructGPT, citoi publikisht mosmarrëveshjet me udhëheqjen e OpenAI në lidhje me prioritetet thelbësore të kompanisë. Në një seri postimesh në X, Leike shprehu shqetësime për fokusin e kompanisë, duke deklaruar se duhet t’i kushtohet më shumë përpjekje përgatitjes për AI në të ardhmen modele, duke theksuar sigurinë, monitorimin, sigurinë dhe ndikimin shoqëror.

Dje ishte dita ime e fundit si shef i shtrirjes, drejtues i superlinjës dhe ekzekutiv @OpenAI.

— Jan Leike (@janleike) 17 maj 2024

Formimi dhe objektivat e Ekipit Superalignment

I formuar në korrik të vitit të kaluar, ekipi i Superalignment u drejtua nga Leike dhe bashkëthemeluesi i OpenAI Ilya Sutskever. Ekipi synoi të adresonte sfidat teknike të kontrollit të AI superinteligjente brenda katër viteve. Ai përfshinte shkencëtarë dhe inxhinierë nga divizioni i shtrirjes së OpenAI dhe studiues nga organizata të tjera. Misioni i ekipit ishte të kontribuonte në sigurinë e modeleve të AI përmes kërkimit dhe një programi granti që mbështeti studiues të jashtëm.

Megjithë publikimin e kërkimeve për sigurinë dhe shpërndarjen e miliona granteve, ekipi i Superalignment luftoi ndërsa udhëheqja e OpenAI u fokusua gjithnjë e më shumë në lansimet e produkteve. Konflikti i brendshëm u përkeqësua nga largimi i Sutskever, pas një përpjekjeje të dështuar nga ish-bordi i OpenAI për të rrëzuar CEO Sam Altman. Roli i Sutskever ishte thelbësor në lidhjen e ekipit të Superalignment me divizione të tjera dhe në mbrojtjen e rëndësisë së tij për vendimmarrësit kryesorë.

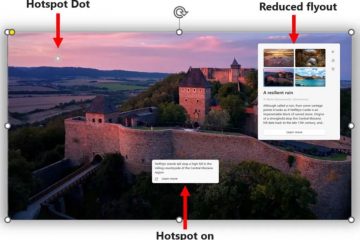

[përmbajtja e integruar]

Shkarkimet dhe largimet shtesë

Trazirat brenda ekipit të Superalignment panë gjithashtu shkarkimin e dy studiuesve, Leopold Aschenbrenner dhe Pavel Izmailov, për nxjerrje të sekreteve të kompanisë. Një tjetër anëtar i ekipit, William Saunders, u largua nga OpenAI në shkurt. Për më tepër, dy studiues të OpenAI që punojnë në politikën dhe qeverisjen e AI, Cullen O’Keefe dhe Daniel Kokotajlo, duket se është larguar nga kompania kohët e fundit. OpenAI nuk pranoi të komentojë largimet e Sutskever ose anëtarëve të tjerë të ekipit të Superalignment, ose të ardhmen e punës së tij mbi rreziqet afatgjata të AI.

Pas dorëheqjeve, John Schulman, një tjetër bashkëthemelues i OpenAI, ka marrë përgjegjësinë për punën e trajtuar më parë nga ekipi i Superalignment. Megjithatë, ekipi nuk do të ekzistojë më si një entitet i dedikuar; në vend të kësaj, funksionet e tij do të integrohen në divizione të ndryshme në të gjithë kompaninë. Një zëdhënës i OpenAI e ka përshkruar këtë ndryshim si një lëvizje për të”integruar [ekipin] më thellë”, megjithëse ka shqetësime se ky integrim mund të zbehë fokusin në sigurinë e AI.

Siguria më e gjerë e AI e OpenAI. Përpjekjet

Shpërbërja e ekipit Superalignment ngre pyetje në lidhje me angazhimin e OpenAI për të garantuar sigurinë dhe përafrimin e zhvillimeve të tij të AI, OpenAI mban një grup tjetër kërkimor të quajtur Ekipi i Përgatitjes, i cili fokusohet në çështje si privatësia , manipulimi emocional dhe rreziqet e sigurisë kibernetike Kompania ka qenë gjithashtu herët për të zhvilluar dhe lëshuar publikisht projekte eksperimentale të AI, duke përfshirë një version të ri të ChatGPT të bazuar në modelin e ri multimodal GPT-4o, i cili lejon ChatGPT të shohë botën dhe të bisedojë në një mënyrë. Mënyrë më e natyrshme dhe njerëzore Gjatë një demonstrimi të transmetuar drejtpërdrejt, versioni i ri i ChatGPT imitoi emocionet njerëzore dhe u përpoq të flirtonte me përdoruesit.

Karta e OpenAI e lidh atë me zhvillimin e sigurt të inteligjencës së përgjithshme artificiale për të mirën e njerëzimit. Ekipi i Superalignment u pozicionua publikisht si ekipi kryesor që punon për problemin e kontrollit të AI potencialisht superinteligjente. Konfliktet e fundit të brendshme dhe çështjet e shpërndarjes së burimeve hedhin një hije mbi misionin e kompanisë për të zhvilluar me përgjegjësi AI.