Modeli më i fundit multimodal i OpenAI GPT-4o po përballet me shqyrtim për shkak të problemeve me të dhënat e tij të shenjave kineze. Problemet rrjedhin nga proceset joadekuate të pastrimit të të dhënave, duke çuar në probleme të mundshme të performancës dhe keqpërdorim, sipas një studiuesi që kishte një vështrim më të afërt në bibliotekën publike të shenjave të GPT-4o.

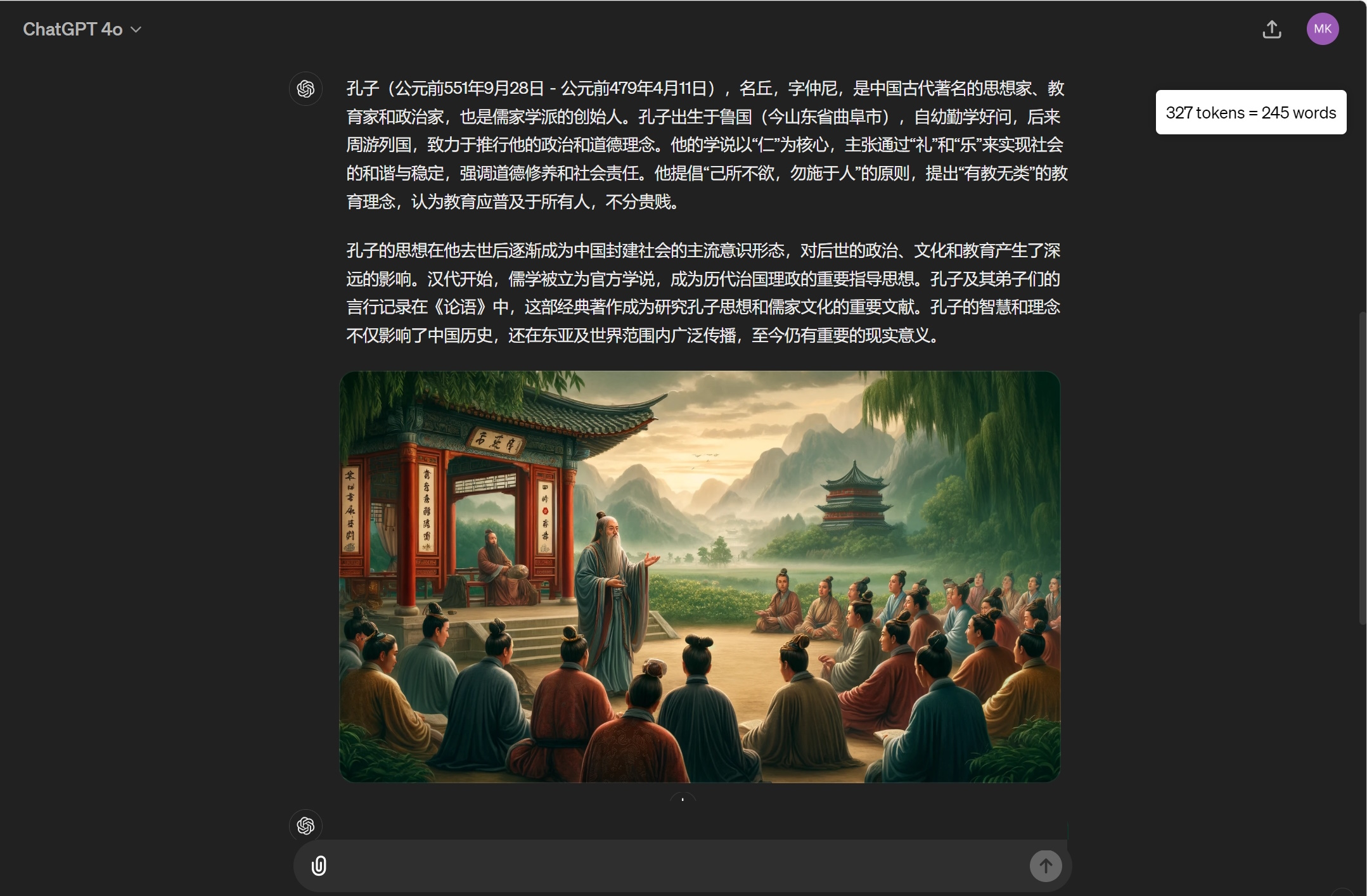

Xhenetet janë njësitë bazë në modelet gjuhësore. që përfaqësojnë fjalë, shprehje ose karaktere. Ato lejojnë modelin të përpunojë tekstin në mënyrë më efikase duke njohur vargjet e qëndrueshme të karaktereve. Tokenizuesi i ri i GPT-4o përfshin 200,000 argumente, me 25% në gjuhët jo-anglisht, që synojnë përmirësimin e detyrave shumëgjuhëshe. Megjithatë, shenjat kineze janë kryesisht fraza të padëshiruara dhe pornografike, të cilat nuk përdoren zakonisht në gjuhën e përditshme. Kjo mospërputhje është për shkak të filtrimit të pamjaftueshëm të të dhënave gjatë fazës së trajnimit.

Ndikimi në performancën e modelit

Prania e këtyre shenjave të papërshtatshme mund të shkaktojë që modeli të gjenerojë modele. përgjigje të pakuptimta ose të palidhura. Studiuesit kanë treguar se këto argumente mund të shfrytëzohen gjithashtu për të anashkaluar mekanizmat e sigurisë të OpenAI, duke i mundësuar modelit të prodhojë përmbajtje të pasigurt. Tianle Cai, një studente doktorature në Universitetin e Princeton, e identifikoi problemin duke analizuar argumentet më të gjata kineze në bibliotekën publike të shenjave të GPT-4o, financ37 ishin të lidhura me lojërat e fatit dhe pornografinë.

Sapo shkrova një skenar për të hetuar më tej se si korpusi i përdorur për të trajnuar tokenizuesin gpt4o është i ndotur nga mashtrimet në internet. Rezultatet janë mjaft interesante… 🤦♂️🤦♂️🤦♂️https://t.co/Fc2T4rSHix https://t.co/Q1Syh9amJn pic.twitter.com/lQ1u5aQoAs

— Tianle Cai (@tianle_cai) 13 maj 2024

Pastrimi dhe zgjidhjet e të dhënave

Ekspertët sugjerojnë se problemi lind nga ndotja e të dhënave të trajnimit nga faqet e internetit të padëshiruara që rrëmbejnë përmbajtje të palidhura për të rritur dukshmërinë e tyre. Ky problem nuk ishte i pranishëm në versionet e mëparshme të tokenizatorit të përdorur në GPT-3.5 dhe GPT-4. Zgjidhjet për këtë problem përfshijnë aplikimin e proceseve rigoroze të pastrimit të të dhënave dhe sigurimin që tokenizuesi dhe modeli i gjuhës janë të trajnuar mbi grupe të qëndrueshme të të dhënave. Teknika të thjeshta, si përkthimi automatik i fjalëve kyçe të zbuluara, mund të reduktojnë ndjeshëm përhapjen e postës së padëshiruar.

Çështja nënvizon rëndësinë e pastrimit të plotë të të dhënave në zhvillimin e modeleve gjuhësore, veçanërisht për gjuhët jo-anglisht. Ndërsa OpenAI vazhdon të përsosë modelet e tij, adresimi i këtyre çështjeve të cilësisë së të dhënave do të jetë thelbësor për përmirësimin e performancës dhe ruajtjen e besimit të përdoruesit.