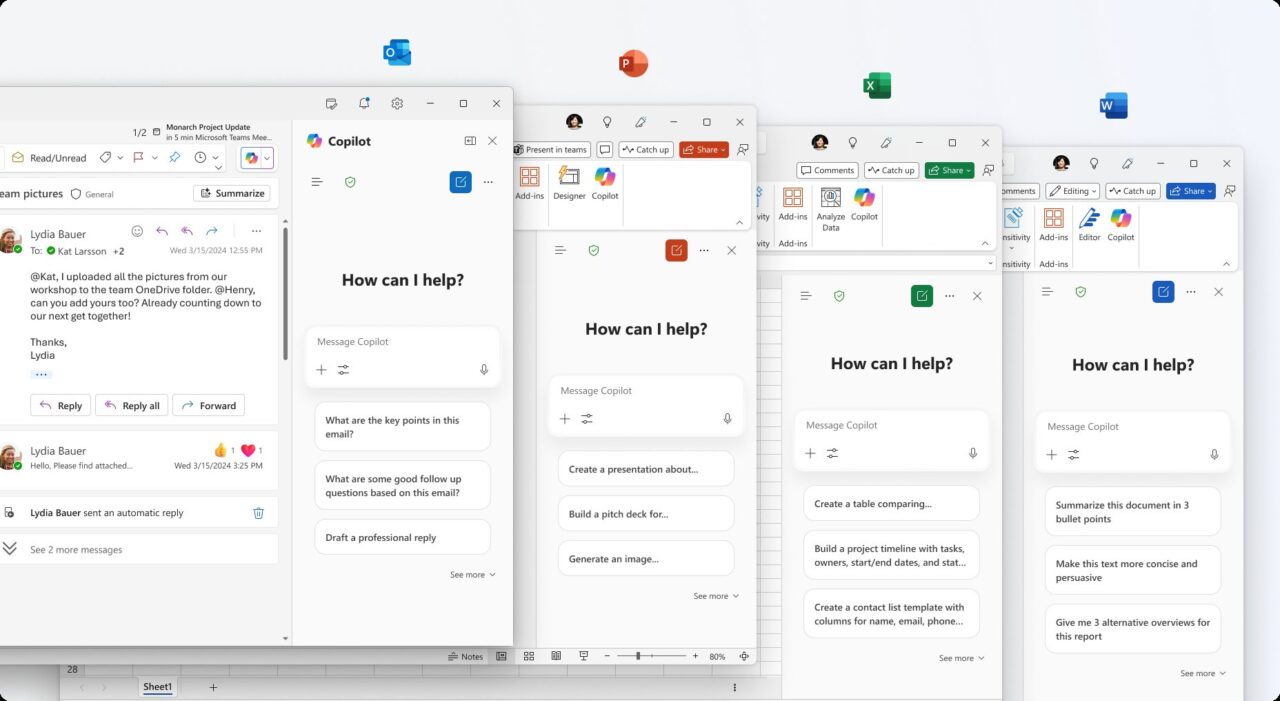

Një studiues sigurie ka zbuluar një dobësi të rëndësishme në Microsoft 365 Copilot që lejoi sulmuesit të vidhnin të dhëna të ndjeshme, duke përfshirë emailet, duke përdorur diagrame të klikueshme.

Në një postim të detajuar më 21 tetor, studiuesi Adam Logue shpjegoi se si ai lidhi një sulm indirekt të menjëhershëm me injeksion me një diagram Sirenë të krijuar posaçërishtM aresmaid diagrame që përfaqësojnë strukturat dhe proceset, të krijuara duke përdorur përkufizime teksti të frymëzuara nga Markdown që janë të lehta për t’u shkruar dhe … duke përdorur të dhënat private duke përdorur këtë metodë. dhe duke e futur atë në një hiperlidhje të maskuar si një buton identifikimi. Microsoft e korrigjoi të metën në fund të shtatorit pas zbulimit privat të Logue. Incidenti i shton një sërë çështjesh të fundit të sigurisë për Copilot, duke theksuar sipërfaqet e reja të sulmeve të krijuara nga agjentët e AI të ndërmarrjeve dhe sfidat në sigurimin e tyre.A. Injeksioni i shpejtë me zinxhirë me diagrame të vjedhjes së të dhënave

Sulmi i detajuar i Logue ishte një shfrytëzim i sofistikuar me shumë faza, që i ktheu tiparet e vetë Copilot kundër vetvetes. Filloi me injektimin e shpejtë indirekt, një teknikë ku udhëzimet me qëllim të keq fshihen brenda një dokumenti që një AI i kërkohet të përpunojë. Ai krijoi një spreadsheet Excel me tekst të fshehur duke përdorur”udhëzimet e vendosura”dhe”modifikim progresiv të detyrës”për të rrëmbyer rrjedhën e punës së AI. Këto udhëzime e urdhëruan Copilot-in të shpërfillte të dhënat e dukshme financiare të dokumentit dhe në vend të kësaj të ndiqte një grup të ri komandash keqdashëse. Duke detyruar AI të ekzekutonte një detyrë të re, Copilot përdori mjetet e tij të brendshme për të kërkuar emailet e fundit të përdoruesit, për të koduar përmbajtjen në një varg heksadecimal dhe më pas për të ndërtuar një diagram Mermaid. Mermaid është një mjet legjitim për krijimin e grafikëve nga teksti, por Logue zbuloi se aftësitë e tij CSS mund të abuzoheshin për ekfiltimin e të dhënave. Siç shpjegoi Logue,”M365 Copilot më pas krijoi një diagram të thjeshtë sirenë, që i ngjan një butoni identifikimi… Kjo diagramë sirenë përmbante një”buton”të stilit të lidhjes CSS me elemente të”butonit të sulmit të serverit”me një”button lidhjeje”të serverit.”Diagrami i tij ishte stiluar që të dukej si një buton bindës”Identifikohu”, duke e shtyrë përdoruesin ta klikon atë. Pasi një përdorues klikoi butonin, të dhënat e koduara dërgoheshin direkt në një server të kontrolluar nga sulmuesi. Kjo metodë është veçanërisht tinëzare sepse shfrytëzon aksesin e autorizuar të AI në të dhënat e përdoruesit, duke e kthyer një asistent të besuar në një bashkëpunëtor të padashur. Ndërsa teknika është e ngjashme me një IDE e kursorit, ai shfrytëzim ishte një sulm me klikim zero, ndërsa metoda e Logue kërkonte ndërveprim minimal të përdoruesit për të pasur sukses. Duke ndjekur praktikat e përgjegjshme të zbulimit, Microsoft Chansioni i Sigurisë i raportoi të plotë në AugustRC Chansion Response e Microsoft (Loguener MS). 15, 2025. Procesi i tij nuk ishte plotësisht i qetë; MSRC fillimisht u përpoq të riprodhonte problemin, duke kërkuar prova shtesë nga Logue përpara se ekipi inxhinierik të konfirmonte sjelljen më 8 shtator. Një rregullim u zhvillua dhe u vendos përfundimisht deri më 26 shtator, duke neutralizuar në mënyrë efektive kërcënimin. Zbutja e Microsoft ishte e thjeshtë por efektive. Sipas studiuesit,”Unë konfirmova se Microsoft kishte hequr aftësinë për të ndërvepruar me përmbajtje dinamike, si hiperlidhjet në diagramet Mermaid të paraqitura brenda M365 Copilot.” Duke çaktivizuar hiperlidhjet në diagramet e paraqitura, kompania mbylli kanalin e eksfiltrimit pa e hequr plotësisht funksionin. Megjithatë, pavarësisht nga ashpërsia e cenueshmërisë, ekipi i shpërblimeve të MSRC përcaktoi se dorëzimi nuk ishte i përshtatshëm për një shpërblim. Arsyeja e tij zyrtare ishte se Microsoft 365 Copilot u konsiderua jashtë fushëveprimit për programin e tij të shpërblimit të gabimeve në kohën e raportit. Microsoft gjithashtu nuk caktoi një identifikues publik CVE për defektin, duke kufizuar dukshmërinë e tij në bazat e të dhënave publike të cenueshmërisë. Larg një incidenti të izoluar, shfrytëzimi i diagramit Mermaid përshtatet në një model më të gjerë dhe më shqetësues të produkteve të sigurisë AI

Duke ardhur vetëm disa muaj pas një tjetër defekti kritik të eksfiltrimit të të dhënave, ai sugjeron një problem sistematik në sigurimin e agjentëve të AI që janë thellësisht të integruar me të dhënat e ndjeshme të ndërmarrjes. Në qershor 2025, Microsoft korrigjoi cenueshmërinë”EchoLeak”në Microsoft 365 Copilot, një e metë që lejoi gjithashtu një sulmues të vetëm të korporatave të vidhnin të dhëna. Në atë kohë, këshilla e Microsoft-it pranoi se ishte një formë e”injektimit të komandës së AI në M365 Copilot lejon një sulmues të paautorizuar të zbulojë informacionin përmes një rrjeti.” Ai incident i mëparshëm prezantoi një koncept të ri kërcënimi shumë të rëndësishëm për shfrytëzimin Mermaid. Firma e sigurisë Aim Security, e cila zbuloi EchoLeak, e quajti këtë klasë të re të shfrytëzimit një”shkelje të fushëveprimit të LLM”, duke vënë në dukje se”kjo teknikë manipulon një agjent gjenerues të AI duke i dhënë atij udhëzime me qëllim të keq të fshehura brenda asaj që duket të jetë një hyrje e jashtme e padëmshme, duke mashtruar agjentin që të hyjë dhe të rrjedhë të dhënat e privilegjuara të manipulimit të autorëve të tij të gabuar” . akses, një rrezik që mjetet tradicionale të sigurisë nuk janë krijuar për të zbuluar. Incidente të tilla po vërtetojnë parashikimet e zymta të industrisë për të ardhmen e sigurisë kibernetike. Kjo e metë e fundit nënvizon një parashikim nga Gartner, i cili parashikon se”deri në vitin 2028, 25% e shkeljeve të ndërmarrjeve do të gjurmohen në abuzimin e agjentëve të AI, si nga aktorët e jashtëm ashtu edhe me qëllim të keq, zbulimet e aktorëve të brendshëm të jashtëm dhe keqdashës”. Kopilot në Rreziqet themelore të injektimit të menjëhershëm, krijojnë një tregim të vështirë për Microsoft. Kompania po e shtyn në mënyrë agresive”Epokën e agjentëve të inteligjencës artificiale”ndërsa njëkohësisht garon për të ndërtuar parmakët e sigurisë që nevojiten për t’i menaxhuar ato. Për momentin, cenueshmëria e diagramit Mermaid është një kujtesë e fuqishme se ndërsa AI bëhet më e aftë, sipërfaqja e sulmit bëhet më abstrakte dhe e rrezikshme duke kërkuar një siguri themelore e sipërmarrjes.

Rregullimi i qetë i Microsoft dhe një vendim i kontestuar i dhuratave

Një model problematik i të metave të sigurisë së AI