Inteligenta artificiala depinde de capacitatea sa de a interpreta date, de a se adapta la medii dinamice si de a lua decizii cu informatii incomplete. În centrul acestor procese se află entropia-o metrică care cuantifică incertitudinea și aleatorietatea.

Inițial cîncepută în termodinamică, entropia joacă acum un rol fundamental în AI, ghidând sisteme pentru a echilibra structura cu flexibilitatea și îmbunătățirea capacității acestora de a gestiona sarcini complexe.

Claude Shannon a redefinit entropia în 1948,

Astăzi, entropia conduce inovații în învățarea automată, crearea de date sintetice, modele generative , învățare prin consolidare și calcul cuantic. Pe măsură ce inteligența artificială devine mai integrantă a tehnologiilor moderne, înțelegerea aplicațiilor entropiei este cheia pentru sisteme mai inteligente și mai adaptabile.

Originile entropiei

Entropia a fost introdusă pentru prima dată. în secolul al XIX-lea, pe măsură ce oamenii de știință au căutat să înțeleagă eficiența energetică în sistemele termodinamice. Studiile de pionier ale lui Sadi Carnot studii despre căldură motoare inspirate de Rudolf Clausius pentru a defini formal entropia.

Clausius a descris-o ca fiind porțiunea de energie dintr-un sistem care nu poate fi convertită în muncă, reflectând tendința universului către o dezordine mai mare. Acest concept termodinamic a pus bazele pentru înțelegerea aleatoriei și ireversibilității în sistemele fizice.

Descoperirea lui Claude Shannon

Claude Shannon a revoluționat entropia aplicând-o sistemelor informaționale. În lucrarea sa fundamentală A Mathematical Theory of Communication, Shannon a descris entropia ca un măsura incertitudinii într-un set de date. El a scris: „Problema fundamentală a comunicării este aceea de a reproduce la un moment dat fie exact, fie aproximativ un mesaj selectat într-un alt punct.”

Entropia lui Shannon a cuantificat impredictibilitatea informațiilor, permițând inginerilor să calculeze eficiența transmisia și compresia datelor. Formula sa a stabilit entropia ca măsură universală pentru măsurarea incertitudinii, legând-o de distribuțiile de probabilitate și creând o bază pentru tehnologiile moderne bazate pe date.

În învățarea automată, entropia evaluează caracterul aleatoriu sau impuritatea din seturile de date, ghidând algoritmii pentru a lua decizii care minimizează incertitudinea

Arborele de decizie, de exemplu, utilizează entropia pentru a determina atributele cele mai informative care maximizează informațiile câștigul sau reducerea entropiei sunt alese ca criterii de împărțire, îmbunătățind acuratețea clasificării modelului.

Luați în considerare un set de date cu etichete de clase mixte: entropia sa mare reflectă imprevizibilitatea. Prin împărțirea datelor în subseturi pe baza unui atribut specific, entropia este redusă, rezultând grupuri mai omogene.

Acest proces iterativ construiește un arbore de decizie care reduce în mod sistematic incertitudinea, creând o structură optimizată pentru predicții precise.

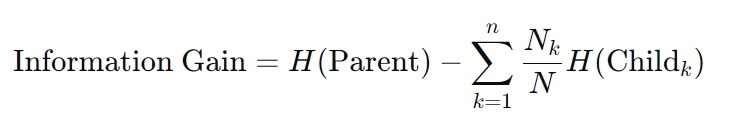

Formula pentru obținerea de informații este următoarea:

Aici, H reprezintă entropia, Nk este numărul de mostre în nodul secundar k-th, iar N este numărul total de eșantioane în nodul părinte. Acest calcul asigură că fiecare decizie reduce la maximum incertitudinea, un principiu de bază pentru algoritmii arborelui de decizie.

Pierderea entropiei încrucișate în rețelele neuronale

Entropia sprijină, de asemenea, optimizarea tehnici în rețelele neuronale. Cross-entropy loss, o metrică utilizată pe scară largă în sarcinile de clasificare, măsoară diferența dintre probabilitățile prezise și etichete reale. Minimizarea acestei pierderi aliniază predicțiile unui model cu rezultatele din lumea reală, îmbunătățind acuratețea.

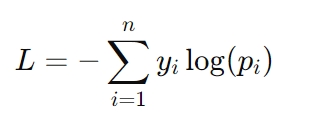

Formula pentru pierderea de entropie încrucișată este:

Aici, yi reprezintă eticheta reală (de exemplu, 0 sau 1), iar pi este probabilitatea estimată pentru acea etichetă. Pierderea entropiei încrucișate este deosebit de critică în sarcini precum recunoașterea imaginilor și modelarea limbajului, unde sunt necesare predicții precise de probabilitate pentru succes.

Rolul entropiei în crearea de date sintetice

Datele sintetice au devenit o resursă esențială în dezvoltarea AI, oferind soluții la provocări precum accesul limitat la seturi de date din lumea reală, preocupările legate de confidențialitate și constrângerile de cost.

Cu toate acestea, eficacitatea seturilor de date sintetice depinde în mare măsură de nivelurile de entropie ale acestora. Datele sintetice cu entropie ridicată introduc variabilitatea necesară pentru a imita condițiile din lumea reală, permițând modelelor AI să se generalizeze mai bine la noile scenarii.

Totuși, entropia excesivă poate introduce zgomot, ceea ce duce la overfitting—unde modelul devine prea adaptat la datele de antrenament și nu reușește să funcționeze bine pe exemple nevăzute.

În contrast, seturile de date cu entropie scăzută simplifică învățarea, dar pot subreprezenta complexitatea datelor din lumea reală. Acest dezechilibru riscă să underfitting, în cazul în care modelele nu reușesc să surprindă modele semnificative, ceea ce duce la o generalizare slabă. Găsirea echilibrului corect între aceste extreme este cheia pentru crearea de date sintetice de înaltă calitate.

Tehnici de optimizare a datelor sintetice cu entropie

Pentru a aborda provocările ridicate prin entropie în seturile de date sintetice, cercetătorii folosesc tehnici avansate care îmbunătățesc calitatea datelor, păstrând în același timp relevanța:

Selectare entropie cu maximizare a similitudinii reale-sintetice (ESRM): ESRM identifică mostre sintetice care oglindesc îndeaproape datele din lumea reală asigurând că seturile de date de formare rămân diverse, dar gestionabile. Echilibrarea entropiei în seturile de date sintetice asigură că modelele sunt antrenate pe exemple diverse, dar relevante, reducând zgomotul, păstrând în același timp utilitatea. Curăţarea şi normalizarea datelor: aceste procese ajută la eliminarea aleatoriei excesive prin alinierea distribuţiilor de date sintetice cu cele ale seturilor de date din lumea reală. Normalizarea asigură că seturile de date sunt compatibile cu algoritmii de învățare automată, facilitând o convergență mai fluidă a modelului. Selectarea caracteristicilor: concentrându-se pe caracteristicile bogate în entropie care oferă cele mai informative informații, selecția caracteristicilor reduce redundanța și zgomotul, făcând datele sintetice mai eficiente pentru antrenamentul modelului.

Aceste metode îmbunătățesc fiabilitatea datelor sintetice, ajutând sistemele AI să obțină o generalizare robustă, fără supraadaptare sau subadaptare.

IA generativă: creativitate și control prin entropie

Generative AI, care include sisteme precum generatoare de text, creatori de imagini și instrumente de sinteză audio, se bazează pe entropie pentru a controla echilibrul dintre creativitate și coerență.

Prin ajustarea pragurilor de entropie, dezvoltatorii pot influența cât de previzibile sau variate sunt rezultatele generate.

De exemplu, o setare cu entropie scăzută asigură că răspunsurile sunt concentrate și relevante, ideal pentru aplicații precum chatbot-uri de serviciu pentru clienți sau asistenți automati de scriere. În schimb, entropia mai mare introduce diversitate și noutate, permițând sarcini creative, cum ar fi generarea de artă sau povestirea.

Acest control este esențial pentru adaptarea AI generativă la cazuri de utilizare specifice. În aplicațiile practice, ajustările entropiei ajută la menținerea unui echilibru între inovație și precizie, asigurând că rezultatele îndeplinesc obiectivele dorite fără a compromite calitatea.

Autentificarea conținutului generat de AI

Entropia joacă, de asemenea, un rol vital în verificarea autenticității conținutului generat de AI. Studiile au arătat că textul generat de inteligență artificială tinde să prezinte entropie mai mică în comparație cu materialul scris de om, ceea ce îl face mai ușor de detectat.

Acest decalaj măsurabil oferă un punct de referință pentru a distinge conținutul sintetic de expresiile umane autentice.

Asemenea valori au aplicații practice în combaterea dezinformării și în asigurarea integrității conținutului generat de IA. Organizațiile folosesc analiza entropiei pentru a identifica potențiala utilizare greșită a IA generativă în deepfake, știri false sau propagandă automată, subliniind importanța crescândă a acesteia în verificarea conținutului.

Învățare prin consolidare: explorarea necunoscutului cu entropie >

În învățare prin consolidare (RL), entropia este esențială pentru menținerea echilibrului delicat între explorare și exploatare. Explorarea implică încercarea de noi acțiuni pentru a descoperi strategii mai bune, în timp ce exploatarea se concentrează pe rafinarea acțiunilor cunoscute pentru a maximiza recompensele. Politicile cu entropie ridicată încurajează selecția diverselor acțiuni, împiedicând agenții să rămână blocați în soluții suboptime.

Acest principiu este deosebit de valoros în medii dinamice, cum ar fi robotica autonomă, IA pentru joc și sistemele logistice adaptive, unde flexibilitatea și adaptabilitatea sunt esențiale.

Regularizarea entropiei—o tehnică care introduce un termen de penalizare bazat pe entropia politicii—asigură că agenții păstrează suficientă aleatorie pentru a explora strategii alternative fără a compromite performanța pe termen lung.

Stabilizarea învățării cu entropie

Metodele de gradient de politică, o clasă de algoritmi RL, beneficiază, de asemenea, de efectele stabilizatoare ale entropiei. Prin menținerea aleatoriei controlate în procesul de luare a deciziilor al agentului, entropia previne convergența prematură și încurajează o explorare mai cuprinzătoare.

Entropia asigură că agenții de învățare de întărire rămân adaptabili, permițându-le să prospere în medii complexe și imprevizibile.

Entropia în calculul cuantic și comprimarea datelor

În calculul cuantic, entropia joacă un rol critic în evaluarea coerenței și încalcării stărilor cuantice. Spre deosebire de sistemele clasice, în care entropia cuantifică dezordinea în distribuțiile de date, entropia cuantică surprinde natura probabilistică a sistemelor cuantice.

Metrici precum von Entropia Neumann sunt utilizate pe scară largă pentru a măsura incertitudinea și a ghida optimizarea cuantice hibride. algoritmi clasici.

Acești algoritmi folosesc entropia cuantică pentru a rezolva probleme care nu sunt fezabile din punct de vedere computațional pentru sistemele clasice, cum ar fi cele complexe sarcini de optimizare, criptografie și simulări ale structurilor moleculare.

De exemplu, entropia von Neumann este esențială în rafinarea rețelelor neuronale cuantice, care îmbină principiile probabilistice ale mecanicii cuantice cu cadrele tradiționale de învățare automată. Entropia realizează o legătură între incertitudinea inerentă mecanicii cuantice și predictibilitatea cerută de sistemele clasice.

Entropia cuantică ajută, de asemenea, la corectarea erorilor, o provocare cheie în calculul cuantic. Prin identificarea și minimizarea surselor de entropie în cadrul sistemelor cuantice, dezvoltatorii pot îmbunătăți stabilitatea și fiabilitatea qubiților, deschizând calea pentru tehnologii cuantice mai robuste.

Comprimarea datelor determinată de entropie

h4>

Entropia stă la baza algoritmilor de comprimare a datelor, permițând stocarea eficientă și transmiterea prin reducerea redundanței, păstrând în același timp informațiile esențiale. Tehnicile de compresie analizează nivelurile de entropie din seturile de date pentru a optimiza schemele de codificare, atingând un echilibru între minimizarea dimensiunilor fișierelor și păstrarea integrității datelor.

Această abordare este deosebit de valoroasă în mediile cu lățime de bandă restrânsă, cum ar fi rețelele IoT și sistemele de calcul edge.

De exemplu, metodele de compresie bazate pe entropie permit dispozitivelor IoT să transmită datele senzorilor mai eficient, reducerea consumului de energie și a lățimii de bandă. Folosind entropia ca măsură de ghidare, aceste sisteme obțin performanțe ridicate fără a compromite acuratețea sau fiabilitatea.

Considerații etice: incluziune, părtinire și transparență

Seturile de date cu entropie ridicată includ adesea exemple diverse și mai puțin comune, cum ar fi datele care reprezintă grupuri subreprezentate. Aceste puncte de date sunt esențiale pentru construirea de sisteme AI echitabile, dar pot fi excluse din neatenție în timpul proceselor de optimizare a entropiei, ceea ce duce la rezultate părtinitoare.

Dezvoltatorii trebuie să se asigure că tehnicile bazate pe entropie țin cont de toate punctele de date relevante pentru a preveni excluderea grupurilor marginalizate.

În IA, în timp ce entropia cuantifică incertitudinea, este responsabilitatea noastră să ne asigurăm că modul în care o gestionăm reflectă un angajament față de corectitudine și incluziune. Construirea de sisteme transparente care acordă prioritate incluziunii nu numai că îmbunătățește corectitudinea, ci și robustețea modelelor de inteligență artificială prin expunerea acestora la o gamă mai largă de scenarii.

Transparența în procesul decizional bazat pe entropie

Deoarece sistemele AI se bazează tot mai mult pe entropie pentru a ghida luarea deciziilor, menținerea transparenței devine esențială. Acest lucru este valabil mai ales în aplicațiile sensibile, cum ar fi asistența medicală și luarea deciziilor juridice, unde mizele sunt mari.

Explicarea modului în care valorile entropiei influențează predicțiile sau deciziile modelului este vitală pentru construirea încrederii și asigurarea răspunderii.

De exemplu, în IA medicală, entropia este adesea folosită pentru a măsura incertitudinea în predicțiile de diagnostic. Prin comunicarea acestei incertitudini profesioniștilor din domeniul sănătății, aceste sisteme permit luarea deciziilor în cunoștință de cauză, reducând decalajul dintre rezultatele algoritmice și expertiza umană.

Extinderea rolului entropiei în IA h3>

IA cuantică reprezintă o convergență între inteligența artificială și calculul cuantic, iar entropia se află în centrul acestei intersecții. Cercetătorii explorează modul în care metricile entropiei cuantice, cum ar fi entropia von Neumann, pot optimiza rețelele neuronale cuantice și alte sisteme hibride.

Aceste progrese sunt promițătoare pentru rezolvarea problemelor complexe în domenii precum logistica, descoperirea de medicamente și comunicațiile securizate.

De exemplu, sistemele cuantice de inteligență artificială ar putea folosi entropia pentru a modela interacțiuni moleculare complexe cu interacțiuni fără precedent. precizie, accelerând descoperirile în domeniul farmaceutic. Combinând punctele forte probabilistice ale sistemelor cuantice cu adaptabilitatea AI, entropia continuă să-și extindă influența în tehnologiile de ultimă oră.

Integrarea în fluxurile de lucru AI

Entropia este din ce în ce mai integrată în fiecare etapă a fluxurilor de lucru AI, de la preprocesarea datelor până la luarea deciziilor în timp real. Acesta servește ca o măsură unificatoare pentru cuantificarea incertitudinii, permițând sistemelor să se adapteze dinamic la condițiile în schimbare.

Această integrare asigură că AI rămâne flexibilă, fiabilă și capabilă să facă față provocărilor mediilor complexe.

Industriile, de la vehicule autonome până la modelarea financiară, beneficiază de abordări bazate pe entropie, care îmbunătăți acuratețea predicțiilor, viteza de luare a deciziilor și adaptabilitatea. Prin integrarea entropiei în nucleul dezvoltării inteligenței artificiale, cercetătorii construiesc sisteme care nu sunt doar robuste din punct de vedere tehnic, ci și aliniate cu obiectivele etice și societale.

Ceea ce urmează

Entropia a evoluat de la un concept termodinamic la o piatră de temelie a inteligenței artificiale. Cuantificând incertitudinea, permite sistemelor AI să echilibreze aleatorietatea și structura, stimulând adaptabilitatea, creativitatea și precizia. Fie că ghidăm algoritmii de învățare automată, gestionăm datele sintetice sau conducem inovații cuantice AI, putem vedea clar cum entropia remodelează modul în care inteligența artificială învață și se adaptează.

Pe măsură ce AI continuă să crească în complexitate și impact, înțelegere și aplicarea entropiei va fi esențială pentru a construi sisteme care nu sunt doar mai inteligente, ci și mai corecte, mai transparente și mai bine echipate pentru a naviga în incertitudinile realului. lume.