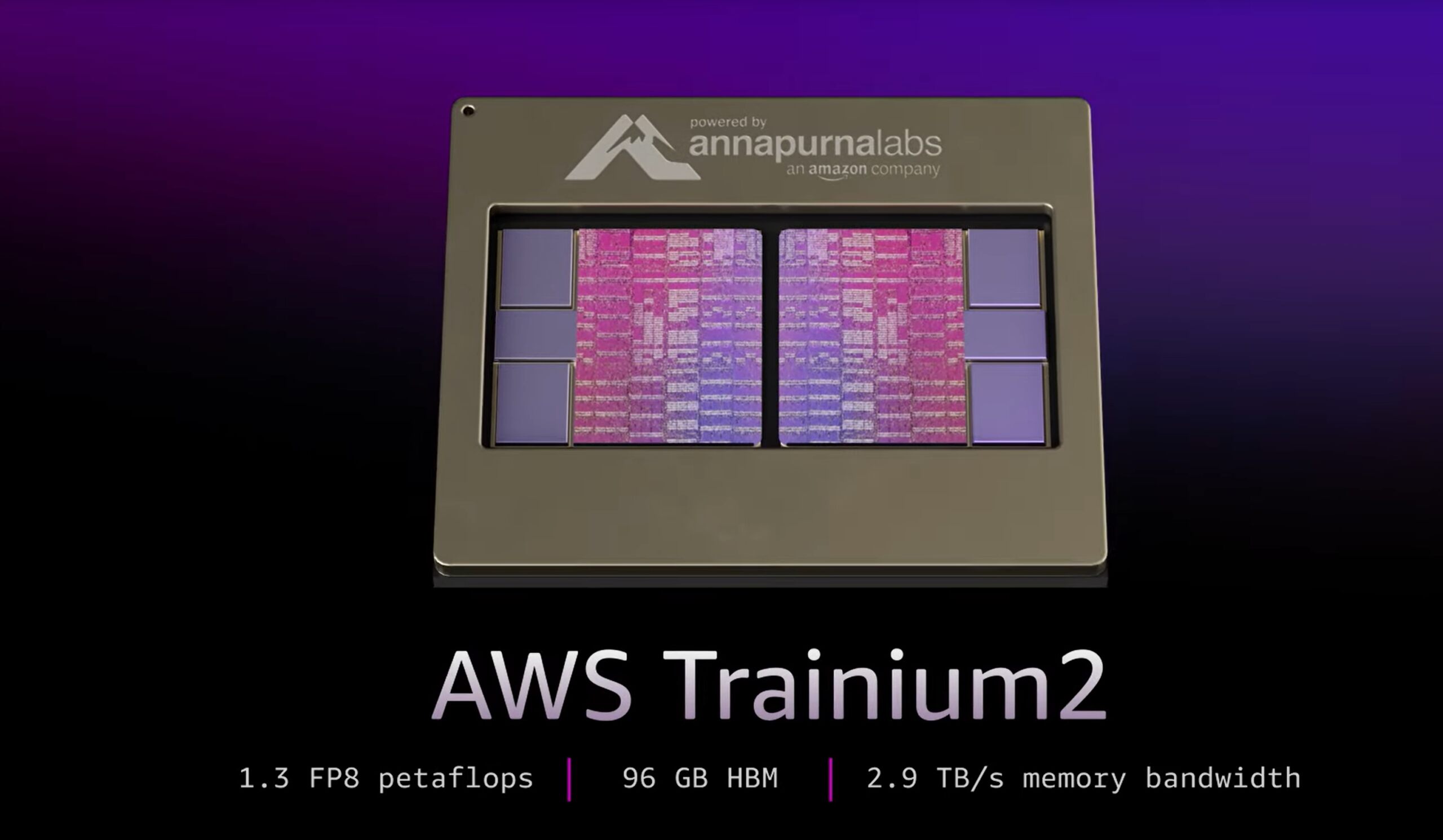

AWS a făcut un salt semnificativ în infrastructura AI prin dezvăluirea cipurilor Trainium2 de a doua generație și prin introducerea Trn2 UltraServers, concepute pentru a depăși limitele performanței modelului de limbaj mare (LLM).

Anunțat la re. Conferința: Invent, aceste evoluții poziționează AWS ca un jucător formidabil în peisajul AI care evoluează rapid. AWS a prezentat, de asemenea, Trainium3, un cip de ultimă generație care promite o creștere de patru ori a performanței, care urmează să fie lansat la sfârșitul anului 2025.

David Brown, vicepreședinte pentru calcul și rețele la AWS, a descris importanța acestor inovații:

„Trainium2 este cel mai performant cip AWS creat până în prezent. Și cu modelele care se apropie de trilioane de parametri, știam că clienții ar avea nevoie de o abordare nouă pentru a antrena și a rula acele modele masive. Noile UltraServere Trn2 oferă cea mai rapidă performanță de instruire și inferență pe AWS pentru cele mai mari modele din lume.”

Trainium2: Deblocarea unui calcul fără precedent Putere

Cipurile Trainium2 sunt proiectate pentru a satisface cerințele de calcul în creștere ale modelelor moderne de inteligență artificială, oferind până la 20,8 petaflopi de calcul dens FP8 per instanță.

Fiecare instanță EC2 Trn2 integrează 16 cipuri Trainium2 conectate prin interconectarea proprietară NeuronLink de la AWS, care asigură o latență redusă și o lățime de bandă mare pentru o scalabilitate perfectă, esențială pentru formarea și implementarea LLM-urilor expansive.

AWS a prezentat capacitățile Trainium2 cu modelul Llama 405B de la Meta, care a atins „de trei ori mai mare producție de generare de simboluri în comparație cu alte oferte disponibile de la furnizorii importanți de cloud”. conform companiei.

Această îmbunătățire accelerează semnificativ sarcini precum generarea de text, rezumatul, și inferență în timp real, abordând cerințele companiilor care se bazează pe IA generativă.

[conținut încorporat]

UltraServere: scalare dincolo de limite

Pentru întreprinderile care abordează modele cu trilioane de parametri, AWS a introdus Trn2 UltraServers, care combină 64 de cipuri Trainium2 pentru a oferi până la 83,2 petaflopi de performanță redusă FP8.

Serverele permit timpi de antrenament mai rapizi și inferențe în timp real pentru modele AI ultra-mari, reprezentând un progres critic pentru companiile care își propun să implementeze sisteme extrem de complexe.

Gadi Hutt, director senior la Annapurna Labs, a explicat capacitățile UltraServers:

„În continuare, depășim acea limită [16-chip] și oferim 64 de cipuri în UltraServer, și asta pentru modele extrem de mari. Deci, dacă aveți un model cu 7 miliarde de parametri, acesta era odinioară mare, dar nu mai-sau un model extrem de mare, să-i spunem 200 de miliarde sau 400 de miliarde. Doriți să serviți la cea mai rapidă latență posibilă. Deci, utilizați UltraServer.”

Colaborare cu Anthropic: construirea celui mai mare cluster AI

AWS a încheiat un parteneriat cu Anthropic pentru a dezvolta Project Ranier, un calculator cluster care va include sute de mii de cipuri Trainium2.

AWS îl descrie ca fiind de cinci ori mai puternic decât sistemele actuale Anthropic și cel mai mare cluster de calcul AI din lume raportat la data. Această colaborare subliniază angajamentul AWS de a-și împuternici partenerii cu tehnologie de ultimă oră.

Anthropic, cunoscut pentru Claude 3.5 Sonnet LLM, se bazează pe infrastructura AWS pentru a menține un avantaj competitiv față de rivali precum OpenAI și Google. AWS și-a dublat recent investiția în Anthropic la 8 miliarde de dolari, consolidându-și concentrarea strategică pe IA generativă.

Trainium3: Modelarea viitorului calculului AI

AWS a anunțat și Trainium3, viitorul său cip construit pe un proces de trei nanometri, care promite să ofere performanțe de patru ori mai mari decât UltraServere. Se așteaptă să se lanseze la sfârșitul anului 2025, Trainium3 va permite antrenament și inferențe și mai rapide pentru modelele AI de generația următoare, consolidând și mai mult liderul AWS în calculul AI.

David Brown a subliniat viziunea AWS pentru noul cip: „Cu ajutorul nostru a treia generație de cipuri Trainium3, vom permite clienților să construiască mai rapid modele mai mari și să ofere performanțe superioare în timp real la implementare ei.”

Strategia AWS cu Trainium3 urmărește să provoace dominația Nvidia pe piața hardware AI. În timp ce viitoarele GPU-uri Blackwell ale Nvidia se laudă cu până la 720 de petaflopi de performanță FP8, soluțiile integrate Trainium de la AWS oferă un cost-eficient și scalabil. alternativă adaptată pentru sarcinile de lucru AI la scară întreprindere.

Suport pentru ecosistem: instrumente pentru Integrare perfectă

Pentru a completa inovațiile sale hardware, AWS oferă Neuron SDK, un set de instrumente de dezvoltare optimizat pentru cadre precum PyTorch și JAX.

SDK-ul include instrumente pentru instruire distribuită și inferență, permițând dezvoltatorilor să folosească cipurile Trainium fără reconfigurare extinsă.

AWS oferă, de asemenea, AMI-uri Deep Learning preconfigurate, asigurând că dezvoltatorii își pot implementa rapid aplicațiile AI.