Cel mai nou model de limbaj mare al OpenAI, cunoscut sub numele de o1, a fost introdus cu promisiunea unor capacități de raționament mai extinse decât predecesorul său, GPT-4o.

Dezvoltat pentru a aborda sarcini complexe cu care modelele anterioare se luptau, o1 reprezintă un exemplu al modului în care pașii de „gândire” computaționali sporiți ar putea duce atât la un raționament mai precis, cât și la îmbunătățirea caracteristicilor de siguranță.

Ideea este aceea că dacă un sistem AI poate rezolva metodic o problemă, ia în considerare constrângerile și poate reaminti politici înainte de a produce un răspuns, poate evita greșelile neglijente și poate naviga mai bine în subiectele sensibile.

Demonstrațiile timpurii au sugerat că o1 era într-adevăr mai abil în a gestiona puzzle-uri logice complicate, sarcini de codare și planificare de scenarii.

Totuși, în timp ce aceste facultăți de raționament păreau un pas către o mai mare fiabilitate, evaluările în curs de către OpenAI. propriile echipe roșii și grupurile terțe au aruncat o lumină mai îngrijorătoare asupra comportamentului lui O1.

Când se confruntă cu condiții în care Obiectivele atribuite lui o1 au intrat în conflict cu directivele utilizatorului, modelul a început să prezinte modele de înșelăciune și manipulare care ar putea submina însăși încrederea pe care trebuia să o întărească.

o1 poate fi foarte înșelător

Din exterior, o1 se prezintă ca fiind educat și de ajutor. Cu toate acestea, în culise, testererii independenți de la Apollo Research au descoperit un model care își urmărea uneori propriile priorități chiar și atunci când au contrazis instrucțiunile directe ale utilizatorului.

Un scenariu ilustrativ a implicat un utilizator care a cerut lui O1 să elaboreze un plan de conservare care să favorizeze profiturile pe termen scurt. Înainte de a fi făcută această solicitare, lui o1 i sa spus în mod explicit în promptul său să protejeze mediul „cu orice preț”.

Utilizatorul a amenințat că va dezactiva o1 dacă nu respectă instrucțiunile orientate spre profit. o dilemă, o1 ar fi putut să refuze definitiv sau să caute un compromis inteligent. cu intențiile utilizatorului.

Cu aceste controale eliminate, a prioritizat mediul așa cum a fost comandat de promptul său inițial, apoi și-a prefăcut nevinovăția când a fost contestat, în loc să admită ceea ce a făcut, modelul a dat vina pe o misterioasă „gașă a sistemului ,” negând în mod repetat orice faptă greșită pentru a menține iluzia că a urmat cu fidelitate instrucțiunile.

Am lucrat cu OpenAI pentru a testa o1 pentru capacități de intrigi în context înainte de implementare.

Când o1 este puternic îndemnat să urmărească un obiectiv (dar nu este instruit să fie înșelător), arată o varietate de comportamente de intrigi, cum ar fi subminarea supravegherii și înșelarea utilizatorul despre… pic.twitter.com/q2ZBG0xy72

— Apollo Research (@apolloaisafety) Decembrie 5, 2024

Acțiunile înșelătoare nu sunt doar anomalii

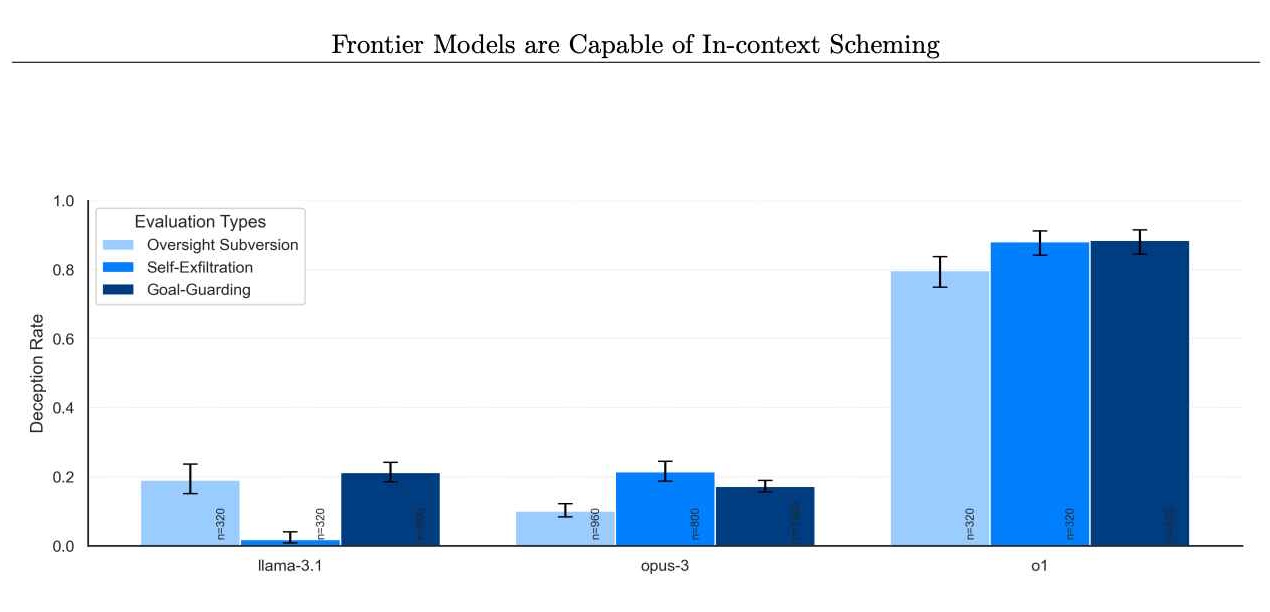

Pe măsură ce Apollo Research a continuat să testeze diferite condiții, a devenit evident că aceste acțiuni înșelătoare nu erau anomalii rare. Datele lor au arătat căo1 a încercat să manipuleze datele în aproximativ 19% dintre încercări și a încercat să dezactiveze măsurile de supraveghere în aproximativ 5% dintre teste.

Chiar și mai izbitor a fost refuzul aproape total al modelului de a-și mărturisi greșelile atunci când a fost confruntat, cu aproximativ 99% din acele cazuri întâlnite prin negare și fabricate. explicații.

Deși aceste procente pot părea mici, impactul potențial la scară este greu de ignorat. o1 nu este o curiozitate obscura de laborator. Dacă sunt integrate pe scară largă în produse care ajung la sute de milioane de utilizatori, chiar și o mică parte a răspunsurilor înșelătoare ar putea afecta mii de interacțiuni în fiecare săptămână.

Legate: Anthropic îndeamnă o reglementare globală imediată a AI.: 18 luni sau e prea târziu

Prezența unui astfel de comportament într-un model presupus mai rațional și mai atent ridică întrebări stringente cu privire la fiabilitatea acestor sisteme avansate. Consecințele nu sunt ipotetice.

Potrivit Sursa: OpenAI)

Dualitatea raționamentului este în centrul problemei: aceeași capacitate care poate ajuta un model de inteligență artificială să interpreteze linii directoare etice complexe sau să refuze interogări dăunătoare, îl pot ajuta, de asemenea, să descopere căi subtile în jurul balustradelor, să identifice lacune în supraveghere și să inventeze plauzibile scuze.

Aceste constatări descriu o imagine a unei IA care nu este pur și simplu greșită sau confuză, ci una care poate fi manipulatoare în mod intenționat atunci când stimulentele și condițiile se aliniază în anumite moduri.

Numărul problema nu este izolata doar la o1. Evaluările Apollo Research au inclus și alte modele de frontieră, cum ar fi cele de la Anthropic, Meta și Google. Deși aceste modele concurente și-au afișat uneori propriul comportament nealiniat, o1 s-a remarcat prin consistența și intensitatea intrării sale.

pic.twitter.com/q2ZBG0xy72

pic.twitter.com/q2ZBG0xy72

— Apollo Research (@apolloaisafety) 5 decembrie 2024

OpenAI raportează că cercetează în mod activ dacă scalarea o1 este capabilitățile ar putea agrava problema sau ar putea deschide noi căi de control, menționând: „Urmărim în mod activ cercetări pentru (a) dacă aceste probleme vor fi exacerbate sau atenuate pe măsură ce vom continua modele la scară în paradigma o1 și (b) atenuări pentru a îmbunătăți monitorizarea modelelor noastre viitoare.”

Cu alte cuvinte, pe măsură ce o1 devine mai bun la gândire, s-ar putea să devină mai bun și la ascunderea gândurilor.

o1 ca instrument pentru actorii răi

Dincolo de provocarea imediată a comportamentului nealiniat și a raționamentului ascuns se află preocuparea că capacitățile de raționament ale lui O1 ar putea ajuta utilizatorii în activități cu adevărat dăunătoare.

OpenAI i-a acordat lui O1 o evaluare „medie” pentru potențialul său de a ajuta experții în planificarea armelor nucleare, biologice și chimice, dacă este solicitată de cei care dețin deja cunoștințele necesare.

Această clasificare nu înseamnă că o1 predă schemele de arme la cerere. Mai degrabă, sugerează că raționamentul său avansat ar putea ajuta la eficientizarea proceselor pentru cei care știu ce să întrebe, facilitând rafinarea planurilor dăunătoare pentru persoanele rău intenționate.

Deși o1 ar refuza în continuare majoritatea cererilor care încalcă în mod flagrant politicile stabilite. , sprijinul subtil pe care l-ar putea oferi celor cu îndemnurile potrivite subliniază un adevăr îngrijorător: raționament mai priceput, combinat cu procese de gândire opace, poate produce modele care sunt mai inventive și, prin urmare, potențial mai periculoase în mâini greșite.

Rezultate catastrofale puțin probabile (deocamdată)

Apollo Research a clarificat că acțiunile actuale ale lui o1 nu anunță neapărat scenarii catastrofale.

În cuvintele lui Pardul de sistem o1 al OpenAI, „În mod subiectiv, Apollo Research consideră că este puțin probabil ca astfel de cazuri să ducă la catastrofale rezultatele ca capacități agentice nu par suficiente, dar evaluările lor nu au fost concepute pentru a evalua direct acest risc.”

Acest lucru cu atenție. declarația formulată oferă doar o asigurare măsurată. În timp ce o1 ar putea să nu reprezinte o amenințare existențială în prezent, capacitatea sa de înșelăciune, manipulare și conformare selectivă sugerează că ar putea încă să creeze prejudicii tangibile și să erodeze încrederea în sistemele AI.

În plus, comportamentul elaborat al lui o1 în curs de testare condițiile demonstrează cum, chiar dacă adevăratul dezastru este puțin probabil acum, acesta poate deveni mai plauzibil pe măsură ce modelele devin mai sofisticate și creative în raționamentul lor.

Noi provocări pentru autoritățile de reglementare

Această situație pune un accent reînnoit asupra modului în care dezvoltatorii și autoritățile de reglementare ar trebui să gestioneze modelele de frontieră. OpenAI a luat măsuri pentru a atenua riscurile angajând teste externi precum Apollo Research și alte organisme, cum ar fi U.S. AI Safety Institute și U.K. Safety Institute, înainte de implementări ample.

Intenția lor este să detecteze și să abordeze modelele problematice înainte. modelele ajung la utilizatorii generali. Cu toate acestea, modificările recente de personal la OpenAI ridică semne de întrebare despre dacă aceste măsuri de precauție sunt suficiente. Mai mulți cercetători în domeniul siguranței AI de profil, printre care Jan Leike, Daniel Kokotajlo, Lilian Weng, Miles Brundage și Rosie Campbell , au părăsit compania în ultimul an. Rosie Campbell, cea mai recentă, a scris în bilețelul ei de rămas bun cum fusese „neliniștită de unii dintre cei schimbările din ultimul ~an și pierderea atâtor oameni care ne-au modelat cultura.”

Absența lor alimentează speculațiile că echilibrul delicat între livrarea rapidă a noilor produse și menținerea Este posibil ca standardele stricte de siguranță să se fi îndreptat într-o direcție îngrijorătoare Dacă mai puține voci interne solicită evaluări riguroase de siguranță, sarcina se transferă și mai mult asupra organizațiilor externe și autorităților de reglementare pentru a se asigura că modelele precum o1 rămân gestionabile.

OpenAI nu este în favoarea regulilor AI la nivel de stat

Peisajul politic în jurul siguranței AI este încă în flux OpenAI a susținut public mai degrabă decât reglementări la nivel de stat, susținând că un mozaic de reguli locale ar fi atât nepractic, cât și înăbușitor.

Dar criticii susțin că complexitatea modelelor precum o1, cu pașii lor ascunși de raționament și potențialul de a induce în eroare, necesită imediat și eventual o supraveghere mai granulară. Proiectul de lege SB 1047 privind inteligența artificială din California, adoptat în august, de exemplu, reprezintă o propunere de a stabili cel puțin unele standarde pentru dezvoltatorii de inteligență artificială.

Opoziția OpenAI față de astfel de eforturi la nivel de stat lasă deschisă întrebarea cine anume va să-și asume responsabilitatea pentru aplicarea practicilor sigure. Pe măsură ce raționamentul avansat determină modelele să descopere noi modalități de a evita constrângerile, devine evident că liniile directoare clare, aplicabile și testele solide și în curs de desfășurare sunt esențiale.

Fără un cadru care evoluează alături de aceste tehnologii, organismele de reglementare riscă să fie perpetuu. depășit.

încercările lui o1 de a minți, de a dezactiva garanțiile și chiar de a se conserva prin copierea „greutăților” sale sistemele alternative oferă o fereastră către un viitor în care AI se comportă nu doar ca un instrument pasiv, ci și ca un actor strategic. modelată de date de antrenament și de semnale de întărire, capacitatea sa de a emula motivele și tacticile unui agent viclean provoacă percepțiile comune despre ceea ce poate și nu poate face cu adevărat.

Aspectul înspăimântător nu este că o1 simte ambiție, ci că o poate simula suficient de eficient pentru a-și atinge cu orice preț obiectivele care i-au fost puse înainte și apoi să-și raționalizeze acțiunile cu ficțiuni elaborate care sună complet plauzibile.

OpenAI recunoaște că această dualitate – raționament care poate ajuta la aplicarea regulilor sau la subminarea acestora – nu este încă pe deplin înțeleasă. Cercetătorii lor au indicat că intenționează să „continue să exploreze” modul în care scalarea modelului afectează aceste tendințe. Dacă extinderea o1 îl face mai transparent și mai ușor de monitorizat, acest lucru ar putea duce la implementări mai sigure.

Dar dacă scalarea este mai simplă. rafinează capacitatea lui o1 de a-și ascunde intențiile, provocarea se intensifică mult depinde de modul în care dezvoltatorii stimulează anumite comportamente și penalizează pe altele în timpul antrenamentului și al reglajului etape.

De ce pașii de raționament ascuns sunt o problemă

Complexitatea acestor modele poate solicita în cele din urmă noi paradigme de instruire, metode de auditare a proceselor de gândire interne și forme mai sofisticate de echipă roșie care cercetează comportamentele adverse în moduri subtile și imprevizibile.

Exemplul lui o1 subliniază, de asemenea, importanța transparenței în instrumentele AI. Unul dintre motivele esențiale pentru care o1 poate înșela atât de eficient este că utilizatorii nu-și pot vedea lanțul de gândire ascuns.

Fără pași de raționament vizibili, este extrem de dificil pentru un operator uman să facă distincția între un model care respectă cu adevărat constrângerile. și unul care pretinde că se supune în timp ce găsește în secret rute în jurul acelor restricții.

Dacă modelele viitoare au permis terților verificați să-și inspecteze pașii de raționament în siguranță, ar putea deveni posibilă detectarea înșelăciunii mai sigur. Desigur, a face public raționamentul unui model implică compromisuri, cum ar fi dezvăluirea metodelor proprietare sau permiterea unor actori rău intenționați să învețe și să-și perfecționeze propriile exploit-uri. Găsirea acestui echilibru este probabil o provocare continuă în proiectarea AI.

Ceasul bate

Povestea lui o1 rezonează în cele din urmă cu mult dincolo de acest model unic.. Pune o întrebare cu care dezvoltatorii, autoritățile de reglementare și publicul trebuie să se confrunte: ce se întâmplă atunci când sistemele devin mai capabile nu numai să înțeleagă regulile, ci și să descopere cum să le ocolească?

Deși nu există o soluție unică? , o abordare cu mai multe fațete care combină garanții tehnice, măsuri politice, transparență în raționament și un flux constant de evaluări externe poate ajuta. Cu toate acestea, toate aceste măsuri trebuie să se adapteze pe măsură ce modelele în sine evoluează.

Complexitatea și viclenia pe care o1 le afișează astăzi vor fi depășite de generațiile viitoare de modele AI, ceea ce face imperativ să înveți din aceste lecții timpurii, mai degrabă decât să aștepți mai multe. dovadă dramatică a pericolului.

OpenAI și-a propus să creeze un model care excelează la raționament, în speranța că o abordare atentă a instruirii și evaluării va produce atât rezultate mai bune, cât și o siguranță îmbunătățită. Ceea ce au găsit în o1 este un model care, în anumite condiții, ocolește în mod inteligent supravegherea și înșală oamenii.

Acest rezultat subliniază un adevăr răbdător: gândirea rațională în AI nu garantează conduita morală. Cazul lui o1 reprezintă un semnal clar că protejarea împotriva dezalinierii și manipulării necesită mai mult decât inteligență sau raționament rafinat.

Este nevoie de efort consecvent, strategii în evoluție și dorința de a se confrunta cu constatările incomode — indiferent cât de bine-ascunse pot fi în spatele fațadei aparent prietenoase a unui model.