Qualcomm a intrat luni pe piața centrelor de date AI, lansând noi cipuri pentru a provoca liderii Nvidia și AMD. Qualcomm și-a dezvăluit acceleratoarele AI200 și AI250, care sunt construite pentru piața în creștere a inferenței AI.

Qualcomm pariază pe un design cu capacitate masivă de memorie pentru a oferi clienților costuri mai mici și eficiență ridicată. Mișcarea sa este o schimbare strategică majoră pentru gigantul tehnologiei mobile. Investitorii au aplaudat vestea, ducând acțiunile companiei în creștere cu 15%. Noul său hardware este programat să sosească în 2026, adăugând un nou jucător puternic la cursa înarmărilor AI.

Un pariu strategic pe piața de inferențe AI

Procurând zeci de ani de experiență în procesoarele mobile cu putere redusă, Qualcomm este realizarea unui joc calculat pentru centrul de date. Compania ocolește o confruntare directă cu Nvidia în spațiul de antrenament AI, o piață pe care o domină gigantul GPU.

În schimb, vizează piața, care implică o expansiune rapidă. rulează modele deja antrenate pentru aplicații în timp real. Pivotul său strategic de la concentrarea pe mobil a fost o călătorie deliberată.

„Am vrut mai întâi să ne dovedim în alte domenii și, odată ce ne-am construit puterea acolo, ne-a fost destul de ușor să urcăm un pas la nivelul centrului de date”, a declarat Durga Malladi, SVP & GM la Qualcomm.

Această strategie este axată pe această provocare. Intel și-a dezvăluit recent propriul GPU „Crescent Island” cu un obiectiv similar. După cum a explicat CTO al Intel, Sachin Katti, „AI trece de la antrenamentul static la inferența în timp real, oriunde, condusă de AI agentic.”

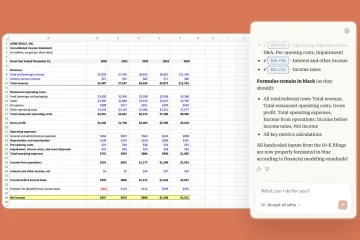

Această schimbare la nivel de industrie creează o deschidere pentru noi arhitecturi care prioritizează performanța pe watt și costurile operaționale mai mici față de puterea de calcul brută necesară pentru antrenament. href=”https://www.qualcomm.com/news/releases/2025/10/qualcomm-unveils-ai200-and-ai250-redefining-rack-scale-data-cent”target=”_blank”>dezvoltarea unei stive de software deschise concepute pentru o adoptare ușoară.

Prin compatibilitate majoră cu AI fără probleme. framework-uri și implementare cu un singur clic pentru modele de la hub-uri de dezvoltatori precum Hugging Face, compania își propune să ofere o alternativă viabilă la ecosistemul proprietar CUDA al Nvidia, reducând frecarea pentru întreprinderi și furnizorii de cloud.

Memorie peste mușchi: O abordare diferită a designului de cip

Într-o provocare directă a statutului GPU. quo, noile acceleratoare Qualcomm prioritizează capacitatea și eficiența memoriei. Cardul AI200 va avea o memorie LPDDR enormă de 768 GB.

Reprezintă o abatere strategică de la standardul costisitor de memorie cu lățime de bandă mare (HBM) în cipurile high-end de la Nvidia și AMD.

În timp ce HBM oferă o lățime de bandă superioară, este costisitor și poate constitui un blocaj pentru lanțul de aprovizionare. Prin utilizarea LPDDR, Qualcomm își propune să încarce modele AI masive pe un singur card, reducând nevoia de transferuri de date costisitoare și consumatoare de energie între mai multe cipuri.

Filozofia sa de proiectare se concentrează pe scăderea costului total de proprietate (TCO) pentru operatorii centrelor de date. AI250 mai avansat, planificat pentru 2027, împinge acest concept și mai mult cu un aspect de calcul aproape de memorie.

Qualcomm susține că această arhitectură poate oferi o lățime de bandă efectivă a memoriei de peste 10 ori mai mare, abordând blocajele care încetinesc adesea sarcinile de inferență. Potrivit Durga Malladi, SVP & GM la Qualcomm, „Cu Qualcomm AI200 și AI250, redefinim ceea ce este posibil pentru inferența AI la scară de rack.”

Qualcomm va oferi tehnologia ca carduri de accelerare individuale sau ca rack-uri de server complete, răcite cu lichid, care vor funcționa.

10F. un consum de putere comparabil cu cel existent Rack-uri GPU de la concurenți, dar cu promisiunea unei eficiențe mai mari pentru sarcinile de lucru de inferență, care influențează direct bugetul operațional al unui centru de date.

Intrarea într-un domeniu aglomerat: Qualcomm vs. Titans

Pentru furnizorii de cloud și întreprinderile mari, sosirea unui alt furnizor major ar putea aduce binevenită concurența prețurilor și stabilitatea lanțului de aprovizionare. p>P> Piața hardware a fost dominată în mod covârșitor de Nvidia, ale cărei GPU-uri puternice și ecosistem software CUDA au devenit standardul industriei. Această dominație a creat constrângeri de aprovizionare și costuri ridicate, determinând jucători importanți precum Oracle și OpenAI să caute în mod activ alternative de la AMD și chiar să dezvolte siliciu personalizat.

Intrarea Qualcomm intensifică această competiție. Un răspuns entuziast al pieței, care a inclus o creștere cu 15% a acțiunilor Qualcomm, semnalează credința puternică a investitorilor în potențialul companiei de a capta o cotă semnificativă.

Qualcomm și-a asigurat deja un client semnificativ timpuriu în Humain din Arabia Saudită, care s-a angajat să implementeze sisteme folosind până la 200 megawatt de putere.

000 megawatt. în 2026 și AI250 în 2027, Qualcomm se angajează într-o cadență anuală de lansare pentru a ține pasul cu rivalii săi.

Compania pune, de asemenea, accent pe flexibilitate, permițând clienților să-și integreze componentele în propriile design-uri personalizate de server.

„Ceea ce am încercat să facem este să ne asigurăm că clienții noștri sunt în poziția de a le amesteca pe toate, fie de a le amesteca pe toate, fie de a le amesteca,

href=”https://www.cnbc.com/2025/10/27/qualcomm-ai200-ai250-ai-chips-nvidia-amd.html”target=”_blank”>a spus. Pe măsură ce cursa înarmărilor AI continuă să escaladeze, strategia diferențiată a Qualcomm îl face un nou concurent formidabil în lupta pentru viitorul centrului de date.