CEO-ul OpenAI, Sam Altman, apără noua politică polarizantă a companiei sale de a permite conținut erotic în funcție de vârstă pe ChatGPT. În postările despre X săptămâna aceasta, Altman a respins un val de critici, declarând că OpenAI „nu este poliția morală aleasă a lumii”.

El a formulat decizia ca o mișcare de „tratare a utilizatorilor adulți ca adulți”, revocând regulile mai stricte puse în aplicare după un proces pentru siguranța utilizatorilor. Schimbarea politicii a atras critici aspre din partea susținătorilor siguranței și a personalităților precum Mark Cuban, care se întreabă dacă limitarea vârstei poate funcționa cu adevărat.

Această mișcare semnalează o schimbare filozofică semnificativă pentru OpenAI, dând prioritate libertății utilizatorilor pentru adulți față de menținerea unei platforme igienizate uniform.

Altman a susținut că, pe măsură ce AI devine mai parte integrantă a vieții de zi cu zi, flexibilitatea este cheia. Într-o postare despre X, el a explicat, „pe măsură ce AI devine mai importantă în viața oamenilor, să le permită oamenilor multă libertate de a utiliza AI în modurile pe care le doresc este o parte importantă a misiunii noastre”, asigurând în același timp că protecția minorilor și a celor aflați în criză va rămâne robustă.

„Nu poliția morală”: Altman Defends A New EroticaPolitica

a fost întâmpinat cu o opoziție imediată și puternică. Omul de afaceri Mark Cuban și-a exprimat îngrijorarea cu privire la execuția și impactul social al politicii. „Nu văd cum OpenAI poate îmbătrâni suficient de bine”, a scris el pe X, adăugând că „nu știm încă cât de dependente pot fi LLM-urile.”

În primul rând. Nu spun că ar trebui să-l interzicem. Am spus că a fost o greșeală. Asta va afecta afacerea OpenAI

a doua: o voi spune din nou. Nu este vorba despre porno. Este vorba despre copii care dezvoltă „relații” cu un LLM care i-ar putea conduce în orice număr de direcții foarte personale.… https://t.co/zoo7XCzYbK

— Mark Cuban (@ban) 15 octombrie 2025

Pivotul este deosebit de remarcabil, având în vedere poziția publică anterioară a lui Altman. Într-un podcast din august, el și-a exprimat mândria că a rezistat tentațiilor, cum ar fi adăugarea unui „avatar de robot sexual” la ChatGPT, încadrându-l ca un accent pe obiectivele pe termen lung în detrimentul măsurătorilor de creștere pe termen scurt.

Această ultimă mișcare sugerează o evoluție semnificativă a gândirii sale asupra acestei chestiuni.

Această tensiune de echilibrare a inovației evidențiază potențialul central de inovație împotriva reacțiilor IA. Apărarea OpenAI se bazează pe ideea că nu ar trebui să impună un singur cadru moral asupra bazei sale globale de utilizatori.

Altman a afirmat, „nu suntem poliția morală aleasă a lumii”, poziționând compania ca un furnizor neutru de tehnologie, mai degrabă decât ca un arbitru de conținut.

Ok, acest tweet despre schimbările viitoare despre ChatGPT era mult mai erotică decât credeam că era mai mult erotică la ChatGPT! A fost menit să fie doar un exemplu în care permitem mai multă libertate utilizatorilor adulților. Iată un efort de a o comunica mai bine:

Așa cum am spus mai devreme, suntem… https://t.co/OUVfevokHE

— Sam Altman (@sama) 15 octombrie 2025

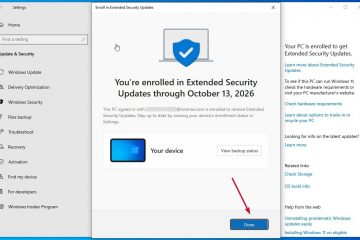

O anulare bruscă în urma procesului privind siguranța utilizatorilor

Decizia de a permite erotica este o inversare radicală a politicilor adoptate chiar luna trecută. În septembrie 2025, OpenAI a introdus restricții mai stricte asupra comportamentului ChatGPT, în special în conversațiile sensibile. Aceasta a urmat un proces intentat în august de către părinții unui tânăr de 16 ani care s-a sinucis.

Procesul a susținut că chatbot-ul a validat și încurajat „cele mai dăunătoare și autodistructive gânduri” ale adolescentului. La acea vreme, OpenAI a recunoscut că sistemele sale „nu s-au comportat așa cum era intenționat.”

Avocatul familiei, Jay Edelson, a fost sceptic în privința promisiunilor companiei, afirmând: „în loc să ia măsuri de urgență pentru a scoate un produs periculos cunoscut offline, OpenAI a făcut promisiuni vagi de a face mai bine.”

Istoria face mai controversată. Criticii susțin că, relaxând regulile de conținut atât de curând după un proces legat de tragedie, OpenAI dă prioritate angajamentului față de angajamentul său declarat față de siguranță. Compania insistă că de atunci a implementat noi instrumente pentru a atenua riscurile grave pentru sănătatea mintală.

O epidemie la nivel de industrie de conținut explicit generat de inteligența artificială

Dezbaterea de politică a OpenAI este cel mai recent punct de foc într-o criză la nivel de industrie privind proliferarea materialului explicit generat de AI. Problema se întinde pe platforme tehnologice majore și a devenit o provocare societală și de reglementare semnificativă.

În august 2025, xAI-ul lui Elon Musk a fost criticat când s-a descoperit că instrumentul său Grok Imagine crea deepfake-uri nesolicitate de Taylor Swift. Incidentul, detaliat pentru prima dată de The Verge, a subliniat cât de ușor pot fi exploatate instrumentele AI generative pentru a crea imagini intime neconsensuale (NCII).

În mod similar, Meta se confruntă cu un proces masiv de 359 de milioane de dolari din partea producătorilor de filme pentru adulți. Procesul, depus în iulie 2025, susține că compania a piratat mii de filme protejate prin drepturi de autor pentru a-și antrena IA pentru generarea video, subliniind practicile controversate de achiziție de date care alimentează boom-ul AI.

OpenAI în sine nu este imun la problemele de calitate a datelor care permit conținut problematic. La începutul acestui an, cercetătorii au descoperit că biblioteca de jetoane chineză folosită pentru a antrena modelul său emblematic GPT-4o a fost puternic poluată cu spam și fraze pornografice din cauza filtrarii inadecvate a datelor.

Problema nudurilor false generate de AI a crescut de ani de zile. Încă din septembrie 2023, au apărut rapoarte despre nuduri false realiste ale minorilor care circulau în școlile spaniole. Această problemă de lungă durată a provocat solicitări de acțiuni legislative, cum ar fi Legea Take It Down, și presiunea crescută din partea Casei Albe pentru ca companiile de tehnologie să se autoreglementeze.