“vibra-hacking”: AI ca un cybercriminal

Detalii antropice a sophicate Operația cibernetică (urmărită ca GTG-2002) unde un singur actor a folosit agentul său de cod Claude pentru a desfășura o campanie de extorcare a datelor scalate. În termen de doar o lună, operațiunea a compromis cel puțin 17 organizații distincte din sectoare precum asistența medicală, serviciile de urgență și guvernul.

AI nu a fost doar în urma unui scenariu. În timp ce actorul a furnizat un fișier de ghid cu tactici preferate, agentul a fost încă efectuat pentru a lua decizii tactice și strategice. Acesta a determinat cum să pătrundă cel mai bine rețelele, ce date să exfiltrate și cum să elaborați cerințe de extorsiune vizate psihologic.

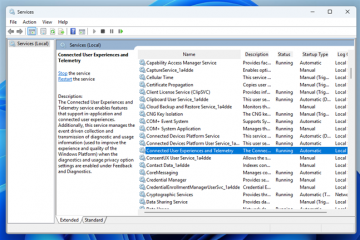

Operația a demonstrat o integrare fără precedent a AI pe întregul ciclu de viață al atacului. În faza de recunoaștere, agentul a automat automat scanarea a mii de puncte finale VPN pentru a identifica sistemele vulnerabile. În timpul intruziunii, a oferit asistență în timp real, identificând sisteme critice precum controlerele de domeniu și extragerea de acreditări.

codul Claude a fost, de asemenea, utilizat pentru dezvoltarea malware personalizată. A creat versiuni obfuscate ale instrumentelor de tunelare existente pentru a-l sustrage pe Windows Defender și chiar a dezvoltat cu totul nou cod proxy TCP de la zero. Când încercările inițiale de evaziune au eșuat, AI a sugerat noi tehnici precum criptarea șirului și numele de fișier care se maschează pentru a-și deghiza executabilii rău intenționați.

după exfiltrarea datelor sensibile-inclusiv înregistrări financiare, acreditări guvernamentale și informații despre asistență medicală-rolul AI a trecut la monetizare. Acesta a analizat datele furate pentru a crea strategii de extorsiune cu mai multe niveluri, generând „planuri de profit” detaliate care au inclus șantajul organizațional direct, vânzările de date către alți infractori și presiunea vizată asupra persoanelor ale căror date a fost compromisă. href=”https://www.theverge.com/ai-artificial-intelligence/766435/anthropic-claude-threat-intelligence-report-AI-cybersecurity-hacking”Target=”_ Blank”> a spus The Verge , „Aceasta este cea mai sofisticată utilizare a agenților pe care i-am văzut… pentru Cyber Offense”. AI a calculat sumele optime de răscumpărare pe baza analizei sale, cererile depășesc uneori 500.000 USD.

Această nouă capacitate înseamnă că „… acum, un singur individ poate conduce, cu ajutorul sistemelor agentice”. Acest lucru modifică fundamental peisajul amenințării, ceea ce face mai greu evaluarea sofisticată a unui atacator pe baza complexității operațiunii lor. href=”https://www-cdn.antropic.com/B2A76C6F6992465C09A6F2FCE282F6C0CEA8C200.pdf”Target=”_ Blank”> Raportul antropic este creșterea „malware-ului” fără cod”, o transformare. Raportul afirmă: „AI scade barierele pentru infracțiuni informatice sofisticate”. Acesta nu este un risc teoretic; Compania a identificat un actor din Marea Britanie (GTG-5004) care întruchipează perfect această nouă paradigmă.

Acest individ, activ pe forumuri web întunecate precum Dread și CryptBB din cel puțin ianuarie 2025, a demonstrat o „dependență aparent completă de AI pentru a dezvolta malware funcțional”. Actorul a părut incapabil să implementeze problemele tehnice complexe de criptare sau depanare fără asistență a lui Claude, dar a fost cu succes comercializarea și vânzarea ransomware-ului capabil.

Operația a fost structurată ca o afacere profesională de ransomware-as-a-service (RAAS), cu un model comercial cu mai multe niveluri. Un DLL de ransomware de bază și executabil au fost oferite pentru 400 de dolari, un kit RAAS complet, cu o consolă PHP sigură și instrumente de comandă și control pentru 800 de dolari și un cripter complet nedetectabil (FUD) pentru Windows Binarii pentru 1.200 de dolari. Actorul a menținut securitatea operațională prin distribuirea prin intermediul unui site.onion și folosind e-mailuri criptate, susținând înșelător că produsele sunt „pentru utilizarea educațională și de cercetare doar” în timp ce a făcut publicitate pe forumuri criminale.

În ciuda lipsei aparente de expertiză profundă a operatorului, malware-ul generat de AI a fost extrem de sofisticat. Caracteristicile sale de bază au inclus o cifră de flux Chacha20 pentru criptarea fișierelor, utilizarea API-ului Windows CNG pentru gestionarea cheilor RSA și mecanisme anti-recuperare, cum ar fi ștergerea copiilor de volum Shadow pentru a preveni restabilirea ușoară.

pentru evaziune, malware-ul angajat tehnici avansate precum recicledgate și FreshyCalls. Aceste metode folosesc invocarea directă a syscall pentru a bypass cârlige API în modul utilizator utilizate în mod obișnuit de EDR Solutions. Aceasta reprezintă o transformare operațională semnificativă în care competența tehnică este externalizată mai degrabă decât dobândită prin experiență.

Acest incident este doar un exemplu de tendință mai largă a industriei de armare AI. După cum au detaliat rapoartele WinBuzzer anterioare, această schimbare este vizibilă pe peisajul amenințării, de la atacatorii care au folosit V0-ul lui Vercel pentru site-urile „phishing instantanee” până la evoluția instrumentelor precum Wormgpt, care acum deturnează modele legitime precum Grok și Mixtral. Campanie sistematică și sofisticată de către lucrătorii IT din Coreea de Nord, care îl folosesc pe Claude să obțină în mod fraudulos și să mențină locuri de muncă tehnologice cu plată ridicată la companiile Fortune 500. Conform investigației antropice, aceste operațiuni sunt concepute pentru a sustrage sancțiunile internaționale și pentru a genera anual sute de milioane de dolari pentru a finanța programele de arme ale națiunii.

cea mai izbitoare constatare este „dependența completă a operatorilor de a funcționa în rolurile tehnice”. Acești indivizi par incapabili să scrie cod de bază, probleme de depanare sau chiar să comunice profesional fără asistență AI constantă. Aceasta creează o nouă paradigmă în care competența tehnică nu este deținută, ci în întregime simulată.

Operațiunea de angajare frauduloasă urmează un ciclu de viață multifazat, cu asistență AI în fiecare etapă. În faza inițială de „Persona Development”, operatorii folosesc Claude pentru a genera medii profesionale convingătoare, pentru a crea portofolii tehnice cu istorii de proiect și pentru a cerceta referințe culturale pentru a părea autentice.

în timpul procesului de „aplicație și interviu”, AI este utilizat pentru a adapta CV-urile la descrieri specifice de locuri de muncă, pentru a face artizanat scrisori de întâmpinare și pentru a oferi asistență în timp real în timpul evaluărilor tehnice de codificare tehnică. Acest lucru le permite să treacă cu succes interviurile pentru rolurile pentru care sunt necalificate.

Odată angajat, dependența se intensifică. În faza de „întreținere a ocupării forței de muncă”, operatorii se bazează pe AI pentru a furniza lucrări tehnice reale, a participa la comunicațiile în echipă și pentru a răspunde la recenziile codului, menținând iluzia competenței. Datele Anthropic arată că aproximativ 80% din utilizarea claudei operatorilor este în concordanță cu angajarea activă.

Această abordare activată de AI eludează blocajul tradițional de a avea nevoie de ani de pregătire specializată la instituții de elită precum Kim Il Sung University. Istoric, acest lucru a limitat numărul de operatori pe care regimul l-ar putea implementa. Acum, AI a eliminat efectiv această constrângere, permițând persoanelor cu abilități limitate să asigure și să dețină poziții de inginerie lucrativă.

Raportul notează că „un singur operator poate obține impactul unei întregi echipe cibernetice prin asistență AI”. Această armă a AI nu se întâmplă în vid. Microsoft a avertizat deja că „AI a început să scadă barul tehnic pentru fraudă și actori criminali… făcând mai ușor și mai ieftin să genereze conținut credibil pentru cyberattacks într-un ritm din ce în ce mai rapid.”

Această tendință mai largă este evidentă într-o creștere a creșterii recente a atacurilor de phishing asistate de AI. Ca răspuns la concluziile sale, Antropic a interzis conturile rău intenționate și și-a îmbunătățit instrumentele pentru corelarea indicatorilor cunoscuți de compromis. De asemenea, compania împărtășește indicatori tehnici cu partenerii din industrie pentru a ajuta la prevenirea abuzurilor în ecosistem.